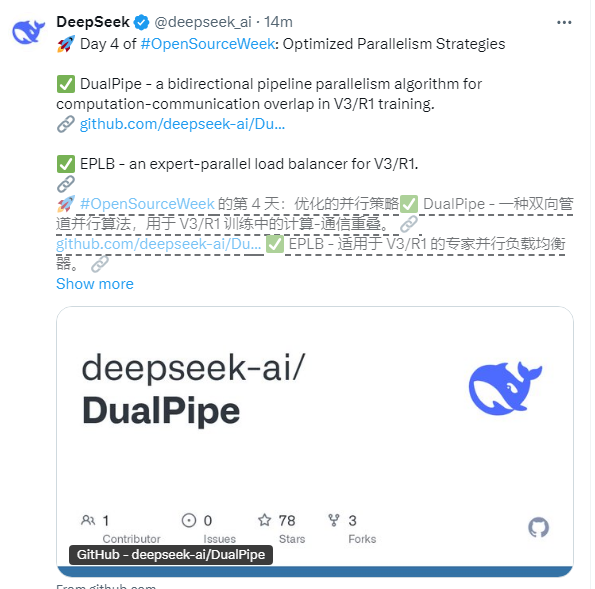

今日、中国の人工知能の分野の大手企業であるDeepseekは、オープンソース計画の4日目を正式に発表しました。今回リリースされたコアテクノロジーには、双方向パイプライン並列アルゴリズムのデュアルパイプ、エキスパート並列ロードバランサーEPLB、およびコンピューティングコミュニケーションの重複メカニズムの深い最適化が含まれます。これらの技術的アップグレードは、大規模な言語モデルトレーニングにおける重要な問題を直接ターゲットにし、スーパーワンカレベルのクラスターの効率的な操作のための新しいソリューションを提供します。

DualPipeは、V3/R1アーキテクチャ専用に設計されたこのテクノロジーアップグレードの中核の1つです。革新的な双方向のデータフローパイプラインを通じて、DualPipeはコンピューティングと通信の間で高い重複を達成します。従来の一方向パイプラインと比較して、このテクノロジーはコンピューティングスループットを大幅に改善します。特に、1,000億から1,000億のパラメーターのスケールのモデルトレーニングに適しています。 GitHubコードベースによると、DualPipeはインテリジェントなスケジューリングメカニズムを介してバックプロパゲーション段階で同期してフォワードコンピューティングを実行し、ハードウェアの利用を約30%増加させます。

EPLBテクノロジーは、ハイブリッドエキスパート(MOE)モデルトレーニングにおける「ホットエキスパート」の問題を目指しており、初めて専門家の動的な負荷分散を実現します。従来の方法は、多くの場合、専門家のタスクの不均一な割り当てによるいくつかの計算カードの過負荷につながります。リアルタイムの監視と適応割り当てにより、EPLBはワンカレベルクラスターの全体的な利用率を92%以上に上げ、アイドルリソースを効果的に回避します。

さらに、DeepSeekは、V3/R1アーキテクチャの通信オーバーラップ分析ツールに基づいて、初めて3D並列処理(データ/パイプライン/テンソル並列性)の時空効率モデルを構築しました。オープンソースの分析データセットを通じて、開発者はコンピューティングと通信の間の競合するノードを正確に見つけることができ、ハイパースケールモデルトレーニングのチューニングベンチマークを提供できます。テストによると、この最適化により、エンドツーエンドのトレーニング時間が約15%短縮されます。

このテクノロジーリリースは、業界で大きな注目を集めています。専門家は、DualPipeとEPLBの統合された革新が、現在の大規模トレーニングの2つの主要な課題に直接対応していることを指摘しました。最初に、モデルスケールの指数関数的な成長により、従来の並列戦略のスケーラビリティボトルネックはますます顕著になりつつあります。第二に、ハイブリッドエキスパートモデルの人気により、動的な負荷バランスが基本的なニーズになりました。クラウドコンピューティングメーカーのテクニカルディレクターは次のようにコメントしています。「これらのツールは、数億ドルのモデルトレーニングのハードウェアのしきい値を大幅に削減し、トレーニングコストを20%〜30%削減すると予想されます。

DeepseekのCTOは、技術文書で、数億1,000億パラメーターモデルの内部トレーニングでオープンソース戦略が検証されており、将来的に繰り返して最適化され続けることを強調しました。現在、これらの3つのテクノロジーはGitHubのオープンソースであり、開発者をサポートして、カスタマイズしてさまざまなハードウェア環境に適用しています。

グローバルなAIコンペティションが「スケーリング勝利」段階に入ると、Deepseekは4日間連続して主要なテクノロジーのソースを開き、中国のAI企業の技術的強さを実証するだけでなく、業界に再利用可能なインフラストラクチャを提供します。 「オープンコラボレーション」によって推進されるこの技術革新は、大きなモデルトレーニングの産業エコシステムを再構築する可能性があります。