[ICCV 2023] (оральный) Это официальный репозиторий для нашей статьи: чувствительность, способствующая визуальной параметрам, точная настройка Haoyu He, Jianfei Cai, Jing Zhang, Dacheng Tao и Bohan Zhuang.

[2023-09-12]: код выпуска.Новости

[2023-08-12]: получил принятие ICCV 2023 для устной презентации!

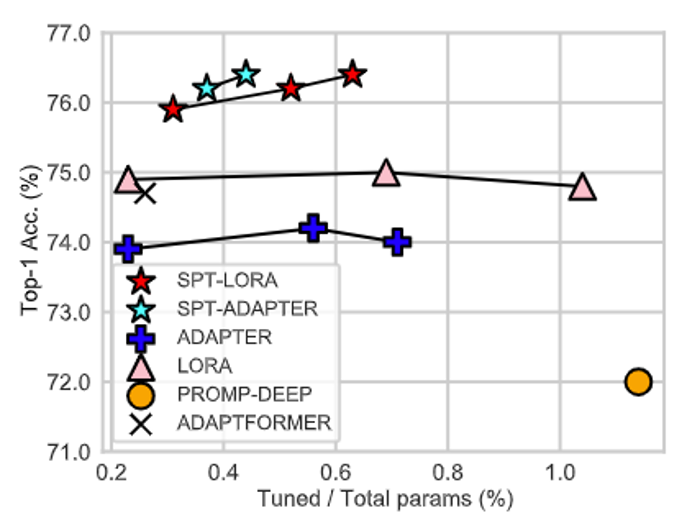

Вместо того, чтобы представлять другую архитектуру с обучаемыми параметрами в сфере точной настройки (PEFT), наша работа подчеркивает важность размещения архитектуры PEFT в оптимальные позиции, адаптированные для разнообразных задач!

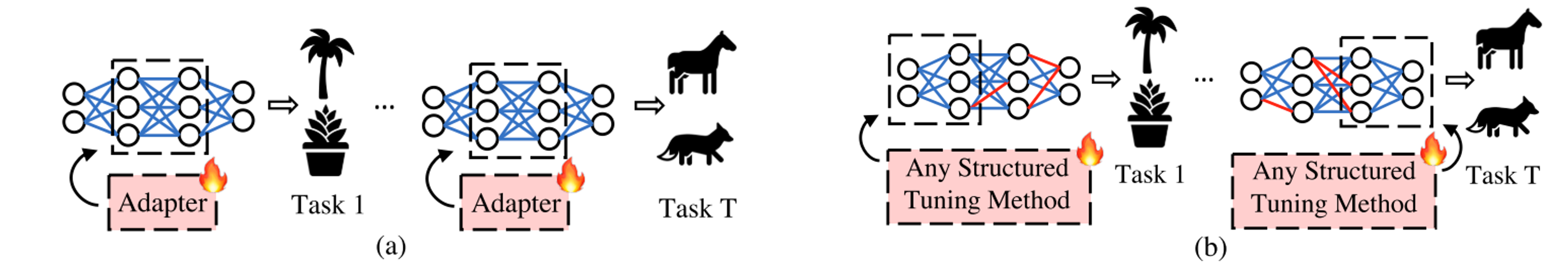

Наш SPT состоит из двух этапов.

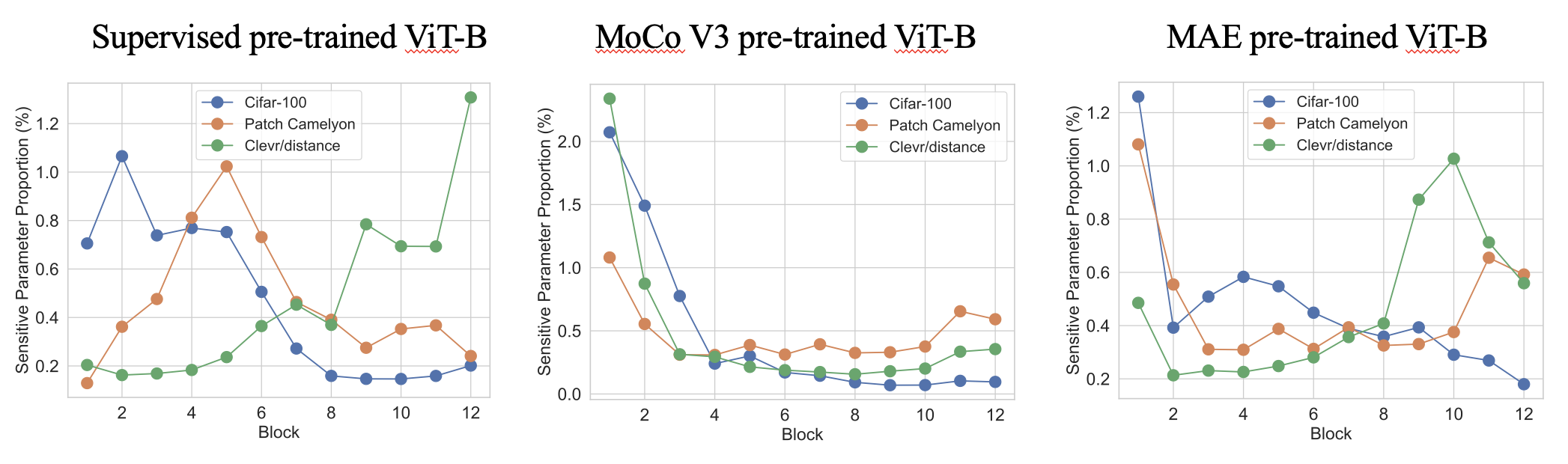

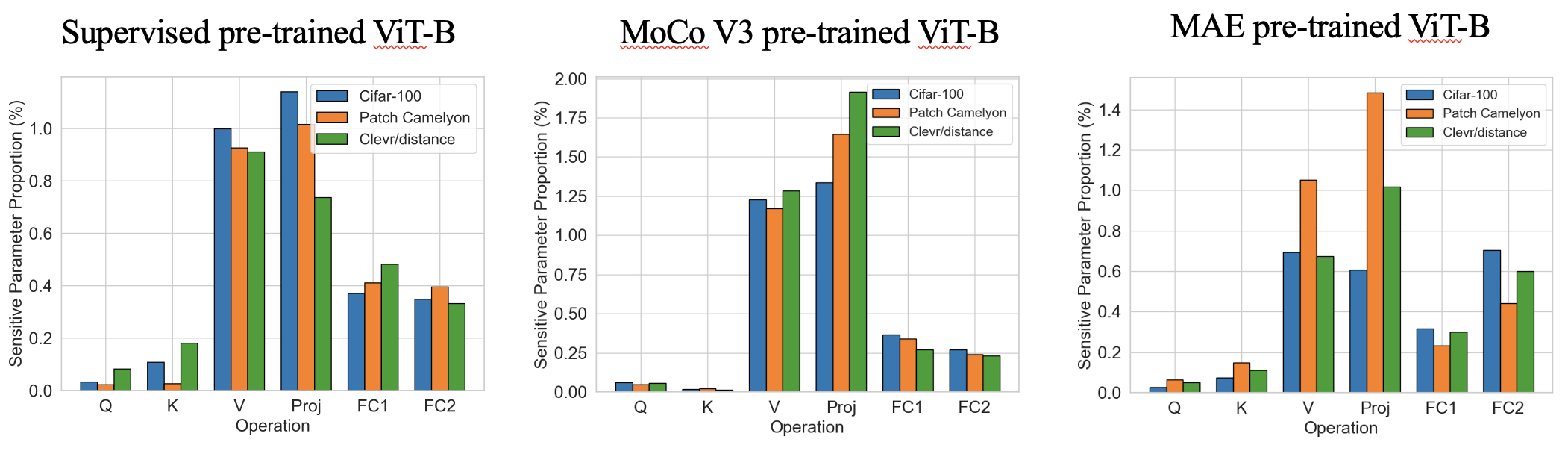

Стадия 1 представляет собой очень быструю оценку чувствительности параметров с одним выстрелом (несколько секунд), чтобы найти, где внедрить тренировочные параметры. Ниже приведены некоторые интересные паттерны чувствительности в различных предварительно обученных VIT с чувствительными параметрами TOP 0,4%. Мы обнаруживаем, что пропорции демонстрируют различные модели специфических для задачи с точки зрения глубины сети и аналогичных схожих шаблонов с точки зрения операций .

Стадия 2-это стандартная PEFT, которая поддерживает замороженные параметры большинства и только настраивать обучаемые. Наш SPT вводит обучаемые параметры в чувствительные положения в двух гранулизмах: неструктурированные нейроны и структурированные модули PEFT (например, Lora или адаптер) для достижения хорошей производительности!

Если вы найдете этот репозиторий или нашу статью полезной, пожалуйста, рассмотрите цит -состав и снимайте нас!

@inproceedings{he2023sensitivity,

title={Sensitivity-Aware Visual Parameter-Efficient Fine-Tuning},

author={He, Haoyu and Cai, Jianfei and Zhang, Jing and Tao, Dacheng and Zhuang, Bohan},

booktitle={ICCV},

year={2023}

}

Мы протестировали наш код как на Torch 1.8.0, так и на 1.10.0. Пожалуйста, установите другие зависимости со следующим кодом в Home Directory:

pip install -r requirements.txt

Мы предоставляем код обучения и вывода для нашего основного эталона VTAB-1K.

cd data/vtab-source

python get_vtab1k.py

PS: Возможно, вам придется вручную установить Sun397. Пожалуйста, обратитесь к VTAB-1K.

Пожалуйста, загрузите основы со следующим кодом:

cd checkpoints

# Supervised pre-trained ViT-B/16

wget https://console.cloud.google.com/storage/browser/_details/vit_models/imagenet21k/ViT-B_16.npz

# MAE pre-trained ViT-B/16

wget https://dl.fbaipublicfiles.com/mae/pretrain/mae_pretrain_vit_base.pth

# MoCo V3 pre-trained ViT-B/16

wget https://dl.fbaipublicfiles.com/moco-v3/vit-b-300ep/linear-vit-b-300ep.pth.tar

Мы предоставили следующий код (мы уже обеспечили чувствительность для под наблюдением предварительно обученного Vit-B/16 в sensitivity_spt_supervised_lora_a10 и sensitivity_spt_supervised_adapter_a10 ).

# SPT-ADAPTER and SPT-LORA with supervised pre-trained ViT-B/16

bash configs/vtab_mae_spt_lora_sensitivity.sh

bash configs/vtab_mae_spt_adapter_sensitivity.sh

# SPT-ADAPTER and SPT-LORA with MAE pre-trained ViT-B/16

bash configs/vtab_mae_spt_lora_sensitivity.sh

bash configs/vtab_mae_spt_adapter_sensitivity.sh

# SPT-ADAPTER and SPT-LORA with MoCo V3 pre-trained ViT-B/16

bash configs/vtab_mae_spt_lora_sensitivity.sh

bash configs/vtab_mae_spt_adapter_sensitivity.sh

Мы предоставили следующий код обучения:

# SPT-ADAPTER and SPT-LORA with supervised pre-trained ViT-B/16

bash configs/vtab_supervised_spt_lora.sh

bash configs/vtab_supervised_spt_adapter.sh

# SPT-ADAPTER and SPT-LORA with MAE pre-trained ViT-B/16

bash configs/vtab_mae_spt_lora.sh

bash configs/vtab_mae_spt_adapter.sh

# SPT-ADAPTER and SPT-LORA with MoCo V3 pre-trained ViT-B/16

bash configs/vtab_moco_spt_lora.sh

bash configs/vtab_moco_spt_adapter.sh

PS: мы подметаем различные обучаемые бюджеты параметров, чтобы добиться лучших результатов (от 0,2 м до 1,0 м).

- [x] Release code for SPT on ViTs.

- [ ] Release code for FGVC benchmark training (ETA October).

- [ ] Release code for SPT on Swin (ETA October).

- [ ] Release code for SPT on ConvNext (ETA October).

- [ ] Integrate to [PEFT](https://github.com/huggingface/peft) package.

Наш код изменен из NOAH, COOP, AutoFormer, TIMM и MMCV. Мы благодарим авторов за их код с открытым исходным кодом.