OpenPCDet -это четкий, простой, автономный проект с открытым исходным кодом для обнаружения трехмерных объектов на основе лидара.

Это также официальный выпуск кода [PointRCNN] , [Part-A2-Net] , [PV-RCNN] , [Voxel R-CNN] , [PV-RCNN++] и [MPPNet] .

Основные моменты :

OpenPCDet был обновлен до v0.6.0 (сентябрь 2022). [2023-06-30] Новое: добавленная поддержка DSVT , которая достигает современной производительности на крупномасштабном наборе данных WayMO с скоростью вывода в реальном времени (27 Гц с Tensorrt).

[2023-05-13] Новый: Добавлена поддержка многомодальных моделей обнаружения 3D-объектов в наборе данных Nuscenes.

BEVFusion , которая объединяет многомодальную информацию о BEV Space и достигает 70,98% NDS в наборе данных проверки Nuscenes. (См. Руководство по обучению/тестированию с помощью Bevfusion). [2023-04-02] добавила поддержку VoxelNeXt на наборах данных Nuscenes, Waymo и Argoverse2. Это полностью разреженная сеть обнаружения трехмерных объектов, которая является чистой редкой сетью CNNS и предсказывает 3D -объекты непосредственно на вокселях.

[2022-09-02] Новое: обновление OpenPCDet до v0.6.0:

MPPNet for temporal 3D object detection, which supports long-term multi-frame 3D object detection and ranks 1st place on 3D detection learderboard of Waymo Open Dataset on Sept. 2th, 2022. For validation dataset, MPPNet achieves 74.96%, 75.06% and 74.52% for vehicle, pedestrian and cyclist classes in terms of mAPH@Level_2. (См. Руководство по обучению/тестированию с помощью MPPNet).--use_tqdm_to_record ). Пожалуйста, используйте pip install gpustat если вы также хотите войти в систему информации, связанной с GPU.[2022-08-22] Добавлена поддержка для пользовательского учебного пособия и шаблона

[2022-07-05] Добавлена поддержка трехмерных Focals Conv .

[2022-02-12] добавлена поддержка для использования Docker. Пожалуйста, обратитесь к руководству в ./docker.

[2022-02-07] добавлена поддержка моделей CenterPoint на наборе данных Nuscenes.

[2022-01-14] добавила поддержку для динамической вокселизации столба после реализации, предложенной в H^23D R-CNN с уникальной операцией и пакетом torch_scatter .

[2022-01-05] Новое: обновление OpenPCDet to v0.5.2:

PV-RCNN++ был выпущен в этом репо, с более высокой производительностью, более высокой скоростью обучения/вывода и меньшим потреблением памяти, чем PV-RCNN. [2021-12-09] Новое: обновление OpenPCDet до V0.5.1:

[2021-12-01] New: OpenPCDet V0.5.0 выпускается со следующими функциями:

CenterPoint и PV-RCNN with CenterHead .USE_SHARED_MEMORY для использования общей памяти, чтобы потенциально ускорить обучающий процесс, если вы страдаете от проблемы с вводом -выводом. [2021-06-08] добавила поддержку модели обнаружения трехмерных объектов на основе Voxel R-CNN .

[2021-05-14] Добавлена поддержка модели монокулярного трехмерного обнаружения объекта CaDDN .

[2020-11-27] Ошибка с ошибкой: Пожалуйста, повторно представьте валидацию набора данных Waymo (версия 1.2), если вы хотите использовать наш предоставленный инструмент оценки Waymo (см. PR). Обратите внимание, что вам не нужно переоценивать учебные данные и базу данных по прав истинной земле.

[2020-11-10] Открытый набор данных Waymo был поддержан с самыми современными результатами. В настоящее время мы предоставляем конфигурации и результаты SECOND , PartA2 и PV-RCNN в наборе данных Waymo Open, и можно легко поддерживать больше моделей путем изменения их конфигураций набора данных.

[2020-08-10] FuckFixed: предоставленные модели Nuscenes были обновлены для исправления ошибок загрузки. Пожалуйста, загрузите его, если вам нужно использовать предварительно подготовленные модели Nuscenes.

[2020-07-30] OpenPCDet V0.3.0 выпускается со следующими функциями:

PointRCNN , PartA2-Free ) поддерживаются сейчас.SECOND-MultiHead (CBGS) и PointPillar-MultiHead ).[2020-07-17] Добавьте простые коды визуализации и быструю демонстрацию для тестирования с помощью пользовательских данных.

[2020-06-24] OpenPCDet V0.2.0 выпускается с довольно новыми структурами для поддержки большего количества моделей и наборов данных.

[2020-03-16] Открыт OpenPCDet V0.1.0.

OpenPCDet ? Обратите внимание, что мы повысили PCDet с v0.1 до v0.2 с довольно новыми структурами для поддержки различных наборов данных и моделей.

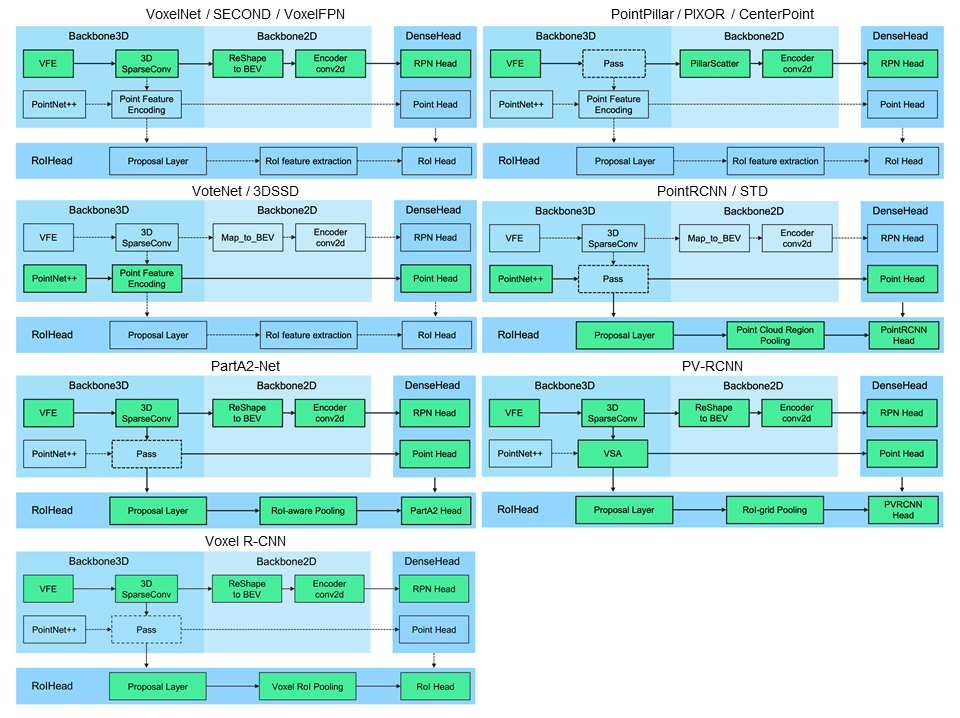

OpenPCDet -это общая кодовая база на основе Pytorch для обнаружения трехмерных объектов из Point Cloud. В настоящее время он поддерживает несколько современных методов обнаружения 3D-объектов с высокопрофильными кодами как для одноэтапных, так и для двухэтапных трехмерных карт обнаружения.

Основываясь на инструментарии OpenPCDet , мы выигрываем задачу Waymo Open DataSet в трехмерном обнаружении, 3D-отслеживании, доменной адаптации три трека среди всех методов только для LIDAR, а модели, связанные с WayMO, скоро будут выпущены в OpenPCDet .

В настоящее время мы активно обновляем это репо, и в ближайшее время будет поддержано больше наборов данных и моделей. Взносы также приветствуются.

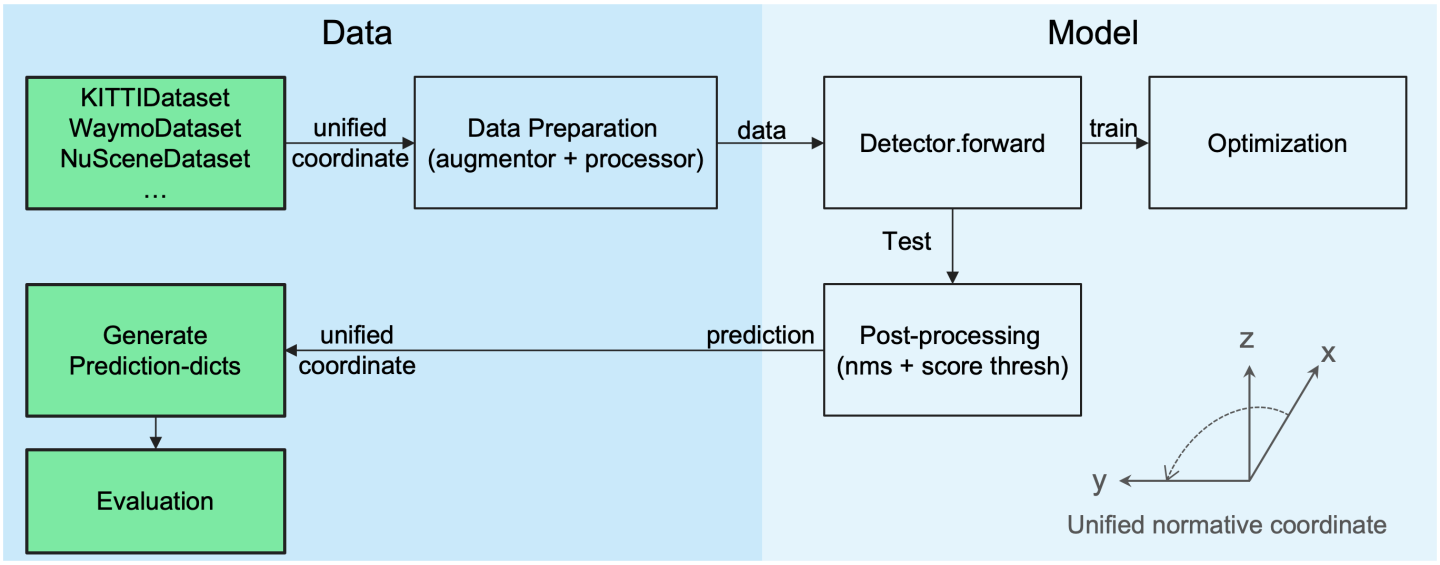

OpenPCDet Design Pattern

Unified 3D -коробка Определение: (x, y, z, dx, dy, dz, заголовок).

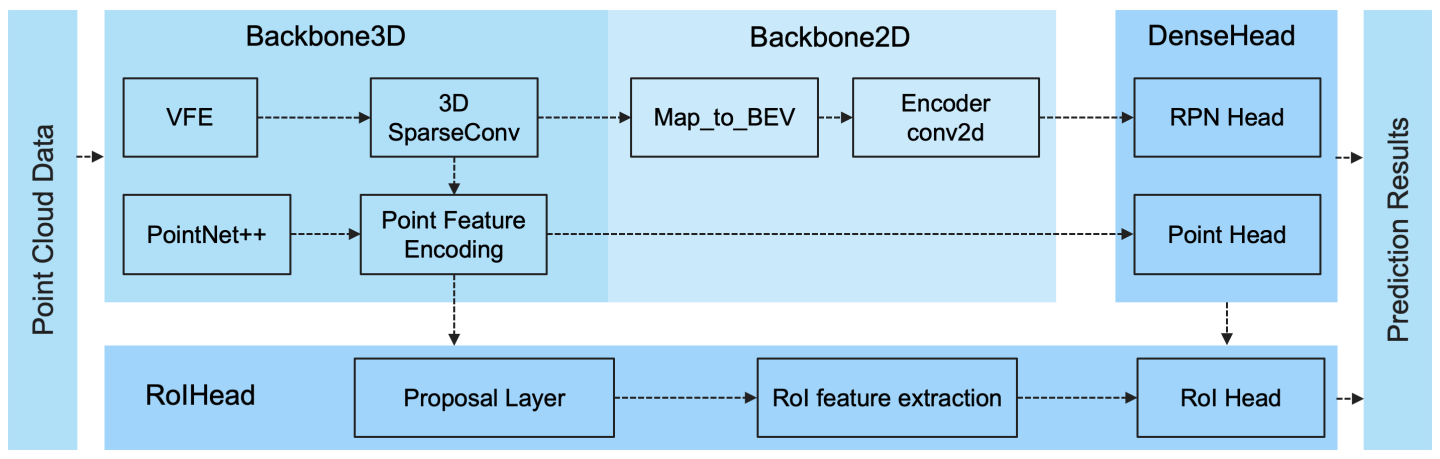

Гибкая и четкая структура модели, чтобы легко поддерживать различные модели трехмерного обнаружения:

Выбранные поддерживаемые методы показаны в таблице ниже. Результатами являются показатели трехмерной обнаружения умеренной сложности в наборе набора данных VAL .

| время обучения | Автомобиль@R11 | Пешеход@R11 | Велосипедист@R11 | скачать | |

|---|---|---|---|---|---|

| Точка | ~ 1,2 часа | 77.28 | 52,29 | 62,68 | модель-18M |

| ВТОРОЙ | ~ 1,7 часа | 78.62 | 52,98 | 67.15 | модель-20м |

| Второе-иу | - | 79,09 | 55,74 | 71.31 | Модель-46M |

| Pointrcnn | ~ 3 часа | 78,70 | 54,41 | 72.11 | модель-16M |

| Pointrcnn-iou | ~ 3 часа | 78,75 | 58.32 | 71.34 | модель-16M |

| Часть A2 без | ~ 3,8 часа | 78.72 | 65,99 | 74,29 | Модель-226M |

| Часть-А2-Анкор | ~ 4,3 часа | 79,40 | 60.05 | 69,90 | Модель-244M |

| PV-RCNN | ~ 5 часов | 83,61 | 57,90 | 70.47 | модель-50м |

| Voxel R-CNN (автомобиль) | ~ 2,2 часа | 84,54 | - | - | Модель-28M |

| Фокусы конвейер - f | ~ 4 часа | 85,66 | - | - | модель-30м |

| Caddn (моно) | ~ 15 часов | 21.38 | 13.02 | 9.76 | Модель-774M |

Мы предоставляем настройку DATA_CONFIG.SAMPLED_INTERVAL на наборе данных Waymo Open (WOD), чтобы подготовить частичные образцы для обучения и оценки, так что вы также можете играть с WOD, установив меньшие ресурсы DATA_CONFIG.SAMPLED_INTERVAL , даже если у вас есть только ограниченные ресурсы GPU.

По умолчанию все модели обучаются с одним кадром из 20% данных (~ 32K рам) из всех обучающих образцов на 8 GTX 1080TI GPU, и результаты каждой ячейки здесь представлены MAP/MAPH, рассчитанные по официальным показателям оценки Waymo по всему набору валидации (версия 1.2).

| Производительность@(поезда с 20% данных) | VEC_L1 | VEC_L2 | Ped_l1 | Ped_l2 | Cyc_l1 | Cyc_l2 |

|---|---|---|---|---|---|---|

| ВТОРОЙ | 70,96/70,34 | 62,58/62,02 | 65,23/54,24 | 57.22/47.49 | 57.13/55,62 | 54,97/53,53 |

| Точка | 70,43/69,83 | 62,18/61,64 | 66.21/46.32 | 58,18/40,64 | 55,26/51,75 | 53,18/49,80 |

| Centerpoint-Pillar | 70.50/69,96 | 62,18/61,69 | 73.11/61,97 | 65,06/55,00 | 65,44/63,85 | 62,98/61,46 |

| CenterPoint-Dynamic-Cylar | 70,46/69,93 | 62,06/61,58 | 73,92/63,35 | 65,91/56,33 | 66.24/64,69 | 63,73/62,24 |

| Centerpoint | 71.33/70.76 | 63,16/62,65 | 72,09/65,49 | 64,27/58,23 | 68,68/67,39 | 66.11/64,87 |

| CenterPoint (RESNET) | 72,76/72,23 | 64,91/64,42 | 74,19/67,96 | 66.03/60.34 | 71.04/69,79 | 68.49/67.28 |

| Часть-А2-Анкор | 74,66/74,12 | 65,82/65,32 | 71,71/62,24 | 62,46/54,06 | 66,53/65,18 | 64,05/62,75 |

| Pv-rcnn (якорь) | 75,41/74,74 | 67,44/66,80 | 71.98/61.24 | 63,70/53,95 | 65,88/64,25 | 63,39/61,82 |

| Pv-rcnn (centerhead) | 75,95/75,43 | 68.02/67.54 | 75,94/69,40 | 67.66/61.62 | 70.18/68,98 | 67,73/66,57 |

| Voxel R-CNN (CenterHead) -Dynamic-воксель | 76.13/75,66 | 68,18/67,74 | 78.20/71.98 | 69,29/63,59 | 70,75/69,68 | 68.25/67.21 |

| Pv-rcnn ++ | 77,82/77,32 | 69,07/68,62 | 77,99/71,36 | 69,92/63,74 | 71,80/70,71 | 69.31/68.26 |

| Pv-rcnn ++ (resnet) | 77.61/77.14 | 69,18/68,75 | 79,42/73,31 | 70,88/65,21 | 72,50/71,39 | 69,84/68,77 |

Здесь мы также предоставляем производительность нескольких моделей, обученных полным учебным наборам (см. Документ PV-RCNN ++):

| Производительность@(поезда со 100% данных) | VEC_L1 | VEC_L2 | Ped_l1 | Ped_l2 | Cyc_l1 | Cyc_l2 |

|---|---|---|---|---|---|---|

| ВТОРОЙ | 72,27/71,69 | 63,85/63,33 | 68,70/58,18 | 60,72/51,31 | 60,62/59,28 | 58.34/57.05 |

| Centerpoint-Pillar | 73,37/72,86 | 65,09/64,62 | 75,35/65,11 | 67,61/58,25 | 67,76/66,22 | 65,25/63,77 |

| Часть-А2-Анкор | 77.05/76.51 | 68,47/67,97 | 75,24/66,87 | 66.18/58,62 | 68,60/67,36 | 66.13/64,93 |

| Voxelnext-2d | 77,94/77,47 | 69,68/69,25 | 80.24/73,47 | 72,23/65,88 | 73,33/72,20 | 70,66/69,56 |

| Voxelnext | 78,16/77,70 | 69,86/69,42 | 81.47/76.30 | 73,48/68,63 | 76.06/74,90 | 73,29/72,18 |

| Pv-rcnn (centerhead) | 78.00/77.50 | 69,43/68,98 | 79,21/73,03 | 70,42/64,72 | 71.46/70.27 | 68,95/67,79 |

| Pv-rcnn ++ | 79.10/78,63 | 70,34/69,91 | 80,62/74,62 | 71.86/66.30 | 73,49/72,38 | 70,70/69,62 |

| Pv-rcnn ++ (resnet) | 79,25/78,78 | 70.61/70.18 | 81.83/76.28 | 73,17/68,00 | 73,72/72,66 | 71.21/70.19 |

| DSVT-Pillar | 79,44/78,97 | 71.24/70.81 | 83.00/77.22 | 75,45/69,95 | 76,70/75,70 | 73,83/72,86 |

| DSVT-Voxel | 79,77/79,31 | 71.67/71.25 | 83,75/78,92 | 76.21/71.57 | 77,57/76,58 | 74,70/73,73 |

| Pv-rcnn ++ (resnet, 2 рамки) | 80.17/79,70 | 72.14/71,70 | 83,48/80,42 | 75,54/72,61 | 74,63/73,75 | 72.35/71.50 |

| Mppnet (4 кадра) | 81.54/81.06 | 74,07/73,61 | 84,56/81,94 | 77.20/74,67 | 77.15/76.50 | 75,01/74,38 |

| Mppnet (16 кадров) | 82,74/82,28 | 75,41/74,96 | 84,69/82,25 | 77,43/75,06 | 77.28/76.66 | 75,13/74,52 |

Мы не смогли предоставить вышеуказанные модели, предварительно предопределенные из -за лицензионного соглашения о наборах данных WayMO, но вы можете легко достичь аналогичной производительности, обучаясь с конфигурациями по умолчанию.

Все модели обучены 8 графических процессоров и доступны для загрузки. Для обучения Bevfusion, пожалуйста, обратитесь к руководству.

| приятель | МАС | Маоэ | май | маа | карта | Нс | скачать | |

|---|---|---|---|---|---|---|---|---|

| Pointpillar-Multihead | 33,87 | 26.00 | 32.07 | 28.74 | 20.15 | 44,63 | 58.23 | Модель-23M |

| Второй Multihead (CBGS) | 31.15 | 25,51 | 26.64 | 26.26 | 20.46 | 50.59 | 62,29 | Модель-35M |

| CenterpointpointPillar | 31.13 | 26.04 | 42,92 | 23.90 | 19.14 | 50.03 | 60.70 | Модель-23M |

| CenterPoint (Voxel_Size = 0,1) | 30.11 | 25,55 | 38.28 | 21,94 | 18.87 | 56.03 | 64,54 | Модель-34M |

| CenterPoint (Voxel_Size = 0,075) | 28,80 | 25.43 | 37.27 | 21.55 | 18.24 | 59,22 | 66.48 | Модель-34M |

| VoxelNext (voxel_size = 0,075) | 30.11 | 25.23 | 40.57 | 21.69 | 18.56 | 60.53 | 66.65 | Модель-31M |

| Переливание-l* | 27.96 | 25.37 | 29,35 | 27.31 | 18.55 | 64,58 | 69,43 | Модель-32M |

| Bevfusion | 28.03 | 25.43 | 30.19 | 26.76 | 18.48 | 67,75 | 70.98 | Модель-157M |

*: Используйте стратегию FADE, которая отключает дополнения данных в последние несколько эпох во время обучения.

Все модели обучены 8 графических процессоров.

| Транспортное средство | Пешеход | Велосипедист | карта | |

|---|---|---|---|---|

| Pointrcnn | 52,09 | 4.28 | 29,84 | 28.74 |

| Точка | 68.57 | 17.63 | 46.81 | 44,34 |

| ВТОРОЙ | 71.19 | 26.44 | 58.04 | 51.89 |

| PV-RCNN | 77.77 | 23.50 | 59,37 | 53,55 |

| Centerpoint | 78.02 | 49,74 | 67.22 | 64,99 |

Все модели обучаются с 4 графическими процессорами.

| карта | скачать | |

|---|---|---|

| Voxelnext | 30,5 | Модель-32M |

Добро пожаловать, чтобы поддержать другие наборы данных, отправив запрос на развод.

Пожалуйста, обратитесь к install.md для установки OpenPCDet .

Пожалуйста, обратитесь к Demo.md для быстрого демонстрации для тестирования с предварительной моделью и визуализируйте прогнозируемые результаты в ваших пользовательских данных или исходных данных Kitti.

Пожалуйста, обратитесь к get get_started.md, чтобы узнать больше об использовании этого проекта.

OpenPCDet выпускается по лицензии Apache 2.0.

OpenPCDet -это проект с открытым исходным кодом для восприятия 3D-сцены на основе лидара, который поддерживает несколько моделей восприятия на основе лидара, как показано выше. Некоторые части PCDet изучаются из официальных выпущенных кодов приведенных выше методов. Мы хотели бы поблагодарить за предлагаемые их методы и официальную реализацию.

Мы надеемся, что этот репо может служить сильной и гибкой кодовой базой, чтобы принести пользу исследовательскому сообществу, ускоряя процесс повторного введения предыдущих работ и/или разработки новых методов.

Если вы найдете этот проект полезным в своем исследовании, пожалуйста, рассмотрите цит: CITE:

@misc{openpcdet2020,

title={OpenPCDet: An Open-source Toolbox for 3D Object Detection from Point Clouds},

author={OpenPCDet Development Team},

howpublished = {url{https://github.com/open-mmlab/OpenPCDet}},

year={2020}

}

Добро пожаловать, чтобы стать членом команды разработчиков OpenPCDET, внесли свой вклад в этот репо, и не стесняйтесь обращаться к нам за любыми потенциальными вкладами.