OpenPCDet ist ein klares, einfaches, in sich geschlossenes Open-Source-Projekt für die Erkennung von 3D-Objekten auf LIDAR-Basis.

Es ist auch die offizielle Veröffentlichung von [PointRCNN] , [Part-A2-Net] , [PV-RCNN] , [Voxel R-CNN] , [PV-RCNN++] und [MPPNet] .

Highlights :

OpenPCDet wurde auf v0.6.0 (September 2022) aktualisiert. [2023-06-30] NEU: Unterstützung für DSVT hinzugefügt, das eine hochmoderne Leistung bei großem Maßstab mit Waymo Open-Datensatz mit Echtzeit-Inferenzgeschwindigkeit (27Hz mit Tensorrt) erzielt.

[2023-05-13] Neu: Unterstützung für die multi-modalen 3D-Objekterkennungsmodelle im Nuscenes-Datensatz hinzugefügt.

BEVFusion , das multimodale Informationen zum BEV-Speicherplatz verblasst und 70,98% NDs im Nuscenes-Validierungsdatensatz erreicht. (Siehe die Richtlinie zum Training/Test mit BevFusion). [2023-04-02] Unterstützung für VoxelNeXt in NuScenes, Waymo und Argoverse2-Datensätzen. Es handelt sich um ein vollständig spärliches 3D -Objekterkennungsnetzwerk, das ein sauberes spärliches CNNS -Netzwerk ist und 3D -Objekte direkt auf Voxel vorhersagt.

[2022-09-02] Neu: Update OpenPCDet auf v0.6.0:

MPPNet für die Erkennung der temporalen 3D-Objekte, die Langzeit-Multi-Rahmen-3D-Objekterkennung unterstützt und am 2. September den ersten Platz für 3D-Erkennungs-Lernboard von Waymo Open-Datensatz am 2. September 2022. Für Validierungsdatensatz, MPPNET erreicht 74,96%, 75,06% und 74,06% und 74,06% und 74,06% und 74,06%. (Siehe Richtlinie zum Training/Test mit MPPNet).--use_tqdm_to_record ) verwendet wird. Bitte verwenden Sie pip install gpustat wenn Sie auch die mit GPU bezogenen Informationen protokollieren möchten.[2022-08-22] Unterstützung für das benutzerdefinierte Datensatz-Tutorial und die Vorlage hinzugefügt

[2022-07-05] Unterstützung für die 3D-Objekterkennungs-Backbone-Netzwerk Focals Conv .

[2022-02-12] Unterstützung für die Verwendung von Docker. Bitte beachten Sie die Anleitung in ./Docker.

[2022-02-07] Unterstützung für CenterPoint-Modelle im Nuscenes-Datensatz.

[2022-01-14] Unterstützung für die dynamische Säulenvoxelisierung nach der in H^23D R-CNN vorgeschlagenen Implementierung mit eindeutigem Betrieb und torch_scatter Paket.

[2022-01-05] Neu: Update OpenPCDet auf v0.5.2:

PV-RCNN++ wurde an dieses Repo mit höherer Leistung, schnellerer Trainings-/Inferenzgeschwindigkeit und weniger Speicherverbrauch als PV-RCNN veröffentlicht. [2021-12-09] Neu: Update OpenPCDet auf v0.5.1:

[2021-12-01] NEU: OpenPCDet v0.5.0 wird mit den folgenden Funktionen veröffentlicht:

CenterPoint und PV-RCNN with CenterHead .USE_SHARED_MEMORY , um den gemeinsam genutzten Speicher zu verwenden, um den Trainingsprozess möglicherweise zu beschleunigen, falls Sie an einem IO -Problem leiden. [2021-06-08] Unterstützung für das Voxel-basierte 3D-Objekterkennungsmodell Voxel R-CNN .

[2021-05-14] Unterstützung für das monokulare 3D-Objekterkennungsmodell CaDDN .

[2020-11-27] Bugfixed: Bitte präsentieren Sie die Validierungsinfos des WayMo-Datensatzes (Version 1.2), wenn Sie unser bereitgestelltes WayMo-Bewertungstool (siehe PR) verwenden möchten. Beachten Sie, dass Sie die Datenbank für Schulungsdaten und Ground-Wahrheit nicht neu vorbereiten müssen.

[2020-11-10] Der Waymo Open-Datensatz wurde mit hochmodernen Ergebnissen unterstützt. Derzeit stellen wir die Konfigurationen und Ergebnisse von SECOND , PartA2 und PV-RCNN auf dem WayMo Open-Datensatz bereit, und weitere Modelle können durch die Änderung ihrer Datensatzkonfigurationen leicht unterstützt werden.

[2020-08-10] Bugfixed: Die bereitgestellten Nuscenes-Modelle wurden aktualisiert, um die Ladefehler zu beheben. Bitte laden Sie es wieder, wenn Sie die vorbereiteten Nuscenes -Modelle verwenden müssen.

[2020-07-30] OpenPCDet v0.3.0 wird mit den folgenden Funktionen veröffentlicht:

PointRCNN , PartA2-Free ) werden jetzt unterstützt.SECOND-MultiHead (CBGS) und PointPillar-MultiHead ) unterstützt.[2020-07-17] Fügen Sie einfache Visualisierungscodes und eine schnelle Demo hinzu, um mit benutzerdefinierten Daten zu testen.

[2020-06-24] OpenPCDet v0.2.0 wird mit ziemlich neuen Strukturen veröffentlicht, um mehr Modelle und Datensätze zu unterstützen.

[2020-03-16] OpenPCDet v0.1.0 wird veröffentlicht.

OpenPCDet Toolbox? Beachten Sie, dass wir PCDet von v0.1 bis v0.2 mit ziemlich neuen Strukturen zur Unterstützung verschiedener Datensätze und Modelle beliebt haben.

OpenPCDet ist eine allgemeine Pytorch-basierte Codebasis für die 3D-Objekterkennung aus Punktwolke. Derzeit unterstützt es mehrere hochmoderne 3D-Objekterkennungsmethoden mit stark reflektierten Codes sowohl für einstufige als auch für zweistufige 3D-Erkennungsrahmen.

Basierend auf OpenPCDet Toolbox gewinnen wir die WayMo Open Dataset Challenge in 3D-Erkennung, 3D-Tracking, Domänenanpassung drei Tracks unter allen Methoden mit nur Lidar-Nur-Methoden und die Waymo-verwandten Modelle werden in Kürze an OpenPCDet veröffentlicht.

Wir aktualisieren dieses Repo derzeit aktiv und weitere Datensätze und Modelle werden in Kürze unterstützt. Beiträge sind ebenfalls begrüßt.

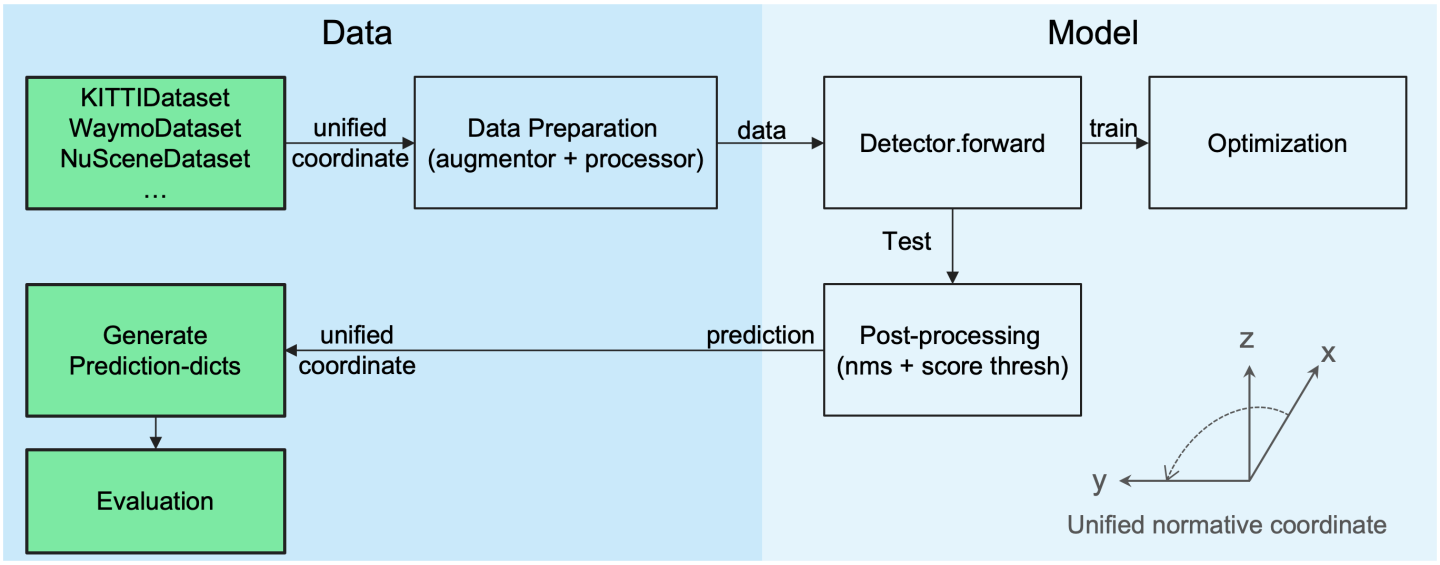

OpenPCDet -Designmuster

Unified 3D -Box -Definition: (X, Y, Z, DX, DY, DZ, Überschrift).

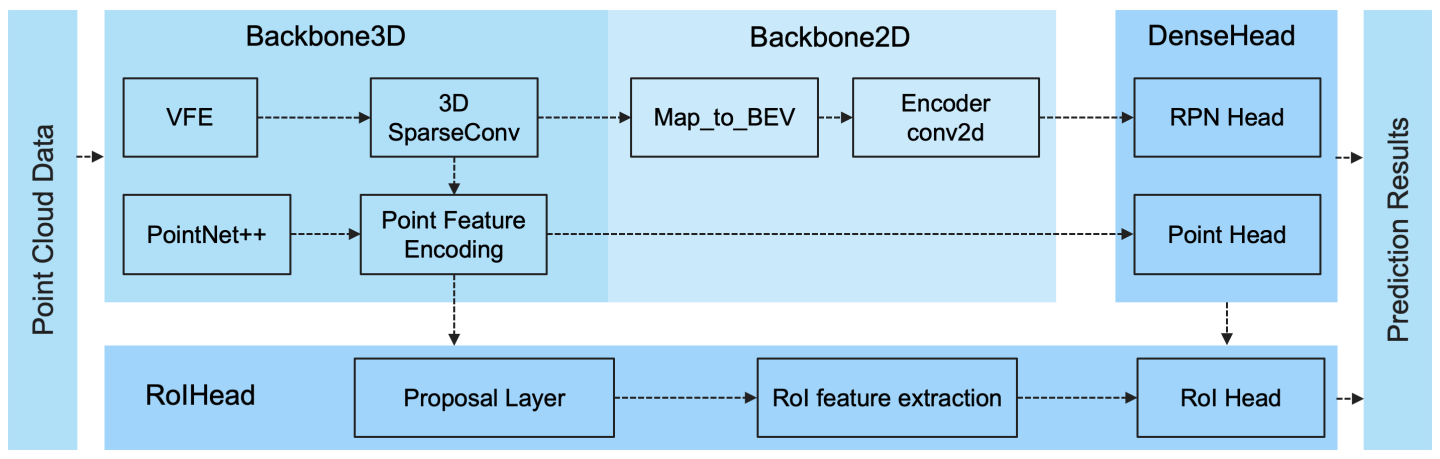

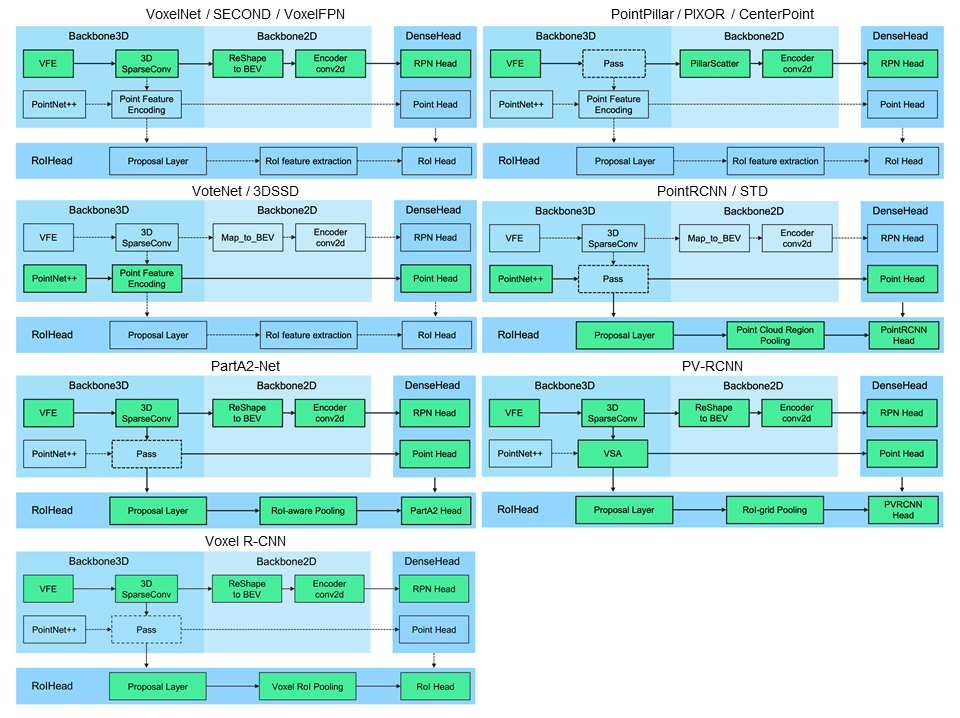

Flexible und klare Modellstruktur, um verschiedene 3D -Erkennungsmodelle einfach zu unterstützen:

Ausgewählte unterstützte Methoden sind in der folgenden Tabelle angezeigt. Die Ergebnisse sind die 3D -Erkennungsleistung von moderaten Schwierigkeiten auf dem Val -Satz von Kitti -Datensatz.

| Trainingszeit | Auto@R11 | Fußgänger@R11 | Radfahrer@R11 | herunterladen | |

|---|---|---|---|---|---|

| Pointpillar | ~ 1,2 Stunden | 77,28 | 52.29 | 62.68 | Modell 18m |

| ZWEITE | ~ 1,7 Stunden | 78,62 | 52,98 | 67.15 | Modell-20m |

| Zweit-iou | - - | 79.09 | 55.74 | 71.31 | Modell-46m |

| Pointrcnn | ~ 3 Stunden | 78,70 | 54.41 | 72.11 | Modell-16m |

| Pointrcnn-iou | ~ 3 Stunden | 78,75 | 58.32 | 71.34 | Modell-16m |

| Teil-A2-frei | ~ 3,8 Stunden | 78,72 | 65,99 | 74.29 | Modell-226m |

| Teil-A2-Anschwer | ~ 4,3 Stunden | 79,40 | 60.05 | 69,90 | Modell-244m |

| PV-RCNN | ~ 5 Stunden | 83.61 | 57.90 | 70,47 | Modell-50m |

| Voxel R-CNN (Auto) | ~ 2,2 Stunden | 84,54 | - - | - - | Modell-28m |

| Fokus konv - f | ~ 4 Stunden | 85.66 | - - | - - | Modell-30m |

| Caddn (Mono) | ~ 15 Stunden | 21.38 | 13.02 | 9.76 | Modell-774m |

Wir stellen die Einstellung von DATA_CONFIG.SAMPLED_INTERVAL auf dem WayMo Open Dataset (WOD) zur Verfügung, um Teilproben für das Training und Bewertung zu untersuchen, sodass Sie auch mit WOD spielen können, indem Sie eine kleinere DATA_CONFIG.SAMPLED_INTERVAL festlegen, auch wenn Sie nur begrenzte GPU -Ressourcen haben.

Standardmäßig werden alle Modelle mit einem einzelnen Rahmen von 20% Daten (~ 32K -Frames) aller Trainingsproben auf 8 GTX 1080TI -GPUs geschult, und die Ergebnisse jeder Zelle sind MAP/MAPH berechnet nach den offiziellen Waymo -Bewertungsmetriken auf dem gesamten Validierungssatz (Version 1.2).

| Leistung@(Zug mit 20% Daten) | Vec_l1 | Vec_l2 | Ped_l1 | Ped_l2 | Cyc_l1 | Cyc_l2 |

|---|---|---|---|---|---|---|

| ZWEITE | 70.96/70.34 | 62.58/62.02 | 65,23/54.24 | 57.22/47.49 | 57.13/55.62 | 54,97/53,53 |

| Pointpillar | 70.43/69.83 | 62.18/61.64 | 66.21/46.32 | 58.18/40.64 | 55.26/51.75 | 53.18/49.80 |

| Zentralpillar | 70.50/69.96 | 62.18/61.69 | 73.11/61.97 | 65.06/55.00 | 65.44/63.85 | 62.98/61.46 |

| Zentralpoint-Dynamic-Pillar | 70.46/69.93 | 62.06/61.58 | 73,92/63,35 | 65.91/56.33 | 66.24/64.69 | 63.73/62.24 |

| Zentrum | 71.33/70.76 | 63.16/62.65 | 72.09/65.49 | 64.27/58.23 | 68.68/67.39 | 66.11/64.87 |

| Centerpoint (Resnet) | 72.76/72.23 | 64,91/64.42 | 74.19/67.96 | 66.03/60.34 | 71.04/69.79 | 68.49/67.28 |

| Teil-A2-Anschwer | 74,66/74.12 | 65,82/65.32 | 71.71/62.24 | 62.46/54.06 | 66.53/65.18 | 64.05/62.75 |

| PV-RCNN (Anchorhead) | 75,41/74.74 | 67.44/66.80 | 71.98/61.24 | 63.70/53.95 | 65,88/64.25 | 63.39/61.82 |

| PV-RCNN (Centerhead) | 75,95/75.43 | 68.02/67.54 | 75,94/69.40 | 67.66/61.62 | 70.18/68.98 | 67.73/66.57 |

| Voxel R-CNN (Centerhead) -Dynamic-Voxel | 76.13/75.66 | 68.18/67.74 | 78.20/71.98 | 69.29/63.59 | 70.75/69.68 | 68.25/67.21 |

| PV-RCNN ++ | 77.82/77.32 | 69.07/68.62 | 77.99/71.36 | 69,92/63.74 | 71.80/70.71 | 69.31/68.26 |

| PV-RCNN ++ (Resnet) | 77.61/77.14 | 69.18/68.75 | 79,42/73,31 | 70,88/65.21 | 72.50/71.39 | 69.84/68.77 |

Hier bieten wir auch die Leistung mehrerer Modelle, die im vollständigen Trainingssatz trainiert wurden (siehe Papier von PV-RCNN ++):

| Leistung@(Zug mit 100% Daten) | Vec_l1 | Vec_l2 | Ped_l1 | Ped_l2 | Cyc_l1 | Cyc_l2 |

|---|---|---|---|---|---|---|

| ZWEITE | 72.27/71.69 | 63,85/63.33 | 68.70/58.18 | 60.72/51.31 | 60.62/59.28 | 58.34/57.05 |

| Zentralpillar | 73.37/72.86 | 65.09/64.62 | 75.35/65.11 | 67.61/58.25 | 67.76/66.22 | 65,25/63.77 |

| Teil-A2-Anschwer | 77.05/76.51 | 68.47/67.97 | 75.24/66.87 | 66.18/58.62 | 68.60/67.36 | 66.13/64.93 |

| Voxelnext-2D | 77.94/77.47 | 69.68/69.25 | 80.24/73.47 | 72.23/65.88 | 73.33/72.20 | 70.66/69.56 |

| Voxelnext | 78.16/77.70 | 69,86/69.42 | 81.47/76.30 | 73.48/68.63 | 76.06/74.90 | 73.29/72.18 |

| PV-RCNN (Centerhead) | 78.00/77,50 | 69.43/68.98 | 79,21/73.03 | 70.42/64.72 | 71.46/70.27 | 68.95/67.79 |

| PV-RCNN ++ | 79.10/78.63 | 70.34/69.91 | 80.62/74.62 | 71.86/66.30 | 73.49/72.38 | 70.70/69.62 |

| PV-RCNN ++ (Resnet) | 79,25/78.78 | 70.61/70.18 | 81.83/76.28 | 73.17/68.00 | 73.72/72.66 | 71.21/70.19 |

| DSVT-PILLAR | 79,44/78.97 | 71.24/70.81 | 83.00/77.22 | 75,45/69.95 | 76.70/75.70 | 73,83/72.86 |

| DSVT-Voxel | 79,77/79.31 | 71.67/71.25 | 83.75/78.92 | 76.21/71.57 | 77,57/76.58 | 74.70/73,73 |

| PV-RCNN ++ (Resnet, 2 Frames) | 80.17/79.70 | 72.14/71.70 | 83.48/80.42 | 75,54/72.61 | 74,63/73,75 | 72.35/71.50 |

| MPPNET (4 Frames) | 81.54/81.06 | 74.07/73,61 | 84.56/81.94 | 77.20/74.67 | 77.15/76.50 | 75,01/74.38 |

| MPPNET (16 Frames) | 82.74/82.28 | 75,41/74,96 | 84.69/82.25 | 77.43/75.06 | 77,28/76.66 | 75.13/74,52 |

Aufgrund des WayMo -Datensatzlizenzvertrags konnten wir die oben genannten Modelle nicht bereitstellen, aber Sie konnten durch das Training mit den Standardkonfigurationen leicht eine ähnliche Leistung erzielen.

Alle Modelle sind mit 8 GPUs ausgebildet und werden zum Download bereitgestellt. Für die Schulung BevFusion finden Sie in der Richtlinie.

| Kumpel | MASE | Maoe | Mave | Maae | Karte | Nds | herunterladen | |

|---|---|---|---|---|---|---|---|---|

| Pointpillar-Multihead | 33.87 | 26.00 | 32.07 | 28.74 | 20.15 | 44,63 | 58.23 | Modell-23m |

| Second-Multihead (CBGs) | 31.15 | 25.51 | 26.64 | 26.26 | 20.46 | 50.59 | 62.29 | Modell-35m |

| Zentralpunkt-Punktpillar | 31.13 | 26.04 | 42,92 | 23.90 | 19.14 | 50.03 | 60.70 | Modell-23m |

| Centerpoint (voxel_size = 0,1) | 30.11 | 25.55 | 38,28 | 21.94 | 18.87 | 56.03 | 64,54 | Modell-34m |

| Centerpoint (voxel_size = 0,075) | 28.80 | 25.43 | 37.27 | 21.55 | 18.24 | 59,22 | 66,48 | Modell-34m |

| Voxelnext (voxel_size = 0,075) | 30.11 | 25.23 | 40.57 | 21.69 | 18.56 | 60.53 | 66,65 | Modell-31m |

| Transfusion-L* | 27.96 | 25.37 | 29.35 | 27.31 | 18.55 | 64,58 | 69.43 | Modell-32m |

| Bevfusion | 28.03 | 25.43 | 30.19 | 26.76 | 18.48 | 67,75 | 70,98 | Modell-157m |

*: Verwenden Sie die FADE -Strategie, die Datenvergrößerungen in den letzten Epochen während des Trainings deaktiviert.

Alle Modelle sind mit 8 GPUs ausgebildet.

| Fahrzeug | Fußgänger | Radfahrer | Karte | |

|---|---|---|---|---|

| Pointrcnn | 52.09 | 4.28 | 29.84 | 28.74 |

| Pointpillar | 68,57 | 17.63 | 46,81 | 44,34 |

| ZWEITE | 71.19 | 26.44 | 58.04 | 51.89 |

| PV-RCNN | 77,77 | 23.50 | 59.37 | 53,55 |

| Zentrum | 78.02 | 49,74 | 67,22 | 64.99 |

Alle Modelle werden mit 4 GPUs ausgebildet.

| Karte | herunterladen | |

|---|---|---|

| Voxelnext | 30,5 | Modell-32m |

Willkommen bei anderen Datensätzen, indem Sie Pull -Anfrage senden.

Weitere Informationen finden Sie in der Installation von OpenPCDet .

In der Demo.MD finden Sie eine kurze Demo, um mit einem vorbereiteten Modell zu testen, und visualisieren Sie die vorhergesagten Ergebnisse Ihrer benutzerdefinierten Daten oder der ursprünglichen Kitti -Daten.

Weitere Informationen zu diesem Projekt finden Sie unter GOTNOW_STARTED.MD.

OpenPCDet wird unter der Apache 2.0 -Lizenz veröffentlicht.

OpenPCDet ist ein Open-Source-Projekt für die auf Lidar-basierte 3D-Szenenwahrnehmung, das mehrere Lidar-basierte Wahrnehmungsmodelle wie oben gezeigt unterstützt. Einige Teile von PCDet werden aus den offiziellen veröffentlichten Codes der oben unterstützten Methoden erfahren. Wir möchten uns für ihre vorgeschlagenen Methoden und die offizielle Implementierung bedanken.

Wir hoffen, dass dieses Repo als starke und flexible Codebasis für die Forschungsgemeinschaft dienen könnte, indem sie den Prozess der Neuimplementierung früherer Arbeiten und/oder der Entwicklung neuer Methoden beschleunigen.

Wenn Sie dieses Projekt in Ihrer Forschung nützlich finden, sollten Sie zitieren:

@misc{openpcdet2020,

title={OpenPCDet: An Open-source Toolbox for 3D Object Detection from Point Clouds},

author={OpenPCDet Development Team},

howpublished = {url{https://github.com/open-mmlab/OpenPCDet}},

year={2020}

}

Willkommen, ein Mitglied des OpenPCDET -Entwicklungsteams zu sein, indem Sie zu diesem Repo beigetragen haben, und können Sie sich gerne für potenzielle Beiträge kontaktieren.