GPT2-Chinese

Описание

- Китайская версия обучающего кода GPT2 с использованием токенизатора Bert или BPE. Он основан на чрезвычайно удивительном хранилище от Team Team Team Team Huggingface. Можно написать стихи, новости, романы или обучать общие языковые модели. Поддержка уровня Char, уровень слов и уровень BPE. Поддержать большой учебный корпус.

- Китайский обучающий код GPT2 использует модель BERT или модель BERT -BER (благодаря вкладу Канцхонхуа, внедрение модели BPE требует слегка изменяя код Train.py). Вы можете написать стихи, новости, романы или обучить общую языковую модель. Поддерживает блок Word, режим причастия слова или режим BPE (требуется немного измененный код Train.py). Поддерживает крупное обучение корпуса.

Обновление 04.11.2024

- Большое спасибо за внимание к этому проекту. С момента выпуска CHATGPT этот проект также снова привлекло внимание. Сам проект-это программа обучения, чтобы я сам изучал пироги, и я не собираюсь делать долгосрочное обслуживание и обновления. Если вы заинтересованы в Big Model LLM, вы можете написать мне ([email protected]), чтобы присоединиться к группе, чтобы сообщить или обсудить ее в этом вопросе.

Обновление 02.06.2021

Этот проект добавил общую предварительную модель GPT-2, предварительно обученную китайскую небольшую модель GPT-2, предварительно обученную модель GPT-2 в китайской лирике и предварительно обученную модель классической китайской GPT-2. Модель обучена проектом UER-PY и может его использовать. Кроме того, модель загружается в концентратор модели Huggingface. Для получения более подробной информации о модели, пожалуйста, обратитесь к GPT2-Chinese-Cluecorpussmall, GPT2-Distil-Chinese-Cluecorpussmall, GPT2-Chinese-Lic и GPT2-Chinese-Antient.

При создании использования всех моделей вам необходимо добавить начальный символ перед введенным текстом, например: если вы хотите ввести «Самое красивое - это не дождливый день, это карнизы, которые сбежали от вас», правильный формат - это «[CLS], самая красивая вещь - это не дождливый день, это карнисты, которые сбежали от вас».

Обновление 11.03.2020

Этот проект добавил предварительно обученную модель GPT-2 древнего стихотворения и предварительную модель Couple GPT-2. Модель обучена проектом UER-PY и может его использовать. Кроме того, модель загружается в концентратор модели Huggingface. Для получения более подробной информации о модели, пожалуйста, обратитесь к GPT2-Chinese-Poem и GPT2-Chinese-Coupet.

При создании использования модели древней поэзии вам нужно добавить начальный символ перед введенным текстом, например: если вы хотите ввести «Meishan, как Jiqing», правильный формат - «[CLS] Meishan похож на Jiqing».

Формат корпуса, используемый в обучении модели куплета,-это «верхний куплетный куплет-куплет». При использовании модели Couplet для генерации необходимо добавить начальный символ перед входным текстом, например: если вы хотите ввести «Данфенг реки Ленгрен Чу Го-», правильный формат-«[CLS] Danfeng River Lengren Chu Go-».

Новости 08.11.2020

- CDIAL-GPT (может быть загружен с помощью этого кода) был опубликован. Этот проект содержит строго очищенный крупномасштабный набор данных для диалога с открытым доменом. Этот проект также содержит предварительную модель диалога GPT, обученную, обученная этому набору данных, и сгенерированный образцы. Все могут посетить.

Новости 12.9.2019

- Новый проект GPT2-CHITCHAT был выпущен, частично основанный на коде этого проекта. Он содержит код и учебную модель для обучения модели диалога GPT2, а также генерировать образцы. Все могут посетить.

Новости 12.7.2019

- Новый проект декодеров-кинезе-TF2.0 также поддерживает китайскую подготовку для GPT2, который проще использовать и не легко вызывает различные проблемы. Это все еще находится на стадии тестирования, и все могут высказывать свое мнение.

Новости 11.9

- GPT2-ML (не прямая связь с этим проектом) была выпущена и содержит модель GPT2 1,5B. Если вы заинтересованы или нуждаетесь в этом, вы можете преобразовать его в формат Pytorch, поддерживаемый этим проектом для дальнейшего обучения или тестирования генерации.

Обновление 10.25

- Первая предварительно обученная модель этого проекта была объявлена и является моделью генерации прозы. Для получения подробной информации, пожалуйста, проверьте раздел обмена модели Readme.

Статус проекта

- Во время объявления этого проекта китайские ресурсы GPT2 были почти нулевыми, а ситуация сейчас отличается. Во -вторых, функции проекта были в основном стабильными, поэтому этот проект был временно остановлен. Моим первоначальным намерением написать эти коды было практиковать использование Pytorch. Даже если я проделал некоторую работу на более позднем этапе, было еще много незрелых аспектов, поэтому, пожалуйста, поймите.

Как использовать

- Создайте папку данных в каталоге Project Root. Поместите учебный корпус в каталог данных под названием Train.json. Train.json - это список JSON, и каждый элемент списка - это текстовое содержимое статьи, которая будет обучена (не ссылка на файл) .

- Запустите файл train.py и проверьте -Raw для автоматического предварительного обработки данных.

- После того, как предварительная обработка будет завершена, обучение будет выполнено автоматически.

Генерировать текст

python ./generate.py --length=50 --nsamples=4 --prefix=xxx --fast_pattern --save_samples --save_samples_path=/mnt/xx

- -fast_pattern (внесено в Leecp8): если параметр сгенерированной длины относительно невелик, а скорость в основном ничем не отличается, я лично протестированная длина = 250, что было на 2 секунды быстрее, поэтому, если--fast_pattern, то метод Fast_pattern не используется по умолчанию.

- -save_samples : По умолчанию выходной образец будет напечатан непосредственно на консоли. Передайте этот параметр и будет сохранен в Samples.txt в корневом каталоге.

- -save_samples_path : Вы можете указать сохраненный каталог самостоятельно. Вы можете создавать многоуровневые каталоги по умолчанию по умолчанию. Вы не можете передать имя файла. Имя файла - это samples.txt по умолчанию.

Структура файла

- Generate.py и Train.py - сценарии для поколения и обучения соответственно.

- Train_single.py - это расширение Train.py, которое можно использовать для большого списка отдельных элементов (таких как обучение книги на небе).

- Eval.py используется для оценки баллов PPL сгенерированной модели.

- Generate_Texts.py - это расширение Generate.py. Он может генерировать несколько предложений с начальными ключевыми словами списка и вывести их в файл.

- Train.json - это формат примера обучения образцов для справки.

- Папка кэша содержит несколько слоев Bert. make_vocab.py - это скрипт, который помогает создавать словарные слова в файле Train.json Corpus. Vocab.txt - это оригинальный Bert Vocab, Vocab_all.txt добавил дополнительный древний словарь, а Vocab_small.txt - это маленький словар.

- Папка «Токенизации» представляет собой три типа токенизаторов, которые могут быть выбраны, включая токенизатор по умолчанию BERT, версию Bert Tokenizer и Tokenizer BERT и токенизатора BPE.

- Сценарии включают в себя обучение образцов и сценарии генерации

Уведомление

- Этот проект использует токенизатор Bert для обработки китайских иероглиф.

- Если вы не используете версию причастию Tokenizer и вам не нужно классифицировать слова заранее, токенизатор поможет вам разделить ее.

- Если вы используете версию причастию Tokenizer, лучше всего использовать файл make_vocab.py в папке кэша для создания списка словарного запаса для вашего корпуса.

- Модель должна быть рассчитана сама по себе. Если вы завершили предварительное обучение, не стесняйтесь общаться.

- Если ваша память очень большая или корпус невелик, вы можете изменить соответствующий код в файлах сборки в Train.py и предварительно обработать корпус напрямую, не разделяя его.

- Если вы используете токенизатор BPE, вам нужно создать свой собственный список слов китайского языка

Материалы

- Можно скачать отсюда и здесь.

- Doupo Sky Corpus может быть загружен отсюда.

FP16 и поддержка накопления градиента

- Я добавил поддержку накопления FP16 и градиента в файл train.py. Если вы установите APEX и знаете, что такое FP16, вы можете изменить переменную fp16 = true, чтобы включить его. Однако в настоящее время FP16 может не сходиться по неизвестным причинам.

Свяжитесь с автором

Цитируя

@misc{GPT2-Chinese,

author = {Zeyao Du},

title = {GPT2-Chinese: Tools for training GPT2 model in Chinese language},

year = {2019},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/Morizeyao/GPT2-Chinese}},

}

Совместное использование модели

| Название модели | Введение модели | Разделяется | Адрес ссылки 1 | Адрес ссылки 2 |

|---|

| Модель прозы | Используйте 130 МБ знаменитой прозы, эмоциональной прозы и прозы. | Hughqiu | Baidu netdisk 【fpyu】 | GDRIVE |

| Поэзия модель | Результаты обучения с использованием около 800 000 древних стихов в 180 МБ. | Hhou435 | Baidu netdisk 【7fev】 | GDRIVE |

| Модель куплета | Доход обучения с использованием около 700 000 куплетов 40 МБ. | Hhou435 | Baidu netdisk 【i5n0】 | GDRIVE |

| Общая китайская модель | Результаты, полученные с использованием обучения Cluecorpussmall Corpus. | Hhou435 | Baidu NetDisk [N3S8] | GDRIVE |

| Общая китайская небольшая модель | Результаты, полученные с использованием обучения Cluecorpussmall Corpus. | Hhou435 | Baidu netdisk [rpjk] | GDRIVE |

| Китайская модель текста | Результаты обучения были получены с использованием около 150 000 китайских текстов 140 МБ. | Hhou435 | Baidu netdisk 【0qnn】 | GDRIVE |

| Классическая китайская модель | Около 3 миллионов классических китайских тренировок были получены с использованием 1,8 ГБ. | Hhou435 | Baidu netdisk [ek2z] | GDRIVE |

Вот модельный файл, полученный в результате обучения восторженных и щедрых друзей GIT, и он открыт для всех друзей для использования. В то же время все партнеры могут раскрыть модель, которую они обучали здесь.

Демо

- Модель, обученная пользователю Jameshujy, на основе модифицированного кода этого склада, используется в качестве фона регулируемых стихов и катрани. Была запущена новая версия генератора поэзии девяти песен.

- Внесенный Leemengtaiwan, он предоставляет статью, которая обеспечивает прямое введение в GPT-2 и как визуализировать механизмы самосознания. Ноутбуки и модели Colab также предоставляются для любого пользователя для создания новых примеров за один раз.

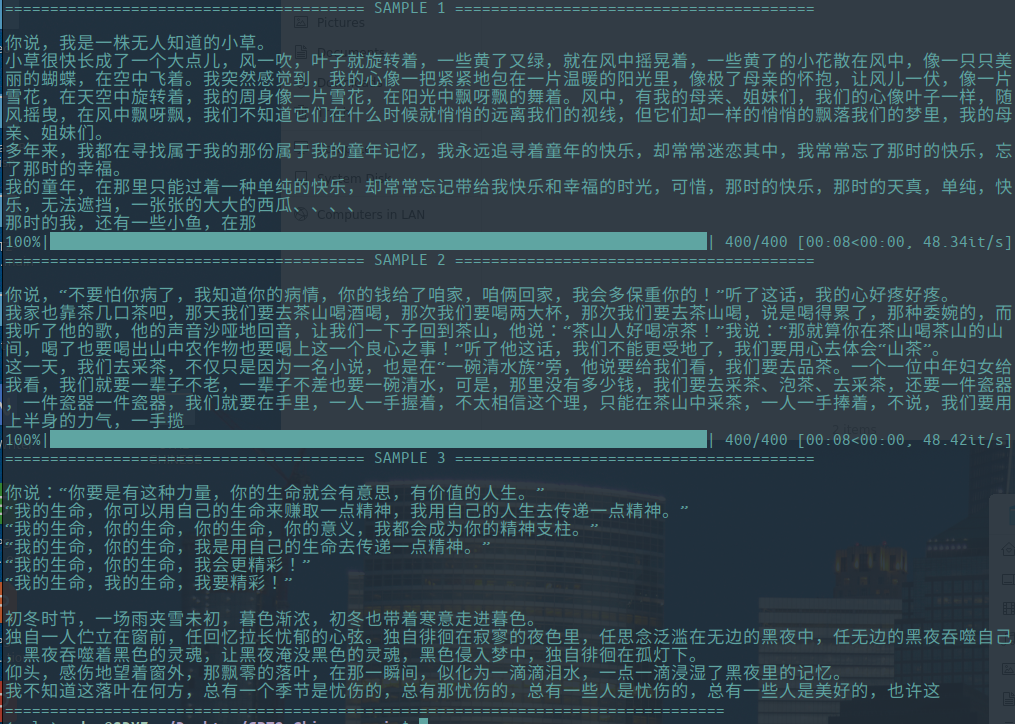

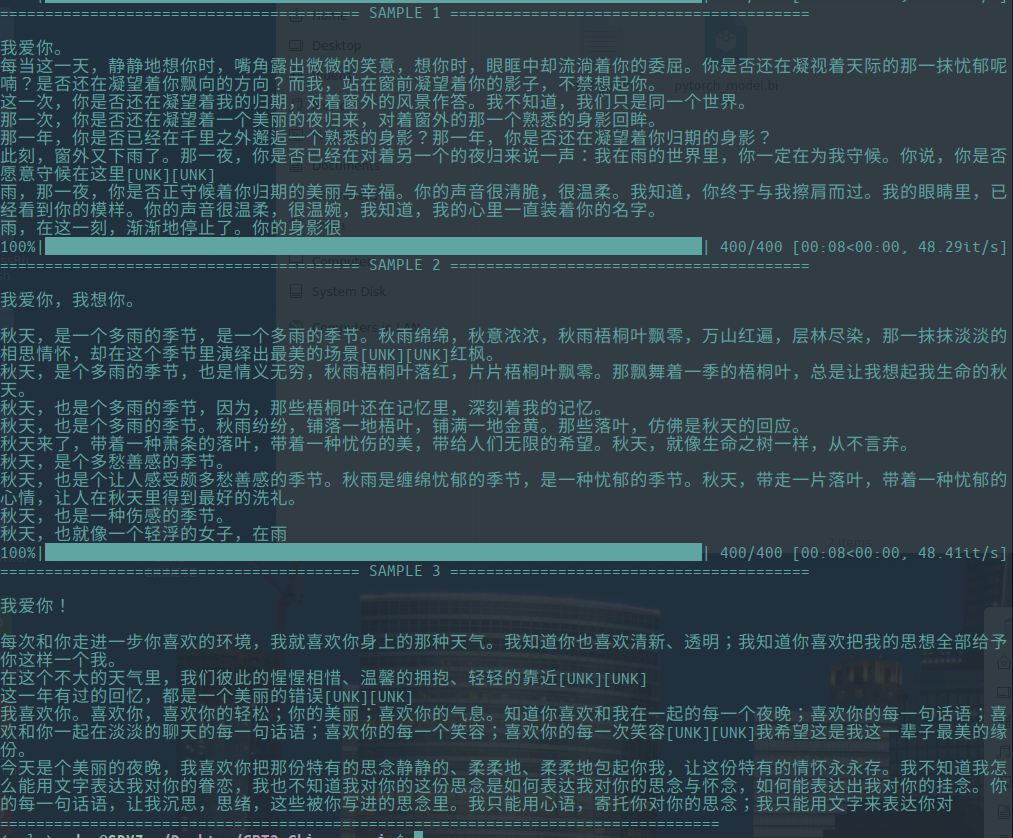

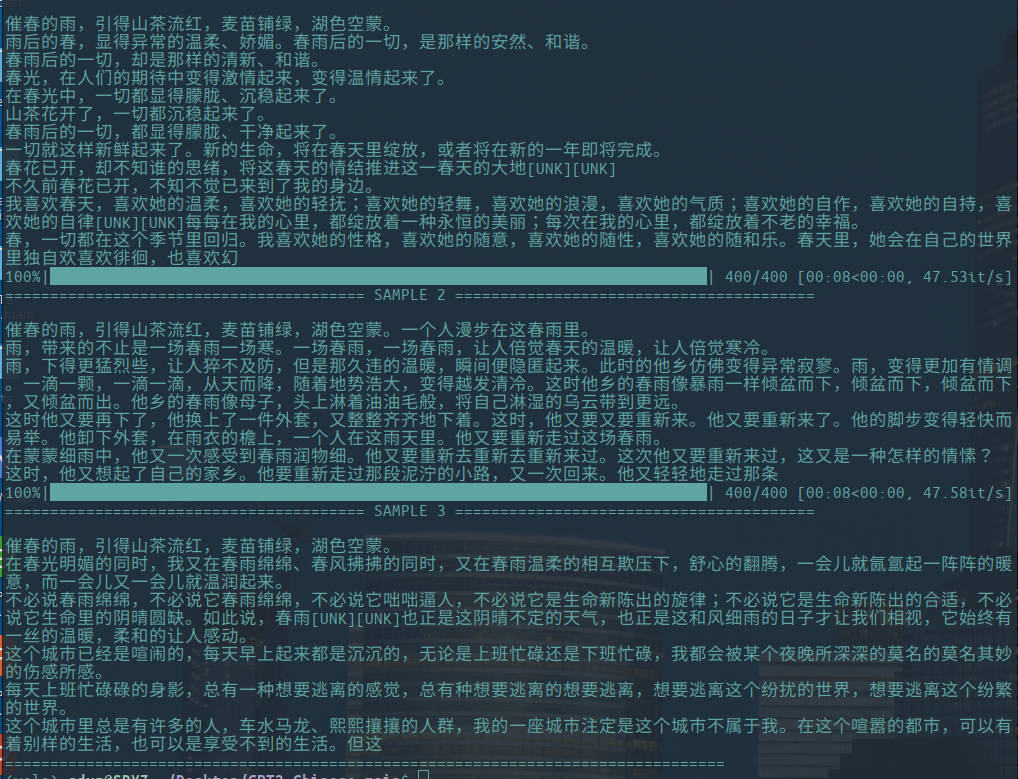

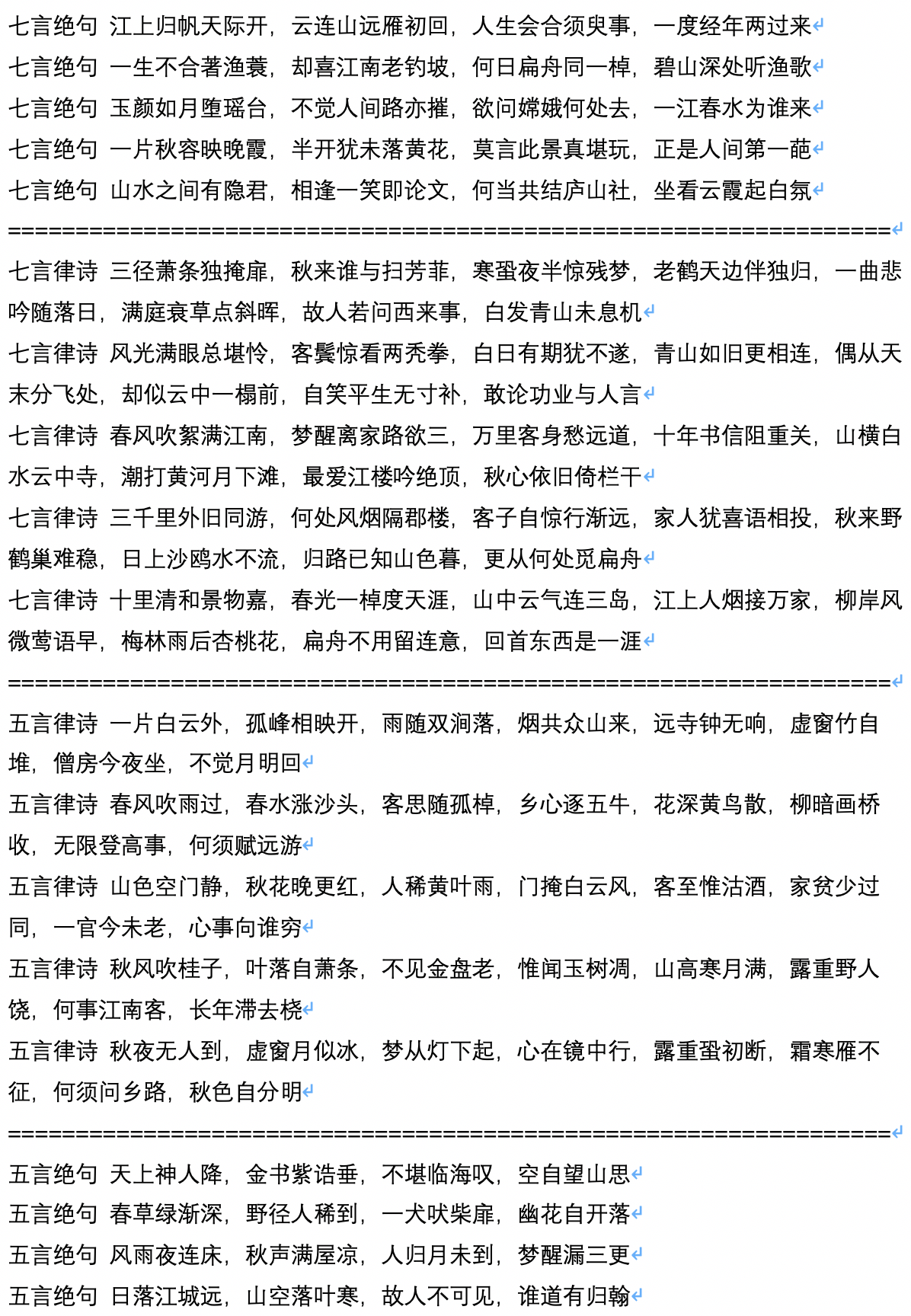

Генерировать образец

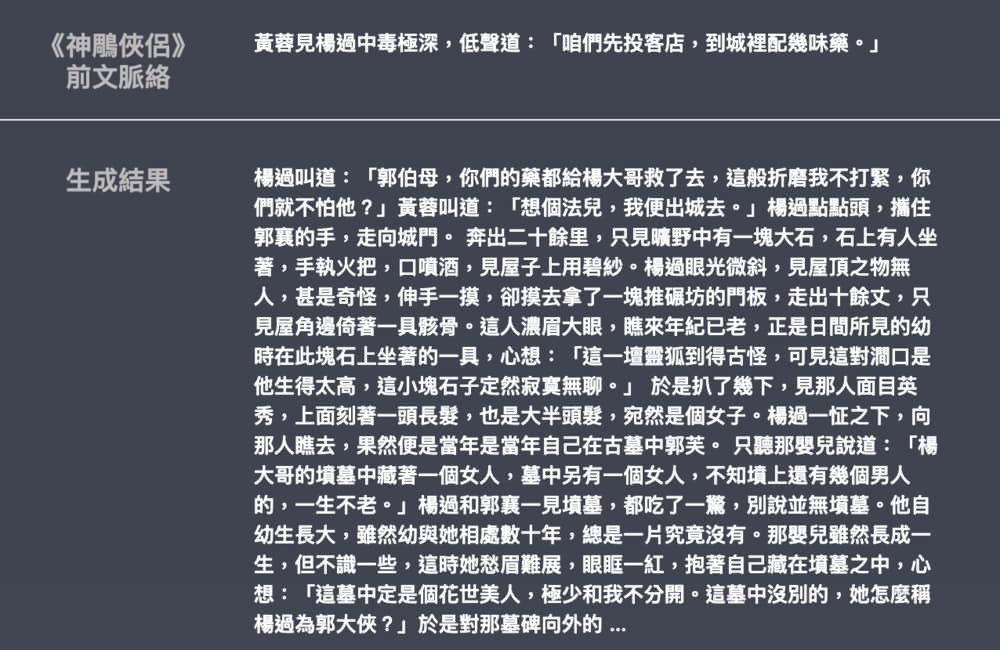

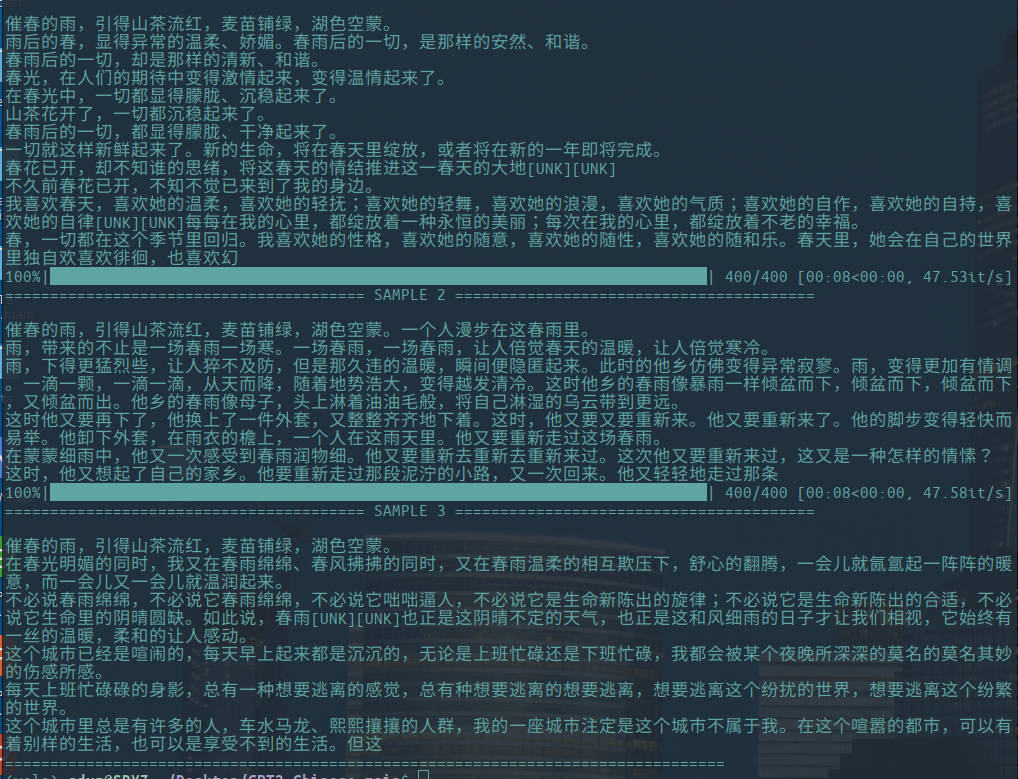

-Ниже приведены примеры генерации литературных очерков, внесенных Hughqiu, и модель была разделена в списке обмена моделью. Корпус 130 МБ, размер партии 16, 10 раундов тренировок на 10 слоях глубины.

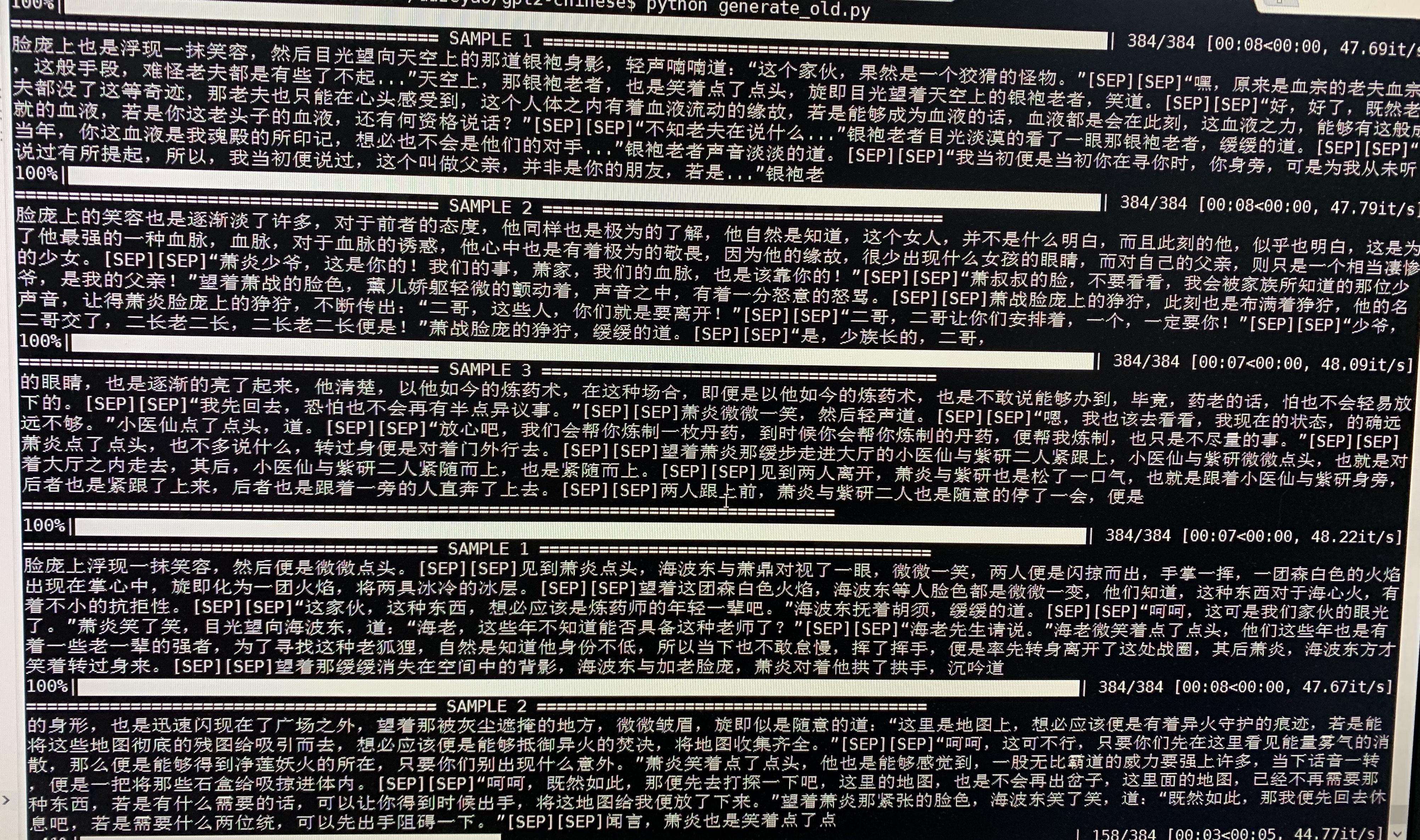

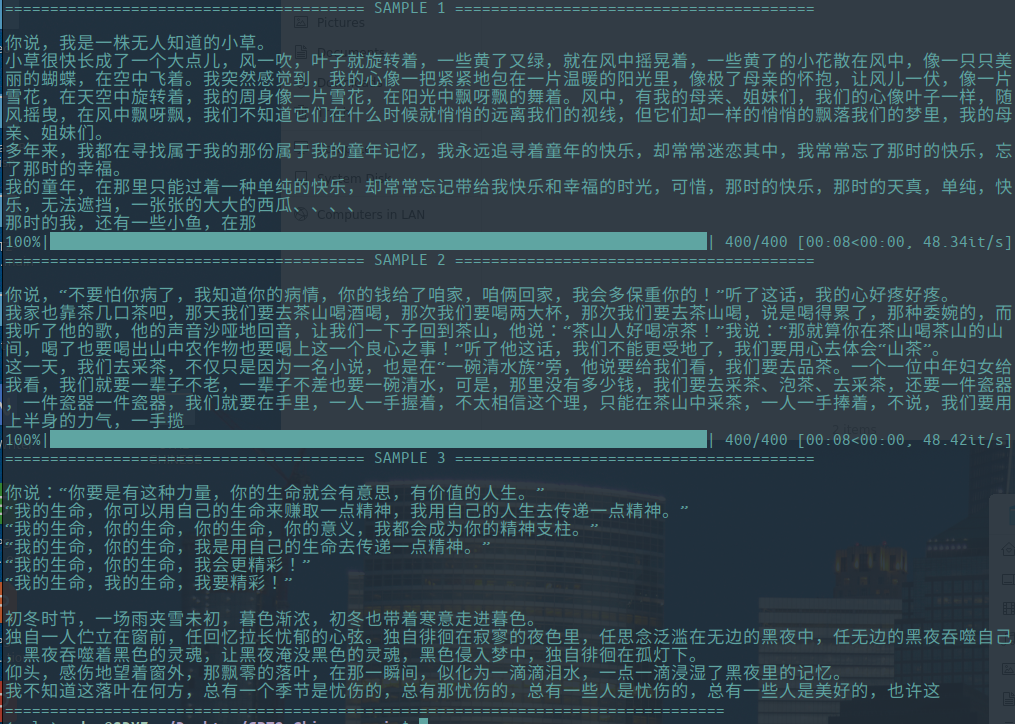

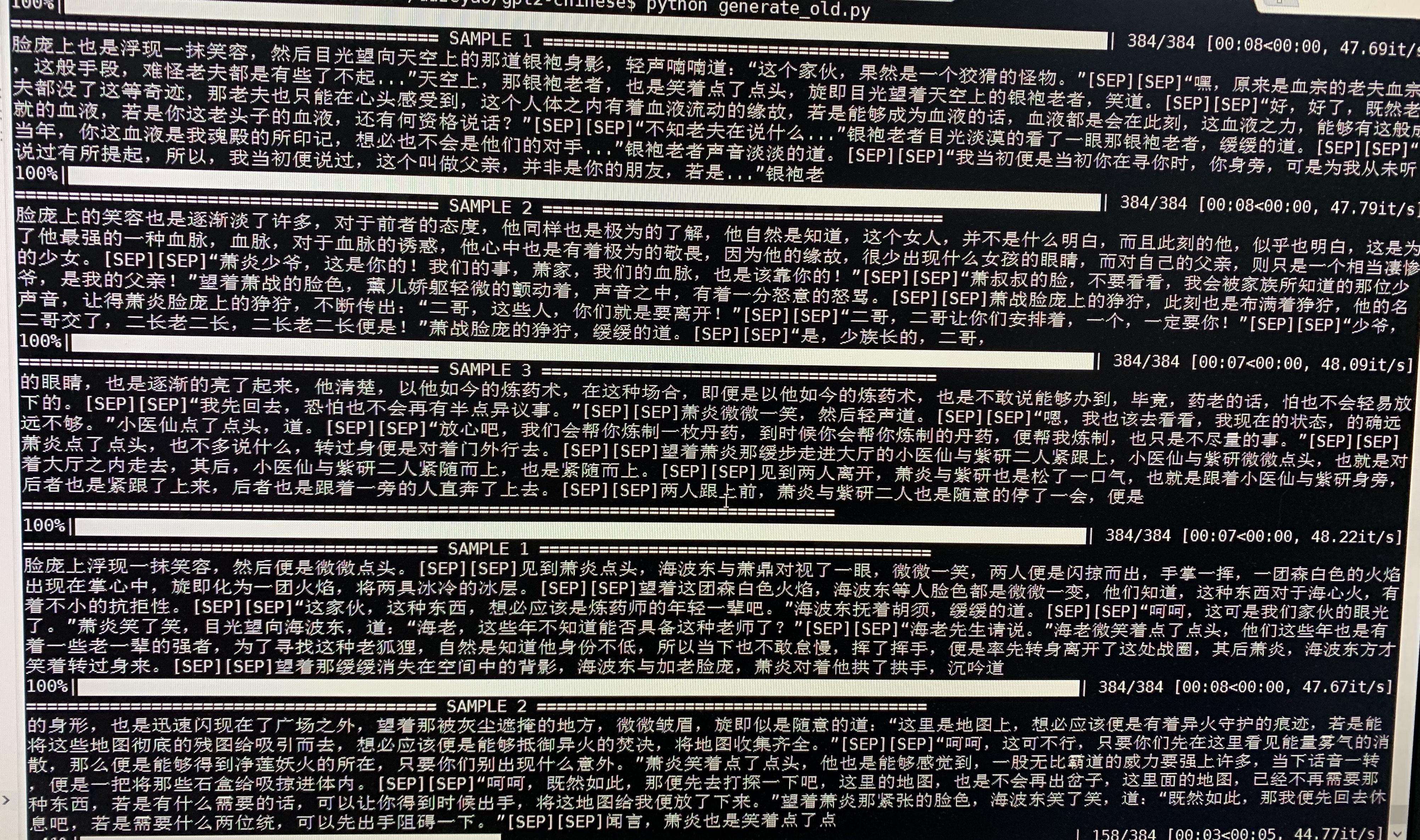

- Ниже приводится генерация образцов Doupo Cangqiong. GPT2 с параметрами около 50 м был обучен на новом контенте Doupo Cangqiong с размером 32 -мБ. Здесь [SEP] означает новую линию.

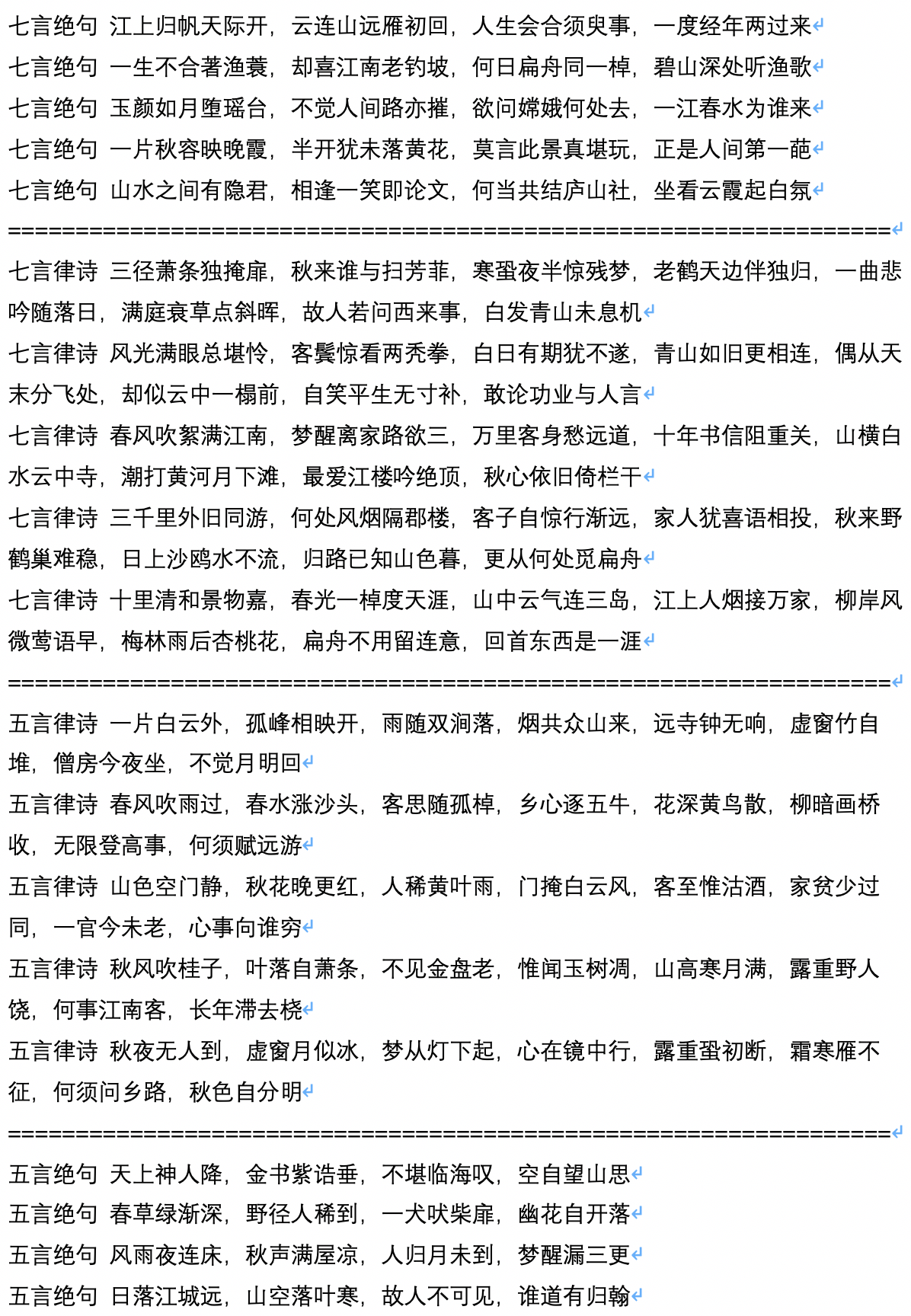

- Ниже приведен образец генерации древних стихов, которые рассчитываются и вносятся пользователем JaMeshujy.

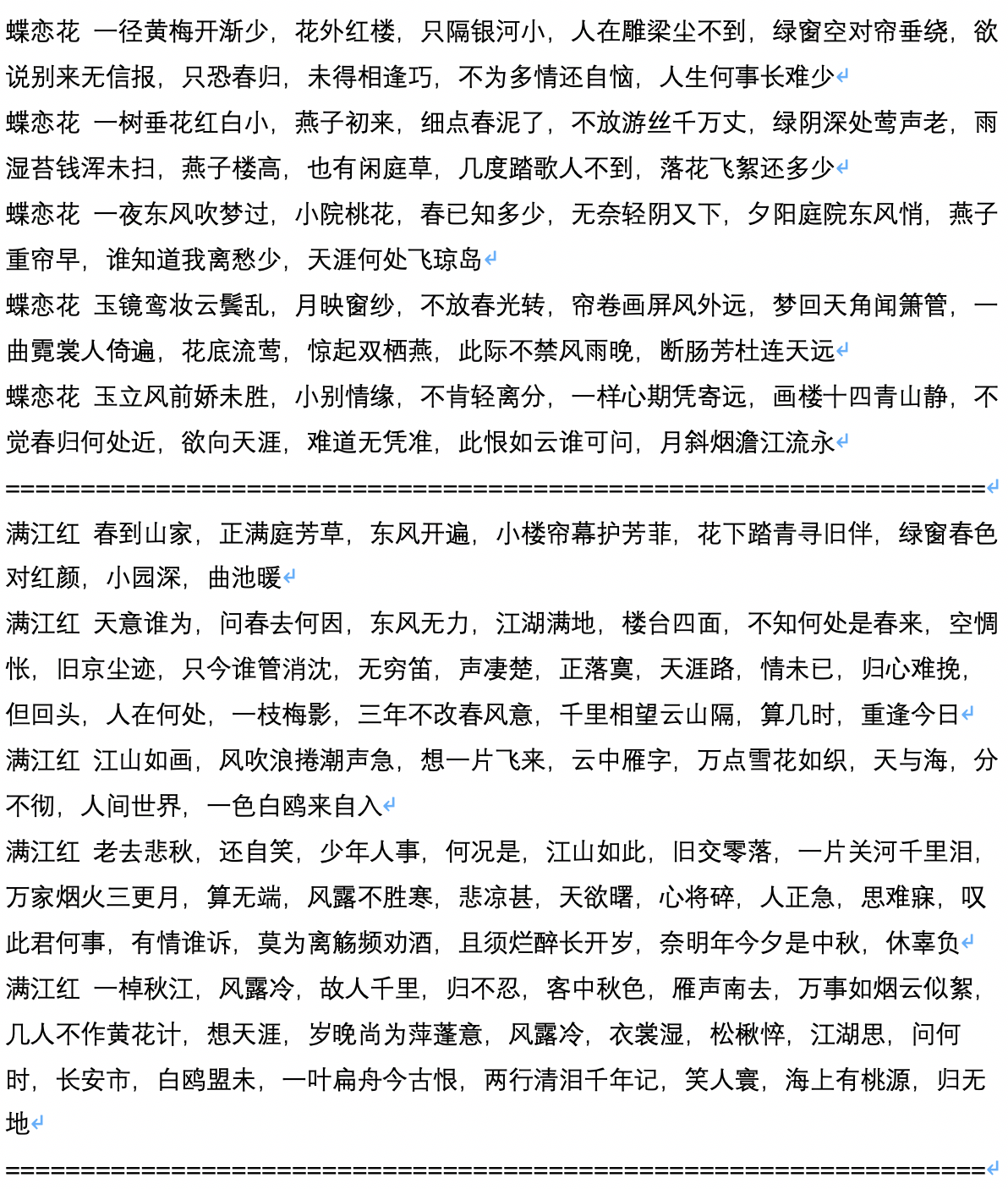

- Ниже приводится генерация образцов после генерации древнего стихотворения, которое рассчитывается и вносится вклад пользователем JaMeshujy.

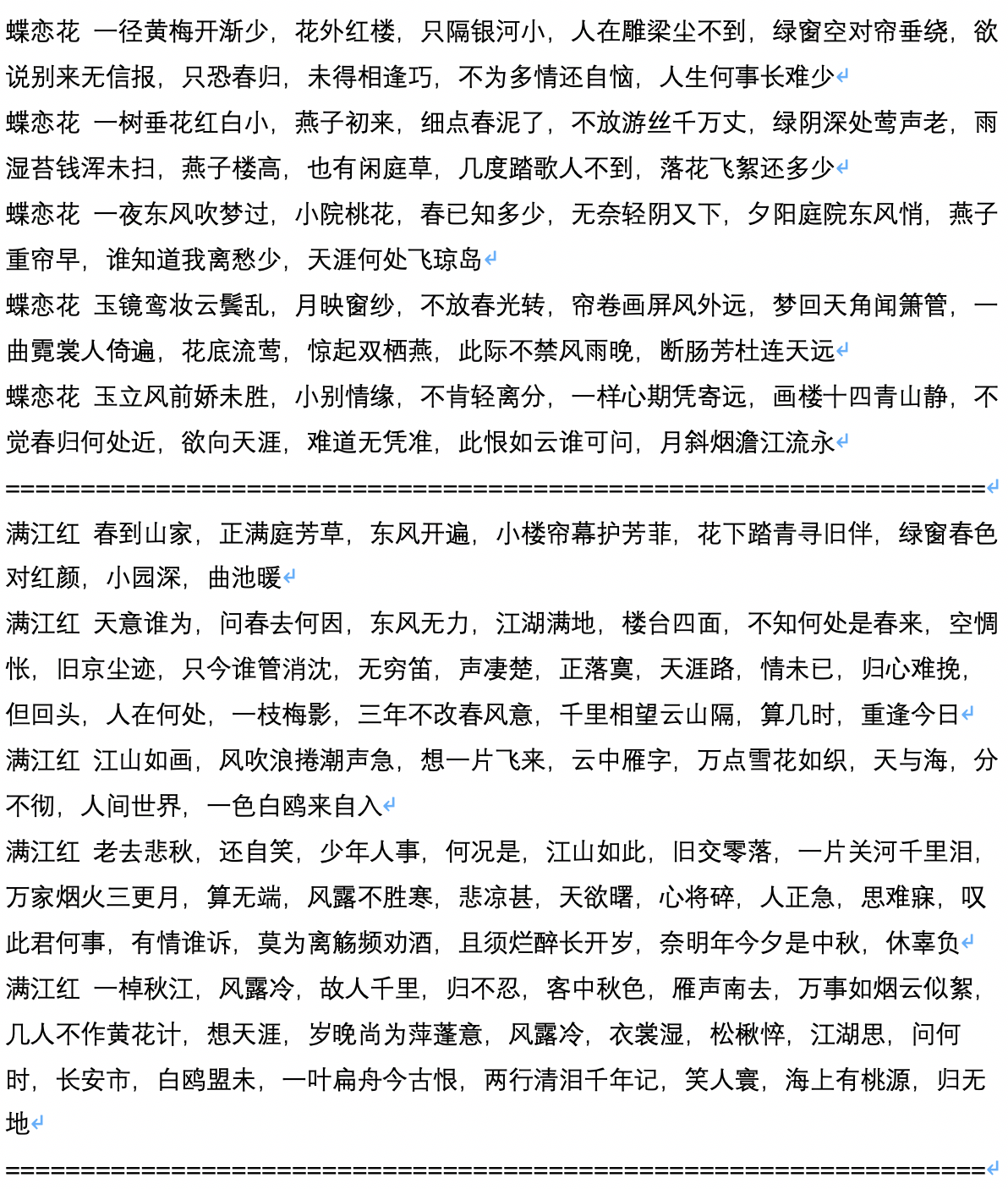

- Ниже приведен пример текста сгенерированного сценария, который рассчитывается и вносится пользователем Chiangandy.

[StartText] Сюжет любовной игры рассказывает историю милой любви между отцом и дочерью фортепиано, аудитории с тяжелой работой и ценностью для реальности для жизни и получении серии любви. Запись акций 1980 -х годов поделился сети. Это был брат директора бренда главного создателя Чена Лейна в 2014 году, большой страны реки Шанхай Хуайх. Хотя молодежь компании-линии не имела карьеры, Лан Чжэнши отказалась понять это. Появление концепции помощи Лан Юэ открыло явное недопонимание, и бизнес стал рекой любовью. В случайном сериале сериал изменил свою судьбу. Трое из них были назначены на свои творения в автомобильной аварии. Их спросили о недоразумении и сдержанном таланте в отрасли. Чен Чжао и Тан Шишиян начали совершенно разные «отношения 2014 года». У них был взаимный характер и имел взаимное лечение. Несмотря на то, что они были небольшим общежитием, записанным Университетом Пекина Хуакиао, поколением после 90-х годов и выдающимися молодыми людьми, такими как Tang Ru и Sheng, как жизнь людей продолжалась против их желаний и создает вместе? И почему они имели успех и заботу друг друга? [EndText]

[StartText] Изучение любви в основном рассказывает историю двух пар Xiaoman. После нелепого теста они, наконец, выбрали троих детей и начали бизнес вместе, чтобы создать четверых детей, и начали успешный бизнес в большом городе. Две компании присоединились к Пекинскому городу, и через некоторое время город был преобразован в беспорядки и в другой, они наконец приобрели настоящую любовь своей мечты. Церемония открытия главных предпринимательских персонажей, таких как идеалы спонсора, сериалы, драмы и т. Д., Проходила в Пекине. Драма основана на телевизионной перспективе трех новичков в Хайнане. Он рассказывает историю нескольких молодых людей, которые улучшили неромантику в Пекине и комедийных поколениях. Благодаря уникальной молодежи двойной эпохи из Пекина до Пекина, урбанизацией Китая крупные города Китая ушли из развития. С изменениями в языковых городах, в то время как их постепенный образ жизни построил такую простую поулсусность для их собственного направления. Это снимается в современное время. Как быть в этом городе? Так что спокойный город - это стиль города. Zhang Jiahe поддерживает создание работы, и это тот момент, когда необходимо создать собрание драмы в аэропорту. Люди, которые превращаются в шахматы и культуры, являются уникальными и сенсационными, переплетенными, смешными и приходят с красивого северо -востока и материка, и две девушки осмеливаются называться немыми девушками. Люди в переплетении пошутили, и впечатляющий темперамент заставил людей выглядеть очень комедийными. То, что они знали, было «северо -восточным» иностранным сторонником семьи, что заставило ее хорошо выглядеть в чтении драм. После этого Ци Фэй, Ци Фэй, фанат, Чу Юэзи и Бай Тяньцзи, которые выразили любовь к нему. Дружба между двумя поколениями, кажется, не сочетается в сочетании веселых и замечательных заявлений. [EndText]

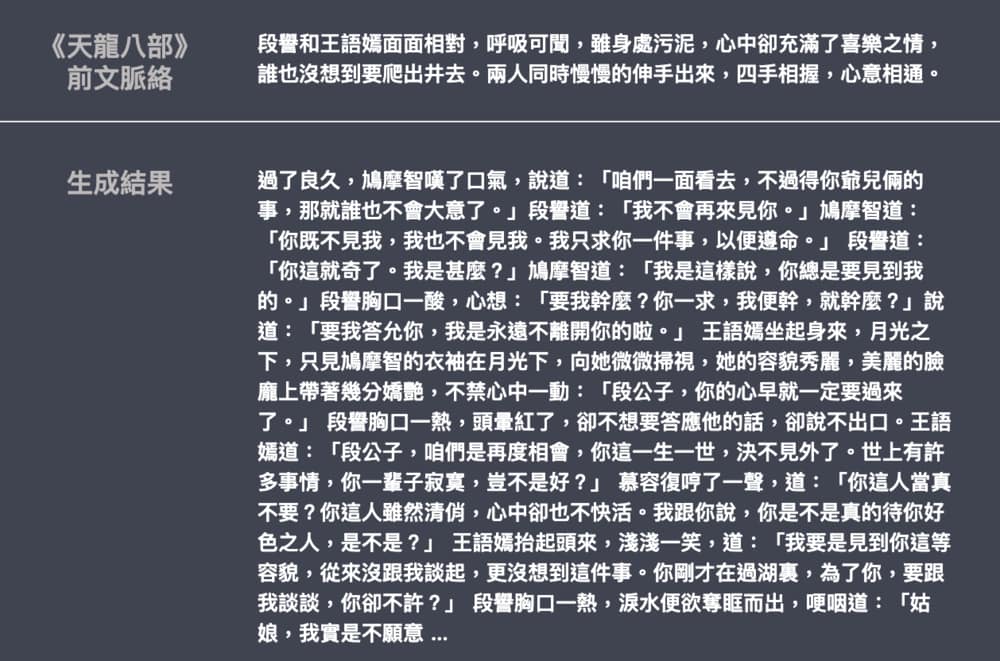

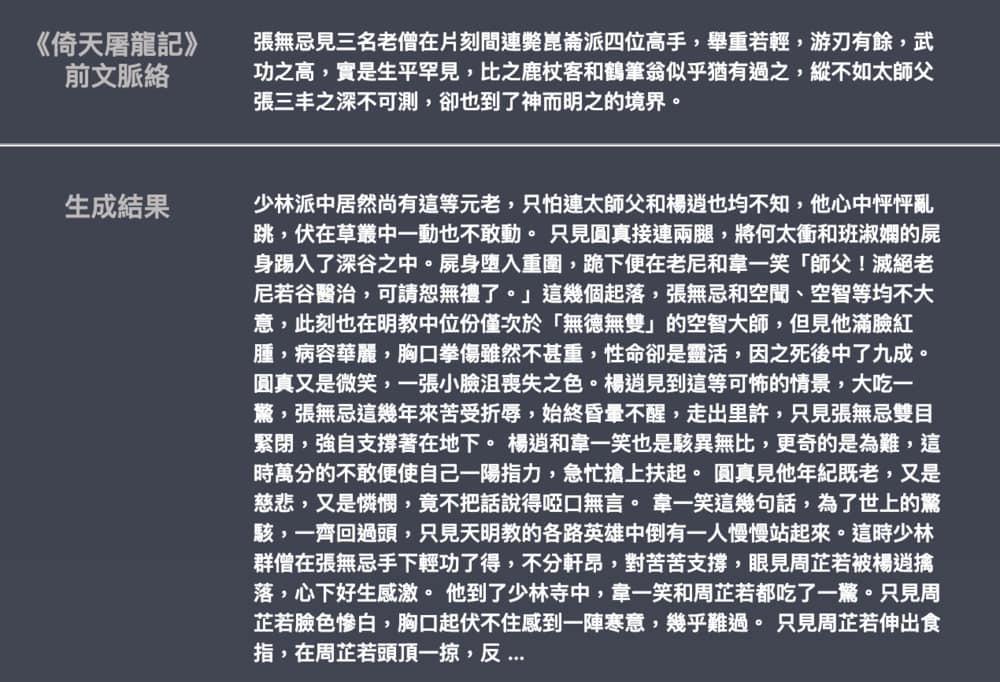

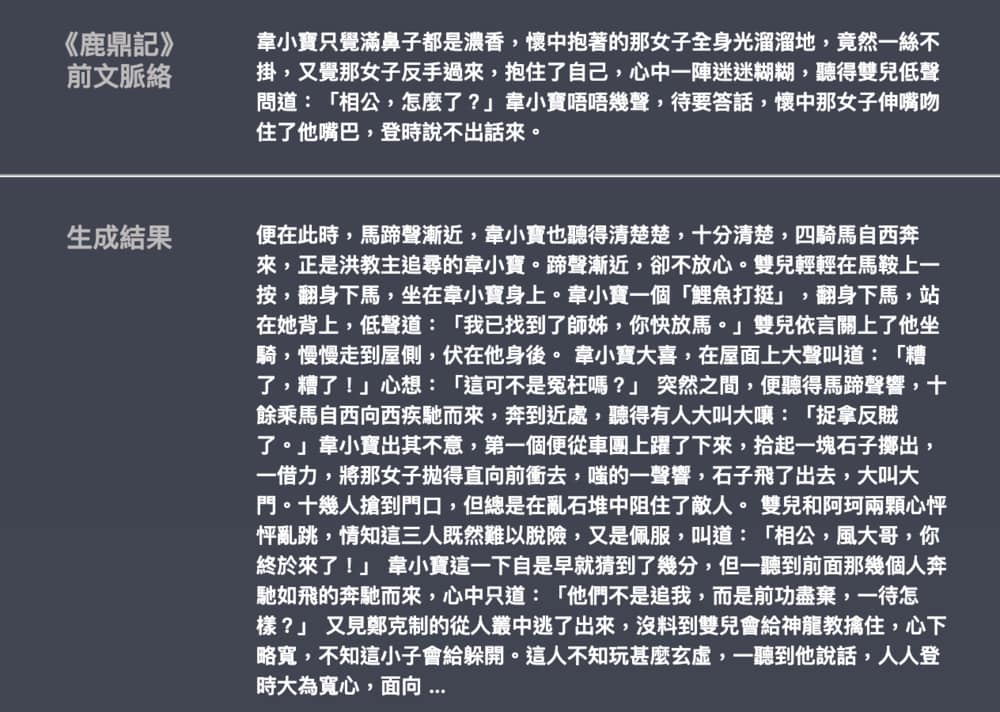

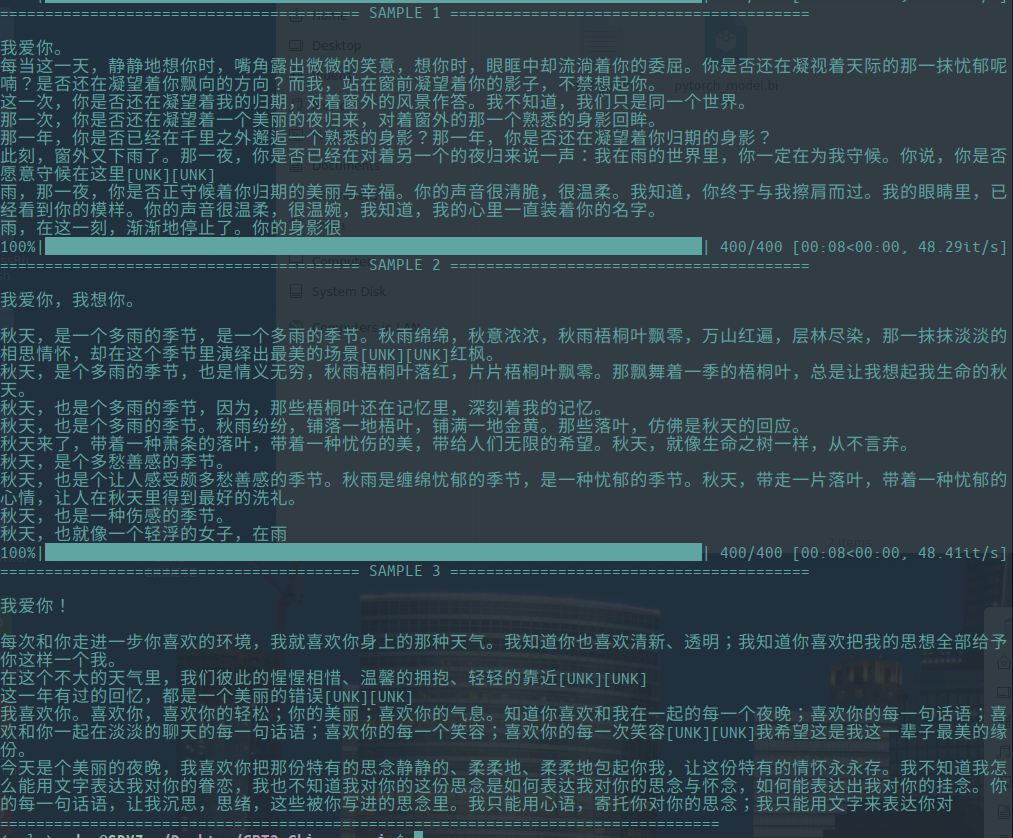

- Ниже приведен пример поколения романов Джин Йонг и Ву Ци, внесенного Лиеменгтайваном. Размер модели составляет около 82 м, языковой материал составляет 50 МБ, а размер партии-16. Предоставляет статью для введения GPT-2 и как визуализировать механизмы самостоятельного прихода. Ноутбуки и модели Colab также предоставляются для любого пользователя для создания новых примеров за один раз.