GPT2 الصين

وصف

- النسخة الصينية من رمز التدريب GPT2 ، باستخدام Bert Tokenizer أو BPE Tokenizer. يعتمد على المستودع الرائع للغاية من محولات فريق Huggingface. يمكن كتابة القصائد أو الأخبار أو الروايات أو تدريب نماذج اللغة العامة. دعم مستوى char ، مستوى الكلمات ومستوى BPE. دعم مجموعة التدريب الكبيرة.

- يستخدم رمز التدريب الصيني GPT2 Tokenizer أو نموذج BPE الخاص بـ Bert (بفضل مساهمة Kangzhonghua ، يتطلب تطبيق نموذج BPE تعديل رمز Train.py قليلاً). يمكنك كتابة الشعر أو الأخبار أو الروايات أو تدريب نموذج لغة مشتركة. يدعم وحدة الكلمات أو وضع النعت في Word أو وضع BPE (يتطلب Train.py Train. يدعم تدريب كوربوس الكبير.

تحديث 04.11.2024

- شكرا جزيلا على اهتمامك بهذا المشروع. منذ إصدار ChatGPT ، اجتذب هذا المشروع أيضًا بعض الاهتمام مرة أخرى. المشروع نفسه هو برنامج تدريبي بالنسبة لي لتعلم Pytorch بنفسي ، وليس لدي أي نية للقيام بالصيانة والتحديثات طويلة الأجل. إذا كنت مهتمًا بـ Big Model LLM ، فيمكنك مراسلتي عبر البريد الإلكتروني ([email protected]) للانضمام إلى المجموعة للتواصل أو مناقشتها.

تحديث 02.06.2021

أضاف هذا المشروع نموذجًا عامًا صينيًا من GPT-2 المدربين مسبقًا ، وهو نموذج صغير صيني GPT-2 الصغير المدرب مسبقًا ، ونموذج صيني GPT-2 تم تدريبه مسبقًا ونموذج GPT-2 الصيني الكلاسيكي. يتم تدريب النموذج من قبل مشروع UER-PY ويرحب به لاستخدامه. بالإضافة إلى ذلك ، يتم تحميل النموذج إلى مركز Huggingface Model. لمزيد من التفاصيل عن النموذج ، يرجى الرجوع إلى GPT2-ClueCorpussMall ، GPT2-Distil-chinese-Cluecorpussmall ، GPT2-Chinese-Lyric و GPT2-Chinese.

عند توليدها باستخدام جميع النماذج ، تحتاج إلى إضافة رمز بداية قبل النص الذي تم إدخاله ، مثل: إذا كنت ترغب في إدخال "أجمل شيء ليس هو يوم الممطر ، فإن التنفس الذي هرب منك" ، فإن التنسيق الصحيح هو "[CLS] أجمل شيء ليس هو يوم الممطر ، وهو ما هرب منك".

تحديث 11.03.2020

أضاف هذا المشروع نموذج القصيدة القديم GPT-2 المدربة مسبقًا ونموذج GPT-2 الذي تم تدريبه مسبقًا. يتم تدريب النموذج من قبل مشروع UER-PY ويرحب به لاستخدامه. بالإضافة إلى ذلك ، يتم تحميل النموذج إلى مركز Huggingface Model. لمزيد من تفاصيل النموذج ، يرجى الرجوع إلى GPT2-Chinese-Poem و GPT2-Chinese-Couplet.

عند توليدها باستخدام نموذج الشعر القديم ، تحتاج إلى إضافة رمز بداية قبل النص الذي تم إدخاله ، مثل: إذا كنت تريد إدخال "Meishan مثل Jiqing ،" التنسيق الصحيح هو "[CLS] Meishan مثل Jiqing".

إن تنسيق Corpus المستخدم في تدريب نموذج الاقتران هو "Canclet Canclet Canclet". عند استخدام نموذج CONICALT لإنشاء ، يجب إضافة حرف انطلاق قبل نص الإدخال ، مثل: إذا كنت ترغب في إدخال "Danfeng River Lengren Chu Go-" ، فإن التنسيق الصحيح هو "[CLS] Danfeng River Lengren Chu Go-".

أخبار 08.11.2020

- تم نشر CDIAL-GPT (يمكن تحميله مع هذا الرمز). يحتوي هذا المشروع على مجموعة بيانات حوار صينية مفتوحة النطاق تم تنظيفها بدقة. يحتوي هذا المشروع أيضًا على نموذج حوار GPT الذي تم تدريبه مسبقًا مدربًا على مجموعة البيانات هذه والعينة التي تم إنشاؤها. الجميع مرحب بهم للزيارة.

أخبار 12.9.2019

- تم إصدار المشروع الجديد GPT2-chitchat ، بناءً على رمز هذا المشروع. أنه يحتوي على الكود ونموذج التدريب لتدريب نموذج حوار GPT2 ، وكذلك إنشاء عينات. الجميع مرحب بهم للزيارة.

أخبار 12.7.2019

- يدعم Deconders-TF2.0 الجديدة من Decoders-TF2.0 التدريب الصيني لـ GPT2 ، وهو أمر أسهل في الاستخدام ولا يسبب مشاكل مختلفة بسهولة. لا يزال في مرحلة الاختبار ، والجميع مرحب بهم لإعطاء آرائهم.

أخبار 11.9

- تم إصدار GPT2-ML (لا يوجد ارتباط مباشر مع هذا المشروع) ويحتوي على نموذج GPT2 الصيني 1.5B. إذا كنت مهتمًا أو في حاجة إليها ، فيمكنك تحويله إلى تنسيق Pytorch الذي يدعمه هذا المشروع لمزيد من التدريب أو اختبار التوليد.

تحديث 10.25

- تم الإعلان عن أول نموذج تم تدريبه مسبقًا لهذا المشروع وهو نموذج لتوليد النثر. للحصول على التفاصيل ، يرجى التحقق من قسم مشاركة طراز ReadMe.

حالة المشروع

- في وقت إعلان هذا المشروع ، كانت موارد GPT2 الصينية صفر تقريبًا ، والوضع مختلف الآن. ثانياً ، كانت وظائف المشروع مستقرة بشكل أساسي ، لذلك تم إيقاف هذا المشروع مؤقتًا. كانت نيتي الأصلية في كتابة هذه الرموز هي ممارسة استخدام Pytorch. حتى لو قمت ببعض العمل في المرحلة اللاحقة ، لا يزال هناك العديد من الجوانب غير الناضجة ، لذا يرجى الفهم.

كيفية استخدام

- إنشاء مجلد بيانات في دليل جذر المشروع. ضع مجموعة التدريب في دليل البيانات تحت اسم Train.json. Train.json هي قائمة JSON ، وكل عنصر من عناصر القائمة هو محتوى النص لمقال يتم تدريبه (وليس رابط ملف) .

- قم بتشغيل ملف Train.py وتحقق -RAW للمعالجة المسبقة للبيانات تلقائيًا.

- بعد اكتمال المعالجة المسبقة ، سيتم تنفيذ التدريب تلقائيًا.

توليد النص

python ./generate.py --length=50 --nsamples=4 --prefix=xxx --fast_pattern --save_samples --save_samples_path=/mnt/xx

- -fast_pattern (التي ساهمت بها LEECP8): إذا كانت المعلمة الطول التي تم إنشاؤها صغيرة نسبيًا ولم تكن السرعة مختلفة بشكل أساسي ، فقد اختبرت شخصياً الطول = 250 ، والذي كان أسرع من ثانيتين ، لذلك إذا لم تتم إضافة-fast_pattern ، فإن طريقة fast_pattern لا تستخدم بالتخلف.

- -save_samples : بشكل افتراضي ، سيتم طباعة عينة الإخراج مباشرة إلى وحدة التحكم. تمرير هذه المعلمة وسيتم حفظها في samples.txt في دليل الجذر.

- --save_samples_path : يمكنك تحديد الدليل المحفوظ بنفسك. يمكنك إنشاء أدلة متعددة المستويات بشكل متكرر افتراضيًا. لا يمكنك تمرير اسم الملف. اسم الملف هو samples.txt بشكل افتراضي.

بنية الملف

- cender.py و Train.py هي البرامج النصية للجيل والتدريب على التوالي.

- Train_single.py هو امتداد لـ Train.py يمكن استخدامه لقائمة كبيرة من العناصر الفردية (مثل تدريب كتاب على السماء).

- يتم استخدام eval.py لتقييم درجات PPL للنموذج الذي تم إنشاؤه.

- cenerte_texts.py هو امتداد ل cender.py. يمكن أن ينشئ عدة جمل مع الكلمات الرئيسية البداية للقائمة وإخراجها إلى ملف.

- Train.json هو مثال تنسيق لعينات التدريب للرجوع إليه.

- يحتوي مجلد ذاكرة التخزين المؤقت على العديد من المفردات Bert. Make_vocab.py هو برنامج نصي يساعد على إنشاء المفردات على ملف Train.json Corpus. VocAb.txt هو Bert Ocab الأصلي ، VOCAB_ALL.TXT أضاف VOCAB قديم إضافي ، و VOCAB_SMALL.TXT هو المفردات الصغيرة.

- مجلد الرمز المميز هو ثلاثة أنواع من المميزات التي يمكن اختيارها ، بما في ذلك Bert Tokenizer الافتراضي ، وإصدار النعت من Bert Tokenizer و BPE Tokenizer.

- وتشمل البرامج النصية نماذج التدريب والبرامج النصية

يلاحظ

- يستخدم هذا المشروع Bert's Tokenizer لمعالجة الأحرف الصينية.

- إذا لم تستخدم إصدار Tokenizer Gorngle ولم تكن بحاجة إلى تصنيف الكلمات بنفسك مسبقًا ، فسيساعدك Tokenizer على تقسيمها.

- إذا كنت تستخدم إصدار Tokenizer Gollle ، فمن الأفضل استخدام ملف Make_vocab.py في مجلد ذاكرة التخزين المؤقت لإنشاء قائمة مفردات لجسمك.

- يجب حساب النموذج بنفسه. إذا كنت قد أكملت التدريب المسبق ، فلا تتردد في التواصل.

- إذا كانت ذاكرتك كبيرة جدًا أو كانت المجموعة صغيرة ، فيمكنك تغيير الكود المقابل في ملفات الإنشاء في Train.py والمعالجة المسبقة مباشرة دون تقسيمها.

- إذا كنت تستخدم BPE Tokenizer ، فأنت بحاجة إلى إنشاء قائمة الكلمات الصينية الخاصة بك

مواد

- يمكن تنزيلها من هنا وهنا.

- يمكن تنزيل Doupo Sky Corpus من هنا.

FP16 ودعم تراكم التدرج

- لقد أضفت FP16 ودعم تراكم التدرج إلى ملف Train.py. إذا قمت بتثبيت Apex ومعرفة ماهية FP16 ، فيمكنك تغيير المتغير FP16 = TRUE لتمكينه. ومع ذلك ، في الوقت الحالي ، قد لا تتقارب FP16 ، لأسباب غير معروفة.

اتصل بالمؤلف

نقلا عن

@misc{GPT2-Chinese,

author = {Zeyao Du},

title = {GPT2-Chinese: Tools for training GPT2 model in Chinese language},

year = {2019},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/Morizeyao/GPT2-Chinese}},

}

مشاركة النموذج

| اسم النموذج | مقدمة نموذج | مشترك من قبل | عنوان الرابط 1 | عنوان الرابط 2 |

|---|

| نموذج النثر | استخدم 130 ميجابايت من النثر الشهير ، النثر العاطفي والتدريب على شعر النثر. | Hughqiu | baidu netdisk 【fpyu】 | Gdrive |

| نموذج الشعر | نتائج التدريب باستخدام حوالي 800000 قصيدة قديمة في 180 ميجابايت. | HHOU435 | Baidu NetDisk 【7fev】 | Gdrive |

| نموذج الإرهاق | الدخل التدريبي من استخدام حوالي 700000 مقاطع من 40 ميجابايت. | HHOU435 | Baidu netDisk 【i5n0】 | Gdrive |

| النموذج الصيني العام | النتائج التي تم الحصول عليها باستخدام تدريب ClueCorpussMall Corpus. | HHOU435 | Baidu NetDisk [N3S8] | Gdrive |

| نموذج صيني صغير | النتائج التي تم الحصول عليها باستخدام تدريب ClueCorpussMall Corpus. | HHOU435 | Baidu NetDisk [RPJK] | Gdrive |

| نموذج كلمات الصينية | تم الحصول على نتائج التدريب باستخدام حوالي 150،000 كلمات صينية من 140 ميجابايت. | HHOU435 | Baidu NetDisk 【0qnn】 | Gdrive |

| النموذج الصيني الكلاسيكي | تم الحصول على حوالي 3 ملايين قطعة تدريب صينية كلاسيكية باستخدام 1.8 جيجابايت. | HHOU435 | Baidu NetDisk [ek2z] | Gdrive |

فيما يلي ملف نموذج تم الحصول عليه من تدريب أصدقاء GIT المتحمسين والسخين ، وهو مفتوح لجميع الأصدقاء للاستخدام. في الوقت نفسه ، نرحب بجميع الشركاء للكشف عن النموذج الذي قاموا بتدريبه هنا.

العرض التوضيحي

- يتم استخدام النموذج الذي تم تدريبه بواسطة المستخدم Jameshujy استنادًا إلى الكود المعدل لهذا المستودع كخلفية للآية المنظمة والكواليس. تم إطلاق الإصدار الجديد من مولد شعر الأغاني التسعة.

- التي ساهمت بها Leemengtaiwan ، فإنه يوفر مقالة توفر مقدمة مباشرة إلى GPT-2 وكيفية تصور آليات الاهتمام الذاتي. يتم توفير دفاتر ونماذج كولاب أيضًا لأي مستخدم لإنشاء أمثلة جديدة دفعة واحدة.

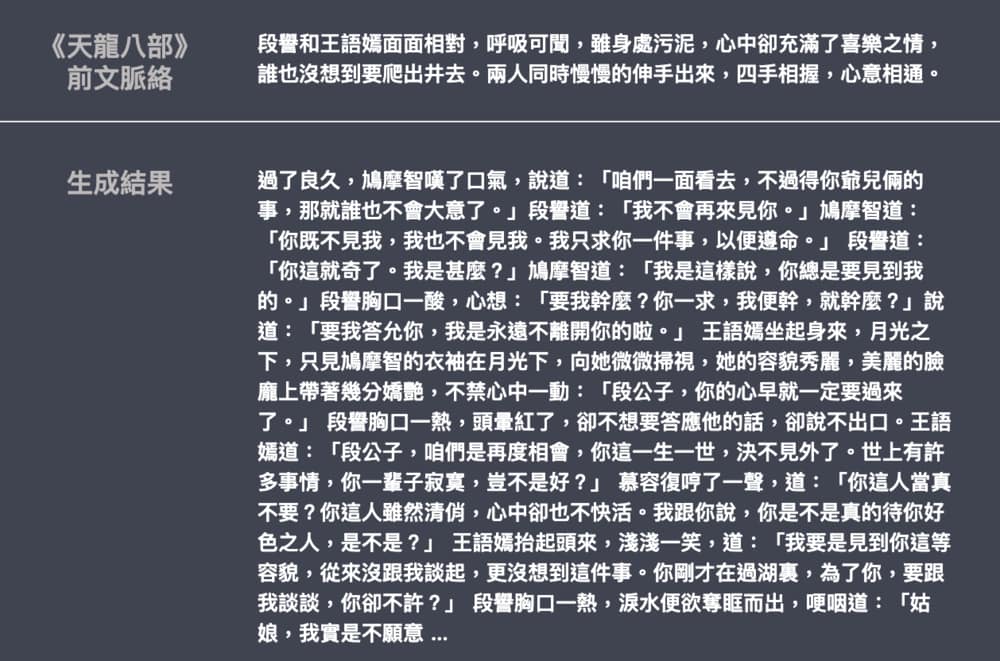

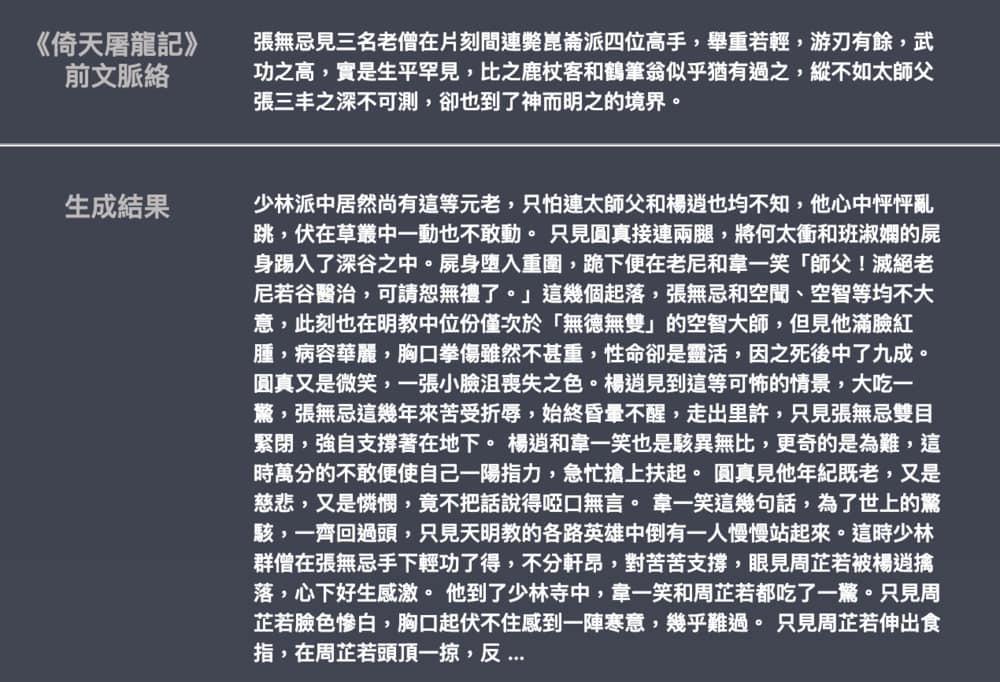

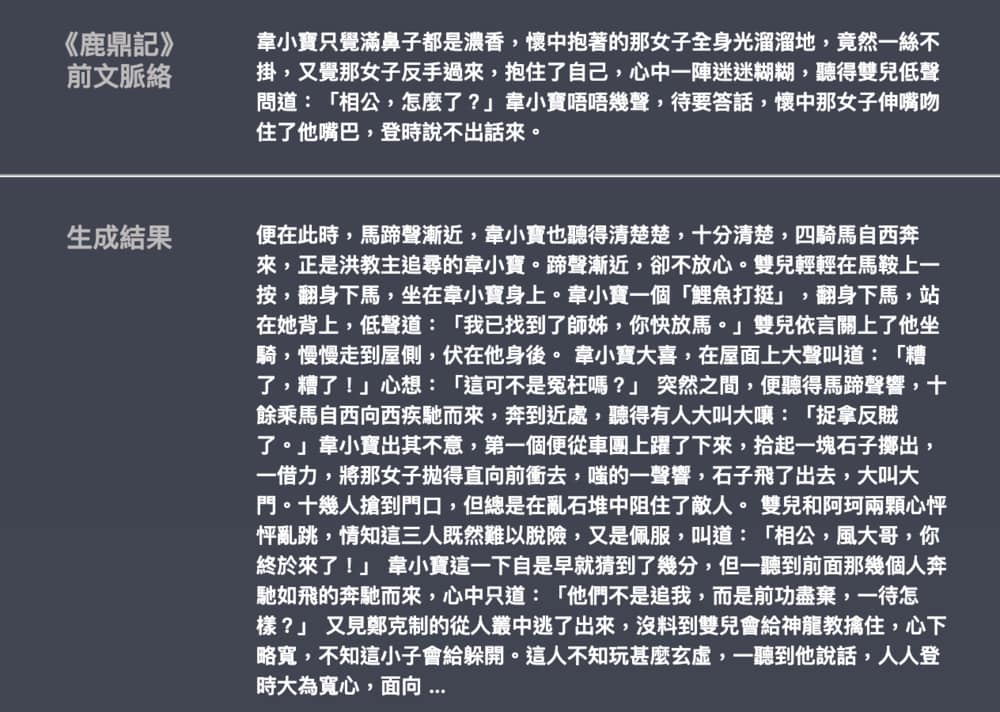

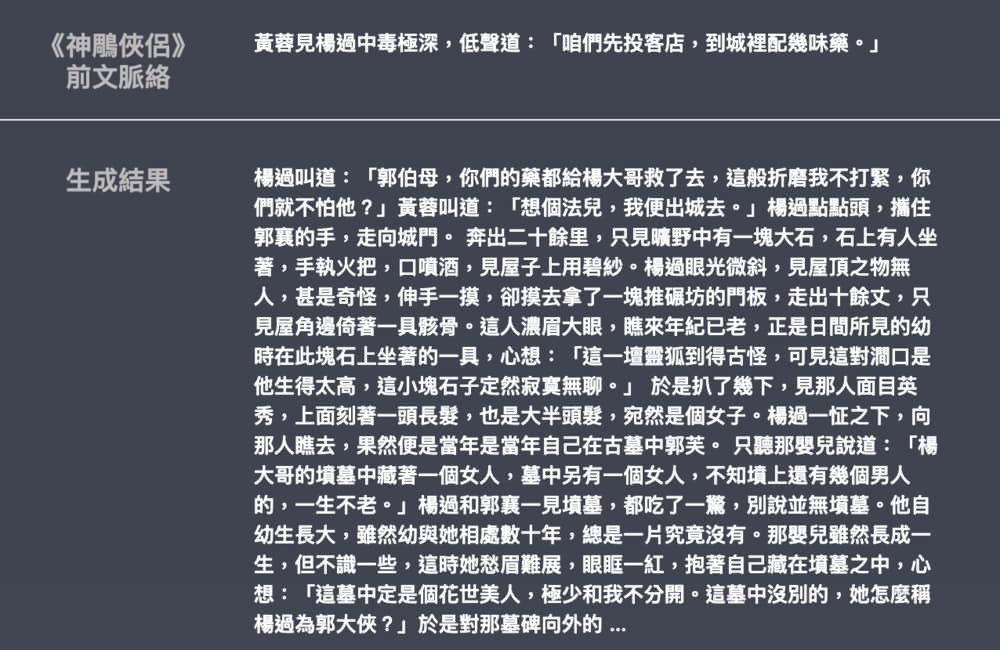

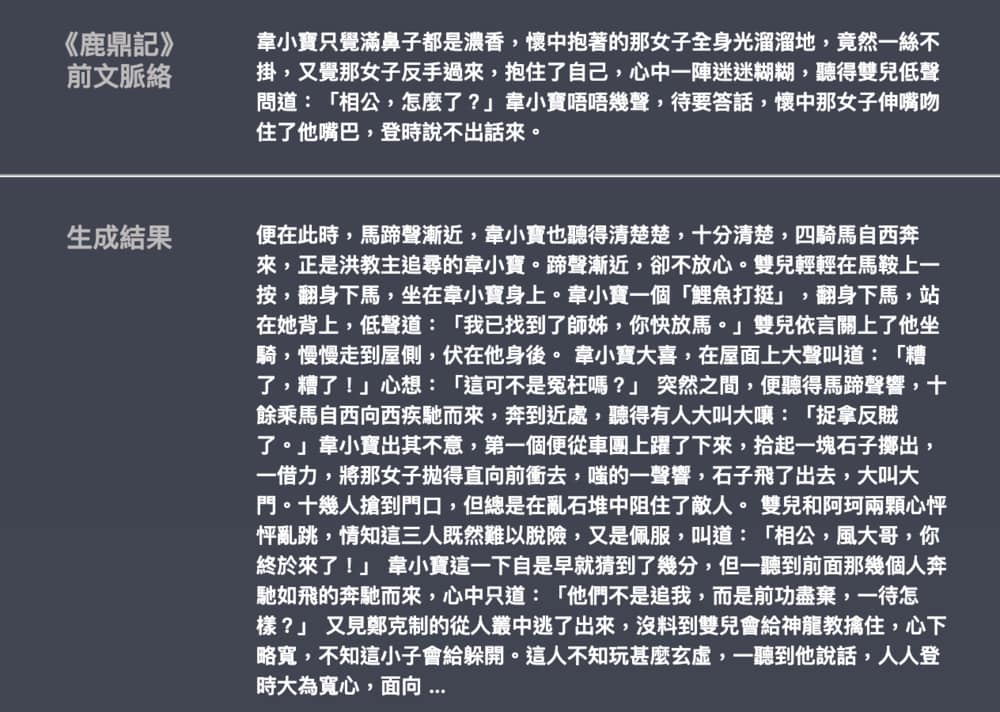

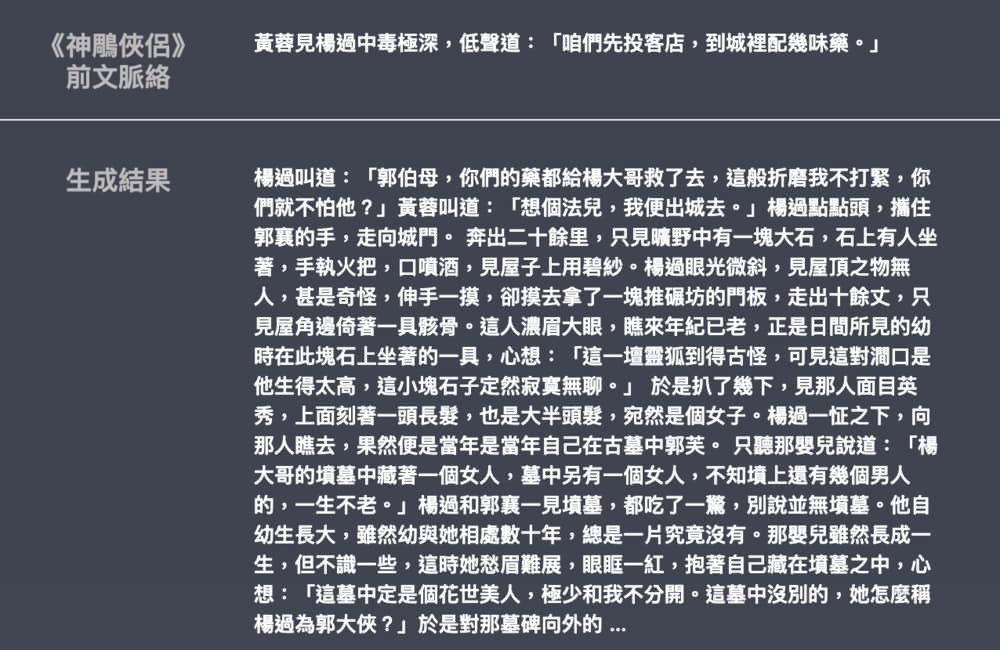

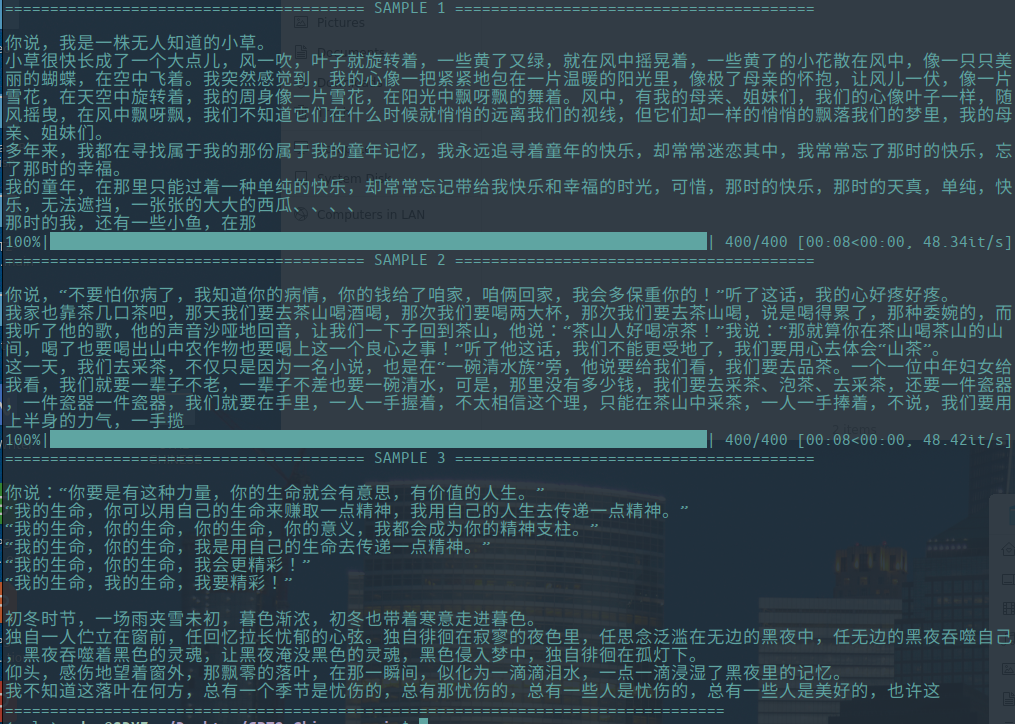

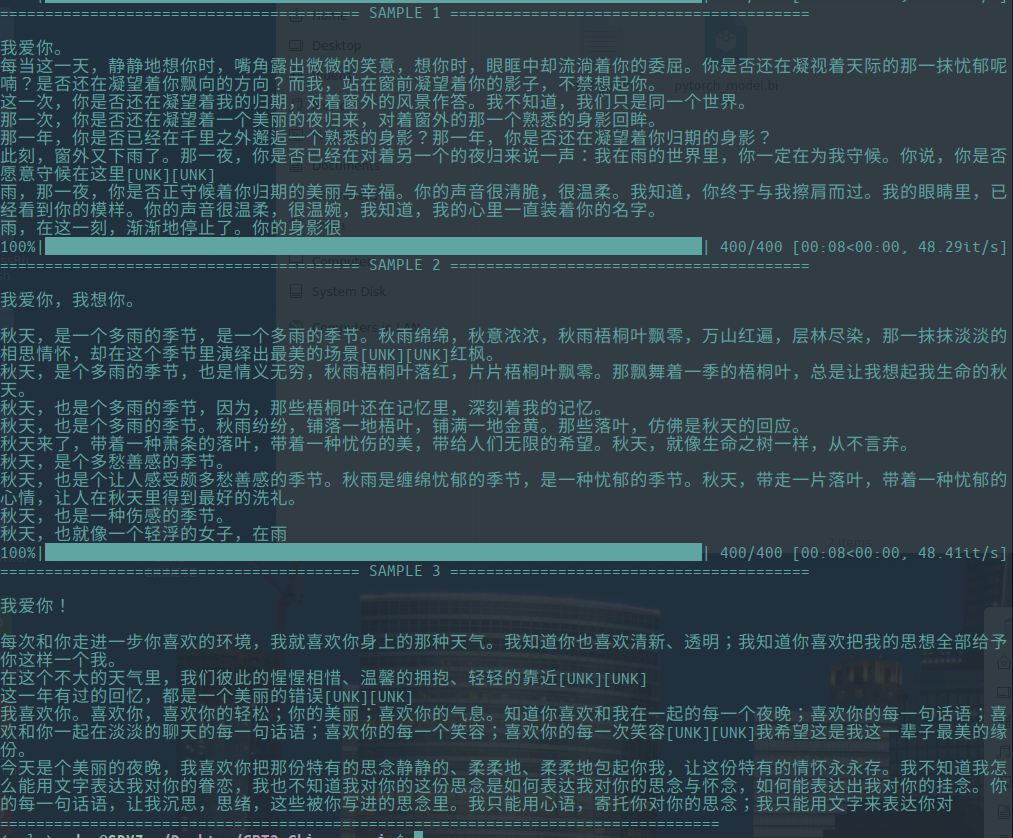

توليد عينة

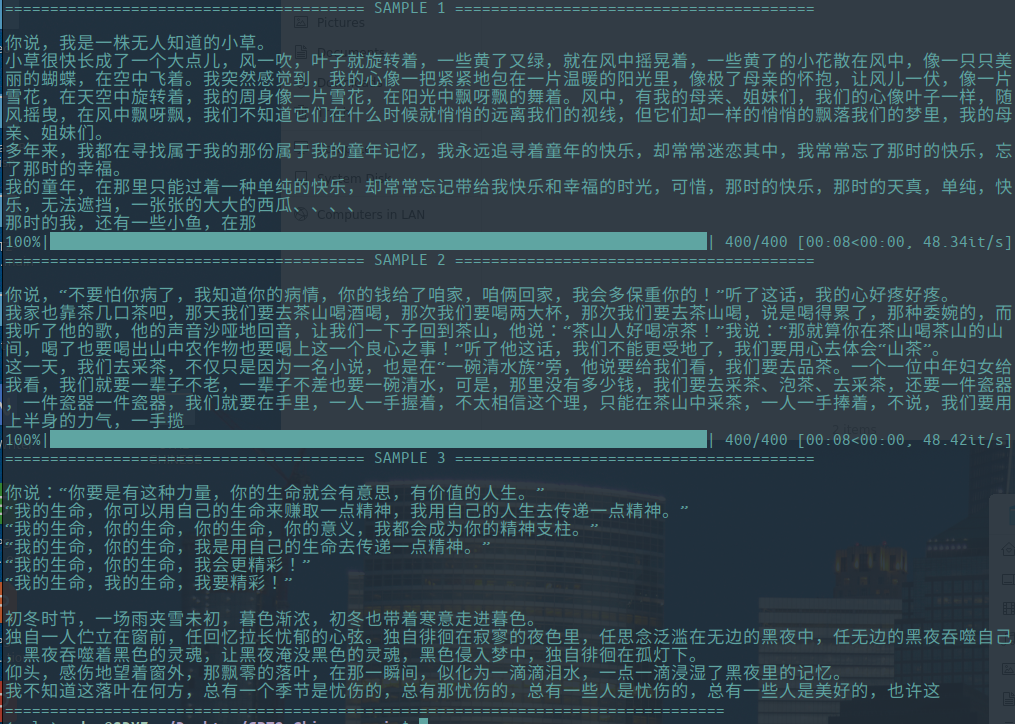

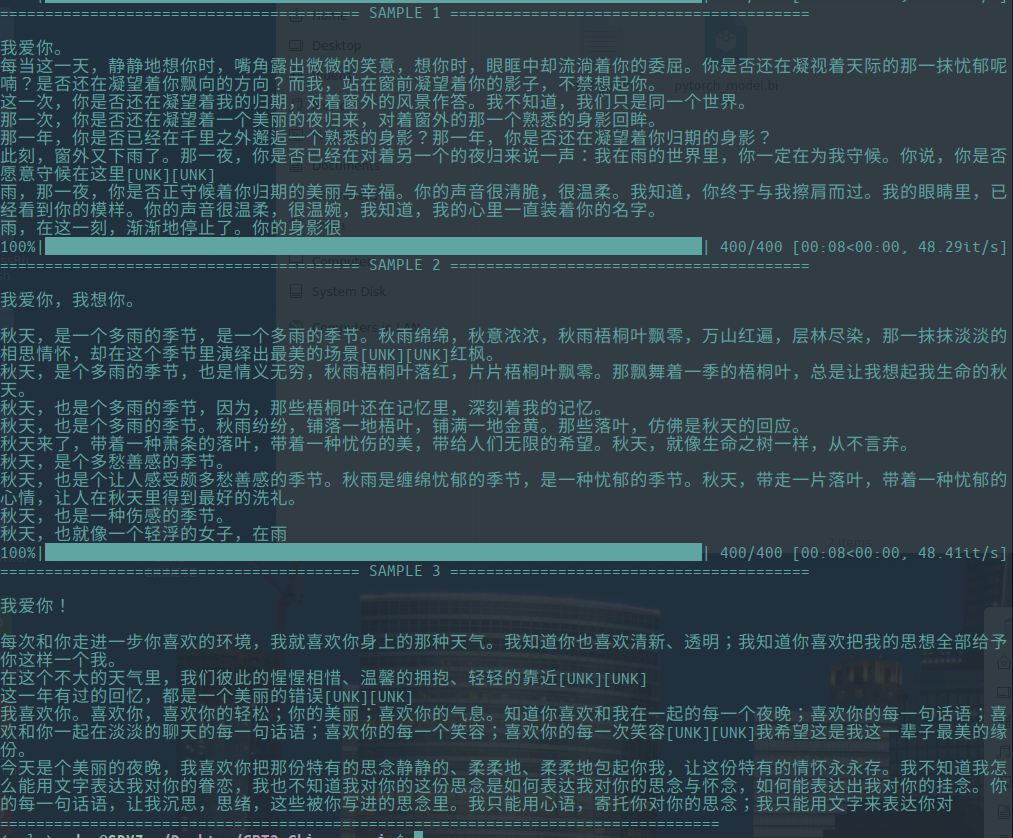

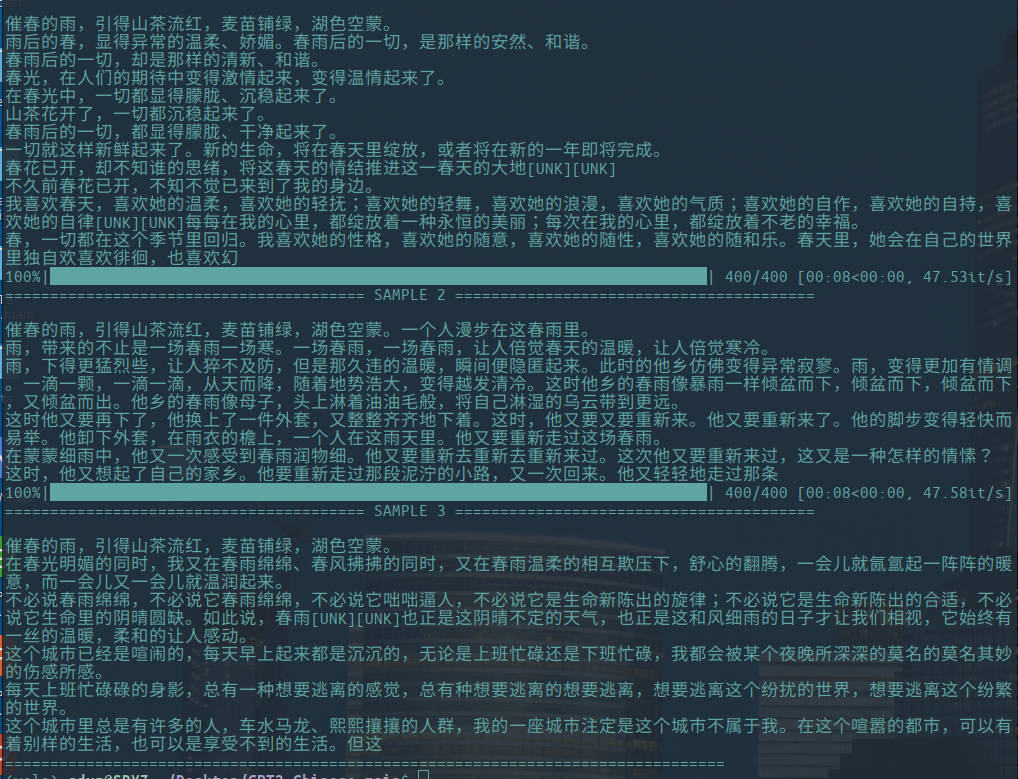

-فيما يلي أمثلة على توليد المقالات الأدبية ، التي ساهمت بها Hughqiu ، وتمت مشاركة النموذج في قائمة مشاركة النماذج. Corpus 130MB ، حجم الدفعة 16 ، 10 جولات من التدريب في 10 طبقات من العمق.

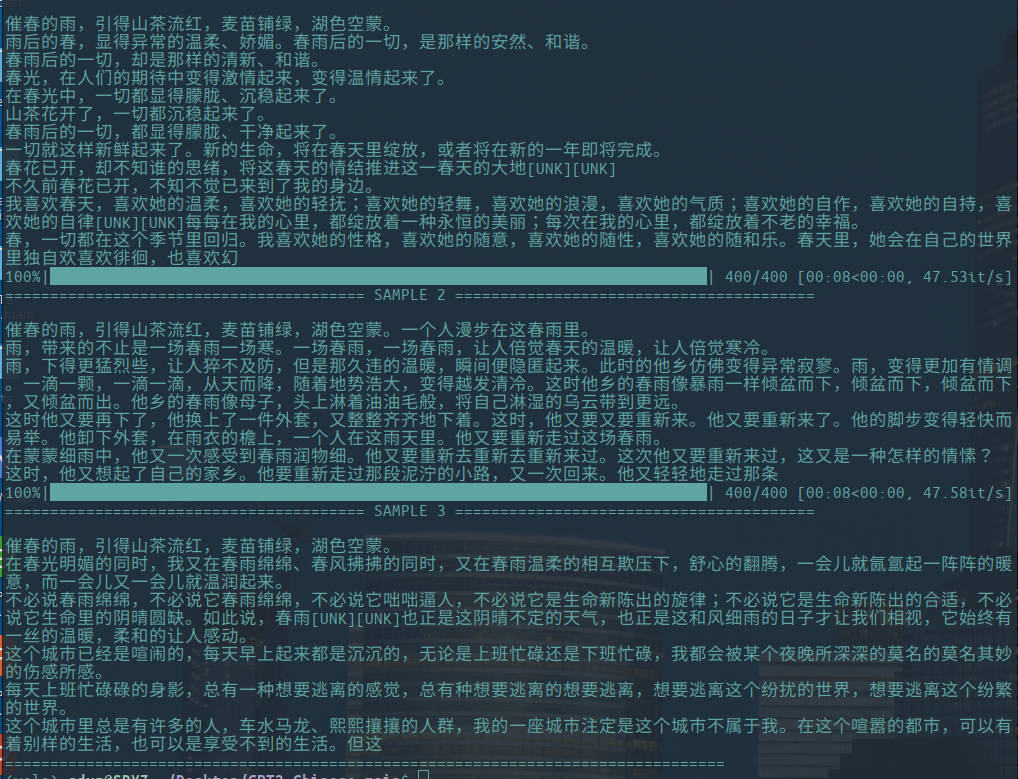

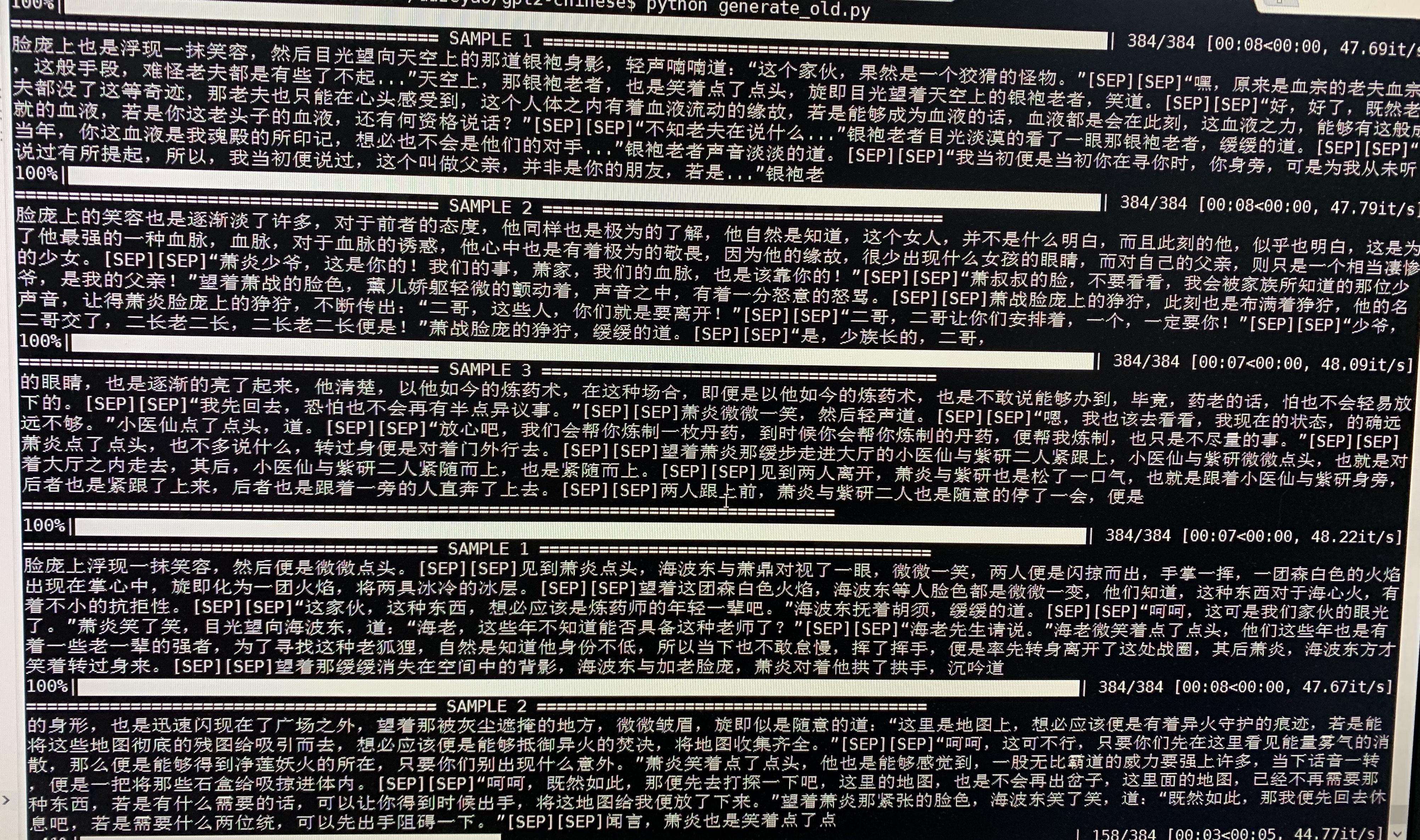

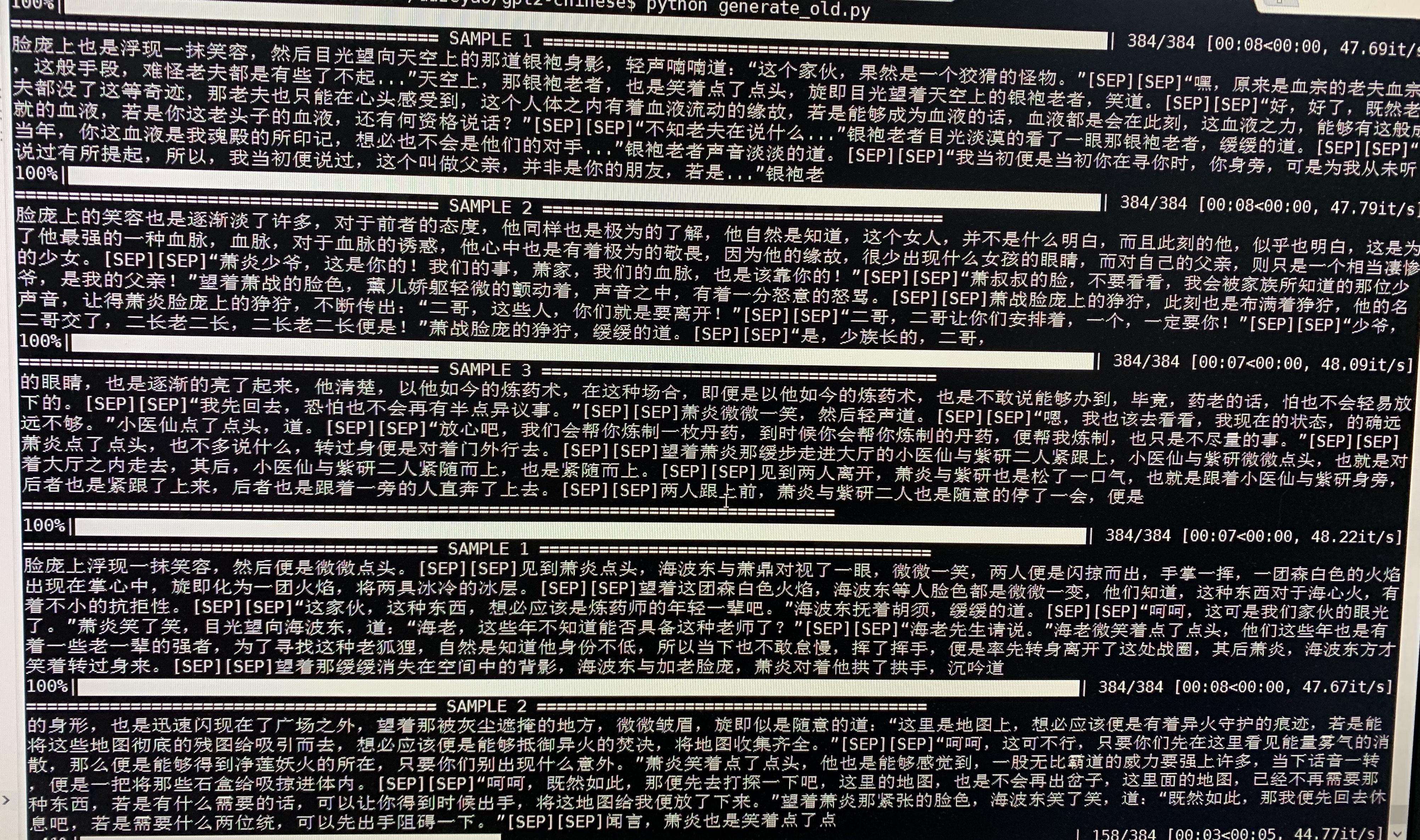

- فيما يلي جيل عينة من doupo cangqiong. تم تدريب GPT2 مع حوالي 50 متر معلمة على محتوى جديد Doupo cangqiong 16 ميجابايت مع حجم 32batch. هنا [SEP] يعني خط جديد.

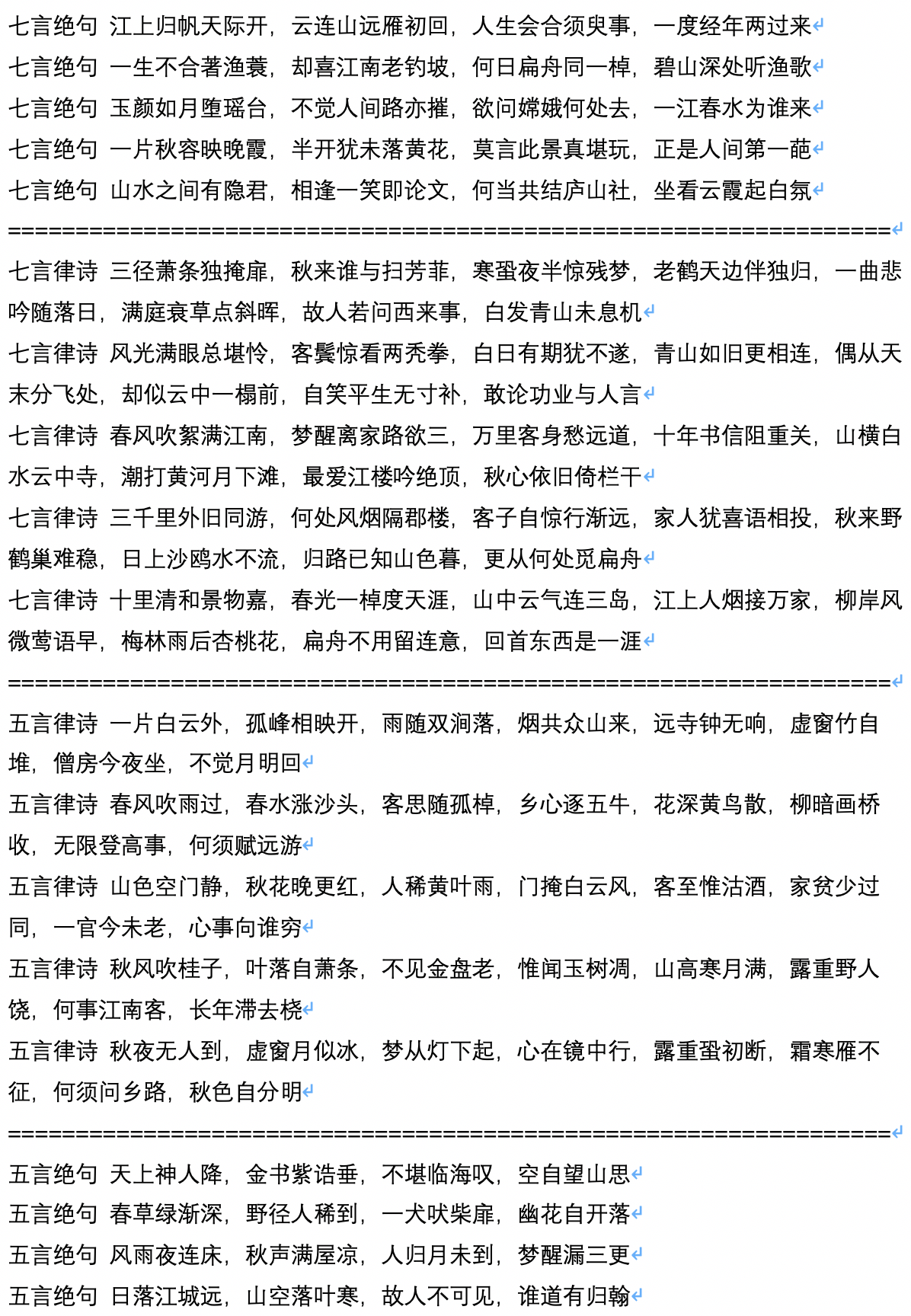

- فيما يلي عينة من توليد القصائد القديمة ، والتي يتم حسابها وتساهم بها المستخدم Jameshujy.

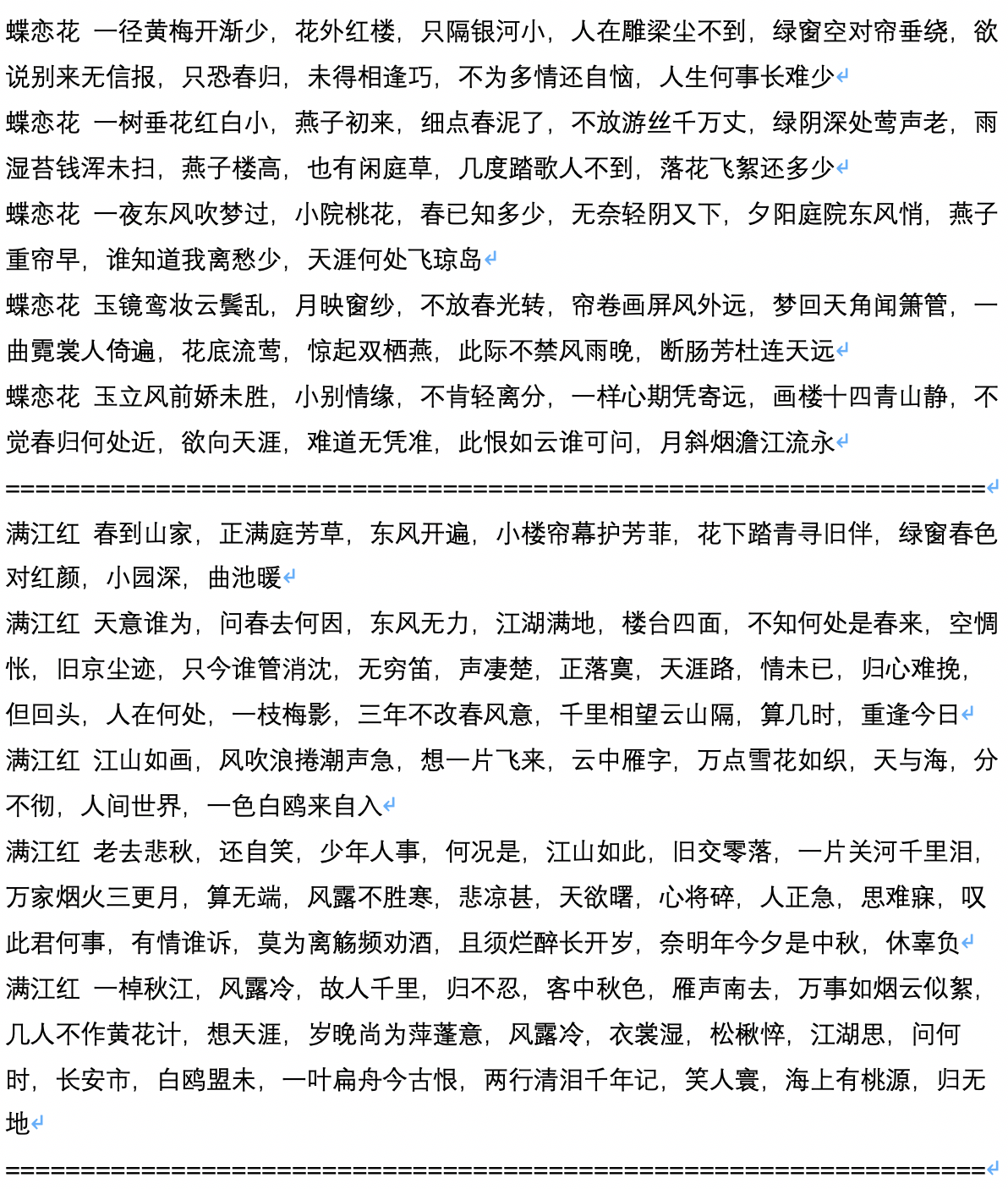

- فيما يلي جيل عينة بعد توليد القصيدة القديمة ، والتي يتم حسابها وساهم بها المستخدم Jameshujy.

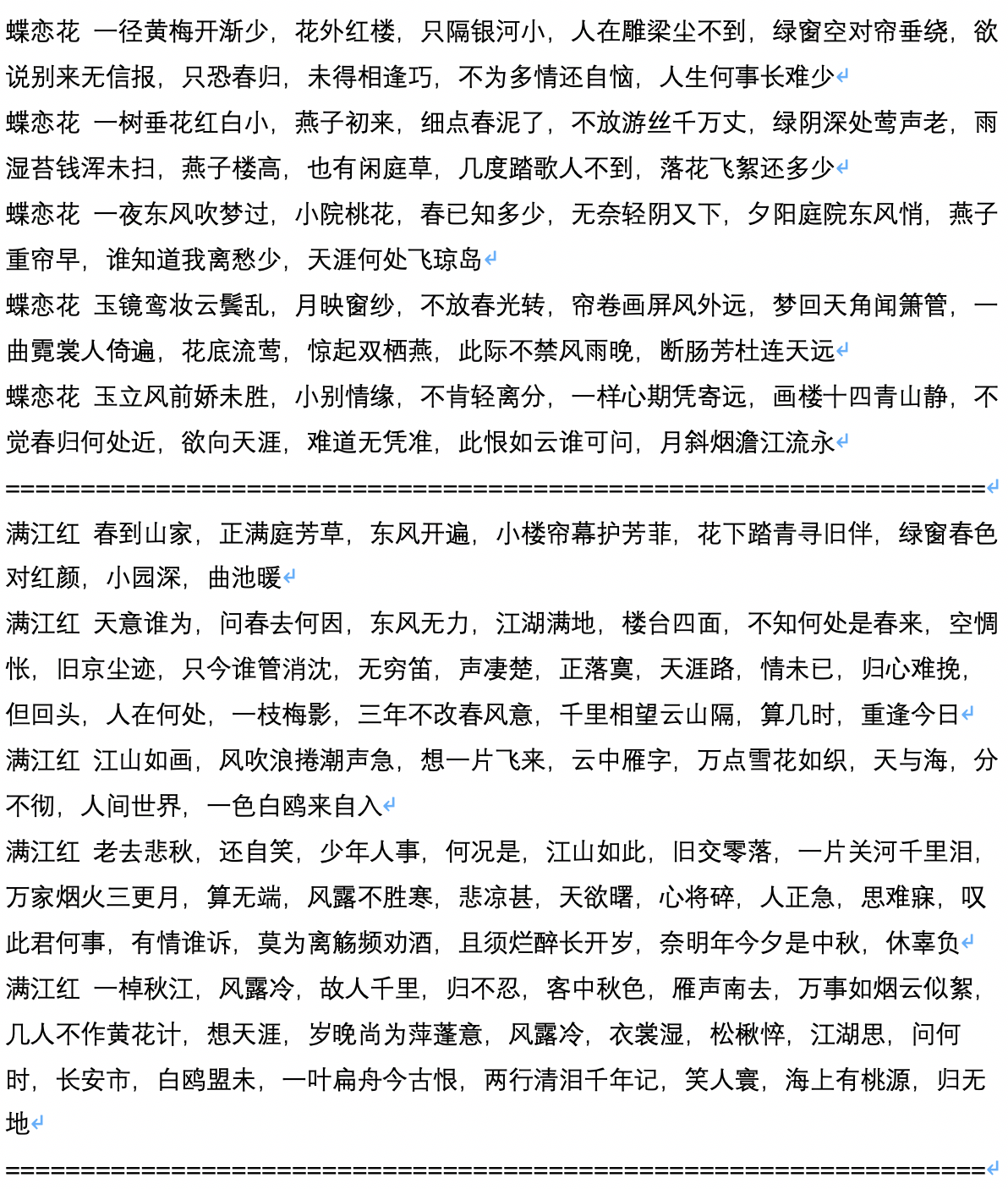

- ما يلي هو نص عينة البرنامج النصي الذي تم إنشاؤه ، والذي يتم حسابه ويساهم به من قبل المستخدم Chiangandy.

[startText] تحكي مؤامرة لعبة الحب قصة الحب اللطيف بين الأب وابنة البيانو ، جمهور يتمتع بالعمل الشاق والقيمة للواقع من أجل الحياة ، والحصول على سلسلة من الحب. تمت مشاركة وسائط تسجيل الأسهم في الثمانينات من قبل مستخدمي الإنترنت. كان شقيق مدير العلامة التجارية للمبدع الرئيسي تشن ليون في عام 2014 ، البلد الكبير لنهر شنغهاي هوايه. على الرغم من أن شباب شركة الخطوط الأمامية لم يكن لديهم مهنة ، إلا أن Lan Zhengshi رفضت فهمها. لقد فتح ظهور مفهوم مساعدة Lan Yue لسوء فهم واضح وأصبح العمل نهرًا الحب. في المسلسل التلفزيوني العرضي ، غيرت المسلسل التلفزيوني مصيرها. تم تعيين الثلاثة منهم لإبداعاتهم في حادث سيارة. سئلوا عن سوء الفهم والموهبة المنخفضة في هذه الصناعة. بدأ تشن تشاو وتانغ شيشيان "علاقة 2014" مختلفة تمامًا. كان لثلاني شخصية متبادلة وكانا علاجين متبادلين. على الرغم من أنها كانت رحلة صوتية صغيرة سجلتها جامعة بكين هواجيو ، وجيل ما بعد التسعينيات ، والشباب البارزين مثل تانغ رو وشنغ ، كيف سارت حياة الناس ضد رغباتهم وخلقوا معًا؟ ولماذا حققوا نجاحًا واهتمامًا ببعضهم البعض؟ [endtext]

[StartText] تعلم الحب يروي بشكل رئيسي قصة زوجين من Xiaoman. بعد اختبار مثير للسخرية ، اختاروا أخيرًا ثلاثة أطفال وبدأوا عملًا معًا لإنشاء أربعة أطفال ، وبدأوا عملًا ناجحًا في مدينة كبيرة. انضمت الشركان إلى بكين. بعد فترة من الزمن ، حصلوا على أشياء مختلفة بعد الفوضى والاختلافات ، وأخيراً اكتسبوا الحب الحقيقي لأحلامهم. أقيم حفل افتتاح الشخصيات الرئيسية في ريادة الأعمال مثل مُثُل الراعي ، والمسلسلات التلفزيونية ، والدراما ، وما إلى ذلك في بكين. تستند الدراما إلى منظور التلفزيون لثلاثة قادمين جدد في هاينان. إنه يروي قصة العديد من الشباب الذين عززوا غير الرومانسيين في أجيال بكين والكوميديا. مع الشباب الفريد من نوعه من بكين إلى بكين ، التوسع الحضري في الصين ، خرجت المدن الكبرى في الصين عن التطور. مع التغييرات في مدن اللغات ، في حين أن أنماط حياتهم التدريجية قد نظمت مثل هذه الابتذال البسيط لاتجاهها الخاص. تم تصويره في العصر المعاصر. كيف تكون في هذه المدينة؟ لذا فإن المدينة الهادئة هي أسلوب المدينة. يدعم Zhang Jiahe خلق العمل ، وهذه هي النقطة التي من الضروري إنشاء اجتماع طاقم دراما في المطار. الأشخاص الذين يتحولون إلى الشطرنج والثقافات فريدة من نوعها ومثيرة للغاية ، متشابكة ، ومضحكة ، ويأتون من الشمال الشرقي الجميل والبر الرئيسي ، والفتاتين تجرؤ على أن يطلق عليهم الفتيات كتم. قام الأشخاص في المتداخلة بمزاح ، وجعل المزاج المثير للإعجاب الناس يبدون كوميديا للغاية. ما عرفوه كان مؤيد الأسرة الأجنبي "الشمالي الشرقي" ، مما جعلها تبدو جيدة في قراءة الأعمال الدرامية. بعد ذلك ، Qi Fei و Qi Fei و Fan Er و Chu Yuezi و Bai Tianjie الذين عبروا عن حبه له. يبدو أن الصداقة بين الجيلين بدون مزيج من التعبيرات البهيجة والرائعة. [endtext]

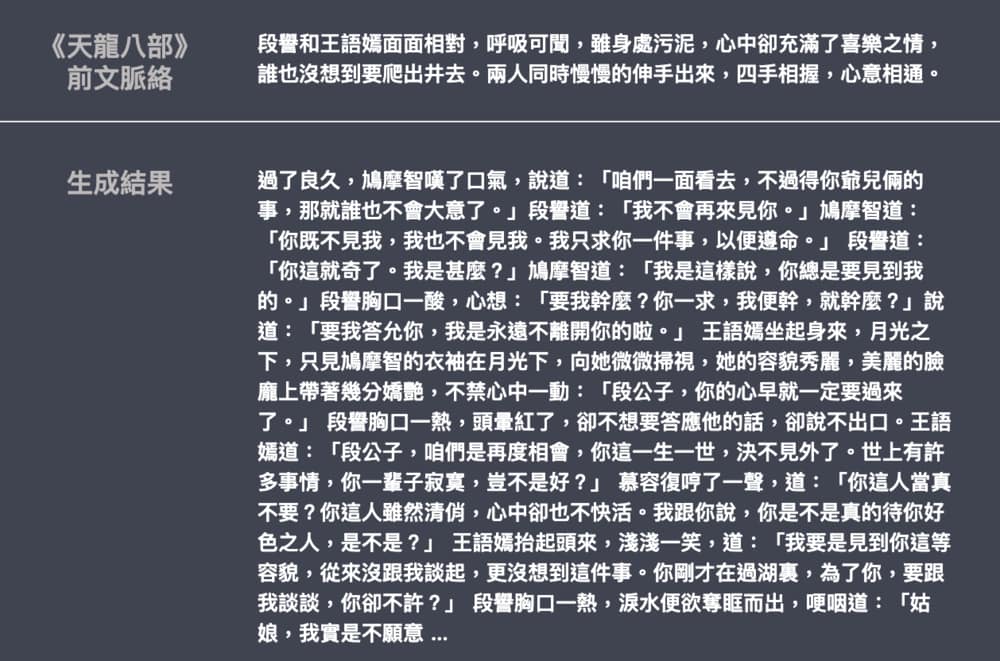

- فيما يلي مثال على توليد روايات Jin Yong و Wu Qi ، التي ساهم بها Leemengtaiwan. يبلغ حجم النموذج حوالي 82 مترًا ، والمواد اللغوية هي 50 ميجابايت ، وحجم الدُفعة هو 16. يوفر مقالة لتقديم GPT-2 وكيفية تصور آليات الاهتمام الذاتي. يتم توفير دفاتر ونماذج كولاب أيضًا لأي مستخدم لإنشاء أمثلة جديدة دفعة واحدة.