Arch - это интеллектуальный распределенный прокси, предназначенный для защиты, наблюдения и персонализации агентов искусственного интеллекта, предназначенного для защиты, наблюдения и персонализации ИИ.

Арх, спроектированный с специально построенным LLM, обрабатывает критические, но недифференцированные задачи, связанные с обработкой и обработкой подсказок, включая обнаружение и отклонение попыток джейлбрейка, разумно называя API «бэкэнд» для выполнения запроса пользователя, представленных в быстром направлении и выдвигая диск.

Арка построена на (и основными участниками) прокси послуца с верой в то, что:

Подсказки - это нюансы и непрозрачные запросы пользователей, которые требуют те же возможностей, что и традиционные HTTP -запросы, включая безопасную обработку, интеллектуальную маршрутизацию, надежную наблюдением и интеграцию с системами бэкэнд (API) для персонализации - вся внешняя бизнес -логика.****************

Основные функции :

Перейдите к нашим документам, чтобы узнать, как вы можете использовать Arch, чтобы улучшить скорость, безопасность и персонализацию ваших приложений Genai.

Важный

Сегодня функция, вызывающая LLM (Arch-Function), предназначенная для сценариев агента и RAG, размещается бесплатно в центре США. Чтобы предложить последовательные задержки и пропускную способность, а также для управления нашими расходами, мы скоро предоставим доступ к размещенной версии через ключи разработчиков и предоставим вам возможность запустить эту LLM на локальном уровне. Более подробную информацию см. В этом выпуске № 258

Чтобы связаться с нами, присоединяйтесь к нашему серверу Discord. Мы будем следить за этим активно и предлагаем там поддержку.

Следуйте этому руководству, чтобы узнать, как быстро настроить Arch и интегрировать ее в ваши генеративные приложения ИИ.

Прежде чем начать, убедитесь, что у вас есть следующее:

Docker & Python установлен в вашей системеAPI Keys для поставщиков LLM (при использовании внешних LLM)Arch's CLI позволяет эффективно управлять и взаимодействовать с Arch Gateway. Чтобы установить CLI, просто запустите следующую команду: Tip: Мы рекомендуем разработчикам создать новую виртуальную среду Python для выделения зависимостей перед установкой Arch. Это гарантирует, что ArchGW и его зависимости не мешают другим пакетам в вашей системе.

Убедитесь, что у вас установлены следующие утилиты, прежде чем продолжить дальше,

$ python -m venv venv

$ source venv/bin/activate # On Windows, use: venvScriptsactivate

$ pip install archgwARCH работает на основе файла конфигурации, где вы можете определить поставщиков LLM, предпринимательские цели, ограждения и т. Д. Ниже приведен пример конфигурации для начала:

version : v0.1

listener :

address : 127.0.0.1

port : 8080 # If you configure port 443, you'll need to update the listener with tls_certificates

message_format : huggingface

# Centralized way to manage LLMs, manage keys, retry logic, failover and limits in a central way

llm_providers :

- name : OpenAI

provider : openai

access_key : $OPENAI_API_KEY

model : gpt-3.5-turbo

default : true

# default system prompt used by all prompt targets

system_prompt : |

You are a network assistant that helps operators with a better understanding of network traffic flow and perform actions on networking operations. No advice on manufacturers or purchasing decisions.

prompt_targets :

- name : device_summary

description : Retrieve network statistics for specific devices within a time range

endpoint :

name : app_server

path : /agent/device_summary

parameters :

- name : device_ids

type : list

description : A list of device identifiers (IDs) to retrieve statistics for.

required : true # device_ids are required to get device statistics

- name : days

type : int

description : The number of days for which to gather device statistics.

default : " 7 "

- name : reboot_devices

description : Reboot a list of devices

endpoint :

name : app_server

path : /agent/device_reboot

parameters :

- name : device_ids

type : list

description : A list of device identifiers (IDs).

required : true

- name : days

type : int

description : A list of device identifiers (IDs)

default : " 7 "

# Arch creates a round-robin load balancing between different endpoints, managed via the cluster subsystem.

endpoints :

app_server :

# value could be ip address or a hostname with port

# this could also be a list of endpoints for load balancing

# for example endpoint: [ ip1:port, ip2:port ]

endpoint : host.docker.internal:18083

# max time to wait for a connection to be established

connect_timeout : 0.005sСделайте вызовы через Arch

from openai import OpenAI

# Use the OpenAI client as usual

client = OpenAI (

# No need to set a specific openai.api_key since it's configured in Arch's gateway

api_key = '--' ,

# Set the OpenAI API base URL to the Arch gateway endpoint

base_url = "http://127.0.0.1:12000/v1"

)

response = client . chat . completions . create (

# we select model from arch_config file

model = "--" ,

messages = [{ "role" : "user" , "content" : "What is the capital of France?" }],

)

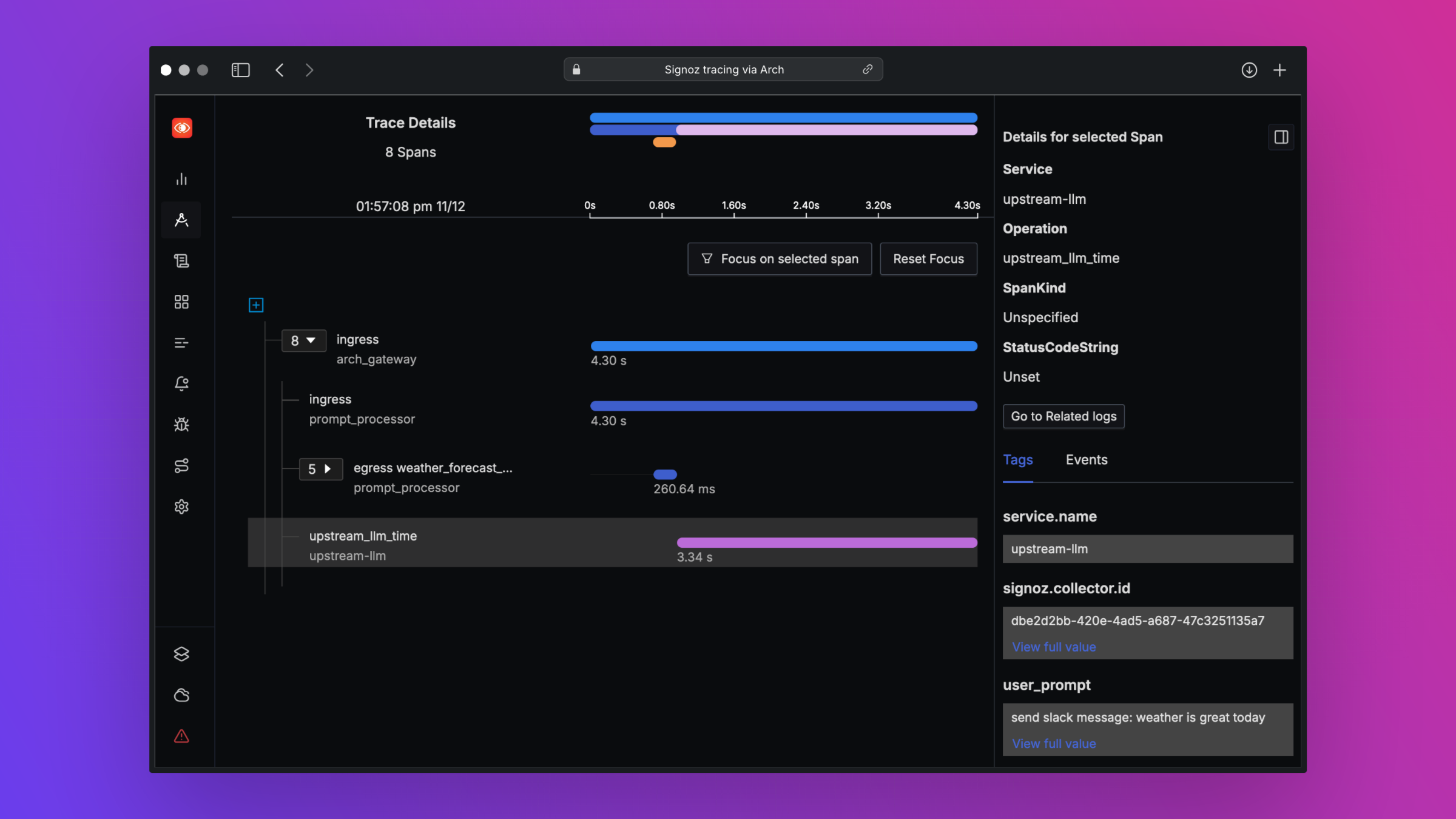

print ( "OpenAI Response:" , response . choices [ 0 ]. message . content )ARCH предназначена для поддержки Best-In Class Observication, поддерживая открытые стандарты. Пожалуйста, прочитайте наши документы о наблюдении, чтобы получить более подробную информацию о трассировке, метриках и журналах

Мы хотели бы отзыв о нашей дорожной карте, и мы приветствовали вклад в Arch ! Независимо от того, исправляете ли вы ошибки, добавляете новые функции, улучшаете документацию или создаете учебные пособия, ваша помощь очень ценится. Пожалуйста, посетите наше руководство по взносу для получения более подробной информации