O ARCH é um proxy distribuído da camada inteligente 7 projetado para proteger, observar e personalizar agentes de IA com suas APIs.

Projetado com LLMs criados para propósitos, lida com as tarefas críticas, mas indiferenciadas, relacionadas ao manuseio e processamento de instruções, incluindo a detecção e rejeição de tentativas de jailbreak, chamando de forma inteligente as APIs de "back-end" para atender à solicitação do usuário, de acordo com a solicitação de uma solicitação de lotes, a devolução de uma solicitação de llms.

Arch é construído sobre (e pelos principais colaboradores de) proxy do enviado com a crença de que:

Os avisos são solicitações de usuário diferenciadas e opacas, que exigem os mesmos recursos que as solicitações tradicionais de HTTP, incluindo manuseio seguro, roteamento inteligente, observabilidade robusta e integração com sistemas de back -end (API) para personalização - toda a lógica de negócios externa.*

Recursos principais :

Salte para nossos documentos para saber como você pode usar o Arch para melhorar a velocidade, a segurança e a personalização de seus aplicativos genai.

Importante

Hoje, a função Calling LLM (arqui-função) projetada para os cenários Agentic e Rag é hospedada gratuitamente na região central dos EUA. Para oferecer latências e taxa de transferência consistentes e gerenciar nossas despesas, permitiremos o acesso à versão hospedada por meio de teclas de desenvolvedores em breve e forneceremos a opção de executar esse LLM localmente. Para mais detalhes, consulte esta edição #258

Para entrar em contato conosco, junte -se ao nosso servidor Discord. Estaremos monitorando isso ativamente e oferecendo suporte lá.

Siga este guia para aprender a configurar rapidamente o Arch e integrá -lo aos seus aplicativos generativos de IA.

Antes de começar, verifique se você tem o seguinte:

Docker & Python instalado em seu sistemaAPI Keys para provedores de LLM (se estiver usando LLMs externos)A CLI de Arch permite que você gerencie e interaja com o Gateway do Arch com eficiência. Para instalar a CLI, basta executar o seguinte comando: Dica: Recomendamos que os desenvolvedores criem um novo ambiente virtual do Python para isolar dependências antes de instalar o Arch. Isso garante que o ARCHGW e suas dependências não interfiram em outros pacotes em seu sistema.

Certifique -se de ter os seguintes utilitários instalados antes de prosseguir,

$ python -m venv venv

$ source venv/bin/activate # On Windows, use: venvScriptsactivate

$ pip install archgwO ARCH opera com base em um arquivo de configuração, onde você pode definir provedores de LLM, metas solicitadas, corrimão, etc. Abaixo está um exemplo de configuração para você começar:

version : v0.1

listener :

address : 127.0.0.1

port : 8080 # If you configure port 443, you'll need to update the listener with tls_certificates

message_format : huggingface

# Centralized way to manage LLMs, manage keys, retry logic, failover and limits in a central way

llm_providers :

- name : OpenAI

provider : openai

access_key : $OPENAI_API_KEY

model : gpt-3.5-turbo

default : true

# default system prompt used by all prompt targets

system_prompt : |

You are a network assistant that helps operators with a better understanding of network traffic flow and perform actions on networking operations. No advice on manufacturers or purchasing decisions.

prompt_targets :

- name : device_summary

description : Retrieve network statistics for specific devices within a time range

endpoint :

name : app_server

path : /agent/device_summary

parameters :

- name : device_ids

type : list

description : A list of device identifiers (IDs) to retrieve statistics for.

required : true # device_ids are required to get device statistics

- name : days

type : int

description : The number of days for which to gather device statistics.

default : " 7 "

- name : reboot_devices

description : Reboot a list of devices

endpoint :

name : app_server

path : /agent/device_reboot

parameters :

- name : device_ids

type : list

description : A list of device identifiers (IDs).

required : true

- name : days

type : int

description : A list of device identifiers (IDs)

default : " 7 "

# Arch creates a round-robin load balancing between different endpoints, managed via the cluster subsystem.

endpoints :

app_server :

# value could be ip address or a hostname with port

# this could also be a list of endpoints for load balancing

# for example endpoint: [ ip1:port, ip2:port ]

endpoint : host.docker.internal:18083

# max time to wait for a connection to be established

connect_timeout : 0.005sFaça chamadas de saída via Arch

from openai import OpenAI

# Use the OpenAI client as usual

client = OpenAI (

# No need to set a specific openai.api_key since it's configured in Arch's gateway

api_key = '--' ,

# Set the OpenAI API base URL to the Arch gateway endpoint

base_url = "http://127.0.0.1:12000/v1"

)

response = client . chat . completions . create (

# we select model from arch_config file

model = "--" ,

messages = [{ "role" : "user" , "content" : "What is the capital of France?" }],

)

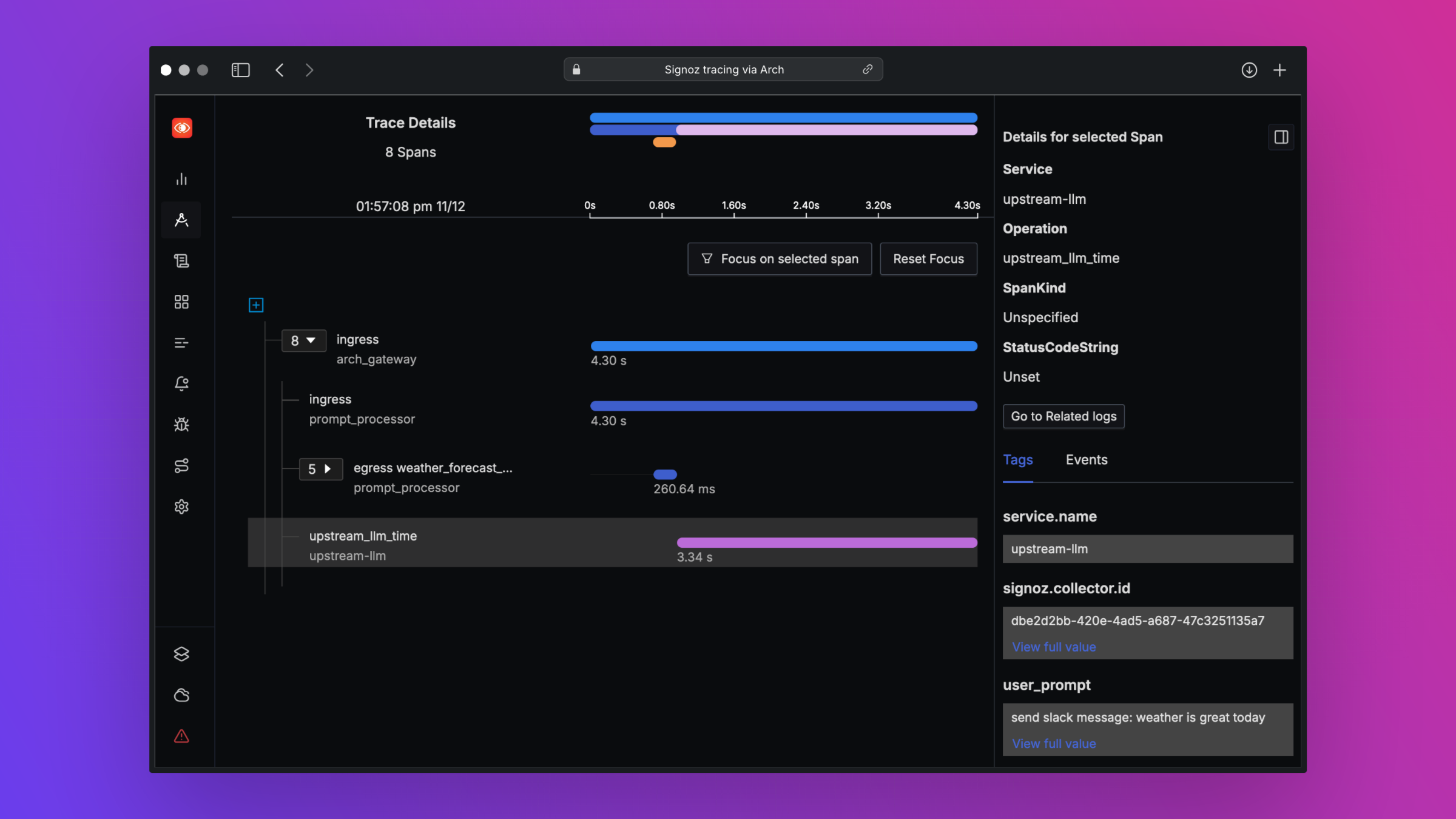

print ( "OpenAI Response:" , response . choices [ 0 ]. message . content )O Arch foi projetado para apoiar a melhor observabilidade da classe, apoiando padrões abertos. Leia nossos documentos sobre observabilidade para obter mais detalhes sobre rastreamento, métricas e logs

Adoraríamos feedback sobre o nosso roteiro e recebemos contribuições para Arch ! Esteja você corrigindo bugs, adicionando novos recursos, melhorando a documentação ou criando tutoriais, sua ajuda é muito apreciada. Visite nosso guia de contribuição para mais detalhes