| Динамический график | TGN |

|---|---|

|  |

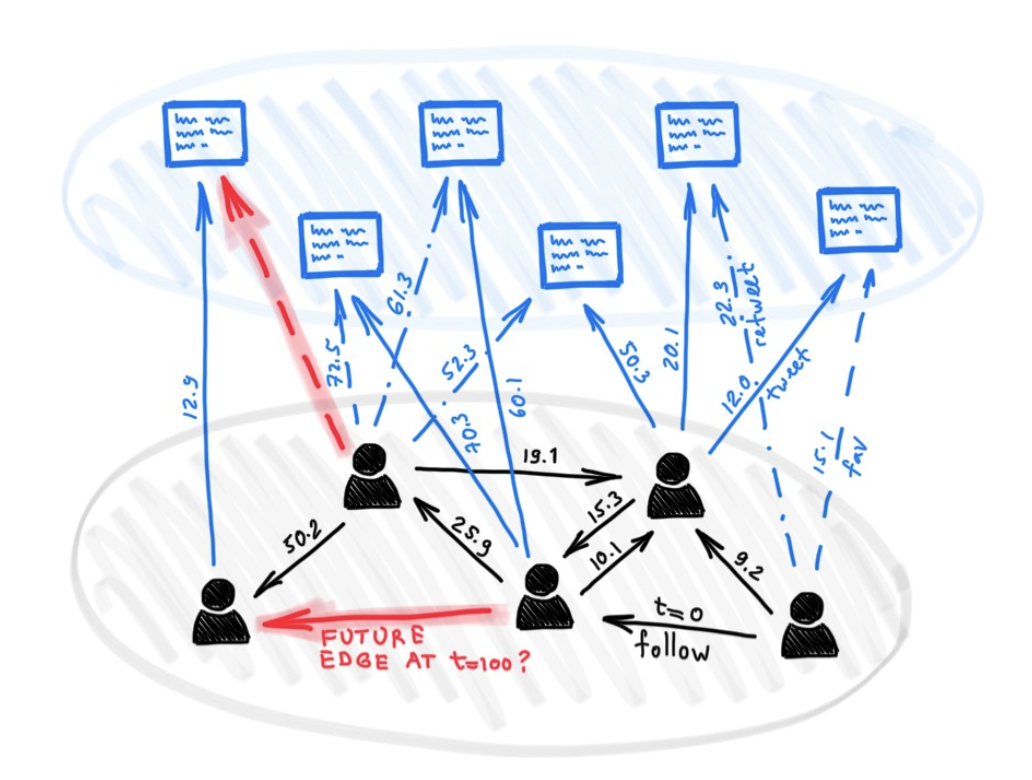

Несмотря на множество различных моделей для глубокого обучения на графиках, до сих пор было предложено несколько подходов для работы с графиками, которые представляют какую -то динамическую природу (например, развивающиеся функции или связь с течением времени).

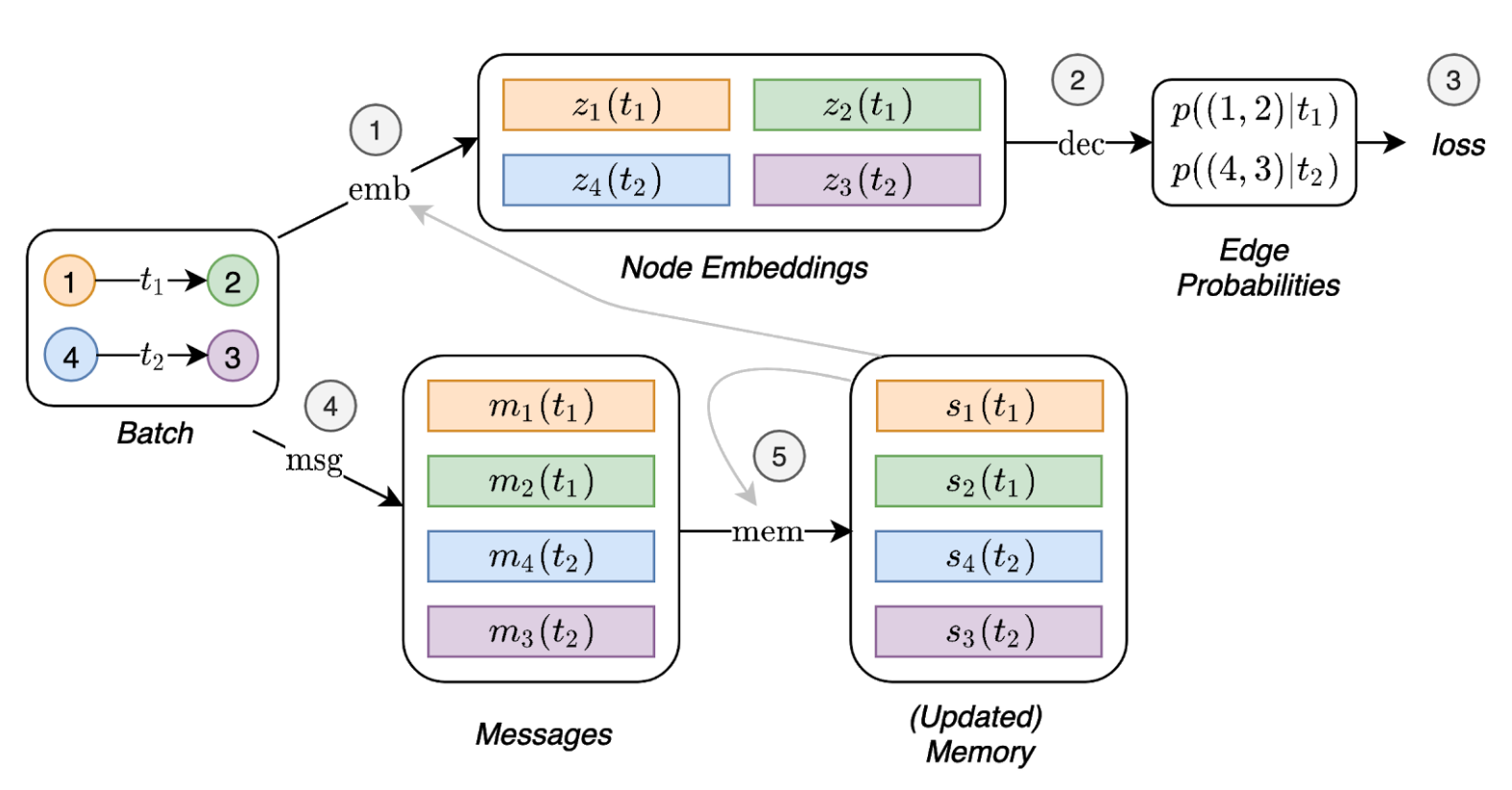

В этой статье мы представляем временные графические сети (TGNS), общую, эффективную структуру для глубокого обучения на динамических графиках, представленных как последовательности временных событий. Благодаря новой комбинации модулей памяти и операторов на основе графиков, TGN могут значительно превосходить предыдущие подходы, которые одновременно более эффективны в вычислителе.

Кроме того, мы показываем, что несколько предыдущих моделей обучения на динамических графиках могут быть отменены в качестве конкретных случаев нашей структуры. Мы проводим подробное исследование абляции различных компонентов нашей структуры и разработаем лучшую конфигурацию, которая достигает современной производительности в нескольких задачах трансдуктивного и индуктивного прогнозирования для динамических графиков.

Зависимости (с Python> = 3,7):

pandas==1.1.0

torch==1.6.0

scikit_learn==0.23.1

Загрузите образцы наборов данных (например, Wikipedia и Reddit) отсюда и храните их файлы CSV в папке с именем data/ .

Мы используем плотный формат npy , чтобы сохранить функции в бинарном формате. Если функции края или узлы отсутствуют, они будут заменены вектором нулей.

python utils/preprocess_data.py --data wikipedia --bipartite

python utils/preprocess_data.py --data reddit --bipartite

Самоотверженное обучение с использованием задачи прогнозирования ссылки:

# TGN-attn: Supervised learning on the wikipedia dataset

python train_self_supervised.py --use_memory --prefix tgn-attn --n_runs 10

# TGN-attn-reddit: Supervised learning on the reddit dataset

python train_self_supervised.py -d reddit --use_memory --prefix tgn-attn-reddit --n_runs 10

Наблюдение за обучением по классификации динамической узлов (для этого требуется обученная модель из самоотверженной задачи, например, запустив команды выше):

# TGN-attn: self-supervised learning on the wikipedia dataset

python train_supervised.py --use_memory --prefix tgn-attn --n_runs 10

# TGN-attn-reddit: self-supervised learning on the reddit dataset

python train_supervised.py -d reddit --use_memory --prefix tgn-attn-reddit --n_runs 10

### Wikipedia Self-supervised

# Jodie

python train_self_supervised.py --use_memory --memory_updater rnn --embedding_module time --prefix jodie_rnn --n_runs 10

# DyRep

python train_self_supervised.py --use_memory --memory_updater rnn --dyrep --use_destination_embedding_in_message --prefix dyrep_rnn --n_runs 10

### Reddit Self-supervised

# Jodie

python train_self_supervised.py -d reddit --use_memory --memory_updater rnn --embedding_module time --prefix jodie_rnn_reddit --n_runs 10

# DyRep

python train_self_supervised.py -d reddit --use_memory --memory_updater rnn --dyrep --use_destination_embedding_in_message --prefix dyrep_rnn_reddit --n_runs 10

### Wikipedia Supervised

# Jodie

python train_supervised.py --use_memory --memory_updater rnn --embedding_module time --prefix jodie_rnn --n_runs 10

# DyRep

python train_supervised.py --use_memory --memory_updater rnn --dyrep --use_destination_embedding_in_message --prefix dyrep_rnn --n_runs 10

### Reddit Supervised

# Jodie

python train_supervised.py -d reddit --use_memory --memory_updater rnn --embedding_module time --prefix jodie_rnn_reddit --n_runs 10

# DyRep

python train_supervised.py -d reddit --use_memory --memory_updater rnn --dyrep --use_destination_embedding_in_message --prefix dyrep_rnn_reddit --n_runs 10

Команды для воспроизведения всех результатов в исследовании абляции по сравнению с различными модулями:

# TGN-2l

python train_self_supervised.py --use_memory --n_layer 2 --prefix tgn-2l --n_runs 10

# TGN-no-mem

python train_self_supervised.py --prefix tgn-no-mem --n_runs 10

# TGN-time

python train_self_supervised.py --use_memory --embedding_module time --prefix tgn-time --n_runs 10

# TGN-id

python train_self_supervised.py --use_memory --embedding_module identity --prefix tgn-id --n_runs 10

# TGN-sum

python train_self_supervised.py --use_memory --embedding_module graph_sum --prefix tgn-sum --n_runs 10

# TGN-mean

python train_self_supervised.py --use_memory --aggregator mean --prefix tgn-mean --n_runs 10

optional arguments:

-d DATA, --data DATA Data sources to use (wikipedia or reddit)

--bs BS Batch size

--prefix PREFIX Prefix to name checkpoints and results

--n_degree N_DEGREE Number of neighbors to sample at each layer

--n_head N_HEAD Number of heads used in the attention layer

--n_epoch N_EPOCH Number of epochs

--n_layer N_LAYER Number of graph attention layers

--lr LR Learning rate

--patience Patience of the early stopping strategy

--n_runs Number of runs (compute mean and std of results)

--drop_out DROP_OUT Dropout probability

--gpu GPU Idx for the gpu to use

--node_dim NODE_DIM Dimensions of the node embedding

--time_dim TIME_DIM Dimensions of the time embedding

--use_memory Whether to use a memory for the nodes

--embedding_module Type of the embedding module

--message_function Type of the message function

--memory_updater Type of the memory updater

--aggregator Type of the message aggregator

--memory_update_at_the_end Whether to update the memory at the end or at the start of the batch

--message_dim Dimension of the messages

--memory_dim Dimension of the memory

--backprop_every Number of batches to process before performing backpropagation

--different_new_nodes Whether to use different unseen nodes for validation and testing

--uniform Whether to sample the temporal neighbors uniformly (or instead take the most recent ones)

--randomize_features Whether to randomize node features

--dyrep Whether to run the model as DyRep

@inproceedings { tgn_icml_grl2020 ,

title = { Temporal Graph Networks for Deep Learning on Dynamic Graphs } ,

author = { Emanuele Rossi and Ben Chamberlain and Fabrizio Frasca and Davide Eynard and Federico

Monti and Michael Bronstein } ,

booktitle = { ICML 2020 Workshop on Graph Representation Learning } ,

year = { 2020 }

}