No campo de geração de vídeo, o OpenAi Sora foi considerado uma referência da indústria por seus altos custos de treinamento e excelente desempenho. No entanto, a Luchen Technology anunciou recentemente o código aberto de seu modelo de geração de vídeo Open-SORA2.0, que sem dúvida causou uma enorme sensação no setor. O Open-SORA2.0 rapidamente se tornou o novo foco da tecnologia de geração de vídeo, com seu custo e desempenho de treinamento extremamente baixos próximos aos modelos principais.

O custo de treinamento da SARA2.0 é de apenas US $ 200.000, o que equivale ao investimento de 224 GPUs, mas treinou com sucesso um modelo de geração de vídeo em nível comercial com 11 bilhões de parâmetros. Essa conquista não apenas demonstra os avanços tecnológicos da Luchen Technology, mas também traz novas possibilidades ao campo da geração de vídeo.

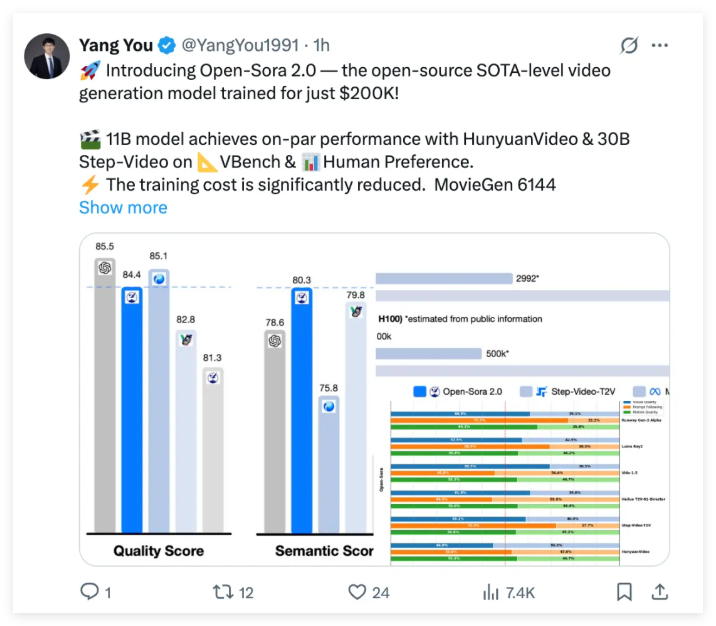

Embora o SARA2.0 aberto custe muito mais baixo que o OpenAI Sora, seu desempenho não é inferior a isso. O Open-SORA2.0 teve um desempenho impressionante em análises autorizadas em testes de preferência do VBEnch e do usuário, e pode até competir com modelos de código fechado que custam milhões de dólares para treinar em várias métricas importantes. Especialmente na avaliação do VBEnch, a diferença de desempenho entre SARA2.0 e OpenAI Sora diminuiu significativamente entre os 4,52% anteriores para apenas 0,69%, quase alcançando um desempenho abrangente.

O que é ainda mais emocionante é que as pontuações abertas-sora2.0 até superam a HunyuanVideo de Tencent em Vbench, demonstrando sua forte força na tecnologia de geração de vídeos. Essa conquista não apenas prova as vantagens tecnológicas do SORA2.0, mas também define uma nova referência para a tecnologia de geração de vídeo de código aberto.

Na revisão de preferências do usuário, o Open-SORA2.0 possui pelo menos dois indicadores que superam o modelo SOTA de código aberto HunyuanVideo e o modelo de negócios Gen-3alpha nas três dimensões principais do desempenho visual, consistência do texto e desempenho da ação. Essa conquista consolida ainda mais a posição de liderança do SABO2.0 no campo de geração de vídeo.

A razão pela qual a SARA2.0 aberta pode atingir um desempenho tão alto a um custo tão baixo é devido a uma série de inovações tecnológicas e estratégias de otimização. Primeiro de tudo, o Open-SORA2.0 continua a idéia de design de SORA1.2, adota a estrutura de treinamento de autoencoder e combinação de fluxo 3D e apresenta um mecanismo de atenção total em 3D para melhorar ainda mais a qualidade da geração de vídeo.

In order to pursue the ultimate cost optimization, Open-Sora2.0 starts from multiple aspects: strict data screening ensures high-quality training data input, priority is given to low-resolution training to efficiently learn motion information, priority is given to training graph video tasks to accelerate model convergence, and adopts an efficient parallel training scheme, combining ColossalAI and system-level optimization, greatly improving the utilization of computing resources.

Estima-se que o custo de um único treinamento de mais de 10B modelos de vídeo de código aberto no mercado seja frequentemente milhões de dólares, enquanto a SARA2.0 reduz esse custo em 5 a 10 vezes. Esse avanço não apenas reduz o limiar para a geração de vídeos de alta qualidade, mas também oferece a mais desenvolvedores a oportunidade de participar da pesquisa e desenvolvimento da tecnologia de geração de vídeo.

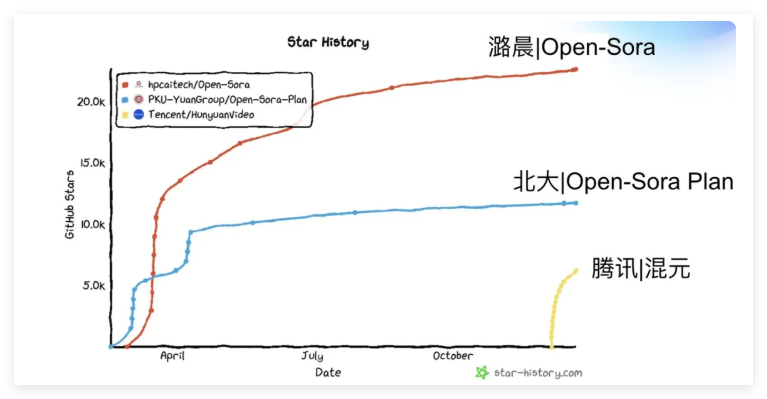

O que é ainda mais louvável é que o código de modelo e os pesos do modelo de código aberto não apenas, mas também o código de treinamento de processo aberto, que sem dúvida promoverá bastante o desenvolvimento de todo o ecossistema de código aberto. O número de citações acadêmicas em papel da SABE2.0 recebeu quase 100 citações dentro de meio ano, classificando-se primeiro no ranking global de influência de código aberto, tornando-se um dos projetos de geração de vídeo de código aberto mais influentes do mundo.

A equipe Open-SORA2.0 também está explorando ativamente a aplicação do autoencoder de vídeo de alta taxa de compressão para reduzir significativamente os custos de inferência. Eles treinaram um autoencoder de vídeo com alta taxa de compressão (4 × 32 × 32) para reduzir o tempo de inferência para gerar vídeos de 768px e 5 segundos em um único cartão de quase 30 minutos para 3 minutos e a velocidade aumentou 10 vezes. Essa inovação significa que podemos gerar conteúdo de vídeo de alta qualidade mais rápido no futuro.

O modelo de geração de vídeo de código aberto Open-SORA2.0 lançado pela Luchen Technology, com suas características abrangentes de código aberto de baixo custo, alto desempenho e abrangentes, sem dúvida traz uma forte tendência de "paridade" para o campo de geração de vídeo. Seu emergência não apenas reduziu a lacuna com os modelos de código fechado superior, mas também reduziu o limite para a geração de vídeos de alta qualidade, permitindo que mais desenvolvedores participem e promovam em conjunto o desenvolvimento da tecnologia de geração de vídeo.

Repositório de código aberto do Github: https://github.com/hpcaitech/open-sora

Relatório Técnico: https://github.com/hpcaitech/open-sora-demo/blob/main/paper/open_sora_2_tech_report.pdf