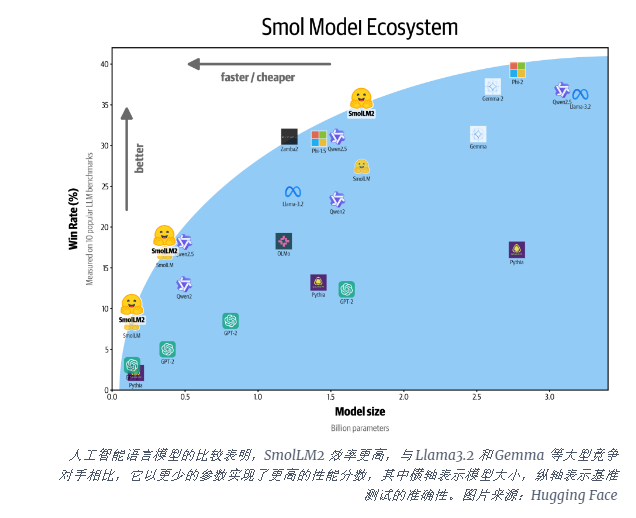

O Hugging Face lançou um novo modelo de linguagem compacta, Smollm2, que é um avanço emocionante. O Smollm2 possui três versões diferentes de tamanho de parâmetro que fornecem desempenho poderoso, mesmo em dispositivos com restrição de recursos, o que é de grande significado para a computação de borda e aplicativos de dispositivos móveis. Ele se destaca em vários benchmarks, superando modelos semelhantes, demonstrando suas vantagens no raciocínio científico e nas tarefas de senso comum. A licença de código aberto e Apache 2.0 do Smollm2 também facilitam o acesso e a aplicação.

Hoje, o Hugging Face lançou o Smollm2, um novo conjunto de modelos de idiomas compactos que alcançam desempenho impressionante, exigindo muito menos recursos de computação do que modelos grandes. O novo modelo é lançado sob a licença Apache 2.0 e vem em três tamanhos - parâmetros de 135m, 360m e 1,7b - adequados para implantação em smartphones e outros dispositivos de borda com potência e memória de processamento limitados.

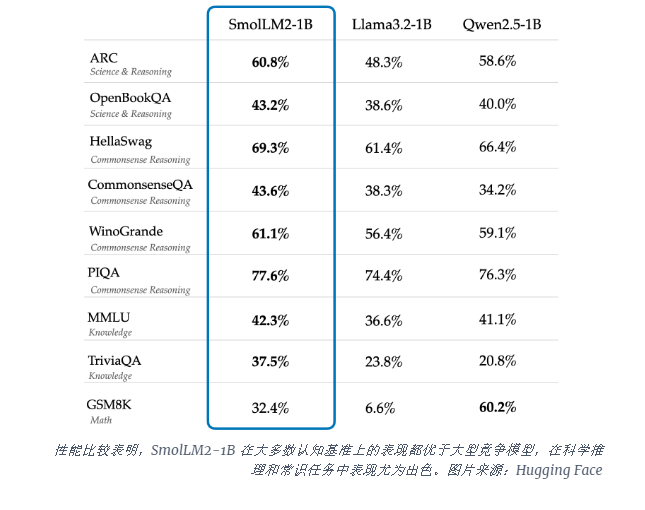

O modelo SMOLLM2-1B supera o modelo Meta llama1b em vários benchmarks importantes, especialmente em raciocínio científico e tarefas de senso comum. Esse modelo supera grandes modelos concorrentes na maioria dos benchmarks cognitivos, usando uma combinação diversificada de conjuntos de dados, incluindo conjuntos de dados matemáticos e codificadores especializados e matemáticos especializados.

O lançamento do Smollm2 ocorre em um momento crítico em que o setor de IA está lutando para lidar com a computação precisa executar grandes modelos de idiomas (LLMS). Embora empresas como OpenAI e Antrópica continuem a ultrapassar os limites do tamanho do modelo, há um reconhecimento crescente da necessidade de IA eficiente e leve que possa ser executada localmente em dispositivos.

O Smollm2 oferece uma abordagem diferente para trazer poderosos recursos de IA diretamente para dispositivos pessoais, apontando para o futuro, onde mais usuários e empresas podem usar ferramentas avançadas de IA, não apenas gigantes da tecnologia com enormes data centers. Esses modelos suportam uma gama de aplicativos, incluindo reescritas de texto, resumo e chamadas de função, adequadas para implantação em cenários em que a privacidade, a latência ou as restrições de conexão tornam impraticável as soluções de IA baseadas em nuvem.

Embora esses modelos menores ainda tenham limitações, eles representam parte de uma tendência ampla em modelos de IA mais eficientes. O lançamento do Smollm2 mostra que o futuro da inteligência artificial pode não apenas pertencer a modelos maiores, mas a arquiteturas mais eficientes que podem fornecer desempenho poderoso com menos recursos.

O surgimento do Smollm2 abriu novas possibilidades para aplicativos leves de IA, indicando que a tecnologia de IA será mais amplamente usada em vários dispositivos e cenários, trazendo aos usuários uma experiência mais conveniente e eficiente. Seus recursos de código aberto também promoveram o desenvolvimento e a inovação adicional da comunidade de IA. No futuro, espera -se que os modelos de IA mais eficientes e compactos surgissem, promovendo a popularização e o avanço das tecnologias de IA.