Hugging Faceは、新しいコンパクト言語モデルであるSmollM2を立ち上げました。これはエキサイティングなブレークスルーです。 SMOLLM2には、リソース制約のデバイスでも強力なパフォーマンスを提供する3つの異なるパラメーターサイズバージョンがあり、これはエッジコンピューティングとモバイルデバイスアプリケーションにとって非常に重要です。複数のベンチマークで優れており、同様のモデルを上回り、科学的推論と常識タスクの利点を示しています。 SMOLLM2のオープンソースとApache 2.0ライセンスにより、アクセスと適用が容易になります。

Hugging Faceは本日、SMOLLM2をリリースしました。SmollM2は、大規模なモデルよりもはるかに少ないコンピューティングリソースを必要としながら、印象的なパフォーマンスを実現するコンパクト言語モデルの新しいセットです。新しいモデルはApache 2.0ライセンスの下でリリースされ、135m、360m、1.7bパラメーターの3つのサイズがあります。

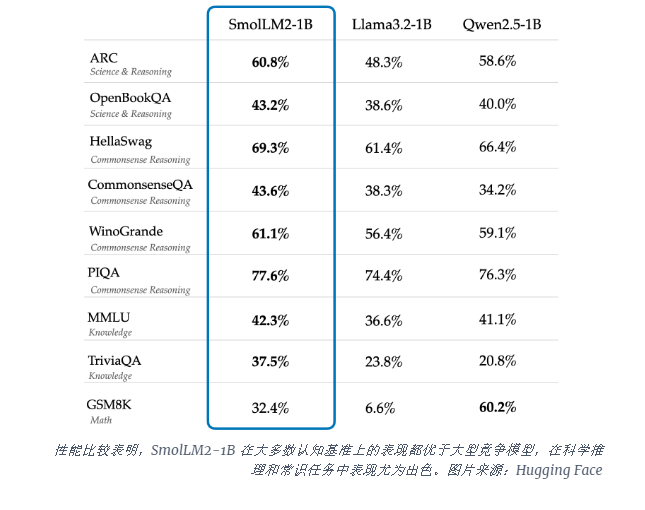

SMOLLM2-1Bモデルは、特に科学的推論と常識タスクで、いくつかの重要なベンチマークでメタラマ1Bモデルを上回ります。このモデルは、FineWeb-EDUや特殊な数学およびコーディングデータセットを含むデータセットの多様な組み合わせを使用して、ほとんどの認知ベンチマークで大規模な競合モデルよりも優れています。

SMOLLM2の発売は、AI業界がコンピューティングに対処するのに苦労している重要な瞬間に、大規模な言語モデル(LLM)を実行する必要があります。 Openaiや人類のような企業は、モデルサイズの境界を押し広げ続けていますが、デバイスで局所的に実行できる効率的で軽量のAIの必要性が高まっています。

SMOLLM2は、強力なAI機能を個人のデバイスに直接提供するための異なるアプローチを提供し、巨大なデータセンターを持つ技術大手だけでなく、より多くのユーザーや企業が高度なAIツールを使用できる未来を指摘しています。これらのモデルは、プライバシー、待ち時間、または接続制限によりクラウドベースのAIソリューションが実用的であるシナリオでの展開に適した、テキスト書き換え、概要、機能呼び出しなど、さまざまなアプリケーションをサポートしています。

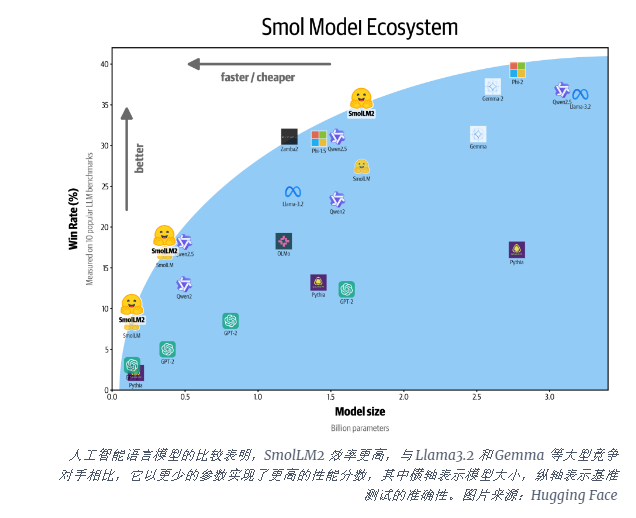

これらの小さなモデルにはまだ制限がありますが、より効率的なAIモデルの幅広い傾向の一部を表しています。 SMOLLM2のリリースは、人工知能の将来がより大きなモデルだけでなく、より少ないリソースで強力なパフォーマンスを提供できるより効率的なアーキテクチャに属する可能性があることを示しています。

SMOLLM2の出現により、軽量AIアプリケーションの新しい可能性が開かれており、AIテクノロジーがさまざまなデバイスやシナリオでより広く使用されていることを示しており、ユーザーがより便利で効率的なエクスペリエンスを提供します。そのオープンソース機能は、AIコミュニティのさらなる開発と革新も促進しています。将来的には、より効率的でコンパクトなAIモデルが出現し、AIテクノロジーの普及と進歩を促進することが期待されています。