A geração de vídeos de alta qualidade com eficiência sempre foi um grande desafio no campo da visão computacional. Os pesquisadores da Meta AI propuseram um método de aceleração sem treinamento chamado Adacache em resposta à lenta inferência dos modelos de transformadores de difusão existentes (DITs). O Adacache inteligentemente utiliza diferenças de conteúdo de vídeo, personaliza estratégias de cache para cada vídeo e introduz um esquema de regularização de movimento para alocar dinamicamente os recursos de computação com base no conteúdo de movimento de vídeo, melhorando significativamente a velocidade de inferência, garantindo a qualidade da geração.

A geração de vídeos contínuos de alta qualidade requer muitos recursos de computação, especialmente para vãos de tempo mais longos. Embora os mais recentes modelos de transformadores de difusão (DITs) tenham feito um progresso significativo na geração de vídeo, esse desafio é exacerbado pelo raciocínio mais lento devido à sua dependência de modelos maiores e mecanismos de atenção mais complexos. Para resolver esse problema, os pesquisadores da Meta AI propuseram um método sem treinamento chamado Adacache para acelerar os dívidos de vídeo.

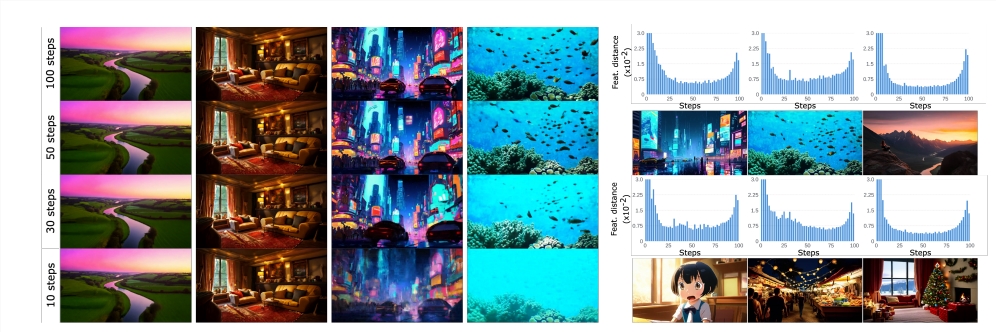

A idéia principal de Adacache é baseada no fato de que "nem todos os vídeos são iguais", o que significa que alguns vídeos exigem menos etapas de denoising do que outros para obter qualidade razoável. Com base nisso, o método não apenas armazena em cache os resultados do cálculo durante o processo de difusão, mas também projeta uma estratégia de cache personalizada para cada geração de vídeo, maximizando assim o trade-off entre qualidade e latência.

Os pesquisadores introduziram ainda um esquema de regularização de movimento (MoreG), que usa informações de vídeo em Adacache para controlar a alocação de recursos de computação com base no conteúdo de movimento. Como as seqüências de vídeo contendo texturas de alta frequência e grandes quantidades de conteúdo de movimento exigem mais etapas de difusão para obter qualidade razoável, o MoreG pode alocar melhor os recursos de computação.

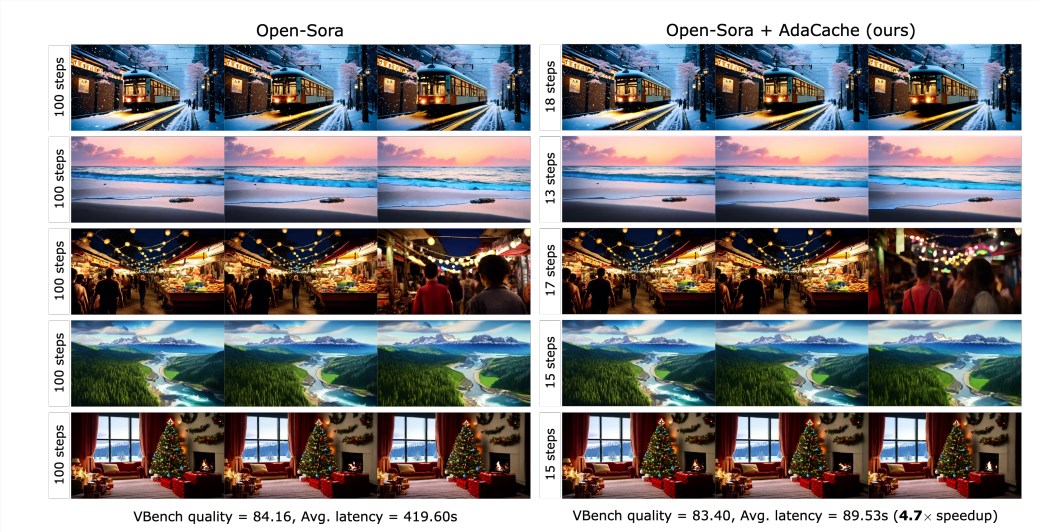

Resultados experimentais mostram que o Adacache pode melhorar significativamente a velocidade de inferência (por exemplo, até 4,7 vezes mais rápida na geração de vídeo SORA720P -2S) sem sacrificar a qualidade da geração. Além disso, o Adacache possui boas recursos de generalização e pode ser aplicado a diferentes modelos de vídeo, como Sora Open, Plano Aberto-Sora e Latte. O Adacache tem vantagens significativas na velocidade e na qualidade em comparação com outros métodos de aceleração sem treinamento, como ∆-dit, T-gate e PAB.

A pesquisa de usuários mostra que os usuários preferem vídeos gerados por Adacache em comparação com outros métodos e acreditam que sua qualidade é comparável ao modelo de referência. Este estudo confirma a eficácia do Adacache e faz uma contribuição importante para o campo da geração de vídeo eficiente. A Meta AI acredita que o Adacache pode ser amplamente utilizado e promover a popularização da geração de vídeo de alta fidelidade.

Papel: https://arxiv.org/abs/2411.02397

Página inicial do projeto:

https://adacache-dit.github.io/

Github:

https://github.com/adacache-dit/adacache

Em resumo, o Adacache, como um método de aceleração de geração de vídeo eficiente, fornece novas possibilidades para a geração de vídeos longos de alta fidelidade, e sua melhoria significativa de desempenho e boa experiência do usuário tornam as perspectivas amplas em aplicativos futuros. Esta pesquisa da Meta AI trouxe importantes avanços no campo da geração de vídeos eficientes.