La génération efficace de vidéos longues de haute qualité a toujours été un défi majeur dans le domaine de la vision par ordinateur. Les chercheurs de Meta AI ont proposé une méthode d'accélération sans formation appelée Adacache en réponse à l'inférence lente des modèles de transformateurs de diffusion existants (DIT). Adacache utilise intelligemment les différences de contenu vidéo, personnalise les stratégies de mise en cache pour chaque vidéo et introduit un schéma de régularisation de mouvement pour allouer dynamiquement les ressources informatiques basées sur le contenu de mouvement vidéo, améliorant ainsi considérablement la vitesse d'inférence tout en garantissant la qualité de la génération.

La génération de vidéos de haute qualité et continues nécessite beaucoup de ressources informatiques, en particulier pour des durées de temps plus longues. Bien que les derniers modèles de transformateurs de diffusion (DIT) aient fait des progrès significatifs dans la génération de vidéos, ce défi est exacerbé par le raisonnement plus lent en raison de leur dépendance à l'égard des modèles plus larges et des mécanismes d'attention plus complexes. Pour résoudre ce problème, les chercheurs de META AI ont proposé une méthode sans formation appelée Adacache pour accélérer les dits vidéo.

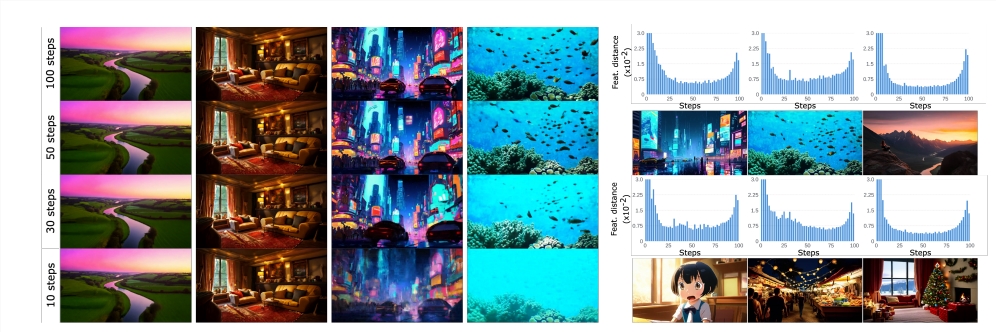

L'idée principale d'Adacache est basée sur le fait que «toutes les vidéos ne sont pas les mêmes», ce qui signifie que certaines vidéos nécessitent moins d'étapes de débrassements que d'autres pour obtenir une qualité raisonnable. Sur la base de cela, la méthode cache non seulement les résultats du calcul pendant le processus de diffusion, mais conçoit également une stratégie de cache personnalisée pour chaque génération de vidéos, maximisant ainsi le compromis entre la qualité et la latence.

Les chercheurs ont en outre introduit un schéma de régularisation de mouvement (MoreG), qui utilise des informations vidéo dans Adacache pour contrôler l'allocation des ressources informatiques en fonction du contenu de mouvement. Étant donné que les séquences vidéo contenant des textures à haute fréquence et de grandes quantités de contenu de mouvement nécessitent plus d'étapes de diffusion pour atteindre une qualité raisonnable, plus peut mieux allouer des ressources informatiques.

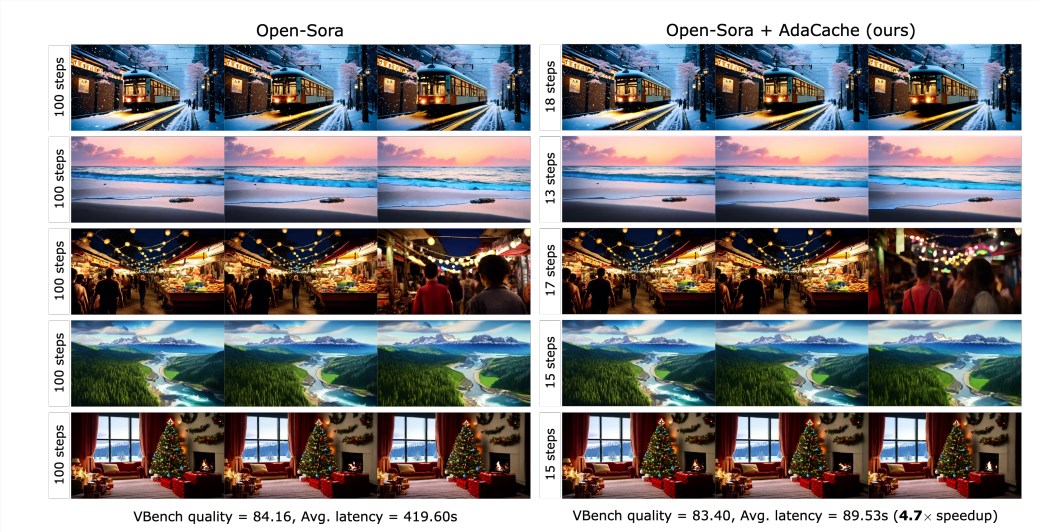

Les résultats expérimentaux montrent que l'Adacache peut améliorer considérablement la vitesse d'inférence (par exemple, jusqu'à 4,7 fois plus rapide dans la génération vidéo ouverte-SORA720P -2S) sans sacrifier la qualité de génération. De plus, Adacache a de bonnes capacités de généralisation et peut être appliquée à différents modèles de DIT vidéo, tels que l'Open-Sora, l'Open-Sora-plan et le latte. Adacache présente des avantages importants en matière de vitesse et de qualité par rapport à d'autres méthodes d'accélération sans formation telles que ∆-DIT, T-gate et PAB.

La recherche sur les utilisateurs montre que les utilisateurs préfèrent les vidéos générées par Adacache par rapport à d'autres méthodes et croient que leur qualité est comparable au modèle de référence. Cette étude confirme l'efficacité de l'Adacache et apporte une contribution importante au domaine de la génération de vidéos efficace. Meta AI estime que l'Adacache peut être largement utilisé et favoriser la popularisation de la génération vidéo longue haute fidélité.

Papier: https://arxiv.org/abs/2411.02397

Page d'accueil du projet:

https://adacache-dit.github.io/

Github:

https://github.com/adacache-dit/adacache

En bref, Adacache, en tant que méthode d'accélération de génération de vidéos efficace, offre de nouvelles possibilités pour la génération de vidéos longues à haute fidélité, et son amélioration significative des performances et une bonne expérience utilisateur font qu'il a des prospects larges dans les applications futures. Cette recherche de Meta AI a apporté d'importantes percées dans le domaine de la génération de vidéos efficaces.