gated Transformer

1.0.0

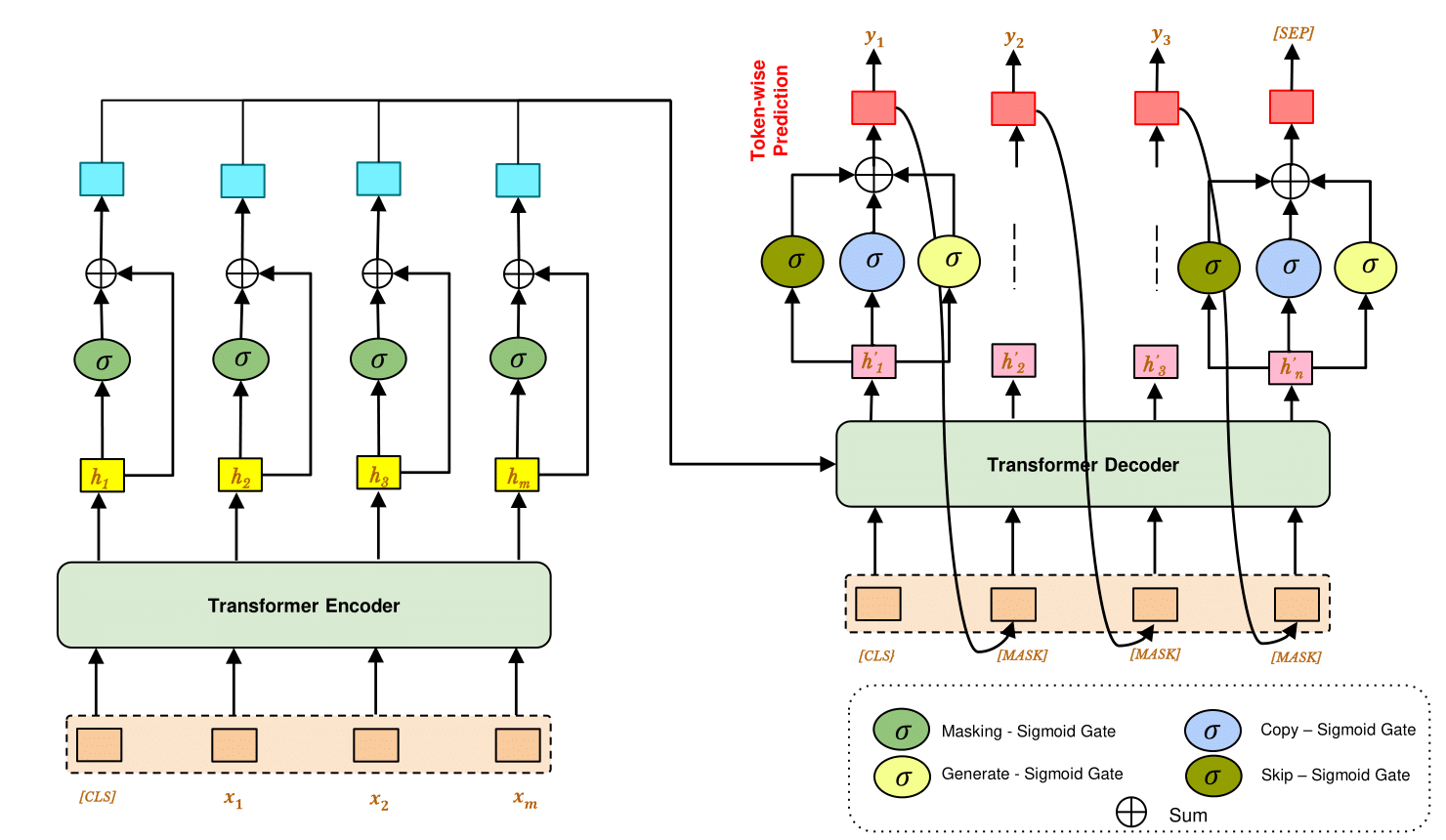

Modelo de transformador pré-arraigado fechado para modelagem robusta de sequência a sequência denoada. Ele usa uma unidade de bloqueio para detectar e corrigir ruídos dos dados de texto e gerar alvo desnatado a partir de um decodificador generativo.

Neste trabalho, conduzimos nosso experimento em três tarefas -

O transformador fechado é mostrado eficaz em -

$ pip install -r requirements.txt

Modelo de sequência de transformadores pré-tenhado (por exemplo-Bart, T5)

$ cd ./drive/MyDrive/gated-denoise/ && python train.py --train_file ./data.csv

--model_path ./model/ --model_type bart --pretrained_encoder_path "facebook/bart-base"

--mask_gate --copy_gate --generate_gate --skip_gate

--epochs 15

Modelo do codificador do transformador (por exemplo - Bert2bert)

$ cd ./drive/MyDrive/gated-denoise/ && python train.py --train_file ./data.csv

--model_path ./model/ --model_type seq2seq

--pretrained_encoder_path "bert-base-uncased" --pretrained_decoder_path "bert-base-uncased"

--mask_gate --copy_gate --generate_gate --skip_gate

--epochs 15

$ cd ./drive/MyDrive/gated-denoise/ && python predict.py --data_file ./data.csv

--model_path ./model/ --model_type bart --pretrained_encoder_path "facebook/bart-base"

--mask_gate --copy_gate --generate_gate --skip_gate

Se você achar esse repositório útil, cite nosso artigo:

@inproceedings {,

author = { Ayan Sengupta and

Amit Kumar and

Sourabh Kumar Bhattacharjee and

Suman Roy } ,

title = { Gated Transformer for Robust De-noised Sequence-to-Sequence Modelling } ,

booktitle = { } ,

publisher = { } ,

year = { } ,

url = { } ,

doi = { } ,

}