gated Transformer

1.0.0

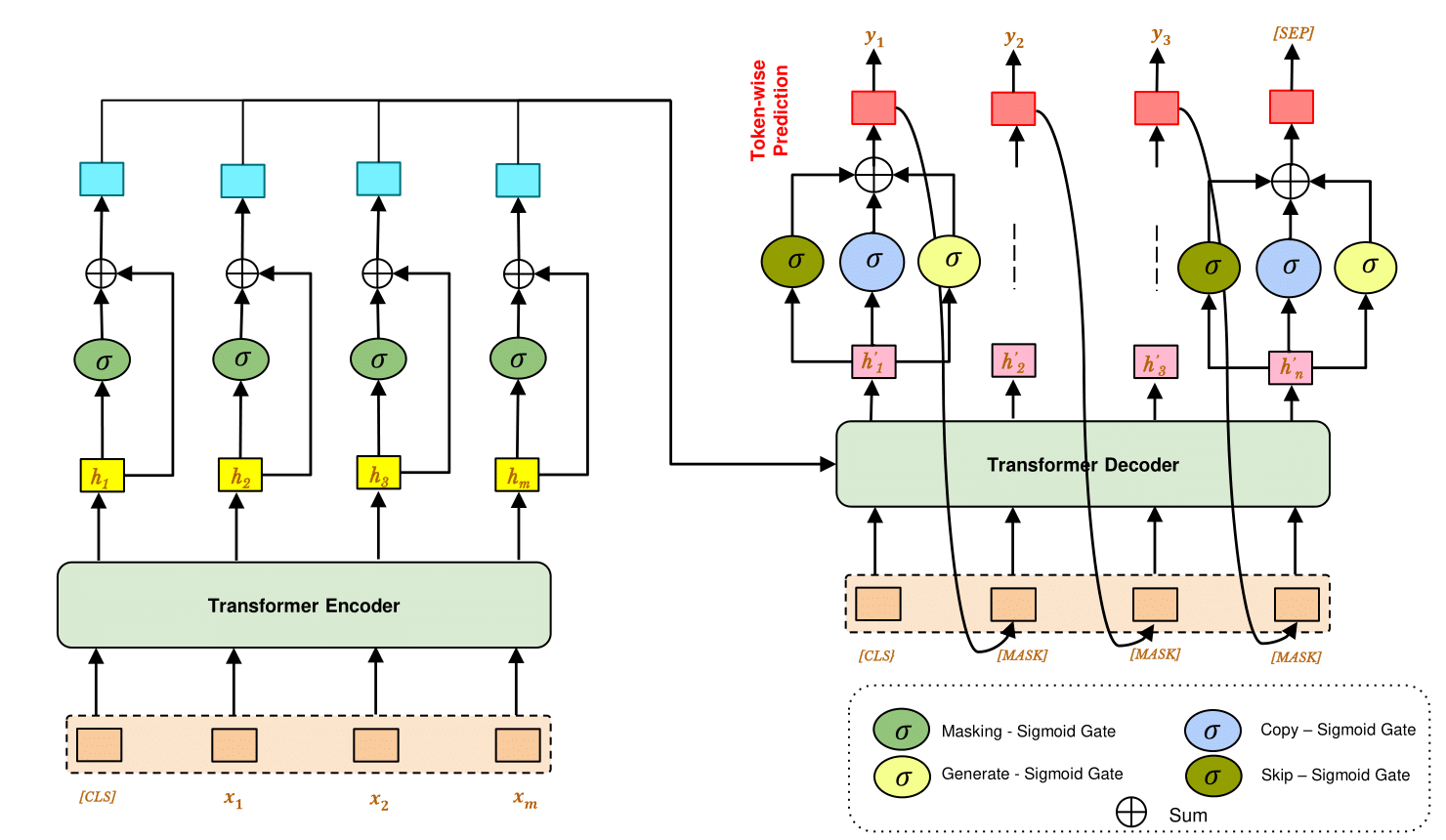

Modèle de transformateur prétrainé fermé pour une modélisation robuste de séquence à séquence à la séquence. Il utilise une unité de déclenchement pour détecter et corriger les bruits à partir des données de texte et générer une cible désactivée à partir d'un décodeur génératif.

Dans ce travail, nous effectuons notre expérience sur trois tâches -

le transformateur fermé est montré efficace sur -

$ pip install -r requirements.txt

Modèle de séquence à séquence de transformateur pré-entraîné (par exemple, Bart, T5)

$ cd ./drive/MyDrive/gated-denoise/ && python train.py --train_file ./data.csv

--model_path ./model/ --model_type bart --pretrained_encoder_path "facebook/bart-base"

--mask_gate --copy_gate --generate_gate --skip_gate

--epochs 15

Modèle de coder de transformateur (par exemple - Bert2bert)

$ cd ./drive/MyDrive/gated-denoise/ && python train.py --train_file ./data.csv

--model_path ./model/ --model_type seq2seq

--pretrained_encoder_path "bert-base-uncased" --pretrained_decoder_path "bert-base-uncased"

--mask_gate --copy_gate --generate_gate --skip_gate

--epochs 15

$ cd ./drive/MyDrive/gated-denoise/ && python predict.py --data_file ./data.csv

--model_path ./model/ --model_type bart --pretrained_encoder_path "facebook/bart-base"

--mask_gate --copy_gate --generate_gate --skip_gate

Si vous trouvez ce dépôt utile, veuillez citer notre article:

@inproceedings {,

author = { Ayan Sengupta and

Amit Kumar and

Sourabh Kumar Bhattacharjee and

Suman Roy } ,

title = { Gated Transformer for Robust De-noised Sequence-to-Sequence Modelling } ,

booktitle = { } ,

publisher = { } ,

year = { } ,

url = { } ,

doi = { } ,

}