Resultados | Atualizações | Uso | TODO | Reconhecer

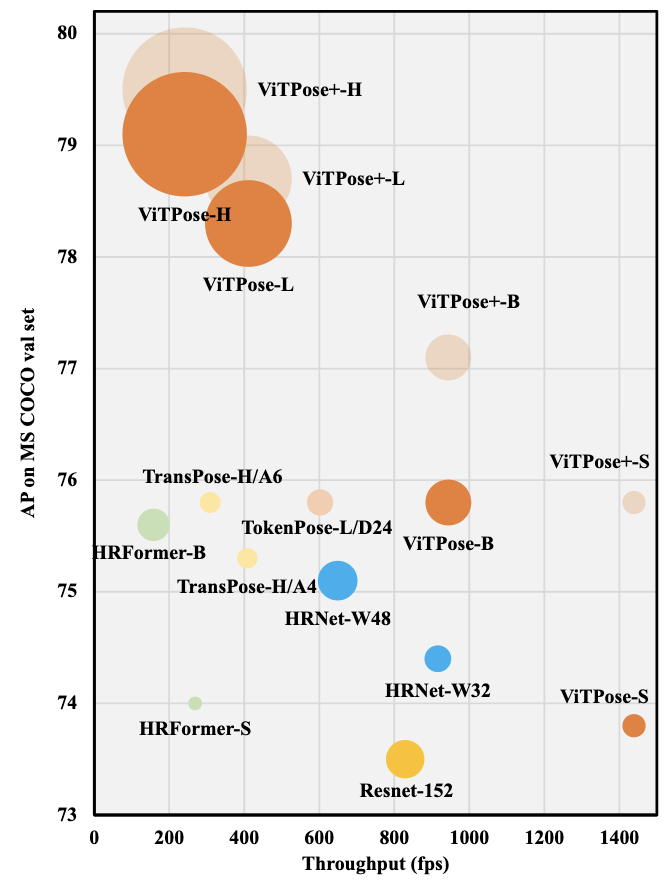

Este ramo contém a implementação de Pytorch da vitória: linhas de base do transformador de visão simples para estimativa de pose humana e vitória+: modelo de fundação do transformador de visão para estimativa genérica de pose corporal. Ele obtém 81,1 AP no conjunto de testes de ponto-chave MS Coco.

Usando os resultados da detecção de um detector que obtém 56 mapa na pessoa. As configurações aqui são para treinamento e teste.

Com decodificador clássico

| Modelo | Pré | Resolução | AP | Ar | Config | registro | peso |

|---|---|---|---|---|---|---|---|

| VitPe-s | Mae | 256x192 | 73.8 | 79.2 | Config | registro | OneDrive |

| VitPe-b | Mae | 256x192 | 75.8 | 81.1 | Config | registro | OneDrive |

| VitPe-L | Mae | 256x192 | 78.3 | 83.5 | Config | registro | OneDrive |

| VitPe-h | Mae | 256x192 | 79.1 | 84.1 | Config | registro | OneDrive |

Com decodificador simples

| Modelo | Pré | Resolução | AP | Ar | Config | registro | peso |

|---|---|---|---|---|---|---|---|

| VitPe-s | Mae | 256x192 | 73.5 | 78.9 | Config | registro | OneDrive |

| VitPe-b | Mae | 256x192 | 75.5 | 80.9 | Config | registro | OneDrive |

| VitPe-L | Mae | 256x192 | 78.2 | 83.4 | Config | registro | OneDrive |

| VitPe-h | Mae | 256x192 | 78.9 | 84.0 | Config | registro | OneDrive |

Nota * Pode existir imagens duplicadas no conjunto de treinamento em fios de crowds e nas imagens de validação em outros conjuntos de dados, conforme discutido na edição #24. Por favor, tenha cuidado ao usar esses modelos para avaliação. Fornecemos os resultados sem o conjunto de dados Crowpose para referência.

Resultados no MS Coco Val Set

Usando os resultados da detecção de um detector que obtém 56 mapa na pessoa. Observe que as configurações aqui são apenas para avaliação.

| Modelo | Conjunto de dados | Resolução | AP | Ar | Config | peso |

|---|---|---|---|---|---|---|

| VitPe-b | Coco+AIC+MPII | 256x192 | 77.1 | 82.2 | Config | OneDrive |

| VitPe-L | Coco+AIC+MPII | 256x192 | 78.7 | 83.8 | Config | OneDrive |

| VitPe-h | Coco+AIC+MPII | 256x192 | 79.5 | 84.5 | Config | OneDrive |

| VitPe-g | Coco+AIC+MPII | 576x432 | 81.0 | 85.6 | ||

| VitPe-b* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 77.5 | 82.6 | Config | OneDrive |

| VitPe-l* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 79.1 | 84.1 | Config | OneDrive |

| VitPe-H* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 79.8 | 84.8 | Config | OneDrive |

| Vitaxa+-s | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 75.8 | 82.6 | Config | log | OneDrive |

| VitPe+-b | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 77.0 | 82.6 | Config | log | OneDrive |

| VitPe+-l | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 78.6 | 84.1 | Config | log | OneDrive |

| VitPe+-h | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 79.4 | 84.8 | Config | log | OneDrive |

Resultados no conjunto de testes ococumanos

Usando caixas delimitadoras de truta. Observe que as configurações aqui são apenas para avaliação.

| Modelo | Conjunto de dados | Resolução | AP | Ar | Config | peso |

|---|---|---|---|---|---|---|

| VitPe-b | Coco+AIC+MPII | 256x192 | 88.0 | 89.6 | Config | OneDrive |

| VitPe-L | Coco+AIC+MPII | 256x192 | 90.9 | 92.2 | Config | OneDrive |

| VitPe-h | Coco+AIC+MPII | 256x192 | 90.9 | 92.3 | Config | OneDrive |

| VitPe-g | Coco+AIC+MPII | 576x432 | 93.3 | 94.3 | ||

| VitPe-b* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 88.2 | 90.0 | Config | OneDrive |

| VitPe-l* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 91.5 | 92.8 | Config | OneDrive |

| VitPe-H* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 91.6 | 92.8 | Config | OneDrive |

| Vitaxa+-s | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 78.4 | 80.6 | Config | log | OneDrive |

| VitPe+-b | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 82.6 | 84.8 | Config | log | OneDrive |

| VitPe+-l | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 85.7 | 87.5 | Config | log | OneDrive |

| VitPe+-h | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 85.7 | 87.4 | Config | log | OneDrive |

Resultados no conjunto MPII Val

Usando caixas delimitadoras de truta. Observe que as configurações aqui são apenas para avaliação. A métrica é PCKH.

| Modelo | Conjunto de dados | Resolução | Significar | Config | peso |

|---|---|---|---|---|---|

| VitPe-b | Coco+AIC+MPII | 256x192 | 93.3 | Config | OneDrive |

| VitPe-L | Coco+AIC+MPII | 256x192 | 94.0 | Config | OneDrive |

| VitPe-h | Coco+AIC+MPII | 256x192 | 94.1 | Config | OneDrive |

| VitPe-g | Coco+AIC+MPII | 576x432 | 94.3 | ||

| VitPe-b* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 93.4 | Config | OneDrive |

| VitPe-l* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 93.9 | Config | OneDrive |

| VitPe-H* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 94.1 | Config | OneDrive |

| Vitaxa+-s | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 92.7 | Config | log | OneDrive |

| VitPe+-b | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 92.8 | Config | log | OneDrive |

| VitPe+-l | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 94.0 | Config | log | OneDrive |

| VitPe+-h | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 94.2 | Config | log | OneDrive |

Resultados no conjunto de testes da IA Challenger

Usando caixas delimitadoras de truta. Observe que as configurações aqui são apenas para avaliação.

| Modelo | Conjunto de dados | Resolução | AP | Ar | Config | peso |

|---|---|---|---|---|---|---|

| VitPe-b | Coco+AIC+MPII | 256x192 | 32.0 | 36.3 | Config | OneDrive |

| VitPe-L | Coco+AIC+MPII | 256x192 | 34.5 | 39.0 | Config | OneDrive |

| VitPe-h | Coco+AIC+MPII | 256x192 | 35.4 | 39.9 | Config | OneDrive |

| VitPe-g | Coco+AIC+MPII | 576x432 | 43.2 | 47.1 | ||

| VitPe-b* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 31.9 | 36.3 | Config | OneDrive |

| VitPe-l* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 34.6 | 39.0 | Config | OneDrive |

| VitPe-H* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 35.3 | 39.8 | Config | OneDrive |

| Vitaxa+-s | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 29.7 | 34.3 | Config | log | OneDrive |

| VitPe+-b | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 31.8 | 36.3 | Config | log | OneDrive |

| VitPe+-l | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 34.3 | 38.9 | Config | log | OneDrive |

| VitPe+-h | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 34.8 | 39.1 | Config | log | OneDrive |

Resultados no conjunto de testes de fios de crowds

Usando o detector humano YOLOV3. Observe que as configurações aqui são apenas para avaliação.

| Modelo | Conjunto de dados | Resolução | AP | AP (H) | Config | peso |

|---|---|---|---|---|---|---|

| VitPe-b* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 74.7 | 63.3 | Config | OneDrive |

| VitPe-l* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 76.6 | 65.9 | Config | OneDrive |

| VitPe-H* | Coco+AIC+MPII+Prosseiro Crowds | 256x192 | 76.3 | 65.6 | Config | OneDrive |

Resultados no conjunto de testes AP-10K

| Modelo | Conjunto de dados | Resolução | AP | Config | peso |

|---|---|---|---|---|---|

| Vitaxa+-s | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 71.4 | Config | log | OneDrive |

| VitPe+-b | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 74.5 | Config | log | OneDrive |

| VitPe+-l | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 80.4 | Config | log | OneDrive |

| VitPe+-h | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 82.4 | Config | log | OneDrive |

Resultados no conjunto APT-36K Val

| Modelo | Conjunto de dados | Resolução | AP | Config | peso |

|---|---|---|---|---|---|

| Vitaxa+-s | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 74.2 | Config | log | OneDrive |

| VitPe+-b | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 75.9 | Config | log | OneDrive |

| VitPe+-l | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 80.8 | Config | log | OneDrive |

| VitPe+-h | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 82.3 | Config | log | OneDrive |

| Modelo | Conjunto de dados | Resolução | AP | Config | peso |

|---|---|---|---|---|---|

| Vitaxa+-s | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 54.4 | Config | log | OneDrive |

| VitPe+-b | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 57.4 | Config | log | OneDrive |

| VitPe+-l | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 60.6 | Config | log | OneDrive |

| VitPe+-h | Coco+AIC+MPII+AP10K+APT36K+TODO | 256x192 | 61.2 | Config | log | OneDrive |

| Modelo | Conjunto de dados | Resolução | AUC | Config | peso |

|---|---|---|---|---|---|

| Vitaxa+-s | Coco+AIC+MPII+PLOBLEO | 256x192 | 86.5 | Config | Em breve |

| VitPe+-b | Coco+AIC+MPII+PLOBLEO | 256x192 | 87.0 | Config | Em breve |

| VitPe+-l | Coco+AIC+MPII+PLOBLEO | 256x192 | 87.5 | Config | Em breve |

| VitPe+-h | Coco+AIC+MPII+PLOBLEO | 256x192 | 87.6 | Config | Em breve |

[2023-01-10] Atualize Vitpos+! Ele usa estratégias da MOE para lidar em conjunto com tarefas de estimativa de pose humano, animal e de todo o corpo.

[2022-05-24] Carregue o código de treinamento de tarefa única, modelos pré-treinados de tarefas únicas e modelos pré-fragmentados com várias tarefas.

[2022-05-06] Carregue os logs para os modelos básicos, grandes e enormes!

[2022-04-27] Nossa vitória com Vitae-G obtém 81,1 AP no conjunto de testes de coco!

As aplicações do transformador Vitae incluem: Classificação da imagem | Detecção de objetos | Segmentação semântica | Segmentação de pose animal | Sensoriamento remoto | Matting | Vsa | Vitdet

Utilizamos o Pytorch 1.9.0 ou o NGC Docker 21.06 e o MMCV 1.3.9 para as experiências.

git clone https://github.com/open-mmlab/mmcv.git

cd mmcv

git checkout v1.3.9

MMCV_WITH_OPS=1 pip install -e .

cd ..

git clone https://github.com/ViTAE-Transformer/ViTPose.git

cd ViTPose

pip install -v -e .Depois de instalar os dois repositórios, instale Timm e Einops, ou seja,

pip install timm==0.4.9 einopsDepois de fazer o download dos modelos pré -treinados, conduza os experimentos executando

# for single machine

bash tools/dist_train.sh < Config PATH > < NUM GPUs > --cfg-options model.pretrained= < Pretrained PATH > --seed 0

# for multiple machines

python -m torch.distributed.launch --nnodes < Num Machines > --node_rank < Rank of Machine > --nproc_per_node < GPUs Per Machine > --master_addr < Master Addr > --master_port < Master Port > tools/train.py < Config PATH > --cfg-options model.pretrained= < Pretrained PATH > --launcher pytorch --seed 0Para testar o desempenho dos modelos pré -treinado, execute

bash tools/dist_test.sh < Config PATH > < Checkpoint PATH > < NUM GPUs >Para modelos de vitória+ pré-treinados, primeiro reorganize os pesos pré-treinados usando

python tools/model_split.py --source < Pretrained PATH > Esta corrente de repo contém modificações, incluindo:

Carregar configurações e modelos pré -tenhados

Mais modelos com resultados SOTA

Carregar configuração de treinamento com várias tarefas

Reconhecemos a excelente implementação de Mmpose e MAE.

Para vitória

@inproceedings{

xu2022vitpose,

title={Vi{TP}ose: Simple Vision Transformer Baselines for Human Pose Estimation},

author={Yufei Xu and Jing Zhang and Qiming Zhang and Dacheng Tao},

booktitle={Advances in Neural Information Processing Systems},

year={2022},

}

Para vitória+

@article{xu2022vitpose+,

title={ViTPose+: Vision Transformer Foundation Model for Generic Body Pose Estimation},

author={Xu, Yufei and Zhang, Jing and Zhang, Qiming and Tao, Dacheng},

journal={arXiv preprint arXiv:2212.04246},

year={2022}

}

Para Vitae e Vitaev2, consulte: Consulte:

@article{xu2021vitae,

title={Vitae: Vision transformer advanced by exploring intrinsic inductive bias},

author={Xu, Yufei and Zhang, Qiming and Zhang, Jing and Tao, Dacheng},

journal={Advances in Neural Information Processing Systems},

volume={34},

year={2021}

}

@article{zhang2022vitaev2,

title={ViTAEv2: Vision Transformer Advanced by Exploring Inductive Bias for Image Recognition and Beyond},

author={Zhang, Qiming and Xu, Yufei and Zhang, Jing and Tao, Dacheng},

journal={arXiv preprint arXiv:2202.10108},

year={2022}

}