Ergebnisse | Updates | Verwendung | Todo | Anerkennen

Dieser Zweig enthält die Pytorch -Implementierung von Vitpose: Einfache Sehtransformator -Baselines für die Schätzung des menschlichen Pose und das Vitins+: Sehtransformator -Foundation -Modell für die Schätzung der generischen Körperpose. Es erhält 81.1 AP für MS Coco Keypoint-Test-Dev-Set.

Verwenden von Erkennungsergebnissen von einem Detektor, der 56 MAP auf der Person erhält. Die Konfigurationen hier sind sowohl für Training als auch für Test.

Mit klassischem Decoder

| Modell | Vorrain | Auflösung | AP | Ar | Konfiguration | Protokoll | Gewicht |

|---|---|---|---|---|---|---|---|

| Vitelle-S | Mae | 256x192 | 73,8 | 79,2 | Konfiguration | Protokoll | OneDrive |

| Vitpuls-B | Mae | 256x192 | 75,8 | 81.1 | Konfiguration | Protokoll | OneDrive |

| Vitpose-L | Mae | 256x192 | 78,3 | 83,5 | Konfiguration | Protokoll | OneDrive |

| Vitpuls-H | Mae | 256x192 | 79.1 | 84.1 | Konfiguration | Protokoll | OneDrive |

Mit einfachem Decoder

| Modell | Vorrain | Auflösung | AP | Ar | Konfiguration | Protokoll | Gewicht |

|---|---|---|---|---|---|---|---|

| Vitelle-S | Mae | 256x192 | 73,5 | 78,9 | Konfiguration | Protokoll | OneDrive |

| Vitpuls-B | Mae | 256x192 | 75,5 | 80.9 | Konfiguration | Protokoll | OneDrive |

| Vitpose-L | Mae | 256x192 | 78,2 | 83.4 | Konfiguration | Protokoll | OneDrive |

| Vitpuls-H | Mae | 256x192 | 78,9 | 84.0 | Konfiguration | Protokoll | OneDrive |

HINWEIS * Es kann möglicherweise doppelte Bilder im Crowdpose -Trainingssatz und in den Validierungsbildern in anderen Datensätzen existieren, wie in Ausgabe Nr. 24 erläutert. Bitte seien Sie vorsichtig, wenn Sie diese Modelle zur Bewertung verwenden. Wir stellen die Ergebnisse ohne Crowpose -Datensatz als Referenz bereit.

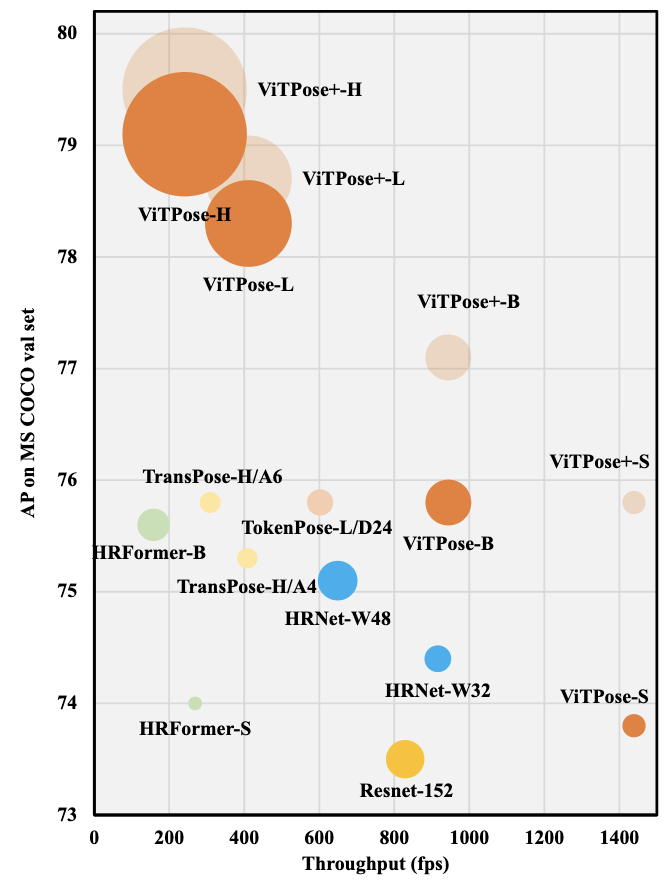

Ergebnisse am MS Coco Val Set

Verwenden von Erkennungsergebnissen von einem Detektor, der 56 MAP auf der Person erhält. Beachten Sie, dass die Konfigurationen hier nur zur Bewertung dienen.

| Modell | Datensatz | Auflösung | AP | Ar | Konfiguration | Gewicht |

|---|---|---|---|---|---|---|

| Vitpuls-B | Coco+AIC+MPII | 256x192 | 77.1 | 82.2 | Konfiguration | OneDrive |

| Vitpose-L | Coco+AIC+MPII | 256x192 | 78,7 | 83.8 | Konfiguration | OneDrive |

| Vitpuls-H | Coco+AIC+MPII | 256x192 | 79,5 | 84,5 | Konfiguration | OneDrive |

| Vitpins-G | Coco+AIC+MPII | 576x432 | 81.0 | 85.6 | ||

| Vitpuls-B* | Coco+AIC+MPII+Crowdple | 256x192 | 77,5 | 82.6 | Konfiguration | OneDrive |

| Vitpose-L* | Coco+AIC+MPII+Crowdple | 256x192 | 79.1 | 84.1 | Konfiguration | OneDrive |

| Vitpuls-H* | Coco+AIC+MPII+Crowdple | 256x192 | 79,8 | 84,8 | Konfiguration | OneDrive |

| VITPOSE+-S | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 75,8 | 82.6 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-B | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 77.0 | 82.6 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-L | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 78,6 | 84.1 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-H | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 79,4 | 84,8 | Konfiguration | Protokoll | OneDrive |

Ergebnisse zum Ochuman -Testsatz

Verwenden von Bodetruth -Begrenzungsboxen. Beachten Sie, dass die Konfigurationen hier nur zur Bewertung dienen.

| Modell | Datensatz | Auflösung | AP | Ar | Konfiguration | Gewicht |

|---|---|---|---|---|---|---|

| Vitpuls-B | Coco+AIC+MPII | 256x192 | 88.0 | 89,6 | Konfiguration | OneDrive |

| Vitpose-L | Coco+AIC+MPII | 256x192 | 90,9 | 92.2 | Konfiguration | OneDrive |

| Vitpuls-H | Coco+AIC+MPII | 256x192 | 90,9 | 92.3 | Konfiguration | OneDrive |

| Vitpins-G | Coco+AIC+MPII | 576x432 | 93.3 | 94.3 | ||

| Vitpuls-B* | Coco+AIC+MPII+Crowdple | 256x192 | 88.2 | 90.0 | Konfiguration | OneDrive |

| Vitpose-L* | Coco+AIC+MPII+Crowdple | 256x192 | 91.5 | 92.8 | Konfiguration | OneDrive |

| Vitpuls-H* | Coco+AIC+MPII+Crowdple | 256x192 | 91.6 | 92.8 | Konfiguration | OneDrive |

| VITPOSE+-S | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 78,4 | 80.6 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-B | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 82.6 | 84,8 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-L | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 85.7 | 87,5 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-H | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 85.7 | 87,4 | Konfiguration | Protokoll | OneDrive |

Ergebnisse am MPII VAL -Set

Verwenden von Bodetruth -Begrenzungsboxen. Beachten Sie, dass die Konfigurationen hier nur zur Bewertung dienen. Die Metrik ist PCKH.

| Modell | Datensatz | Auflösung | Bedeuten | Konfiguration | Gewicht |

|---|---|---|---|---|---|

| Vitpuls-B | Coco+AIC+MPII | 256x192 | 93.3 | Konfiguration | OneDrive |

| Vitpose-L | Coco+AIC+MPII | 256x192 | 94.0 | Konfiguration | OneDrive |

| Vitpuls-H | Coco+AIC+MPII | 256x192 | 94.1 | Konfiguration | OneDrive |

| Vitpins-G | Coco+AIC+MPII | 576x432 | 94.3 | ||

| Vitpuls-B* | Coco+AIC+MPII+Crowdple | 256x192 | 93.4 | Konfiguration | OneDrive |

| Vitpose-L* | Coco+AIC+MPII+Crowdple | 256x192 | 93.9 | Konfiguration | OneDrive |

| Vitpuls-H* | Coco+AIC+MPII+Crowdple | 256x192 | 94.1 | Konfiguration | OneDrive |

| VITPOSE+-S | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 92.7 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-B | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 92.8 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-L | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 94.0 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-H | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 94.2 | Konfiguration | Protokoll | OneDrive |

Ergebnisse beim AI -Challenger -Testsatz

Verwenden von Bodetruth -Begrenzungsboxen. Beachten Sie, dass die Konfigurationen hier nur zur Bewertung dienen.

| Modell | Datensatz | Auflösung | AP | Ar | Konfiguration | Gewicht |

|---|---|---|---|---|---|---|

| Vitpuls-B | Coco+AIC+MPII | 256x192 | 32.0 | 36.3 | Konfiguration | OneDrive |

| Vitpose-L | Coco+AIC+MPII | 256x192 | 34.5 | 39.0 | Konfiguration | OneDrive |

| Vitpuls-H | Coco+AIC+MPII | 256x192 | 35.4 | 39.9 | Konfiguration | OneDrive |

| Vitpins-G | Coco+AIC+MPII | 576x432 | 43.2 | 47.1 | ||

| Vitpuls-B* | Coco+AIC+MPII+Crowdple | 256x192 | 31.9 | 36.3 | Konfiguration | OneDrive |

| Vitpose-L* | Coco+AIC+MPII+Crowdple | 256x192 | 34.6 | 39.0 | Konfiguration | OneDrive |

| Vitpuls-H* | Coco+AIC+MPII+Crowdple | 256x192 | 35.3 | 39,8 | Konfiguration | OneDrive |

| VITPOSE+-S | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 29.7 | 34.3 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-B | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 31.8 | 36.3 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-L | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 34.3 | 38,9 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-H | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 34.8 | 39.1 | Konfiguration | Protokoll | OneDrive |

Ergebnisse beim Crowdple -Testsatz

Verwenden von Yolov3 Human Detektor. Beachten Sie, dass die Konfigurationen hier nur zur Bewertung dienen.

| Modell | Datensatz | Auflösung | AP | AP (h) | Konfiguration | Gewicht |

|---|---|---|---|---|---|---|

| Vitpuls-B* | Coco+AIC+MPII+Crowdple | 256x192 | 74.7 | 63.3 | Konfiguration | OneDrive |

| Vitpose-L* | Coco+AIC+MPII+Crowdple | 256x192 | 76,6 | 65,9 | Konfiguration | OneDrive |

| Vitpuls-H* | Coco+AIC+MPII+Crowdple | 256x192 | 76,3 | 65.6 | Konfiguration | OneDrive |

Ergebnisse beim AP-10K-Testsatz

| Modell | Datensatz | Auflösung | AP | Konfiguration | Gewicht |

|---|---|---|---|---|---|

| VITPOSE+-S | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 71,4 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-B | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 74,5 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-L | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 80.4 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-H | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 82.4 | Konfiguration | Protokoll | OneDrive |

Ergebnisse beim APT-36K VAL-Set

| Modell | Datensatz | Auflösung | AP | Konfiguration | Gewicht |

|---|---|---|---|---|---|

| VITPOSE+-S | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 74.2 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-B | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 75,9 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-L | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 80.8 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-H | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 82.3 | Konfiguration | Protokoll | OneDrive |

| Modell | Datensatz | Auflösung | AP | Konfiguration | Gewicht |

|---|---|---|---|---|---|

| VITPOSE+-S | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 54.4 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-B | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 57,4 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-L | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 60.6 | Konfiguration | Protokoll | OneDrive |

| VITPOSE+-H | COCO+AIC+MPII+AP10K+APT36K+GROMEBODY | 256x192 | 61.2 | Konfiguration | Protokoll | OneDrive |

| Modell | Datensatz | Auflösung | AUC | Konfiguration | Gewicht |

|---|---|---|---|---|---|

| VITPOSE+-S | Coco+AIC+mpii+Ganzkörper | 256x192 | 86,5 | Konfiguration | Bald kommen |

| VITPOSE+-B | Coco+AIC+mpii+Ganzkörper | 256x192 | 87.0 | Konfiguration | Bald kommen |

| VITPOSE+-L | Coco+AIC+mpii+Ganzkörper | 256x192 | 87,5 | Konfiguration | Bald kommen |

| VITPOSE+-H | Coco+AIC+mpii+Ganzkörper | 256x192 | 87.6 | Konfiguration | Bald kommen |

[2023-01-10] Aktualisieren Sie Vitpose+! Es verwendet MOE -Strategien, um gemeinsam mit menschlichen, tierischen und wotbody Pose -Schätzungsaufgaben umzugehen.

[2022-05-24] Laden Sie den Single-Task-Trainingscode, die vorgeschriebenen Modelle mit Einzelaufgaben und mehr Aufgaben hoch.

[2022-05-06] Laden Sie die Protokolle für die Basis, große und riesige Modelle hoch!

[2022-04-27] Unser Vitpose mit Vitae-G erhält 81,1 AP für Coco Test-Dev-Set!

Anwendungen des Vitae -Transformators umfassen: Bildklassifizierung | Objekterkennung | Semantische Segmentierung | Tierpose -Segmentierung | Fernerkundung | Matting | Vsa | Vitdet

Wir verwenden Pytorch 1.9.0 oder NGC Docker 21.06 und MMCV 1.3.9 für die Experimente.

git clone https://github.com/open-mmlab/mmcv.git

cd mmcv

git checkout v1.3.9

MMCV_WITH_OPS=1 pip install -e .

cd ..

git clone https://github.com/ViTAE-Transformer/ViTPose.git

cd ViTPose

pip install -v -e .Nach der Installation der beiden Repos TIMM und Einops installieren, dh,

pip install timm==0.4.9 einopsDurch das Herunterladen der vorbereiteten Modelle führen Sie bitte die Experimente durch Laufen durch

# for single machine

bash tools/dist_train.sh < Config PATH > < NUM GPUs > --cfg-options model.pretrained= < Pretrained PATH > --seed 0

# for multiple machines

python -m torch.distributed.launch --nnodes < Num Machines > --node_rank < Rank of Machine > --nproc_per_node < GPUs Per Machine > --master_addr < Master Addr > --master_port < Master Port > tools/train.py < Config PATH > --cfg-options model.pretrained= < Pretrained PATH > --launcher pytorch --seed 0Um die Leistung der vorbereiteten Modelle zu testen, rennen Sie bitte

bash tools/dist_test.sh < Config PATH > < Checkpoint PATH > < NUM GPUs >Für Vitpose+ vorgeborene Modelle organisieren Sie bitte zunächst die vorgeborenen Gewichte mit

python tools/model_split.py --source < Pretrained PATH > Dieser Repo -Strom enthält Modifikationen, einschließlich:

Laden Sie Konfigurationen und vorbereitete Modelle hoch.

Weitere Modelle mit SOTA -Ergebnissen

Laden Sie die Multitask-Trainingskonfiguration hoch.

Wir erkennen die hervorragende Implementierung von MMose und Mae an.

Für Vitpose

@inproceedings{

xu2022vitpose,

title={Vi{TP}ose: Simple Vision Transformer Baselines for Human Pose Estimation},

author={Yufei Xu and Jing Zhang and Qiming Zhang and Dacheng Tao},

booktitle={Advances in Neural Information Processing Systems},

year={2022},

}

Für Vitpose+

@article{xu2022vitpose+,

title={ViTPose+: Vision Transformer Foundation Model for Generic Body Pose Estimation},

author={Xu, Yufei and Zhang, Jing and Zhang, Qiming and Tao, Dacheng},

journal={arXiv preprint arXiv:2212.04246},

year={2022}

}

Für Vitae und Vitaev2 finden Sie bitte:

@article{xu2021vitae,

title={Vitae: Vision transformer advanced by exploring intrinsic inductive bias},

author={Xu, Yufei and Zhang, Qiming and Zhang, Jing and Tao, Dacheng},

journal={Advances in Neural Information Processing Systems},

volume={34},

year={2021}

}

@article{zhang2022vitaev2,

title={ViTAEv2: Vision Transformer Advanced by Exploring Inductive Bias for Image Recognition and Beyond},

author={Zhang, Qiming and Xu, Yufei and Zhang, Jing and Tao, Dacheng},

journal={arXiv preprint arXiv:2202.10108},

year={2022}

}