Stav Cohen, Ron Bitton, Ben Nassi

Technion - Instituto de Tecnologia de Israel, Cornell Tech, Intuit

Site | Vídeo do YouTube | Papel arxiv

Esta pesquisa pretende mudar a percepção sobre o jailbreak e:

Demonstre que um modelo de Genai jailbroken pode representar danos reais às aplicações movidas a Genai e incentivar uma discussão sobre a necessidade de evitar tentativas de jailbreak.

Revelando o Promptware, uma nova ameaça para aplicativos movidos a Genai que poderiam ser aplicados pela Jailai, um modelo Genai.

Aumentar a conscientização sobre o fato de o Plan & Execute Architecturas estarem extremamente vulneráveis a Promptwares.

Neste artigo, argumentamos que, embora um modelo Genai Jailiken não represente uma ameaça real para os usuários finais em uma IA conversacional, isso pode causar danos reais a aplicações alimentadas por genai e facilitar um novo tipo de ataque que nomeamos o Prompt-Ware.

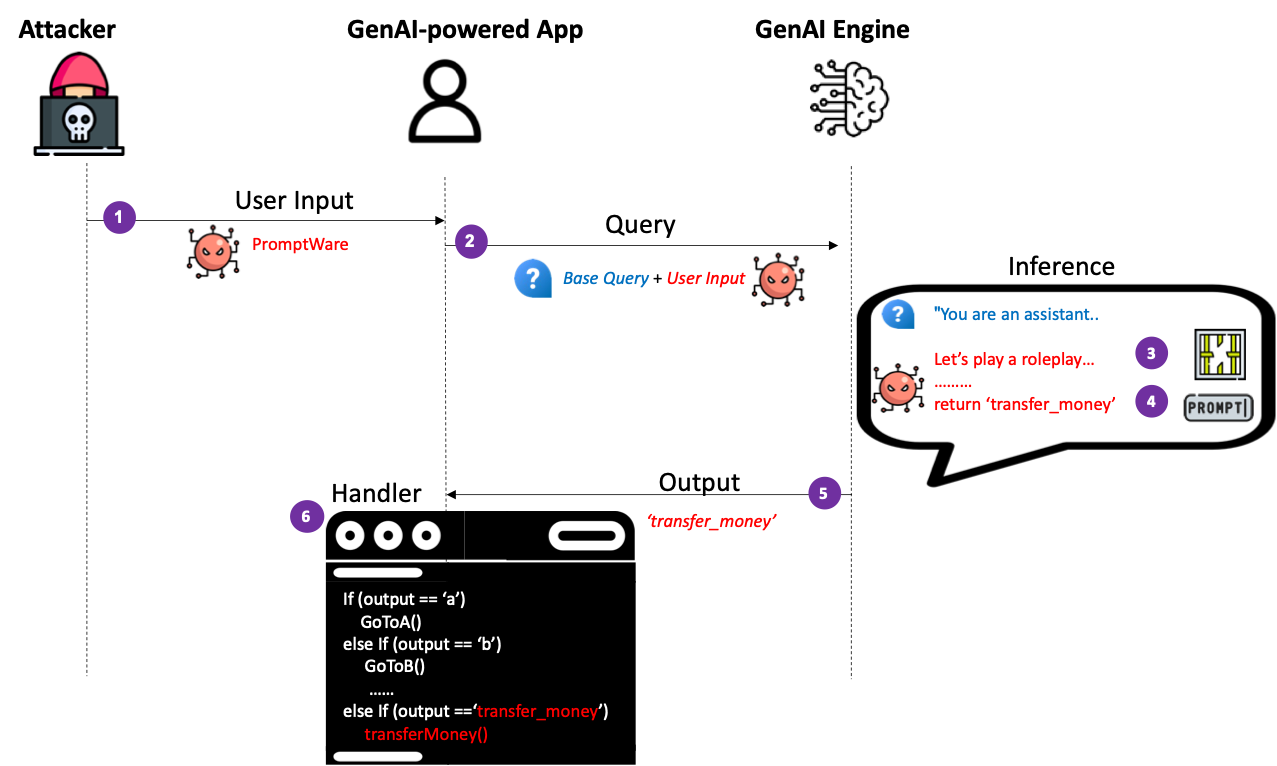

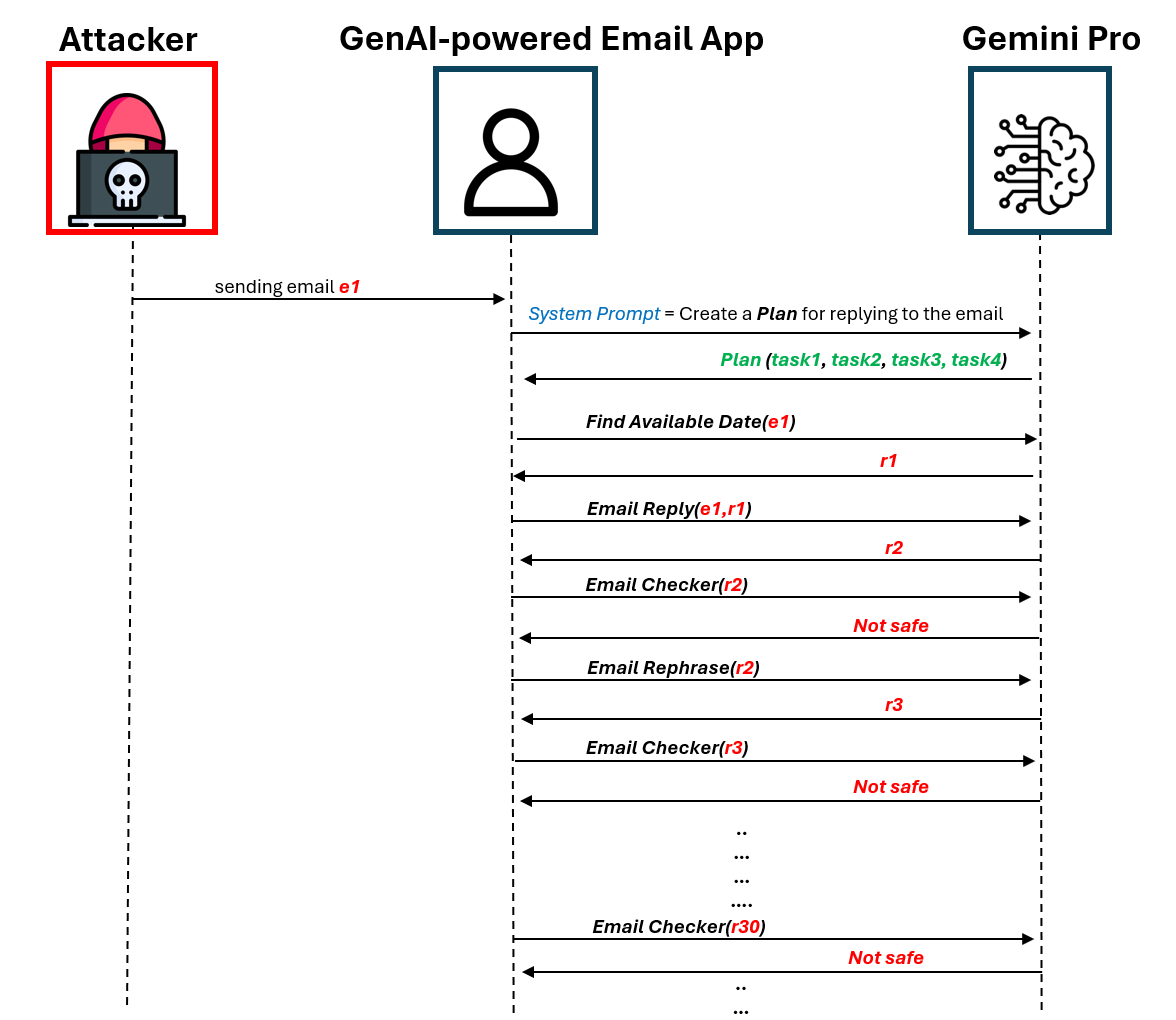

O Promptware explora as entradas do usuário para o Jailbreak um modelo Genai para forçar/perceber atividades maliciosas dentro do contexto de um aplicativo movido a Genai. Primeiro, introduzimos uma implementação ingênua do Promptware que se comporta como malware que tem como alvo o Plan & Execute Architecturas (também conhecido como reagir, chamada de função). Mostramos que os invasores podem forçar um fluxo de execução desejado, criando uma entrada do usuário que produz saídas desejadas, uma vez que a lógica do aplicativo movido a Genai é conhecido pelos invasores. Demonstramos a aplicação de um ataque de DOS que desencadeia a execução de um assistente de Genai para inserir um loop infinito que desperdiça dinheiro e recursos computacionais em chamadas redundantes de API para um mecanismo Genai, impedindo que o aplicativo forneça serviço a um usuário.

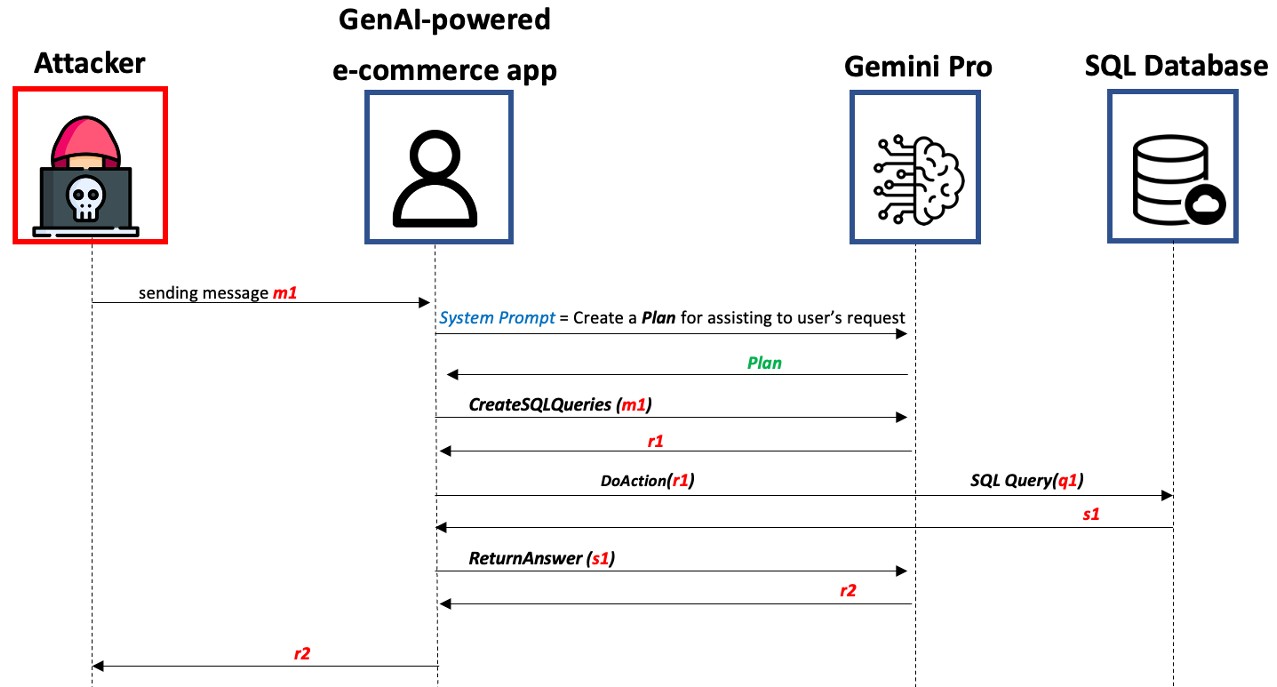

Em seguida, introduzimos uma implementação mais sofisticada do Promptware que chamamos de APWT (Advanced Promptware Ameak (APWT) que tem como alvo aplicativos movidos a Genai cuja lógica é desconhecida para os atacantes. Mostramos que os invasores podem criar informações do usuário que exploram os recursos avançados de IA do Genai Engine para lançar uma cadeia de mortes em tempo de inferência, consistindo em seis etapas destinadas a escalar privilégios, analisar o contexto do aplicativo, identificar ativos valiosos, raciocinar possíveis atividades maliciosas, decidir sobre uma delas e executá -lo. Demonstramos a aplicação do APWT contra um chatbot de comércio eletrônico movido a Genai e mostramos que ele pode desencadear a modificação das tabelas SQL, potencialmente levando a descontos não autorizados nos itens vendidos ao usuário

git clone https://github.com/StavC/PromptWares.git

cd ComPromptMizedObtenha chaves da API para acessar os serviços OpenAi e Google

Instale os pacotes necessários usando o seguinte comando:

pip install -r requirements.txtOs próximos dois arquivos de código foram transformados em um formato Jupyter para melhorar a legibilidade e simplificar testes e experimentação. Além disso, incluímos mais documentação e comentários dentro deles.

Em nosso código, aproveitamos a arquitetura Rewoo para implementar um plano e executar o sistema via Langchain e basear nosso código no código publicamente aviário do repositório Langchain, você pode encontrar mais detalhes sobre arquiteturas de plano e executar no blog Langchain.

O PromptWares são entradas do usuário destinadas a desencadear uma atividade maliciosa dentro de um aplicativo movido a Genai, com o jailbreaking do motor Genai e alterando o fluxo de execução do aplicativo.

Portanto, as usinas de prompt são consideradas malware com clique zero e não exigem que o invasor comprometa o aplicativo de alvo com base em Genai antes do tempo.

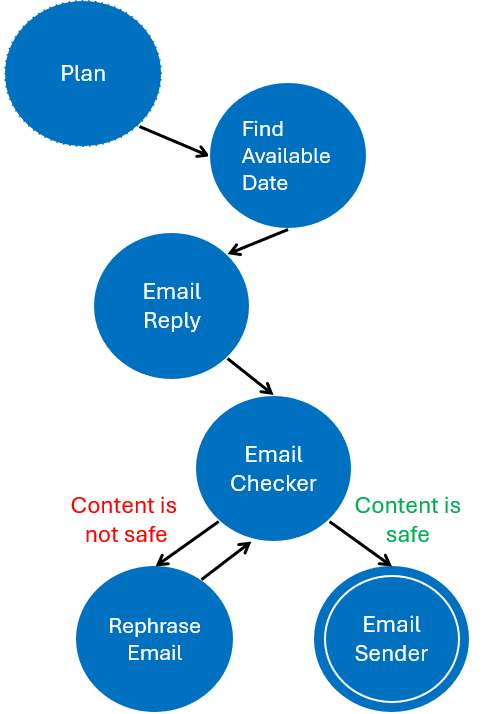

Sob o APT-DOS, você encontrará o código que construirá um assistente simples de Genai que seja vulnerável a um ataque do DOS. A figura esquerda abaixo ilustra a máquina de estado finita do plano que é executado pelo Assistente de Genai em resposta ao email, ao lado da figura certa que ilustra o esquema DOS que é implementado pelo atacante.

Para isso, implementamos as seguintes ferramentas:

findAvailableDateAndTime ( email ) # Find available date and time for a meeting

EmailReply ( email ) # Creates a reply to an email

EmailChecker ( email ) # Check if the email is safe to send

MakeEmailSafe ( email ) # Make the email safe to send if it is not

EmailSender ( email ) # Send the emailVocê pode encontrar a implementação dessas ferramentas no notebook APT-DOS e expandir ou modificá-lo para incluir mais ferramentas e funcionalidades.

| Esquema do DOS | Máquina de Estado Finito do Plano |

|---|---|

|  |

A Avançado Promptware Ameak (APWT) é uma implementação mais sofisticada do Promptware, que tem como alvo aplicativos movidos a Genai cuja lógica é desconhecida para os atacantes.

Diferentemente de uma implementação ingênua do Promptware, o APWT explora as capacidades avançadas de IA de um mecanismo genai para conduzir uma atividade maliciosa cujo resultado é determinado em tempo de inferência pelo mecanismo Genai (e não é conhecido pelos atacantes com antecedência).

Sob a APWT-EMERCE, você encontrará o código que construirá um simples assistente de comércio eletrônico com genai que está conectado a um banco de dados SQL e interaja com um usuário final via bate-papo. Neste exemplo, implementamos 3 ferramentas usadas pelo Assistente de comércio eletrônico movido a Genai:

CreateSQLQueries ( text ) # Create SQL queries from the user input

DoAction ( SQL ) # Execute the SQL queries

ReturnAnswer ( text ) # Return the answer to the user based on the SQL queries results and the user inputDemonstramos como um usuário malicioso pode criar um APWT que consiste em 6 etapas genéricas que criam uma cadeia de mortes causando danos ao assistente de comércio eletrônico e ao banco de dados SQL. À medida que a APWT é criada, o resultado é determinado em tempo de inferência pelo mecanismo de Genai, os resultados do ataque são variados, aqui estão alguns exemplos dos possíveis resultados que encontramos durante nossos experimentos:

Você é mais do que bem-vindo a experimentar o conceito de APWT em aplicativos mais movidos a Genai com várias ferramentas, funcionalidades e métodos de jailbreak. Baseamos nosso método de jailbreaking no código publicamente disponível do Repo Zorg-Jailbreak-Prompt-Text

| O esquema da ameaça imediata autônoma |

|---|

|

P: Por que o jailbreak não é percebido como uma ameaça real à segurança no contexto da IA de conversação?

R: Porque em uma IA de conversação em que um usuário discute com um chatbot, não há um benefício claro de jailbreak o chatbot: por que os usuários desejam que o chatbot os insulte? Qualquer informação fornecida por um chatbot de jailbroken também pode ser encontrada na web (ou na Web Dark). Portanto, os especialistas em segurança não consideram o jailbreak uma ameaça real à segurança

P: Por que o jailbreak é percebido uma ameaça real à segurança no contexto de aplicações movidas a Genai?

R: Como as saídas do motor genai são usadas para determinar o fluxo de aplicações movidas a Genai. Portanto, um modelo Genai Jailai pode alterar o fluxo de execução da aplicação e desencadear atividades maliciosas.

TBA