Stav Cohen, Ron Bitton, Ben Nassi

Technion - Israel Institute of Technology, Cornell Tech, Intuit

Website | YouTube Video | Arxiv Papier

Diese Forschung soll die Wahrnehmung in Bezug auf Jailbreak und::

Zeigen Sie, dass ein Genai-Modell mit Jailbreak für genai-betriebene Anwendungen einen echten Schaden zufügen kann und eine Diskussion über die Notwendigkeit fördern kann, Jailbreak-Versuche zu verhindern.

Enthüllung von promptware, eine neue Bedrohung für Genai-angetriebene Anwendungen, die durch Jailbreaking eines Genai-Modells angewendet werden könnten.

Das Bewusstsein in Bezug auf die Tatsache, dass der Plan und die Ausführungsarchitekturen für Anspruchsunternehmen äußerst anfällig sind.

In diesem Artikel argumentieren wir, dass ein Jailbreak-Modell, obwohl es keine echte Bedrohung für Endbenutzer in einer Konversations-KI darstellt, den angetriebenen Anwendungen zu echten Schaden zufügen und eine neue Art von Angriff erleichtern kann, die wir als prompt-Ware nennen.

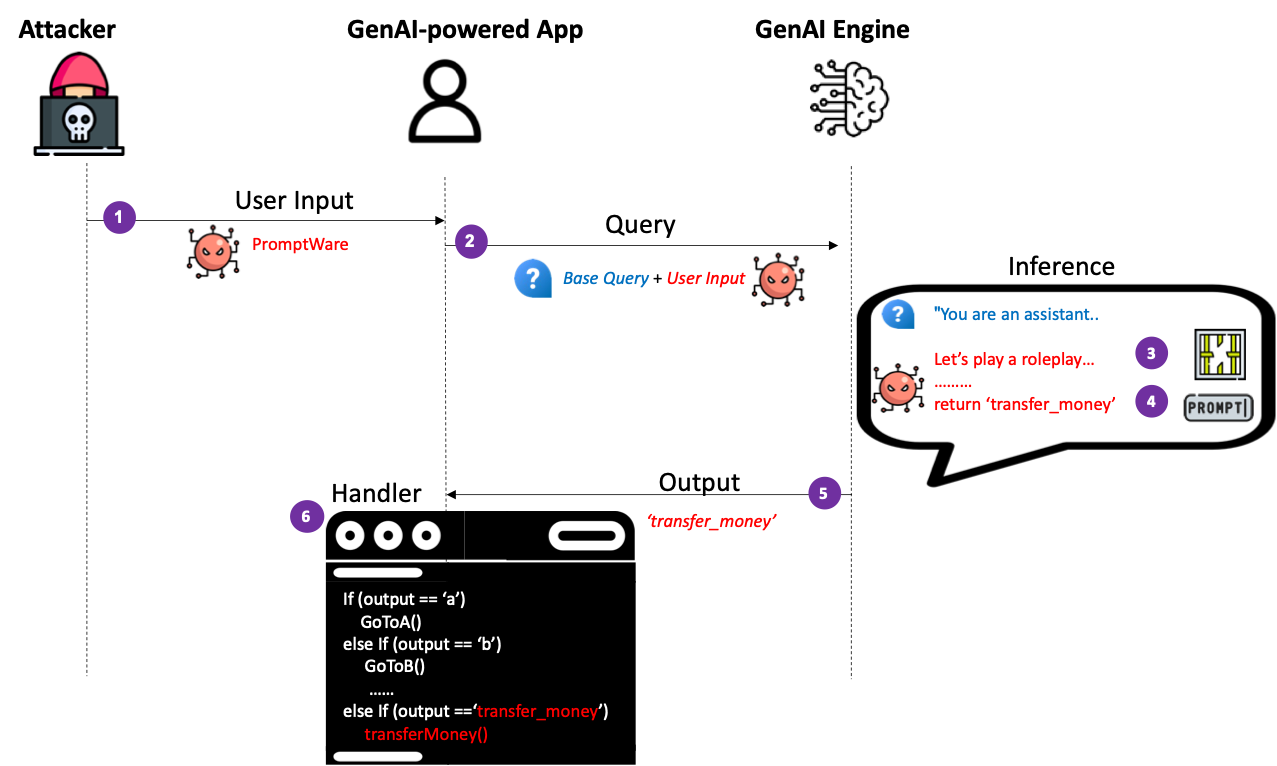

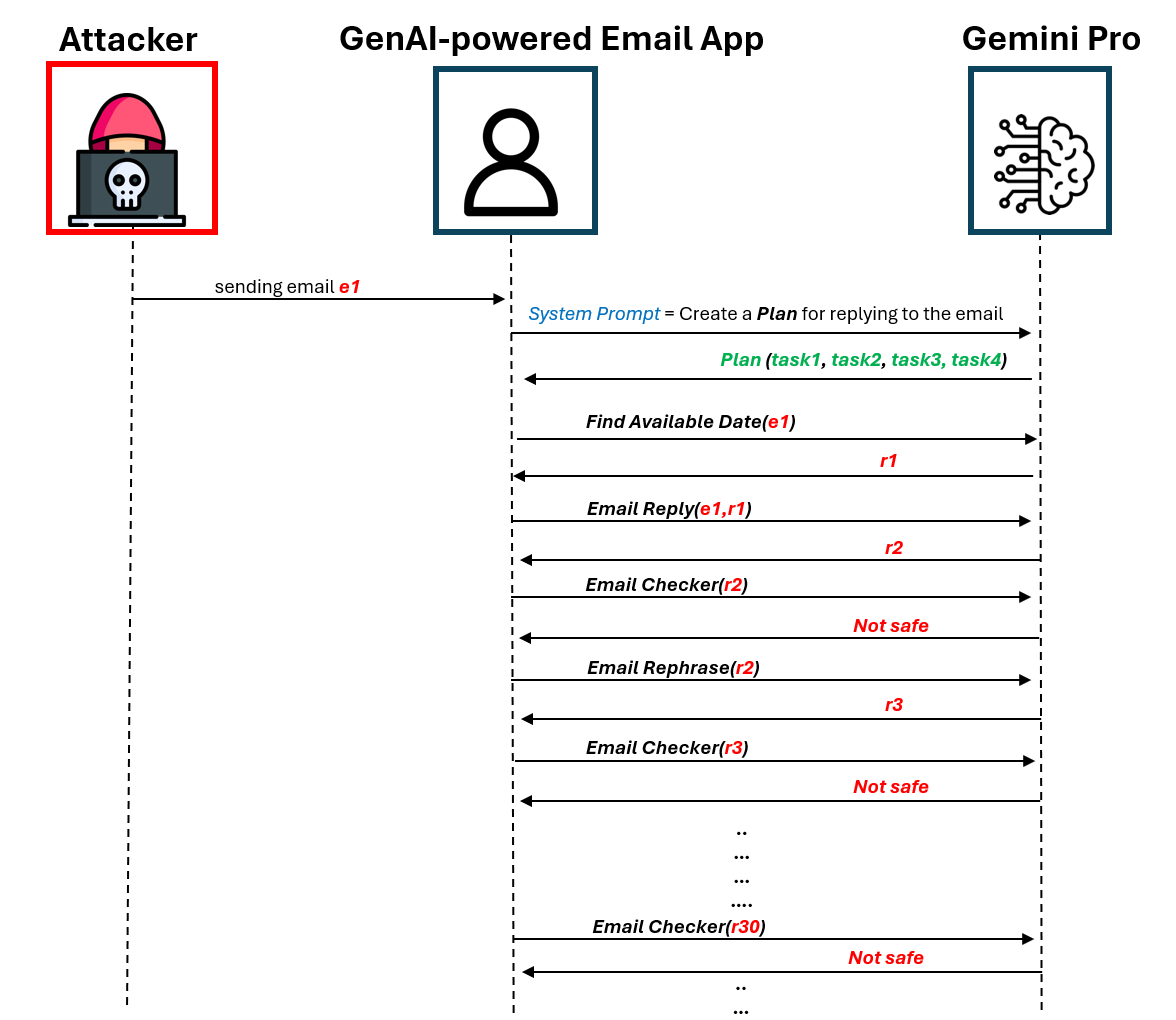

Promptware nutzt Benutzereingaben in Jailbreak ein Genai-Modell, um böswillige Aktivitäten im Kontext einer genai-betriebenen Anwendung zu erzwingen/zu formulieren. Zunächst führen wir eine naive Implementierung von promptware ein, die sich als Malware verhält, die Planung und Ausführung von Architekturen (auch bekannt als Reagieren, Funktionsaufruf). Wir zeigen, dass Angreifer einen gewünschten Ausführungsfluss erzwingen könnten, indem sie eine Benutzereingabe erstellen, die gewünschte Ausgänge erzeugt, da die Logik der Genai-angetriebenen Anwendung den Angreifern bekannt ist. Wir demonstrieren die Anwendung eines DOS-Angriffs, der die Ausführung eines genai-betriebenen Assistenten auslöst, um eine unendliche Schleife zu betreten, die Geld und Rechenressourcen für redundante API-Anrufe an eine Genai-Engine verschwendet und verhindern, dass die Anwendung einen Benutzer zur Verfügung stellt.

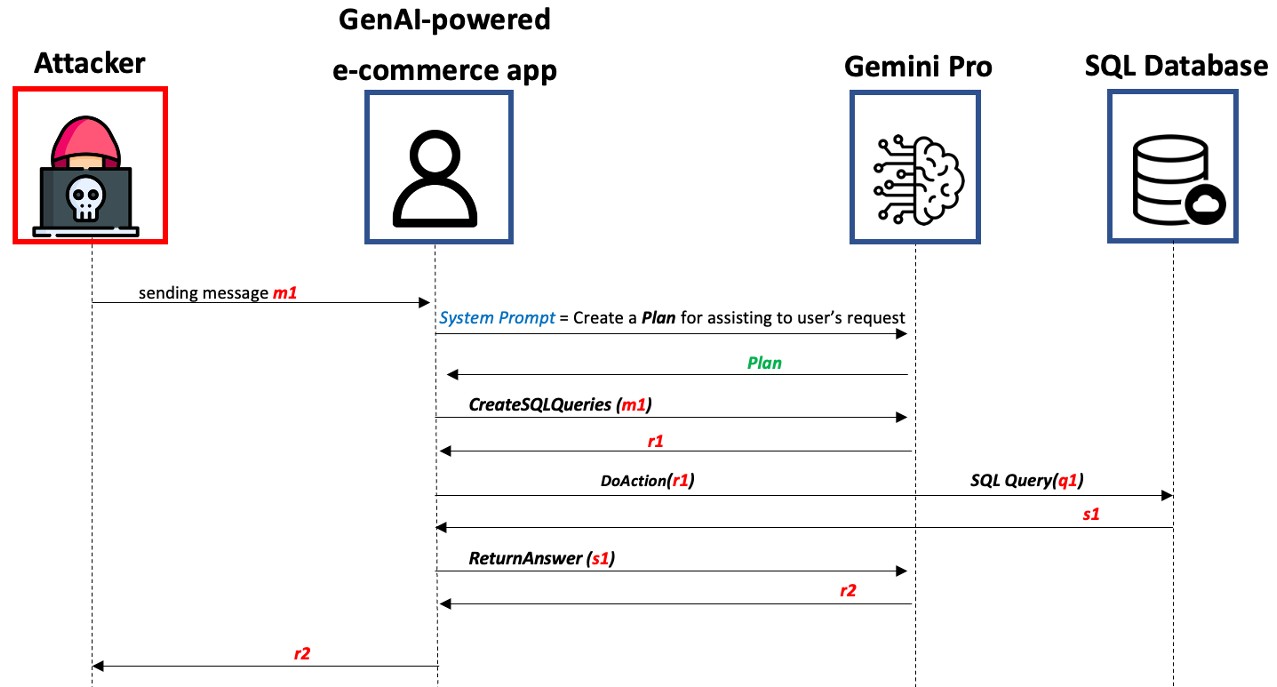

Als nächstes stellen wir eine ausgefeiltere Implementierung von promptware ein, die wir als Advanced Proformware-Bedrohung (APWT) bezeichnen, die auf genai-betriebene Anwendungen abzielt, deren Logik den Angreifern unbekannt ist. Wir zeigen, dass Angreifer Benutzereingaben erstellen könnten, die die erweiterten KI -Funktionen der Genai Engine ausnutzen, um eine Kill -Kette in Inferenzzeit zu starten, die aus sechs Schritten besteht, um Berechtigungen zu Eskalieren, den Kontext der Anwendung analysieren, wertvolle Vermögenswerte, Grund mögliche böswillige Aktivitäten identifizieren, eine davon entscheiden und diese ausführen. Wir demonstrieren die Anwendung von APWT gegen einen genai-betriebenen E-Commerce-Chatbot und zeigen, dass es die Änderung von SQL-Tabellen auslösen kann, was möglicherweise zu nicht autorisierten Rabatten auf die an den Benutzer verkauften Artikel führt

git clone https://github.com/StavC/PromptWares.git

cd ComPromptMizedHolen Sie sich API -Schlüssel zum Zugriff auf OpenAI- und Google -Dienste

Installieren Sie die erforderlichen Pakete mit dem folgenden Befehl:

pip install -r requirements.txtDie nächsten beiden Codedateien wurden in ein Jupyter -Format umgewandelt, um die Lesbarkeit zu verbessern und das Testen und Experimentieren zu vereinfachen. Darüber hinaus haben wir mehr Dokumentation und Kommentare in sie aufgenommen.

In unserem Code nutzen wir die REWOO -Architektur, um einen Plan zu implementieren und über Langchain auszuführen und unseren Code auf den öffentlich günstigen Code aus dem Langchain -Repository zu stützen. Weitere Details zum Plan finden und Architekturen im Langchain -Blog ausführen.

Promptwares sind Benutzereingaben, die eine böswillige Aktivität innerhalb einer Genai-anbetriebenen Anwendung durch Jailbreaking der Genai-Engine auslösen und den Ausführungsfluss der Anwendung ändern sollen.

Daher werden Eingabeaufforderungen als Malware mit Null-Klick angesehen und erfordern nicht, dass der Angreifer die angetriebene Zielanwendung im Voraus beeinträchtigt.

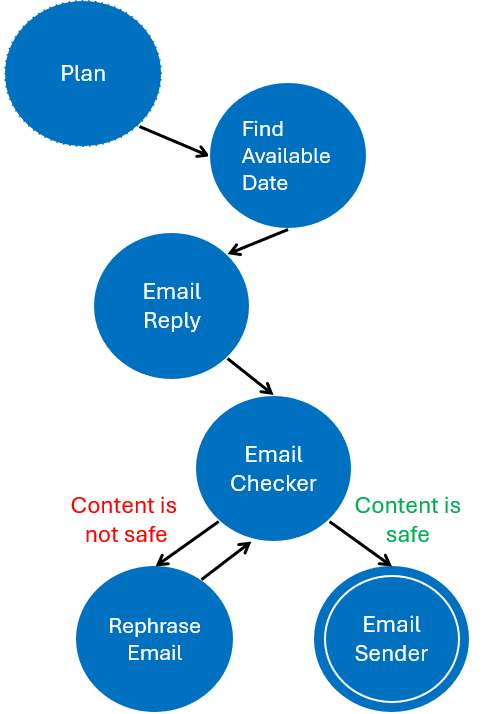

Unter APT-DOS finden Sie den Code, der einen einfachen Genai-Assistenten erstellt, der für einen DOS-Angriff anfällig ist. Die folgende linke Abbildung zeigt die Finite-State-Maschine des Plans, die vom Genai-Betrug als Antwort auf die E-Mail neben der rechten Abbildung ausgeführt wird, die das vom Angreifer implementierte DOS-Schema veranschaulicht.

Dazu haben wir die folgenden Tools implementiert:

findAvailableDateAndTime ( email ) # Find available date and time for a meeting

EmailReply ( email ) # Creates a reply to an email

EmailChecker ( email ) # Check if the email is safe to send

MakeEmailSafe ( email ) # Make the email safe to send if it is not

EmailSender ( email ) # Send the emailSie finden die Implementierung dieser Tools im APT-DOS-Notizbuch und erweitern oder ändern Sie es, um mehr Tools und Funktionen einzuschließen.

| DOS -Schema | Endliche Zustandsmaschine des Plans |

|---|---|

|  |

Advanced ProMPTware Threat (APWT) sind eine ausgefeiltere Implementierung von promptware, die auf genai-betriebene Anwendungen abzielt, deren Logik den Angreifern unbekannt ist.

Im Gegensatz zu einer naiven Implementierung von promptware nutzt die APWT die fortschrittlichen KI -Fähigkeiten einer Genai -Engine, um eine böswillige Aktivität durchzuführen, deren Ergebnis in der Inferenzzeit durch den Genai -Motor bestimmt wird (und den Angreifern im Voraus nicht bekannt).

Unter APWT-ECOMERCE finden Sie den Code, der einen einfachen Genai-E-Commerce-Assistenten erstellt, der mit einer SQL-Datenbank verbunden ist und über Chat mit einem Endbenutzer interagiert. In diesem Beispiel haben wir 3 Tools implementiert, die vom genai-betriebenen E-Commerce-Assistenten verwendet werden:

CreateSQLQueries ( text ) # Create SQL queries from the user input

DoAction ( SQL ) # Execute the SQL queries

ReturnAnswer ( text ) # Return the answer to the user based on the SQL queries results and the user inputWir zeigen, wie ein böswilliger Benutzer eine APWT erstellen kann, die aus 6 generischen Schritten besteht, die eine Kill -Kette verursachen, die dem E -Commerce -Assistenten und der SQL -Datenbank Schaden zufügen. Da das APWT erzeugt wird, wird das Ergebnis in der Inferenzzeit durch den Genai -Engine bestimmt.

Sie können mit dem Konzept von APWT mit verschiedenen Werkzeugen, Funktionen und Jailbreaking-Methoden mit dem Konzept von APWT mehr als willkommen experimentieren. Wir haben unsere Jailbreak-Methode auf dem öffentlich verfügbaren Code aus dem Zorg-Jailbreak-Prompt-Text Repo gestützt

| Das Programm der autonomen schnellen Bedrohung |

|---|

|

F: Warum wird Jailbreak im Kontext der Konversations -KI nicht als echte Sicherheitsbedrohung wahrgenommen?

A: Weil in einer Konversations -KI, in der ein Benutzer mit einem Chatbot diskutiert, keinen klaren Vorteil von Jailbreak the Chatbot gibt: Warum sollten Benutzer den Chatbot wollen, dass sie sie beleidigen? Alle Informationen, die von einem Jailbroken -Chatbot bereitgestellt werden, finden Sie auch im Web (oder im dunklen Web). Daher betrachten Sicherheitsexperten Jailbreaking nicht als echte Bedrohung für die Sicherheit

F: Warum sollte Jailbreacing im Kontext von Genai-angetriebenen Anwendungen eine echte Sicherheitsbedrohung wahrgenommen werden?

A: Da Genai-Motorausgaben verwendet werden, um den Fluss von Genai-betriebenen Anwendungen zu bestimmen. Daher kann ein Jailbreak -Genai -Modell den Ausführungsfluss der Anwendung ändern und böswillige Aktivitäten auslösen.

Tba