Use os modelos poderosos GPT-4, LLAMA-3 e MAIS IA no Raycast, gratuitamente-nenhuma chave da API necessária.

Página inicial · Política de privacidade

"Se você gosta da extensão, considere dar -lhe um Tysm Star!" - o desenvolvedor, provavelmente

Atualmente, esta extensão não está disponível no Raycast Extension Store, mas a instalação da fonte é extremamente simples.

npm ci --production para instalar as dependências necessárias.pip install -r requirements.txt para instalar dependências do Python. Eles são necessários para alguns recursos, por exemplo, pesquisa na web.npm run dev para construir e importar a extensão.A extensão e seu conjunto completo de comandos devem aparecer no aplicativo Raycast.

Por favor, abra um problema se houver problemas inesperados durante a instalação.

Há suporte embutido para atualização dentro da própria extensão! Basta executar o comando "Verificar atualizações" na extensão e ele cuidará do processo de atualização para você. Além disso, você também pode ativar o recurso "Verificar automaticamente as atualizações" nas preferências.

Na linha de comando, execute git pull , npm ci --production e npm run dev (nessa ordem).

Você pode atualizar manualmente se a atualização automática não funcionar (também abra um problema do GitHub, se for esse o caso); A atualização manualmente também permite buscar e visualizar as últimas alterações no código -fonte.

| Provedor | Modelo | Características | Status | Velocidade | Classificação e observações por autor de extensão |

|---|---|---|---|---|---|

| Nexra | GPT-4O (padrão) | Muito rápido | 8.5/10, o modelo de melhor desempenho. | ||

| Nexra | GPT-4-32K | Médio | 6.5/10, sem suporte de streaming, mas, caso contrário, um ótimo modelo. | ||

| Nexra | chatgpt | Muito rápido | 7.5/10 | ||

| Nexra | Bing | Médio | 8/10, GPT-4 com base nos recursos de pesquisa da Web. | ||

| Nexra | LLAMA-3.1 | Rápido | 7/10 | ||

| Nexra | Gemini-1.0-Pro | Rápido | 6.5/10 | ||

| Deepinfra | Meta-llama-3.2-90b-Vision | Rápido | 8.5/10, modelo recente com recursos de visão. | ||

| Deepinfra | Meta-llama-3.2-11b-Vision | Muito rápido | 7.5/10 | ||

| Deepinfra | meta-llama-3.1-405b | Médio | 8.5/10, modelo aberto de última geração, adequado para tarefas complexas. | ||

| Deepinfra | Meta-llama-3.1-70b | Rápido | 8/10, modelo recente com grande tamanho de contexto. | ||

| Deepinfra | Meta-llama-3.1-8b | Muito rápido | 7.5/10, modelo recente com grande tamanho de contexto. | ||

| Deepinfra | LLAMA-3.1-NEMOTRON-70B | Rápido | 8/10 | ||

| Deepinfra | Wizardlm-2-8x22b | Médio | 7/10 | ||

| Deepinfra | Deepseek-V2.5 | Rápido | 7.5/10 | ||

| Deepinfra | QWEN2.5-72B | Médio | 7.5/10 | ||

| Deepinfra | QWEN2.5-CODER-32B | Rápido | 7/10 | ||

| BlackBox | modelo personalizado | Rápido | 7.5/10, geração muito rápida com capacidade de pesquisa na web interna, mas é otimizada para codificação. | ||

| BlackBox | LLAMA-3.1-405B | Rápido | 8.5/10 | ||

| BlackBox | LLAMA-3.1-70B | Muito rápido | 8/10 | ||

| BlackBox | Gemini-1.5-Flash | Extremamente rápido | 7.5/10 | ||

| BlackBox | GPT-4O | Muito rápido | 7.5/10 | ||

| BlackBox | Claude-3.5 SONET | Rápido | 8.5/10 | ||

| BlackBox | Gemini-Pro | Rápido | 8/10 | ||

| Duckduckgo | GPT-4O-MINI | Extremamente rápido | 8/10, modelo autêntico GPT-4O-Mini com forte privacidade. | ||

| Duckduckgo | Claude-3-Haiku | Extremamente rápido | 7/10 | ||

| Duckduckgo | Meta-llama-3.1-70b | Muito rápido | 7.5/10 | ||

| Duckduckgo | Mixtral-8x7b | Extremamente rápido | 7.5/10 | ||

| Bestim | GPT-4O-MINI | Extremamente rápido | 8.5/10 | ||

| Pedras | Claude-3.5 SONET | Rápido | 8.5/10 | ||

| Pedras | Claude-3-opus | Rápido | 8/10 | ||

| Pedras | GPT-4O | Rápido | 7.5/10 | ||

| Pedras | GPT-4 | Rápido | 7.5/10 | ||

| Pedras | LLAMA-3.1-405B | Rápido | 7.5/10 | ||

| Pedras | LLAMA-3.1-70B | Muito rápido | 7/10 | ||

| ChatgptFree | GPT-4O-MINI | Extremamente rápido | 8.5/10 | ||

| Ai4chat | GPT-4 | Muito rápido | 7.5/10 | ||

| Darkai | GPT-4O | Muito rápido | 8/10 | ||

| Mhystical | GPT-4-32K | Muito rápido | 6.5/10 | ||

| Pizzagpt | GPT-4O-MINI | Extremamente rápido | 7.5/10 | ||

| Meta ai | meta-llama-3.1 | Médio | 7/10, modelo recente com acesso à Internet. | ||

| Replicar | Mixtral-8x7b | Médio | ?/10 | ||

| Replicar | meta-llama-3.1-405b | Médio | ?/10 | ||

| Replicar | meta-llama-3-70b | Médio | ?/10 | ||

| Replicar | meta-llama-3-8b | Rápido | ?/10 | ||

| Phind | Phind instant | Extremamente rápido | 8/10 | ||

| Google Gemini | Auto (Gemini-1.5-Pro, Gemini-1.5-Flash) | Muito rápido | 9/10, modelo geral muito bom, mas requer uma chave da API. (É grátis , veja a seção abaixo) | ||

| GPT4Free API local | - | - | permite o acesso a uma grande variedade de fornecedores. Leia mais | ||

| API local de Ollama | - | - | permite a inferência local. Leia mais | ||

| API personalizada compatível com o OpenAI | - | - | Permite usar qualquer API personalizada compatível com o OpenAI. Leia mais |

? - suporta o upload do arquivo. Nota : Por padrão, todos os provedores suportam funcionalidade básica de upload de arquivos para arquivos baseados em texto, como .txt, .md, etc.

¹: suporta apenas imagens.

O limite de taxa para o Google Gemini é de 1500 solicitações por dia (até o momento da redação). Isso deve ser muito mais do que suficiente para qualquer uso normal. Se o seu caso de uso precisar de um limite de taxa aumentado, você poderá criar várias teclas de API com diferentes contas do Google; Separe -os com vírgulas nas preferências.

Deixe o GPT decidir pesquisar informações da Web se ela não tiver conhecimento ou contexto suficientes. Usa a pesquisa do DuckDuckgo, rápida e gratuita.

Ativar pesquisa na web é rápido e fácil. Vá para as preferências de extensão e a opção "Pesquisa da Web" estará disponível. Existem 4 opções:

Comandos: Os comandos que suportam a pesquisa na Web são: Ask AI, pergunte sobre o texto selecionado, explique. Outros comandos não usarão a pesquisa na web.

A pesquisa na web também está disponível nos seguintes comandos:

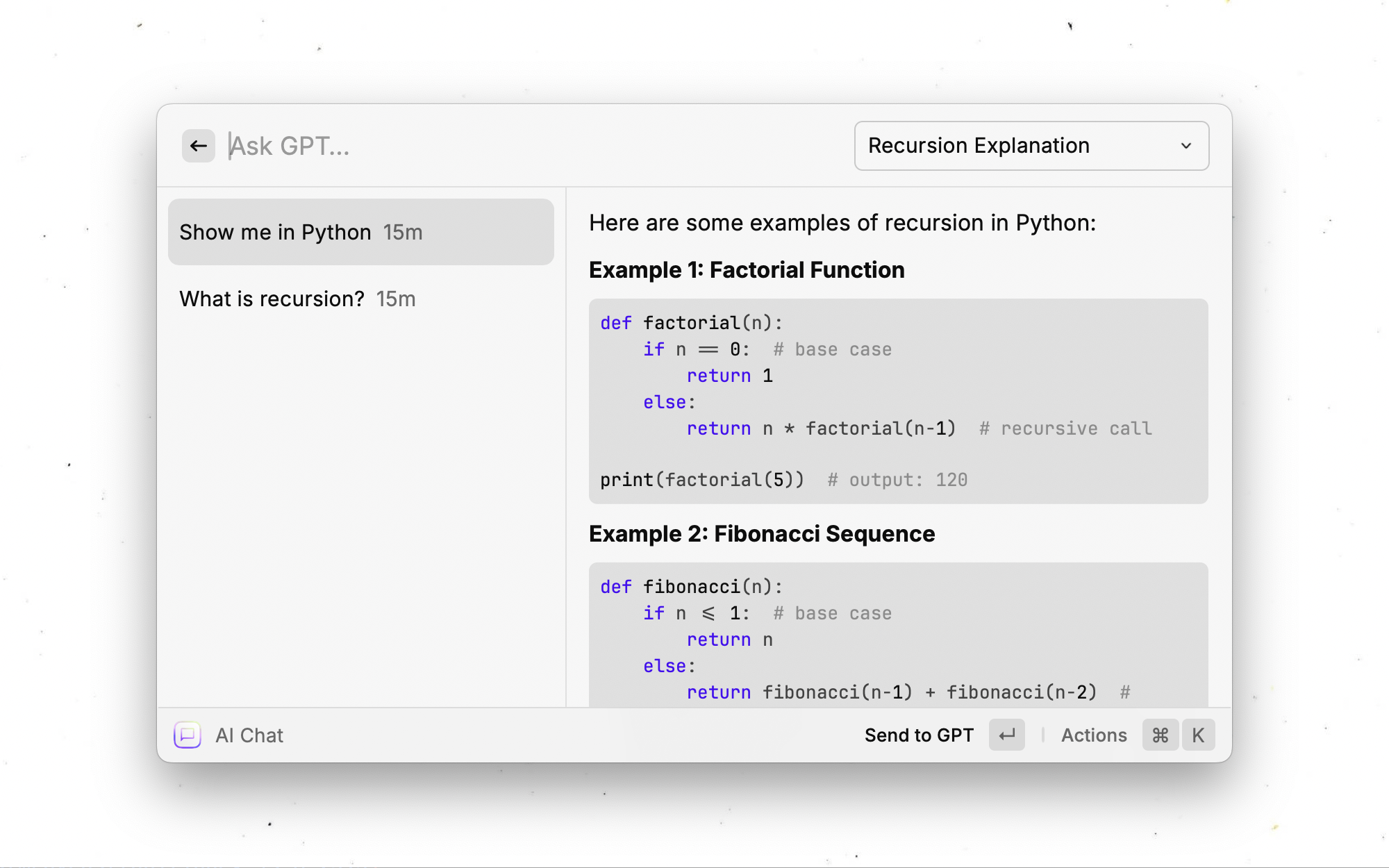

Deixe o GPT obter automaticamente um nome para a sessão de bate -papo atual depois de enviar a primeira mensagem. Por exemplo, isso é semelhante ao que a interface do usuário da Web ChatGPT faz.

Deixe a extensão verificar automaticamente se há atualizações todos os dias. Se uma nova versão estiver disponível, você será notificado, juntamente com a opção de atualizar a extensão com um único clique.

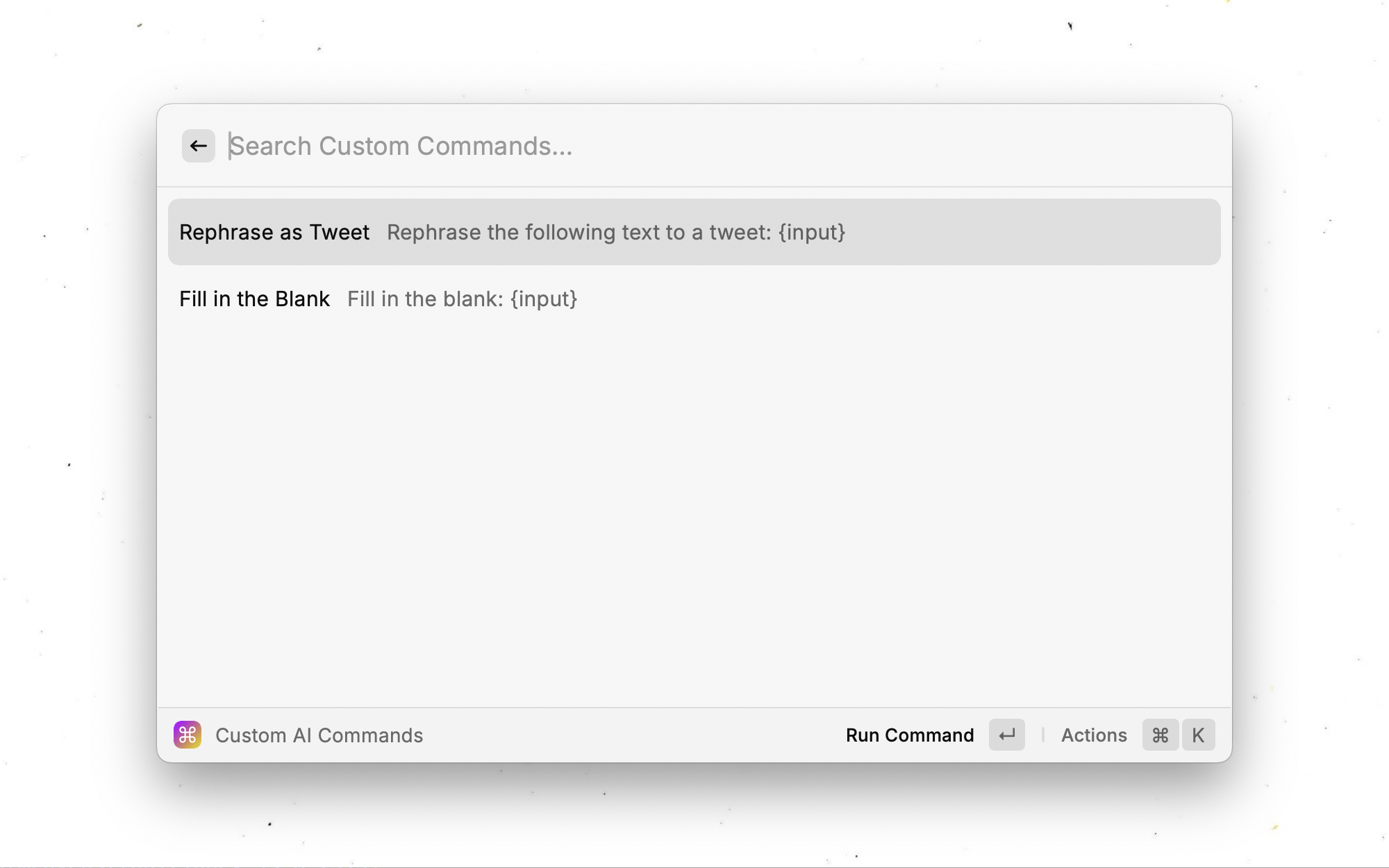

Habilite o armazenamento mais persistente dos dados da extensão, como dados de bate -papo da AI ou comandos personalizados. Isso fará backup de uma cópia desses dados para arquivos no seu computador. Útil para salvar grandes quantidades de dados. Nota: Com esta opção desligada, seus dados já estão bem preservados. Não habilite isso se você tiver dados confidenciais.

Mostre um ícone do cursor quando a resposta estiver carregando - apenas opção cosmética.

Permite que o GPT execute o código Python localmente. O modelo foi instruído a produzir estritamente apenas código seguro, mas use por sua conta e risco!

Somente modelos com recursos de chamada de função suportam esse recurso. Atualmente, isso inclui apenas modelos de Deepinfra selecionados.

Licença: GPLV3. A licença completa é encontrada no License.txt.

A base de código é derivada de Raycast Gemini, de Evan Zhou.

Bibliotecas de terceiros usadas para geração:

(Ambos os pacotes são mantidos pelo autor de extensão.)

Alguns do código deste repositório foram inspirados ou portados do projeto GPT4Free original (escrito em Python).