Inglês |

A maioria dos clientes do OpenAI não oferece suporte ao serviço Azure OpenAi, mas a ligação e a ligação do cartão do serviço Azure OpenAi são muito simples e também há um limite de crédito gratuito. Este script usa o Free CloudFlare Worker como um proxy, permitindo que os clientes habilitados para o OpenAI usem o serviço do Azure Openai diretamente.

Adicionar subclasses de modelo é muito fácil, consulte as seguintes instruções para uso

Proxy Open Solicitações ao serviço Azure OpenAi, Etapas de implantação de código:

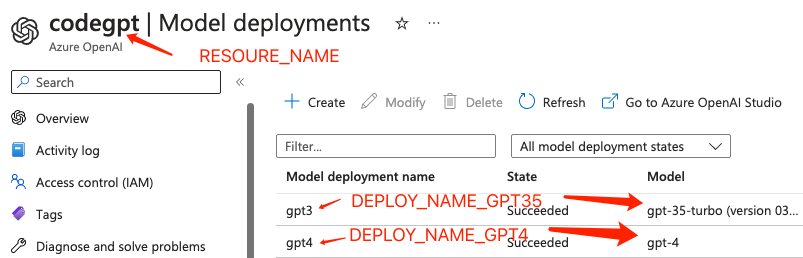

Primeiro, obtenha o nome do nome do recurso e o mapeador de implantação e faça login no fundo do Azure:

// The name of your Azure OpenAI Resource.

const resourceName = "codegpt"

// deployment model mapper

const mapper = {

'gpt-3.5-turbo' : 'gpt3' ,

'gpt-4' : 'gpt4' ,

'dall-e-3' : 'dalle3'

} ;

其他的map规则直接按这样的格式续写即可Ou através do console do CloudFlare Worker, vá para o script dos trabalhadores> Configurações> Adicionar variável em variáveis de ambiente.

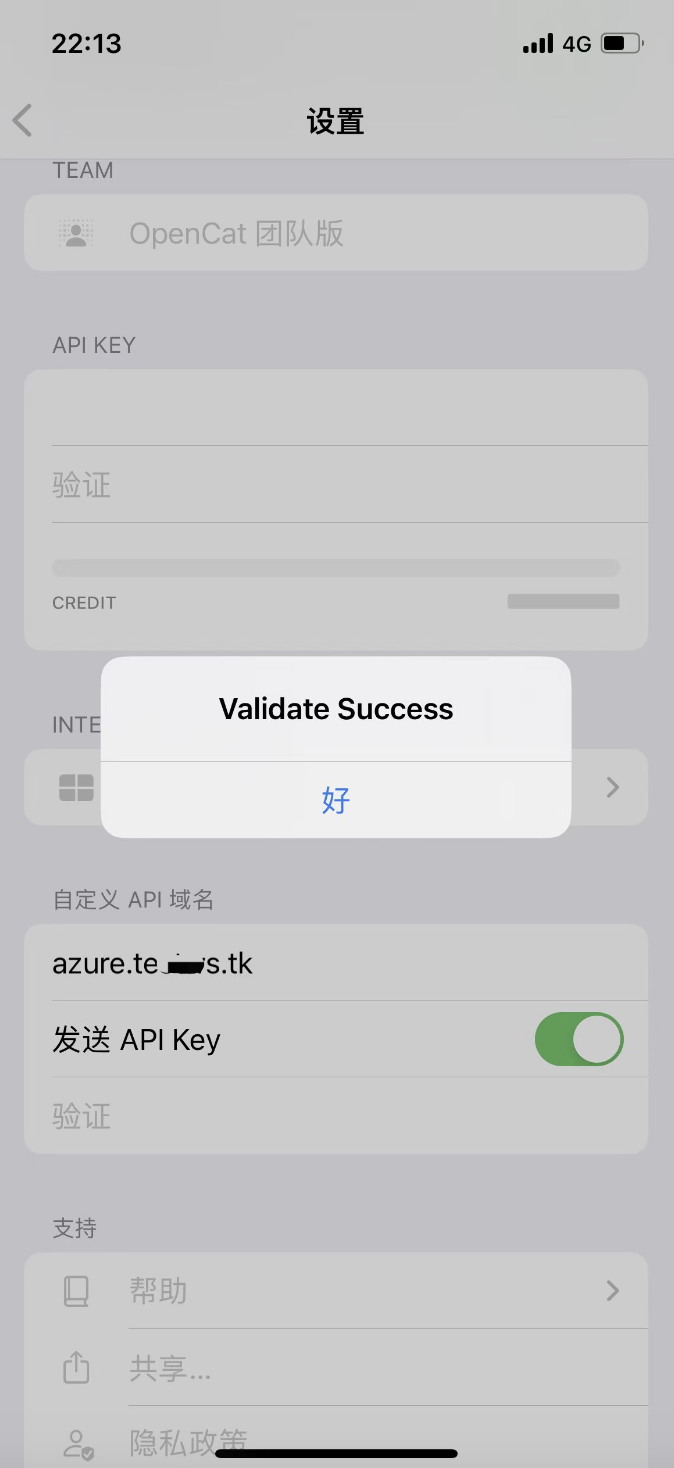

Tomando OpenCat como exemplo: Nome de domínio da API personalizado preenchendo o nome de domínio vinculado na sexta etapa:

Eu tentei vários clientes e, se encontrar problemas com outros clientes, congratulo -me com um problema.