Anglais |

La plupart des clients OpenAI ne prennent pas en charge le service Azure OpenAI, mais la liaison de l'application et de la carte du service Azure OpenAI sont très simples, et il existe également une limite de crédit gratuite. Ce script utilise le travailleur CloudFlare gratuit comme proxy, permettant aux clients compatibles OpenAI d'utiliser directement le service Azure Openai.

L'ajout de sous-classes du modèle est très facile, reportez-vous aux instructions suivantes à utiliser

Demandes d'Openai proxy au service Azure Openai, étapes de déploiement de code:

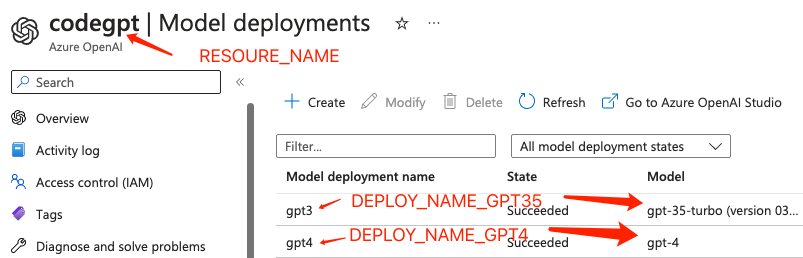

Obtenez d'abord ResourceName et déploiement du mappeur et connectez-vous à l'arrière-plan d'Azure:

// The name of your Azure OpenAI Resource.

const resourceName = "codegpt"

// deployment model mapper

const mapper = {

'gpt-3.5-turbo' : 'gpt3' ,

'gpt-4' : 'gpt4' ,

'dall-e-3' : 'dalle3'

} ;

其他的map规则直接按这样的格式续写即可Ou via la console de travail CloudFlare, accédez à Script des travailleurs> Paramètres> Ajouter une variable dans les variables d'environnement.

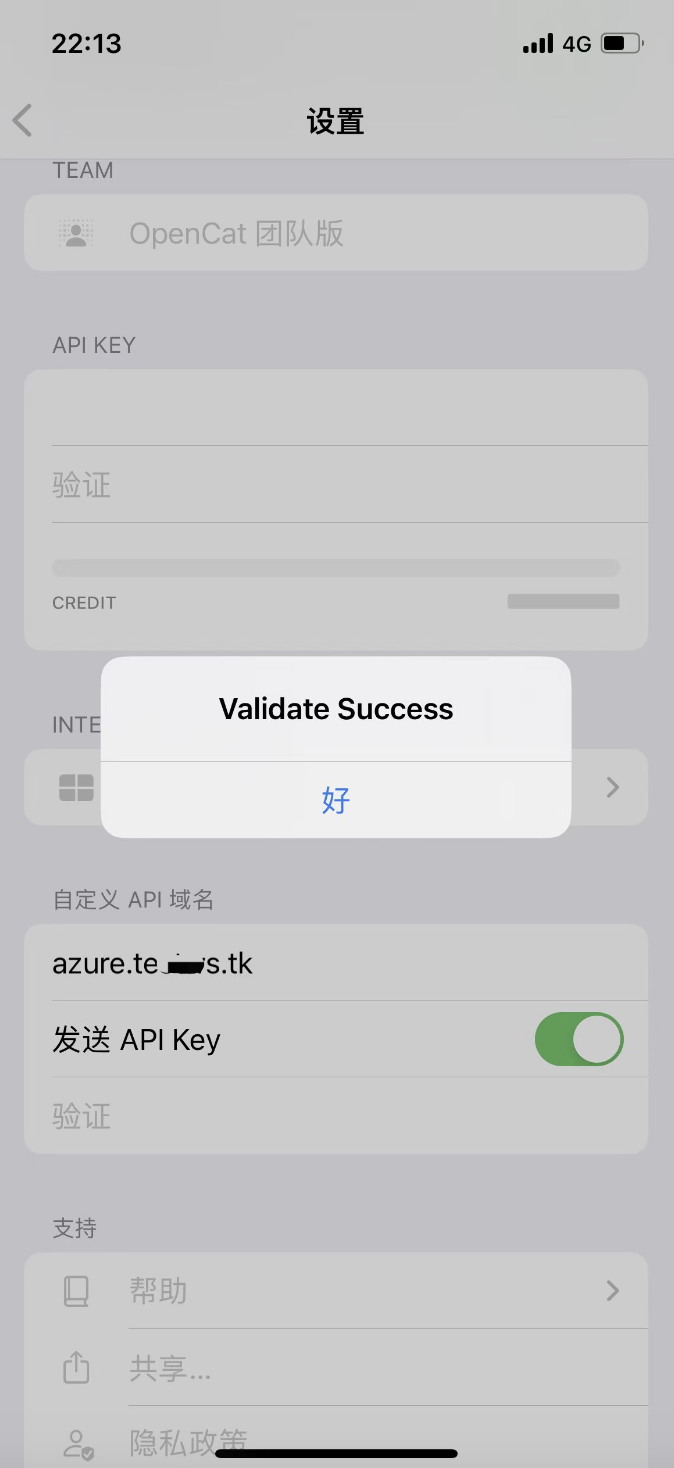

Prendre OpenCat comme exemple: nom de domaine API personnalisé remplissant le nom de domaine lié dans la sixième étape:

J'ai essayé plusieurs clients, et si je rencontre des problèmes avec d'autres clients, je me réjouis de créer un problème.