최근 Alibaba Tongyi Lab은 시각적 문서 이해를 위해 특별히 설계된 Search Enhanced Generation (RAG) 시스템 인 최신 R & D 결과 인 Vidorag의 오픈 소스를 발표했습니다. GPT-4O 모델에 대한 Vidorag의 테스트에 따르면 정확도 속도는 79.4%에 도달했으며 이는 전통적인 RAG 시스템보다 10% 이상 높았습니다. 이 획기적인 획기적인 것은 시각적 문서 처리 분야의 중요한 단계를 나타내며 복잡한 문서 이해에 인공 지능을 적용 할 수있는 새로운 가능성을 제공합니다.

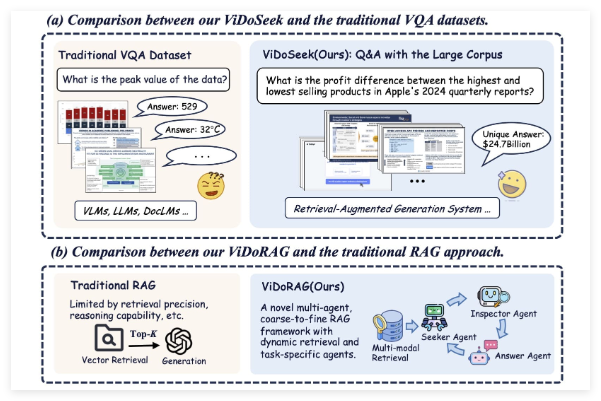

Vidorag는 전통적인 단일 모델은 아니지만 혁신적인 다중 에이전트 프레임 워크 설계를 채택합니다. 이 시스템은 GMM (가우스 하이브리드 모델)을 기반으로 한 동적 반복 추론 제와 하이브리드 검색 기술을 결합합니다. 이 접근법을 통해 Vidorag는 이미지와 텍스트가 포함 된 시각적 문서를 처리 할 때보다 정확하게 주요 정보를 추출하고 추론 할 수 있습니다. 텍스트 검색에만 의존하는 전통적인 RAG 시스템의 한계와 비교하여 Vidorag는 멀티 모달 데이터 융합을 통해 성능을 크게 향상시킵니다.

Tongyi Lab은 공개 된 논문 및 코드 저장소에서 Vidorag가 어떻게 작동하는지 자세히 설명합니다. 그것의 핵심은 여러 에이전트의 협업을 통해 검색 및 생성 프로세스를 동적으로 조정하여 복잡한 시나리오에서 "환상"현상을 줄이고 (즉, 모델이 부정확하거나 제작 된 컨텐츠를 생성 함) 답변의 신뢰성 및 상황에 맞는 관련성을 향상시킵니다.

이 시스템은 GPT-4O에서 79.4%의 정확도를 가지고 있으며, 이는 탁월한 성능을 보여줄뿐만 아니라 전통적인 래그 시스템과 비교하는 그림입니다. 전통적인 래그 시스템은 텍스트 생성 작업에서 잘 수행되지만 시각적 문서를 처리 할 때 단일 모드의 검색 능력으로 제한되며 정확도는 일반적으로 낮은 수준에서 호흡됩니다. Vidorag는 시각 정보 및 텍스트 정보의 깊은 통합을 도입하여 정확도를 10 % 이상 포인트 이상 증가 시켰습니다. 이러한 발전은 법적 문서 분석, 의료 보고서 해석 및 엔터프라이즈 데이터 처리와 같은 고정밀 문서 이해가 필요한 시나리오에 큰 중요합니다.

Alibaba Tongyi Lab의 오픈 소스 Vidorag로의 이동은 트위터에서 열렬한 토론을 촉발했습니다. 사용자는이 시스템의 공개가 AI 분야에서 알리바바의 기술적 강점을 반영 할뿐만 아니라 글로벌 개발자 및 연구원에게 귀중한 자원을 제공한다고 생각합니다. 공개 논문 및 코드 (관련 링크가 트위터 게시물에서 공유됨)를 통해 Vidorag는 시각적 문서 Rag 기술의 연구 및 적용을 가속화하고 멀티 모달 AI 시스템의 추가 개발을 촉진 할 것으로 예상됩니다.

Vidorag의 릴리스 및 오픈 소스는 의심 할 여지없이 Rag 기술을위한 새로운 방향을 열었습니다. 시각적 문서 처리에 대한 수요가 증가함에 따라 Vidorag의 출현은 시작 일 수 있으며, 앞으로 더 유사한 혁신적인 시스템이 등장 할 수 있습니다.

프로젝트 : https://github.com/alibaba-nlp/vidorag