最近、Alibaba Tongyi Labは、視覚文書の理解のために特別に設計された検索拡張ジェネレーション(RAG)システムである最新のR&D結果-Vidoragのオープンソースを発表しました。 GPT-4OモデルでのVidoragのテストは、その精度率が印象的な79.4%に達し、従来のRAGシステムより10%以上高いことを示しました。このブレークスルーは、視覚文書処理の分野における重要なステップを示し、複雑な文書の理解における人工知能を適用するための新しい可能性を提供します。

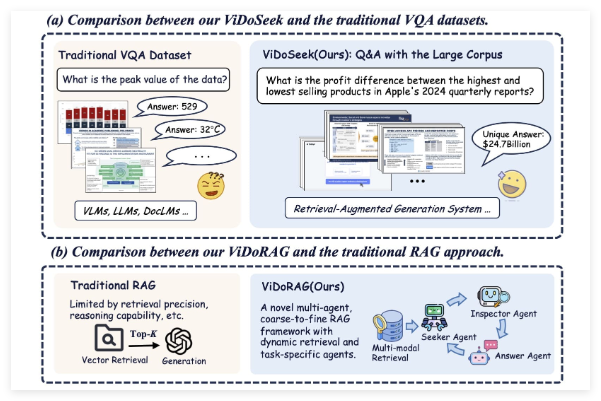

Vidoragは従来の単一モデルではありませんが、革新的なマルチエージェントフレームワーク設計を採用しています。このシステムは、GMM(ガウスハイブリッドモデル)に基づいた動的反復推論エージェントとハイブリッド検索技術を組み合わせています。このアプローチにより、Vidoragは、画像とテキストを含む視覚ドキュメントを処理する際に、キー情報をより正確に抽出および検討することができます。テキストの取得のみに依存する従来のRAGシステムの制限と比較して、Vidoragはマルチモーダルデータ融合によりパフォーマンスを大幅に向上させます。

Tongyi Labは、Vidoragが公開された論文とコードリポジトリでどのように機能するかを詳細に説明しています。そのコアは、複数のエージェントのコラボレーションを通じて検索と生成のプロセスを動的に調整し、それにより複雑なシナリオで「幻想」現象を減らし(つまり、モデルが不正確または製造されたコンテンツを生成します)、回答の信頼性とコンテキスト関連性を改善します。

このシステムの精度は、GPT-4Oで79.4%であり、その優れたパフォーマンスを実証するだけでなく、従来のRAGシステムとも比較する数字です。従来のRAGシステムはテキスト生成タスクでうまく機能しますが、視覚ドキュメントを処理する際の単一モードの検索能力に制限されていることが多く、通常は低レベルでホバリングします。 Vidoragは、視覚情報とテキスト情報の深い統合を導入することにより、精度率を10パーセントポイント以上増やしました。この進歩は、法的文書分析、医療報告書の解釈、企業データ処理など、高精度の文書理解を必要とするシナリオにとって非常に重要です。

Alibaba Tongyi LabのオープンソースVidoragへの動きは、Twitterでの激しい議論も引き起こしました。ユーザーは、このシステムの開示は、AIの分野でのアリババの技術的強さを反映しているだけでなく、グローバルな開発者と研究者に貴重なリソースを提供すると考えています。パブリックペーパーやコード(関連するリンクがTwitterの投稿で共有されている)を通じて、Vidoragは視覚文書RAGテクノロジーの研究と適用を加速し、マルチモーダルAIシステムのさらなる開発を促進することが期待されています。

Vidoragのリリースとオープンソースは、間違いなくRAGテクノロジーの新しい方向性を開きました。視覚文書処理の需要の増加に伴い、Vidoragの出現はほんの始まりに過ぎない可能性があり、将来、より類似した革新的なシステムが出現する可能性があります。

プロジェクト:https://github.com/alibaba-nlp/vidorag