Récemment, Alibaba Tongyi Lab a annoncé l'open source de son dernier résultat de R&D - Vidorag, un système de génération amélioré (RAG) de recherche conçu spécifiquement pour la compréhension des documents visuels. Le test de Vidorag sur le modèle GPT-4O a montré que son taux de précision a atteint un impressionnant 79,4%, ce qui est plus de 10% plus élevé que les systèmes de chiffon traditionnels. Cette percée marque une étape importante dans le domaine du traitement des documents visuels et offre de nouvelles possibilités pour l'application de l'intelligence artificielle dans la compréhension des documents complexes.

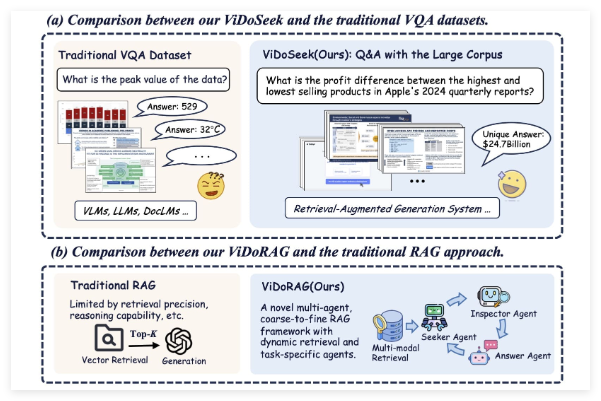

Vidorag n'est pas un modèle unique traditionnel, mais adopte une conception de cadre innovante multi-agents. Le système combine des agents d'inférence itératifs dynamiques et une technologie de récupération hybride basée sur GMM (modèle hybride gaussien). Cette approche permet à Vidorag d'extraire et de déduire les informations clés plus précisément lors du traitement des documents visuels contenant des images et du texte. Par rapport aux limites des systèmes de chiffons traditionnels reposant uniquement sur la récupération de texte, Vidorag améliore considérablement les performances grâce à la fusion de données multimodales.

Tongyi Lab décrit en détail comment Vidorag fonctionne dans ses articles publiés et son référentiel de code. Son cœur réside dans l'ajustement dynamiquement du processus de recherche et de génération à travers la collaboration de plusieurs agents, réduisant ainsi les phénomènes "illusion" dans des scénarios complexes (c'est-à-dire que le modèle génère un contenu inexact ou fabriqué) et l'amélioration de la fiabilité et de la pertinence contextuelle des réponses.

Le système a une précision de 79,4% sur GPT-4O, un chiffre qui démontre non seulement ses excellentes performances, mais la compare également aux systèmes de chiffon traditionnels. Bien que les systèmes de chiffons traditionnels fonctionnent bien dans les tâches de génération de texte, elles sont souvent limitées à la capacité de récupération d'un seul mode lors du traitement des documents visuels, et leur précision plane généralement à un niveau bas. Vidorag a augmenté le taux de précision de plus de 10 points de pourcentage en introduisant une intégration profonde des informations visuelles et des informations textuelles. Cette progression est très importante pour les scénarios qui nécessitent une compréhension des documents de haute précision, tels que l'analyse des documents juridiques, l'interprétation des rapports médicaux et le traitement des données de l'entreprise.

Le mouvement de Alibaba Tongyi Lab vers l'open source Vidorag a également déclenché des discussions animées sur Twitter. Les utilisateurs pensent que la divulgation de ce système reflète non seulement la force technique d'Alibaba dans le domaine de l'IA, mais fournit également une ressource précieuse pour les développeurs et les chercheurs mondiaux. Grâce aux articles publics et aux codes (les liens pertinents ont été partagés dans les publications Twitter), Vidorag devrait accélérer la recherche et l'application de la technologie visuelle des chiffons de documents et promouvoir le développement ultérieur de systèmes d'IA multimodaux.

La sortie et l'open source de Vidorag ont sans aucun doute ouvert de nouvelles directions pour la technologie des chiffons. Avec la demande croissante de traitement des documents visuels, l'émergence de Vidorag peut être le début, et nous pouvons voir des systèmes innovants plus similaires émerger à l'avenir.

Projet: https://github.com/alibaba-nlp/vidorag