인공 지능 분야에서 SULMS (Speech -Prehension Language Models)의 빠른 발전은 광범위한 관심을 끌었습니다. 노스 웨스턴 폴리 테크닉 대학 ASLP Laboratory는 최근 오픈 스피치 이해 모델 OSUM을 발표하여 학업 자원이 제한 될 때 학술 커뮤니티의 연구 및 혁신을 효과적으로 훈련시키고 활용하는 방법을 탐구하는 것을 목표로했습니다.

OSUM 모델은 Whisper Encoder와 QWEN2 언어 모델을 결합하고 음성 인식 (ASR), SRWT (Timestamped Speech 인식), 음성 이벤트 탐지 (SER), SPR (Speech Emotion Recognition), 음성 스타일 인식 (SSR), SPERER Gender Classification (SGC), SPEER AGE PRESTICT (SAP) 및 Stofe-to-to-to-to-to-to-to-to-to-to-to-to-to-to-the chat을 포함한 8 개의 음성 작업을 지원합니다. ASR+X 교육 전략을 채택 함으로써이 모델은 대상 작업을 수행하면서 음성 인식을 효율적으로 최적화하여 멀티 태스킹 학습의 능력을 향상시킬 수 있습니다.

OSUM 모델의 출시는 성능에 중점을 둘뿐만 아니라 투명성을 강조합니다. 교육 방법과 데이터 준비 프로세스는 학계에 귀중한 참조와 지침을 제공하기 위해 열렸습니다. Technical Report v2.0에 따르면 OSUM 모델의 교육 데이터의 양은 50.5k 시간으로 증가하여 이전 44.1k 시간보다 상당히 높았습니다. 그중에는 3000 시간의 음성 성 분류 데이터와 6800 시간의 스피커 연령 예측 데이터가 포함됩니다. 이러한 데이터의 확장으로 인해 다양한 작업에서 모델이 더 나은 성능을 발휘할 수 있습니다.

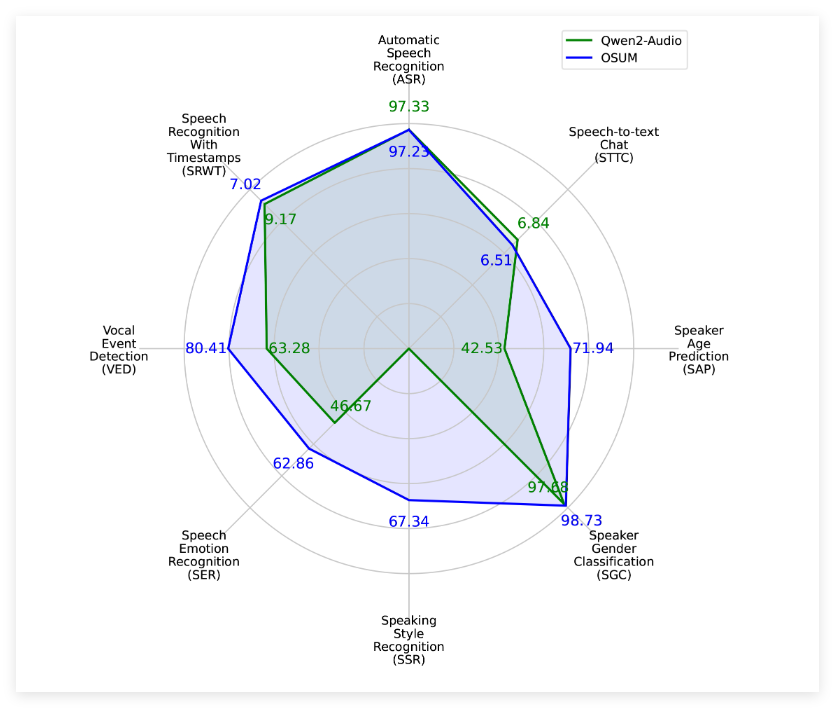

평가 결과에 따르면 OSUM은 컴퓨팅 리소스 및 교육 데이터가 훨씬 적더라도 여러 작업에서 QWEN2-AUDIO 모델보다 낫습니다. 관련 평가 결과는 공개 테스트 세트뿐만 아니라 내부 테스트 세트도 포함하여 음성 이해 작업에 대한 OSUM 모델의 우수한 성능을 보여줍니다.

노스 폴리 테크놀로지 대학교의 ASLP 실험실은 OSUM의 목표는 개방형 연구 플랫폼을 통해 고급 언어 이해 기술 개발을 촉진하는 것이라고 밝혔다. 연구원과 개발자는 모델의 코드와 가중치를 자유롭게 사용할 수 있으며 상업적 목적으로 사용하여 기술의 응용 프로그램 및 홍보를 가속화 할 수도 있습니다.

프로젝트 입구 : https://github.com/aslp-lab/osum?tab=readme-ov-file

OSUM 모델은 Whisper Encoder와 QWEN2 언어 모델을 결합하여 여러 음성 작업을 지원하고 멀티 태스킹 학습을 돕습니다.

OSUM 기술 보고서 v2.0의 OSUM은 교육 데이터 양이 50.5k 시간으로 증가하여 모델의 성능을 향상 시켰습니다.

이 모델의 코드와 가중치는 Apache 2.0 라이센스에 따라 사용될 수 있으며 학계 및 산업에서 광범위한 사용을 장려합니다.