人工知能の分野では、音声理解言語モデル(SULMS)の急速な発展が広範囲にわたる注目を集めています。北西ポリテクニカル大学ASLP研究所は最近、オープンスピーチ理解モデルOSUMをリリースしました。これは、学術リソースが限られているときに学術コミュニティの研究と革新を促進するために、音声理解モデルを効果的に訓練および利用する方法を探求することを目指しています。

OSUMモデルは、ヒスパーエンコーダーとQWEN2言語モデルを組み合わせて、音声認識(ASR)、タイムスタンプ付き音声認識(SRWT)、音声イベント検出(VED)、音声スタイル認識(SER)、音声スタイル認識(SSR)、スピーカージェンダー分類(SGC)、声(SGC)などの8つの音声タスクをサポートします。 ASR+Xトレーニング戦略を採用することにより、このモデルはターゲットタスクを実行しながら効率的かつ安定して音声認識を最適化し、マルチタスク学習の能力を向上させることができます。

OSUMモデルのリリースは、パフォーマンスに焦点を当てるだけでなく、透明性も強調しています。そのトレーニング方法とデータ準備プロセスは、学術コミュニティへの貴重な参照とガイダンスを提供するために開かれています。テクニカルレポートv2.0によると、OSUMモデルのトレーニングデータの量は50.5k時間に増加し、過去44.1k時間よりも大幅に高くなっています。その中には、3000時間の音声性別分類データと6800時間のスピーカー年齢予測データが含まれています。これらのデータを拡張すると、さまざまなタスクでモデルのパフォーマンスが向上します。

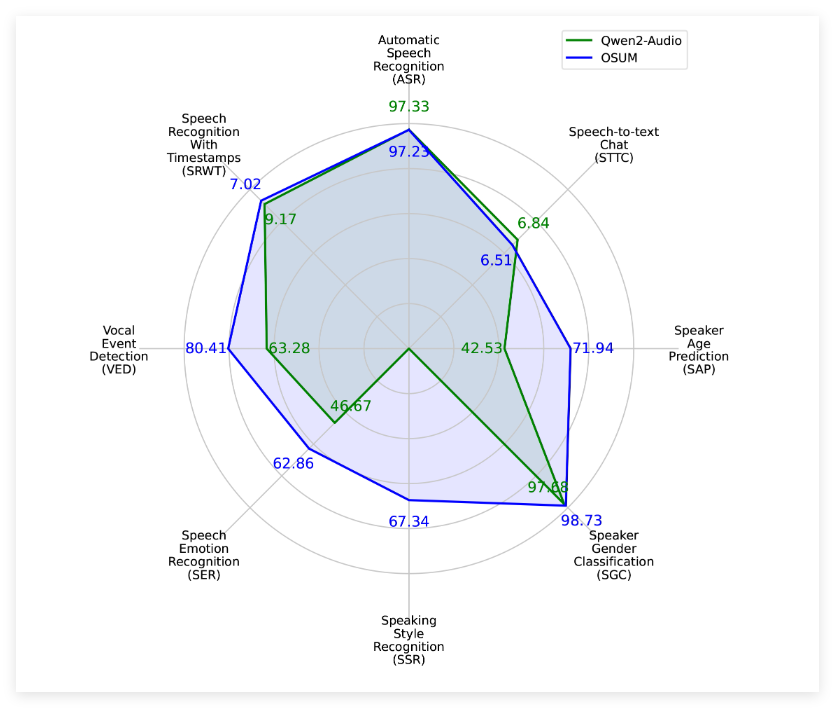

評価結果によると、OSUMは、コンピューティングリソースとトレーニングデータが大幅に少ない場合でも、複数のタスクのQWEN2-Audioモデルよりも優れています。関連する評価結果は、パブリックテストセットだけでなく、内部テストセットもカバーし、音声理解タスクに関するOSUMモデルの良好なパフォーマンスを示しています。

ノースウェスタンポリテクニカル大学のASLP研究所は、OSUMの目標は、オープンな研究プラットフォームを通じて高度な音声理解技術の開発を促進することであると述べました。研究者と開発者は、モデルのコードと重みを自由に使用でき、商業目的に使用することさえでき、それによってテクノロジーのアプリケーションとプロモーションを加速できます。

プロジェクトの入り口:https://github.com/aslp-lab/osum?tab = readme-ov-file

OSUMモデルは、ウィスパーエンコーダーとQWEN2言語モデルを組み合わせて、複数の音声タスクをサポートし、マルチタスク学習を支援します。

テクニカルレポートv2.0では、トレーニングデータのボリュームが50.5k時間に増加し、モデルのパフォーマンスが向上しました。

このモデルのコードと重みは、Apache 2.0ライセンスの下で使用できるようになり、学界と業界での広範な使用を促進します。