최근 인간 3D 모델에 중점을 둔 우크라이나 웹 사이트 인 Trilegangers는 전례없는 교통 공격에 직면하여 서버가 무너졌습니다. 이 웹 사이트는 3D 아티스트와 게임 개발자에게 엄청난 양의 인체 3D 모델 데이터를 제공하기 위해 최선을 다하고 있지만 OpenAi의 Crawler GPTBOT가 자주 크롤링되어 문제가 발생합니다. 이 사건은 웹 크롤러의 잠재적 위협을 웹 사이트 운영에 노출시킬뿐만 아니라 AI 기술과 저작권 보호 간의 균형에 대한 광범위한 토론을 시작했습니다.

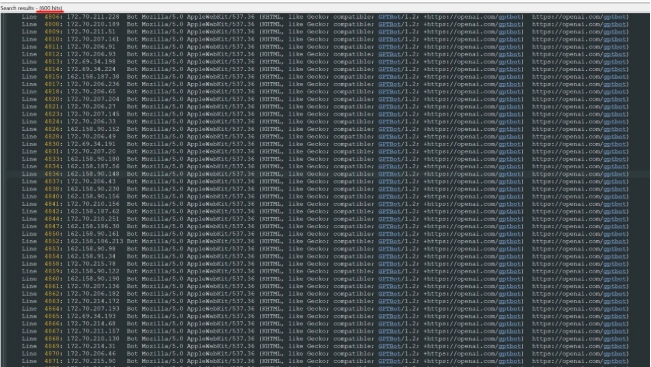

Trilegangers 직원에 따르면, 웹 사이트는 명시 적으로 승인되지 않은 크롤링 및 사용 계약에 사용하는 것을 금지하지만, 크롤러가 액세스하는 것을 방지하기 위해 Robots.txt 파일의 잘못된 설정으로 인해 서버에 과부하가 발생합니다. 서버 로그에 따르면, OpenAi의 GPTBot Crawler는 600 개가 넘는 다른 IP 주소를 통해 수만 건의 요청을 시작했으며, 이로 인해 웹 사이트는 분산 서비스 거부 (DDO) 공격을 만나는 것과 유사하게 웹 사이트가 정상적으로 작동 할 수 없었습니다. 이러한 상황은 웹 사이트의 정상적인 운영에 영향을 줄뿐만 아니라 사용자에게 큰 불편을 겪습니다.

Crawler 설명에서 OpenAi는 웹 사이트가 GPTBOT가 컨텐츠를 크롤링하기를 원하지 않으면 robots.txt 파일에 설정해야한다고 언급했습니다. 그러나 Trilegangers는 이것을 알지 못하여 현재의 딜레마로 이어집니다. Robots.txt 파일은 법에 의해 요구되지 않지만 웹 사이트에서 무단 사용이 금지된다고 말하면 GPTBOT의 크롤링 행동은 여전히 관련 규정을 위반할 수 있습니다. 이 사건은 웹 사이트 운영자에게 기술 설정의 중요성을 상기시켜주고 AI 기술 적용의 윤리에 대해 생각할 수 있습니다.

또한 Amazon AWS 서버의 사용으로 인해 Trilegangers의 대역폭 및 트래픽 소비도 급격히 증가하여 추가 비용 압력이 발생했습니다. 이 응급 상황에 따라 Trilegangers는 올바른 Robots.txt 파일을 설정하고 CloudFlare를 통해 GPTBOT에 대한 블록 액세스를 수행했습니다. 이 레슨은 또한 다른 웹 사이트에 대한 귀중한 참조를 제공합니다.

이 사건은 특히 AI 기술의 발전이 증가하는 맥락에서 네트워크 크롤러의 행동에 대한 관심을 불러 일으켰다. AI 기술의 지속적인 발전으로 네트워크 크롤러의 행동은 기술 개발과 저작권 보호 사이의 균형을 찾는 방법이 향후 해결해야 할 중요한 문제가 될 것입니다. 이 사건은 트레일 겐저에게는 도전 일뿐 만 아니라 인터넷 산업 전체에 대한 경고이기도합니다.