Récemment, TrileGangers, un site Web ukrainien axé sur les modèles 3D humains, a rencontré des attaques de trafic sans précédent, provoquant l'effondrement de son serveur. Le site Web s'engage à fournir aux artistes 3D et aux développeurs de jeux avec des quantités massives de données de modèle 3D du corps humain, mais est en difficulté en raison de la fréquence des rampes du Crawler d'Openai GPTBOT. Cet incident a non seulement exposé la menace potentielle des chenilles du Web aux opérations du site Web, mais a également déclenché des discussions approfondies sur l'équilibre entre la technologie de l'IA et la protection des droits d'auteur.

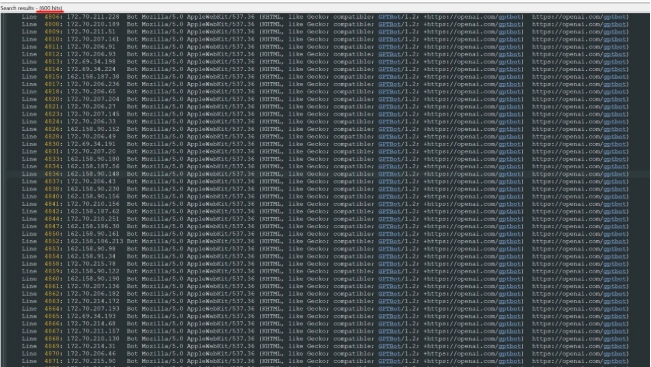

Selon le personnel de TrileGangers, bien que le site Web interdit explicitement la rampe et l'utilisation non autorisées dans l'accord d'utilisation, le serveur est surchargé en raison du paramètre incorrect du fichier robots.txt pour empêcher les chenilles d'accéder. Selon le journal des serveurs, le robot GPTBOT d'OpenAI a lancé des dizaines de milliers de demandes via plus de 600 adresses IP différentes, ce qui a permis à la fonctionnalité de fonctionner normalement, similaire à la rencontre d'une attaque de déni de service distribuée (DDOS). Cette situation affecte non seulement le fonctionnement normal du site Web, mais provoque également de grands inconvénients aux utilisateurs.

Openai a mentionné dans sa description du robot de robot que si le site Web ne veut pas que GPTBOT fasse du contenu, il doit être défini dans le fichier robots.txt. Cependant, les trilegangers n'en sont pas conscients, ce qui conduit au dilemme actuel. Bien que les fichiers robots.txt ne soient pas exigés par la loi, si le site Web a déclaré que l'utilisation non autorisée est interdite, le comportement rampant de GPTBOT peut toujours violer les réglementations pertinentes. Cet incident rappelle aux opérateurs du site Web l'importance des paramètres techniques et déclenche également la réflexion sur l'éthique de l'application de la technologie de l'IA.

En outre, en raison de l'utilisation des serveurs AWS d'Amazon, la consommation de TrileGangers dans la bande passante et le trafic a également augmenté de façon spectaculaire, ce qui a augmenté la pression des coûts supplémentaires. En réponse à ces urgences, TrileGangers a pris des mesures pour configurer le fichier Robots.TXT correct et bloquer l'accès à plusieurs robots, y compris GPTBOT via CloudFlare. Cette leçon fournit également une référence précieuse pour d'autres sites Web.

Cet incident a suscité l'attention des gens sur le comportement des robots de réseau, en particulier dans le contexte du développement croissant de la technologie de l'IA. Avec la progression continue de la technologie de l'IA, le comportement des robots de réseau deviendra plus complexe et caché. Cet incident n'est pas seulement un défi pour les trilegangers, mais aussi un avertissement à l'ensemble de l'industrie Internet.