Kürzlich trafen Trilegangers, eine ukrainische Website mit Schwerpunkt auf menschlichen 3D -Modellen, beispiellose Verkehrsangriffe, wodurch der Server zusammenbricht. Die Website ist bestrebt, 3D -Künstler und Spieleentwickler ein massives Mengen an 3D -Modelldaten des menschlichen Börsens zu bieten, ist jedoch aufgrund des häufigen Kriechens von OpenAs Crawler GPTBOT in Schwierigkeiten. Dieser Vorfall stellte nicht nur die potenzielle Bedrohung durch Webcrawler für Website -Operationen aus, sondern löste auch umfangreiche Diskussionen über das Gleichgewicht zwischen KI -Technologie und Urheberrechtsschutz aus.

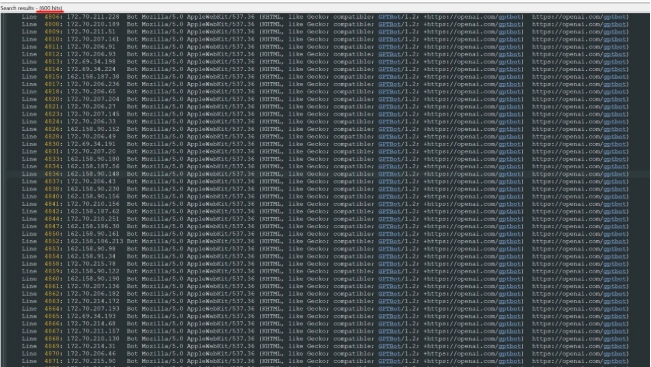

Laut Trilegangers -Mitarbeitern, obwohl die Website das nicht autorisierte Crawling und die Verwendung in der Nutzungsvereinbarung ausdrücklich verbietet, wird der Server aufgrund der falschen Einstellung der Datei robots.txt überlastet, um zu verhindern, dass Crawlers zugreifen. Laut dem Serverprotokoll initiierte der GPTBOT -Crawler von OpenAI Zehntausende von Anforderungen über mehr als 600 verschiedene IP -Adressen, was dazu führte, dass die Website normal nicht funktioniert, ähnlich wie bei der Begegnung mit einem DDOS -Angriff (Distributed Denial of Service). Diese Situation wirkt sich nicht nur auf den normalen Betrieb der Website aus, sondern macht den Benutzern auch große Unannehmlichkeiten.

OpenAI erwähnt in seiner Crawler -Beschreibung, dass die Website, wenn die Website nicht möchte, dass GPTBOT Inhalte kriecht, in der Datei robots.txt festgelegt werden muss. Trileganger sind sich dessen jedoch nicht bewusst, was zum aktuellen Dilemma führt. Obwohl Robots.txt -Dateien gesetzlich nicht erforderlich sind, kann das Krabbeln von GPTBOT immer noch gegen relevante Vorschriften verstoßen, wenn die Website festgestellt hat, dass die nicht autorisierte Verwendung verboten ist. Dieser Vorfall erinnert die Website -Betreiber an die Bedeutung technischer Einstellungen und löst das Denken über die Ethik der Anwendung der AI -Technologie aus.

Aufgrund der Verwendung von Amazon AWS -Servern hat der Verbrauch von Trilegangern in Bandbreite und Verkehr auch dramatisch zugenommen, was zusätzlichen Kostendruck ausgeführt hat. Als Reaktion auf diese Notfälle hat Trileganger Maßnahmen ergriffen, um die richtige Robots.TXT -Datei einzurichten und den Zugriff auf mehrere Crawlers, einschließlich GPTBOT, durch CloudFlare zu blockieren. Diese Lektion bietet auch wertvolle Referenz für andere Websites.

Dieser Vorfall hat die Aufmerksamkeit der Menschen auf das Verhalten von Netzwerkcrawlern erregt, insbesondere im Zusammenhang mit der zunehmenden Entwicklung der AI -Technologie. Mit der kontinuierlichen Weiterentwicklung der KI -Technologie wird das Verhalten von Netzwerkcrawlern komplexer und verborgener. Dieser Vorfall ist nicht nur eine Herausforderung für Trileganger, sondern auch eine Warnung vor der gesamten Internetbranche.