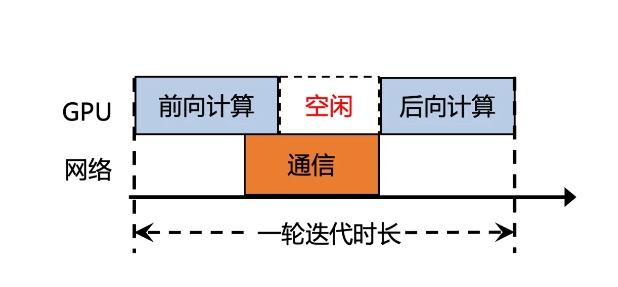

Tencent Cloud는 대규모 모델 훈련에서 낮은 통신 효율성 문제를 해결하기 위해 대형 모델 훈련용으로 설계된 네트워크의 업그레이드 버전인 Xingmai Network 2.0을 출시했습니다. 이전 버전의 Xingmai 네트워크에서는 계산 결과 동기화 시간이 50% 이상을 차지하여 훈련 효율성에 심각한 영향을 미쳤습니다. 새 버전은 여러 가지 기술 업그레이드를 통해 네트워크 성능과 안정성이 크게 향상되어 대규모 모델 훈련을 더욱 강력하게 지원합니다.

1. 단일 클러스터에서 100,000개의 카드 네트워킹을 지원하여 규모를 두 배로 늘리고, 네트워크 통신 효율성을 60% 높이고, 대형 모델 교육 효율성을 20% 높이고, 오류 위치를 며칠에서 몇 분으로 줄입니다.

2. 자체 개발한 스위치, 광 모듈, 네트워크 카드 및 기타 네트워크 장비를 업그레이드하여 인프라의 안정성을 높이고 100,000개 이상의 GPU 카드 규모로 단일 클러스터를 지원합니다.

3. 네트워크 카드에 새로운 통신 프로토콜인 TiTa2.0을 탑재하고 혼잡 알고리즘을 능동 혼잡 제어 알고리즘으로 업그레이드해 통신 효율성을 30% 높이고, 대형 모델 학습 효율성을 10% 높였습니다.

4. 고성능 집단 통신 라이브러리 TCCL2.0은 NVLINK+NET 이종 병렬 통신을 사용하여 데이터의 병렬 전송을 실현합니다. 또한 Auto-Tune Network Expert 적응형 알고리즘을 갖추고 있어 통신 성능을 30% 향상하고 대규모 모델 훈련 효율성을 향상시킵니다. 10%.

5. 새로 추가된 Tencent 독점 기술 Lingjing 시뮬레이션 플랫폼은 클러스터 네트워크를 완벽하게 모니터링하고 GPU 노드 문제를 정확하게 찾아내며 10,000ka 수준의 훈련 결함을 찾는 시간을 며칠에서 몇 분으로 단축할 수 있습니다.

이러한 업그레이드를 통해 Xingmai 네트워크의 통신 효율성은 60% 증가하고, 대형 모델 훈련 효율성은 20% 증가했으며, 결함 위치 정확도도 향상되었습니다. 이러한 개선 사항은 대규모 모델 훈련의 효율성과 성능을 향상시켜 값비싼 GPU 리소스를 더욱 완벽하게 활용할 수 있게 해줍니다.

Xingmai Network 2.0의 업그레이드는 대규모 모델 훈련에 상당한 효율성 향상과 향상된 신뢰성을 가져왔습니다. 네트워크 장비, 통신 프로토콜 및 오류 위치의 개선은 대규모 모델 기술 개발을 촉진하고 사용자에게 더 많은 이점을 제공할 것입니다. 효과적인 AI 훈련 경험.