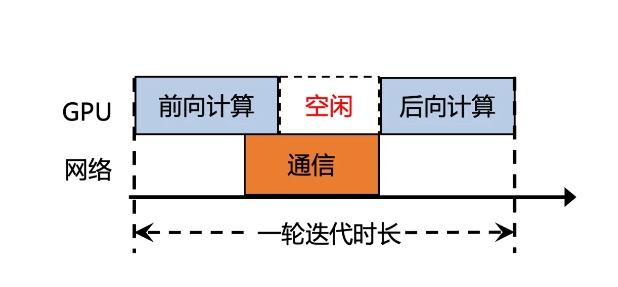

Tencent Cloud ha lanzado Xingmai Network 2.0, una versión mejorada de la red diseñada para el entrenamiento de modelos grandes, con el objetivo de resolver el problema de la baja eficiencia de la comunicación en el entrenamiento de modelos grandes. En la versión anterior de la red Xingmai, el tiempo de sincronización de los resultados de los cálculos representaba más del 50%, lo que afectaba seriamente la eficiencia del entrenamiento. La nueva versión ha mejorado significativamente el rendimiento y la confiabilidad de la red a través de múltiples actualizaciones técnicas, brindando un soporte más potente para la capacitación de modelos a gran escala.

1. Admite redes de 100 000 tarjetas en un solo clúster, lo que duplica la escala, aumenta la eficiencia de la comunicación de la red en un 60 %, aumenta la eficiencia del entrenamiento de modelos grandes en un 20 % y reduce la localización de fallas de días a minutos.

2. Los conmutadores, módulos ópticos, tarjetas de red y otros equipos de red de desarrollo propio se actualizan para hacer que la infraestructura sea más confiable y admita un solo clúster con una escala de más de 100.000 tarjetas GPU.

3. Se implementa el nuevo protocolo de comunicación TiTa2.0 en la tarjeta de red y el algoritmo de congestión se actualiza a un algoritmo de control de congestión activo. La eficiencia de la comunicación aumenta en un 30% y la eficiencia del entrenamiento de modelos grandes aumenta en un 10%.

4. La biblioteca de comunicación colectiva de alto rendimiento TCCL2.0 utiliza comunicación paralela heterogénea NVLINK+NET para realizar la transmisión paralela de datos. También cuenta con el algoritmo adaptativo Auto-Tune Network Expert, que mejora el rendimiento de la comunicación en un 30% y la eficiencia del entrenamiento de modelos grandes en un 30%. 10%.

5. La plataforma de simulación Lingjing, con tecnología exclusiva de Tencent, recientemente agregada, puede monitorear completamente la red del clúster, localizar con precisión los problemas de los nodos de GPU y reducir el tiempo para localizar fallas de entrenamiento de nivel 10,000 ka de días a minutos.

A través de estas actualizaciones, la eficiencia de la comunicación de la red Xingmai aumentó en un 60%, la eficiencia del entrenamiento de modelos grandes aumentó en un 20% y también se mejoró la precisión de la localización de fallas. Estas mejoras ayudarán a mejorar la eficiencia y el rendimiento del entrenamiento de modelos grandes, permitiendo que los costosos recursos de GPU se utilicen más plenamente.

La actualización de Xingmai Network 2.0 ha aportado mejoras significativas en la eficiencia y una mayor confiabilidad para la capacitación de modelos grandes. Sus mejoras en el equipo de red, los protocolos de comunicación y la localización de fallas promoverán el desarrollo de la tecnología de modelos grandes y brindarán beneficios a los usuarios. experiencia efectiva de entrenamiento de IA.