Pytorch에 풍부한 데이터 세트가있는 사용하기 쉬운 SOTA 시맨틱 세분화 모델

2022 년 이래로 많은 변화가 있었으며, 요즘에는 오픈 월드 세분화 모델 (세그먼트가 무엇이든)도 있습니다. 그러나 기존 세분화 모델은 여전히 높은 정확도 및 맞춤형 사용 사례에 대한 수요가 있습니다. 이 repo는 새로운 Pytorch 버전, 업데이트 된 모델 및 사용자 정의 데이터 세트와 함께 사용하는 방법에 대한 문서에 따라 업데이트됩니다.

예상 릴리스 날짜 -> 2024 년 5 월

계획된 기능 :

폐기 할 현재 기능 :

지원되는 백본 :

지원되는 헤드/방법 :

지원되는 독립형 모델 :

지원되는 모듈 :

벤치 마크 및 사용 가능한 미리 훈련 된 모델의 모델을 참조하십시오.

지원하는 백본을 확인하십시오.

참고 : 대부분의 방법에는 미리 훈련 된 모델이 없습니다. 하나의 저장소에서 미리 훈련 된 가중치와 다른 모델을 결합하고 자원이 제한되어 자체를 다시 훈련하는 것은 매우 어렵습니다.

장면 구문 분석 :

인간 구문 분석 :

얼굴 구문 분석 :

기타 :

자세한 내용 및 데이터 세트 준비는 데이터 세트를 참조하십시오.

증강 효과를 테스트하려면 여기에서 노트북을 확인하십시오.

픽셀 레벨 변환 :

공간 수준 변환 :

그런 다음 저장소를 복제하고 프로젝트를 다음과 같이 설치하십시오.

$ git clone https://github.com/sithu31296/semantic-segmentation

$ cd semantic-segmentation

$ pip install -e . configs 에서 구성 파일을 만듭니다. ADE20K 데이터 세트의 샘플 구성은 여기에서 찾을 수 있습니다. 그런 다음 필요한 필드를 편집하십시오. 이 구성 파일은 모든 교육, 평가 및 예측 스크립트에 필요합니다.

단일 GPU로 훈련하기 위해 :

$ python tools/train.py --cfg configs/CONFIG_FILE.yaml 여러 GPU로 훈련하려면 구성 파일에서 DDP 필드를 true 로 설정하고 다음과 같이 실행하십시오.

$ python -m torch.distributed.launch --nproc_per_node=2 --use_env tools/train.py --cfg configs/ < CONFIG_FILE_NAME > .yaml 구성 파일의 MODEL_PATH 훈련 된 모델 디렉토리로 설정하십시오.

$ python tools/val.py --cfg configs/ < CONFIG_FILE_NAME > .yaml 다중 규모 및 플립으로 평가하려면 MSF 의 ENABLE 필드를 true 로 변경하고 위와 동일한 명령을 실행하십시오.

추론을하려면 아래에서 구성 파일의 매개 변수를 편집하십시오.

MODEL >> NAME 과 BACKBONE 원하는 사전 상환 모델로 변경하십시오.DATASET >> NAME 데이터 세트 이름으로 변경합니다.TEST >> MODEL_PATH 테스트 모델의 사전 상환 중량으로 설정하십시오.TEST >> FILE 테스트하려는 파일 또는 이미지 폴더 경로로 변경하십시오.SAVE_DIR 에 저장됩니다. # # example using ade20k pretrained models

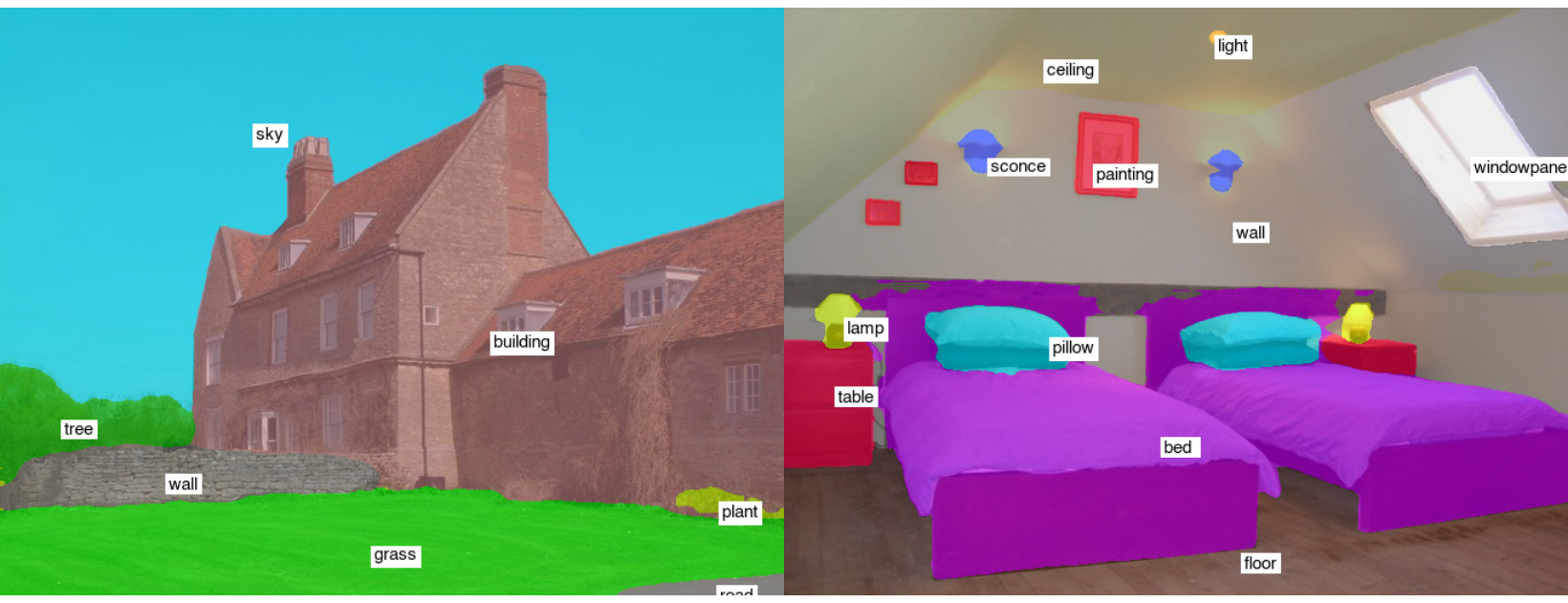

$ python tools/infer.py --cfg configs/ade20k.yaml예제 테스트 결과 (Segformer-B2) :

Onnx 및 Coreml로 변환하려면 실행 :

$ python tools/export.py --cfg configs/ < CONFIG_FILE_NAME > .yamlOpenVino 및 Tflite로 변환하려면 Torch_optimize를 참조하십시오.

# # ONNX Inference

$ python scripts/onnx_infer.py --model < ONNX_MODEL_PATH > --img-path < TEST_IMAGE_PATH >

# # OpenVINO Inference

$ python scripts/openvino_infer.py --model < OpenVINO_MODEL_PATH > --img-path < TEST_IMAGE_PATH >

# # TFLite Inference

$ python scripts/tflite_infer.py --model < TFLite_MODEL_PATH > --img-path < TEST_IMAGE_PATH > @article{xie2021segformer,

title={SegFormer: Simple and Efficient Design for Semantic Segmentation with Transformers},

author={Xie, Enze and Wang, Wenhai and Yu, Zhiding and Anandkumar, Anima and Alvarez, Jose M and Luo, Ping},

journal={arXiv preprint arXiv:2105.15203},

year={2021}

}

@misc{xiao2018unified,

title={Unified Perceptual Parsing for Scene Understanding},

author={Tete Xiao and Yingcheng Liu and Bolei Zhou and Yuning Jiang and Jian Sun},

year={2018},

eprint={1807.10221},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@article{hong2021deep,

title={Deep Dual-resolution Networks for Real-time and Accurate Semantic Segmentation of Road Scenes},

author={Hong, Yuanduo and Pan, Huihui and Sun, Weichao and Jia, Yisong},

journal={arXiv preprint arXiv:2101.06085},

year={2021}

}

@misc{zhang2021rest,

title={ResT: An Efficient Transformer for Visual Recognition},

author={Qinglong Zhang and Yubin Yang},

year={2021},

eprint={2105.13677},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@misc{huang2021fapn,

title={FaPN: Feature-aligned Pyramid Network for Dense Image Prediction},

author={Shihua Huang and Zhichao Lu and Ran Cheng and Cheng He},

year={2021},

eprint={2108.07058},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@misc{wang2021pvtv2,

title={PVTv2: Improved Baselines with Pyramid Vision Transformer},

author={Wenhai Wang and Enze Xie and Xiang Li and Deng-Ping Fan and Kaitao Song and Ding Liang and Tong Lu and Ping Luo and Ling Shao},

year={2021},

eprint={2106.13797},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@article{Liu2021PSA,

title={Polarized Self-Attention: Towards High-quality Pixel-wise Regression},

author={Huajun Liu and Fuqiang Liu and Xinyi Fan and Dong Huang},

journal={Arxiv Pre-Print arXiv:2107.00782 },

year={2021}

}

@misc{chao2019hardnet,

title={HarDNet: A Low Memory Traffic Network},

author={Ping Chao and Chao-Yang Kao and Yu-Shan Ruan and Chien-Hsiang Huang and Youn-Long Lin},

year={2019},

eprint={1909.00948},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@inproceedings{sfnet,

title={Semantic Flow for Fast and Accurate Scene Parsing},

author={Li, Xiangtai and You, Ansheng and Zhu, Zhen and Zhao, Houlong and Yang, Maoke and Yang, Kuiyuan and Tong, Yunhai},

booktitle={ECCV},

year={2020}

}

@article{Li2020SRNet,

title={Towards Efficient Scene Understanding via Squeeze Reasoning},

author={Xiangtai Li and Xia Li and Ansheng You and Li Zhang and Guang-Liang Cheng and Kuiyuan Yang and Y. Tong and Zhouchen Lin},

journal={ArXiv},

year={2020},

volume={abs/2011.03308}

}

@ARTICLE{Yucondnet21,

author={Yu, Changqian and Shao, Yuanjie and Gao, Changxin and Sang, Nong},

journal={IEEE Signal Processing Letters},

title={CondNet: Conditional Classifier for Scene Segmentation},

year={2021},

volume={28},

number={},

pages={758-762},

doi={10.1109/LSP.2021.3070472}

}

@misc{yan2022lawin,

title={Lawin Transformer: Improving Semantic Segmentation Transformer with Multi-Scale Representations via Large Window Attention},

author={Haotian Yan and Chuang Zhang and Ming Wu},

year={2022},

eprint={2201.01615},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@misc{yu2021metaformer,

title={MetaFormer is Actually What You Need for Vision},

author={Weihao Yu and Mi Luo and Pan Zhou and Chenyang Si and Yichen Zhou and Xinchao Wang and Jiashi Feng and Shuicheng Yan},

year={2021},

eprint={2111.11418},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@misc{wightman2021resnet,

title={ResNet strikes back: An improved training procedure in timm},

author={Ross Wightman and Hugo Touvron and Hervé Jégou},

year={2021},

eprint={2110.00476},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@misc{liu2022convnet,

title={A ConvNet for the 2020s},

author={Zhuang Liu and Hanzi Mao and Chao-Yuan Wu and Christoph Feichtenhofer and Trevor Darrell and Saining Xie},

year={2022},

eprint={2201.03545},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

@misc{li2022uniformer,

title={UniFormer: Unifying Convolution and Self-attention for Visual Recognition},

author={Kunchang Li and Yali Wang and Junhao Zhang and Peng Gao and Guanglu Song and Yu Liu and Hongsheng Li and Yu Qiao},

year={2022},

eprint={2201.09450},

archivePrefix={arXiv},

primaryClass={cs.CV}

}