이것은 "Pos-tag가있는 구조화 된 삼중 항 학습, 시각적 질문 답변, WACV 2018 (Zhe Wang, Xiaoyi Liu, Liangjian Chen, Limin Wang, Yu Qiao, Xiaohui Xie, Charless Fowlkes에 대한 구조화 된 트리플렛 학습에 대한 코드입니다." 그리고 언어 작업.

코드가 유용하다면 논문을 인용하십시오.

코드에 대한 피드백이 있으면 다음에 문의하십시오.

아래는 우리의 방법의 단계별 효과 검증입니다. 참고 검증 속도를 높이려면 14BY14 기능 대신 7BY7 기능을 사용합니다.

| 방법 | v7w | VQA 검증 |

|---|---|---|

| 우리의 기준선 | 65.6 | 58.3 |

| +POS 태그 가이드주의 (Pos-Att) | 66.3 | 58.7 |

| +Convolutional N-Gram (Conv N-Gram) | 66.2 | 59.3 |

| +pos-att +conc n-gram | 66.6 | 59.5 |

| +Pos-Att +CONC N-GRAM +트리플렛주의 Q | 66.8 | 60.1 |

| +Pos-Att +CONC N-GRAM +트리플렛주의 A | 67.0 | 60.1 |

| +Pos-Att +CONC N-GRAM +트리플렛주의 Q +A. | 67.3 | 60.2 |

| +Pos-Att +CONC N-GRAM +트리플렛주의 Q +A +구조적 학습 트리플릿 | 67.5 | 60.3 |

우리의 전체 모델 성능

| 방법 | V7W 말하기 | VQA 테스트 표준 | VQA 테스트 개발자 | VQA 테스트 Dev Y/N | VQA 테스트 데브 NUM | VQA Test Dev 기타 |

|---|---|---|---|---|---|---|

| 우리 것 | 68.2 | 69.6 | 69.7 | 81.9 | 44.3 | 64.7 |

Tensorflow, Torch, Pandas, H5Py, IPDB, CV2, PDB, Spacy, Sklearn, Matplotlib, PIL, NLTK

https://drive.google.com/open?id?id=1hofquxw22j8soyje0vuzqxcnuvjd-e9v에서 공유되는 V7W 지시 기능을 다운로드하고 "Cuda_visible_devices = 0 Python v7w.py"를 실행하십시오.

visual7w : http://web.stanford.edu/~yukez/visual7w/ 및 장갑 : http://nlp.stanford.edu/data/wordvecs/glove.6b.zip https://github.com/stanfordnlp/glove 다운로드 : https://d2j0dndfm35trm.cloudfront.net/resnet-200.t7

Python data_preprocessing_7w.py ---data_set 지시

python prepro_7w.py

th prepro_img_residule.lua

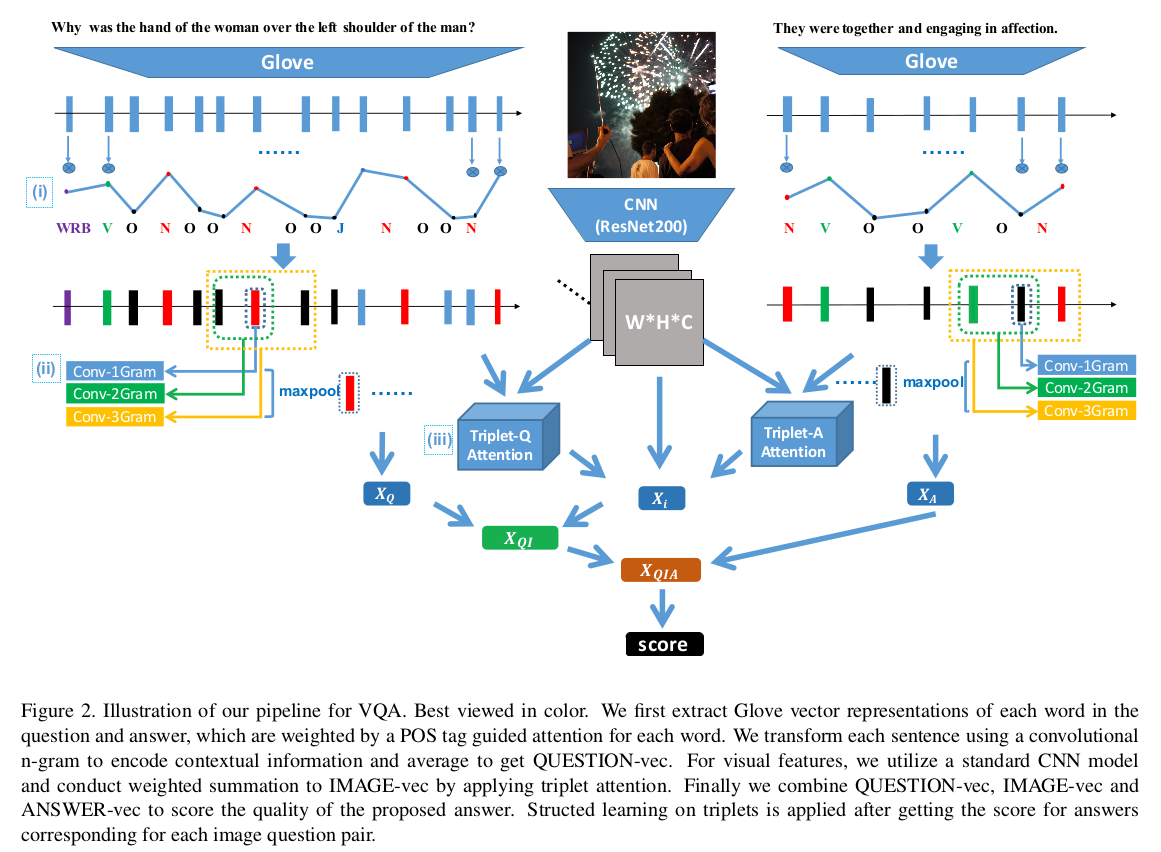

건축학 :

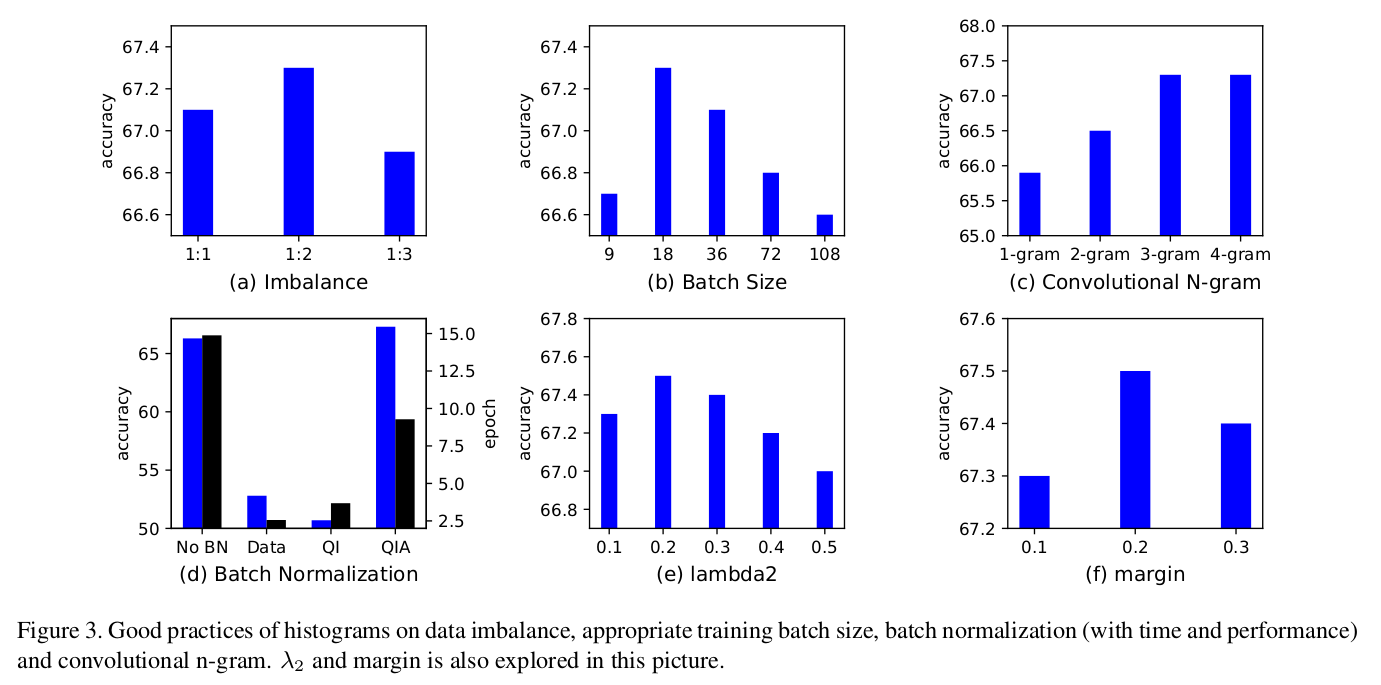

모범 사례 :

python comparisons_wacv.py

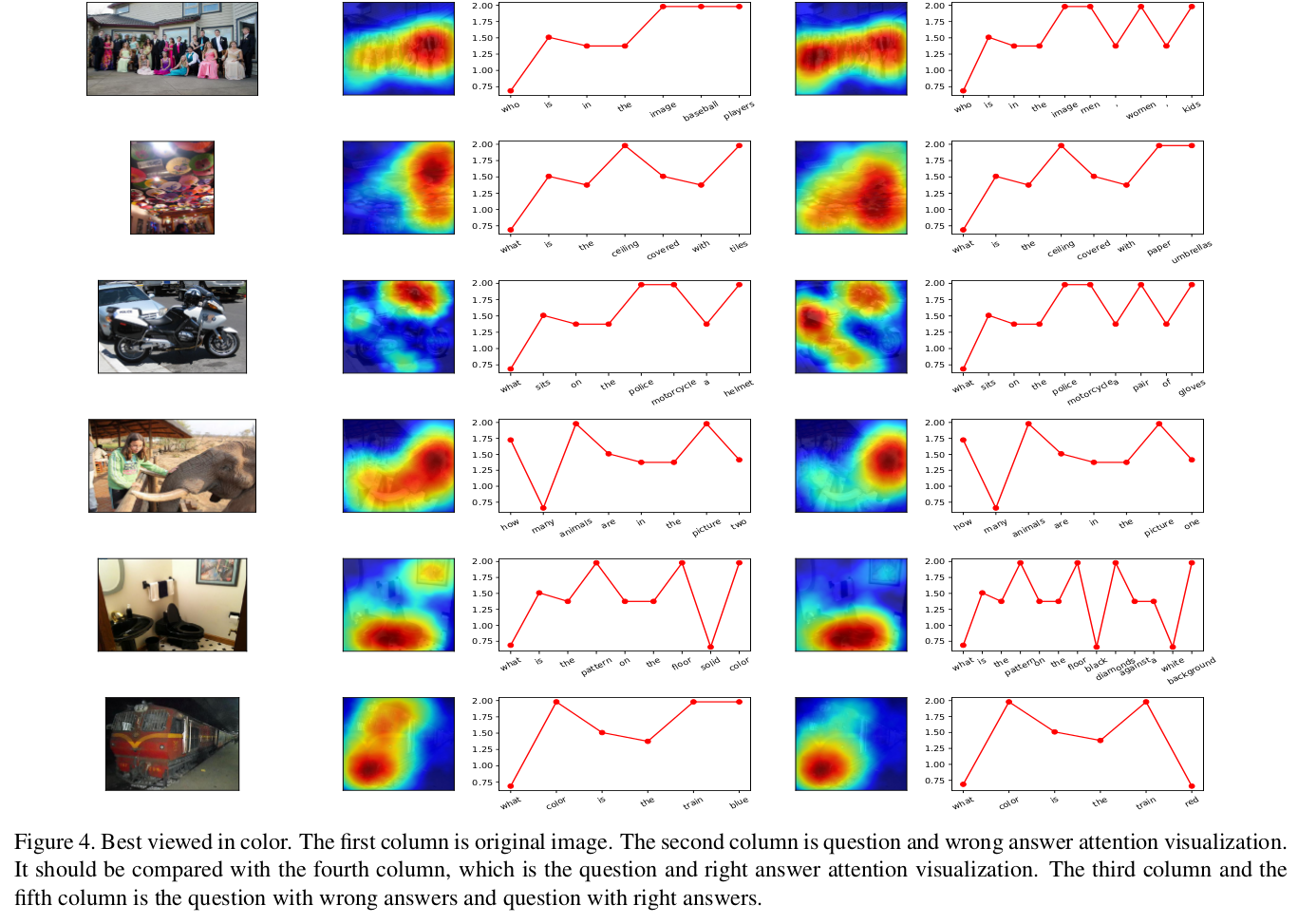

좋은 샘플 :

좋은 샘플 :

Python draw_heat_new.py

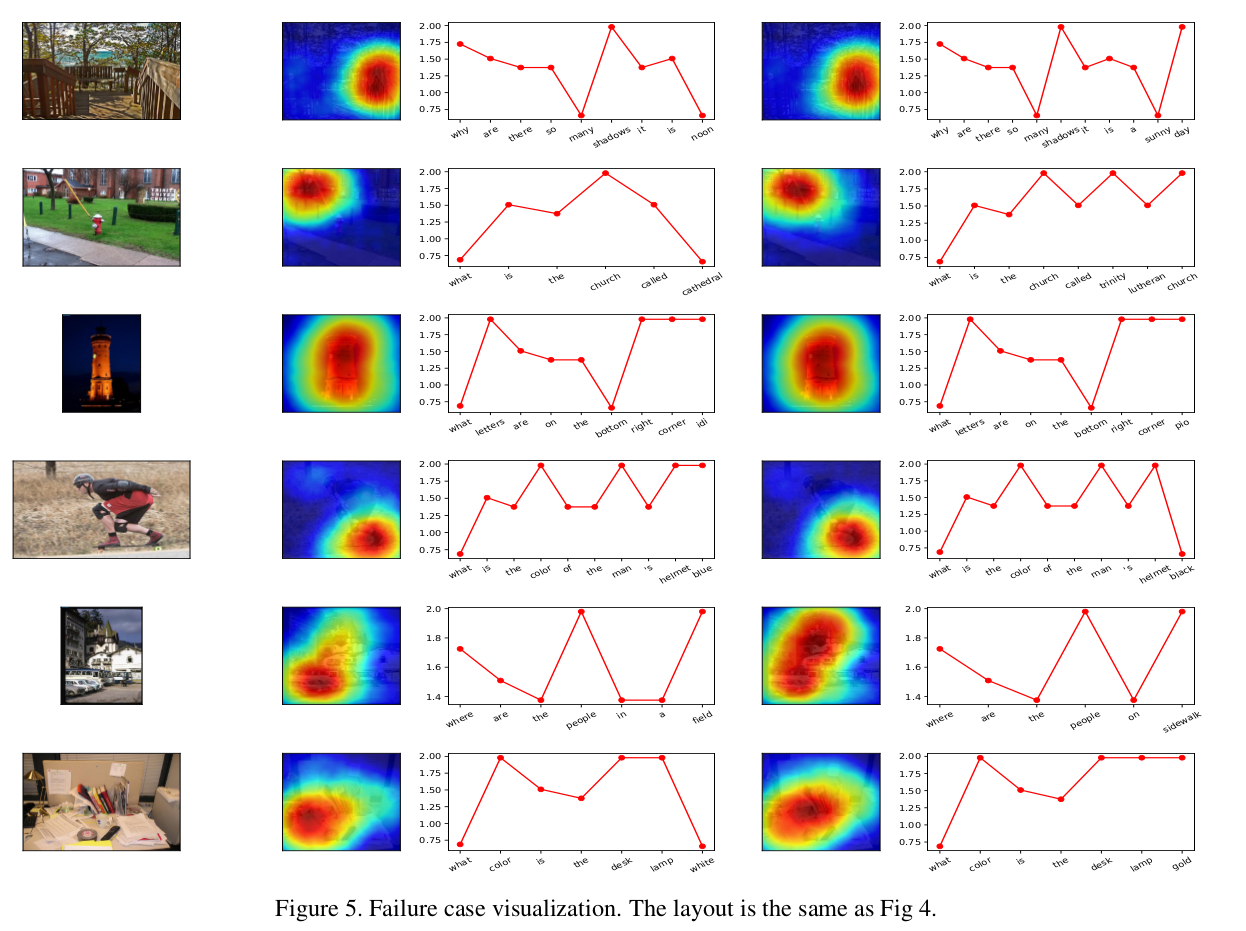

나쁜 샘플 :

나쁜 샘플 :

MIT