Dies ist der Code für "strukturiertes Triplett-Lernen mit pos-Tag-geführter Aufmerksamkeit für die visuelle Frage, WACV 2018 (Zhe Wang, Xiaoyi Liu, Liangjian Chen, Limin Wang, Yu Qiao, Xiaohui Xie Xie Xie Xie, charloses Fowlkes)". Aufgabe.

Wenn Sie den Code nützlich finden, zitieren Sie bitte das Papier:

Wenn Sie Feedback für den Code haben, wenden Sie sich bitte an:

Im Folgenden finden Sie die Schritt -für -Schritt -Effektivitätsüberprüfung unserer Methode. Hinweis, um die Überprüfung zu beschleunigen. Wir verwenden die 7BY7 -Funktion anstelle von 14BY14 -Feature

| Verfahren | V7w | VQA -Validierung |

|---|---|---|

| Unsere Grundlinie | 65.6 | 58,3 |

| +POS-Tag Guided Achtung (pos-att) | 66,3 | 58,7 |

| +Faltungs-N-Gram (überzeugen) | 66,2 | 59.3 |

| +Pos-att +überzeugen | 66.6 | 59,5 |

| +Pos-att +überzeugen-Gram +Triplett-Aufmerksamkeit-Q | 66,8 | 60.1 |

| +Pos-att +überzeugen Gram +Triplett-Aufmerksamkeit-a | 67.0 | 60.1 |

| +Pos-att +überzeugen Gram +Triplett Achtung-Q +a | 67,3 | 60.2 |

| Bis | 67,5 | 60.3 |

Unsere vollständige Modellleistung

| Verfahren | V7W erzählt | VQA -Teststandard | VQA Test Dev | VQA -Test devy/n | VQA Test Dev Num | VQA Test Dev Andere |

|---|---|---|---|---|---|---|

| Unsere | 68,2 | 69.6 | 69.7 | 81.9 | 44.3 | 64.7 |

Tensorflow, Torch, Pandas, H5Py, IPDB, CV2, PDB, Spacy, Sklearn, Matplotlib, Pil, NLTK

Laden Sie die V7W-Feature herunter, die auf https://drive.google.com/open?id=1Hofquxw22j8soyje0vuzqxcnuvjd-e9v geteilt wird, und führen Sie "cuda_visible_devices = 0 python v7w.py" aus und führen Sie es aus.

Download Visual7W: http://web.stanford.edu/~yukez/visual7w/ und GLOVE: http://nlp.stanford.edu/data/wordvecs/glove.6b.zip von https://github.com/stanfordnlp/glove Download:: https://d2j0dndfm35trm.cloudfront.net/resnet-200.t7

python data_preprocessing_7w.py - -data_set Telling

Python prepro_7w.py

th prepro_img_residule.lua

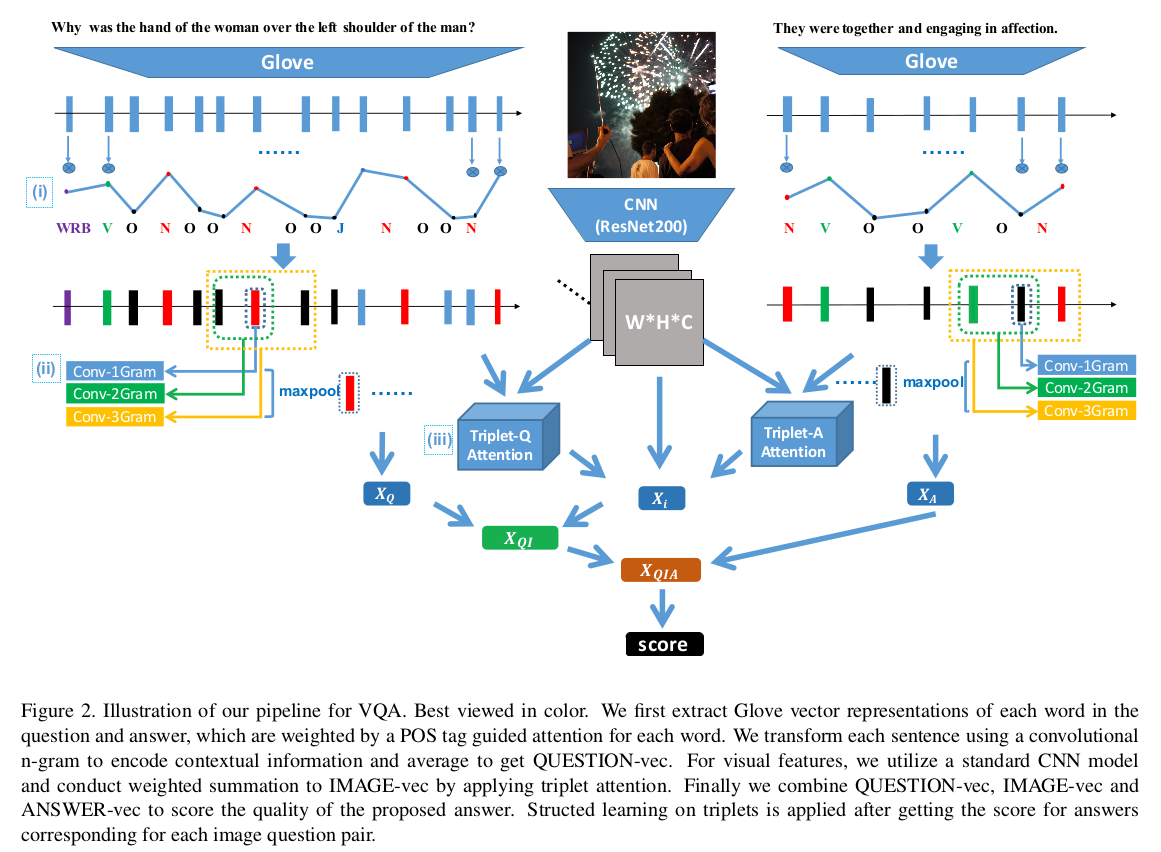

Architektur :

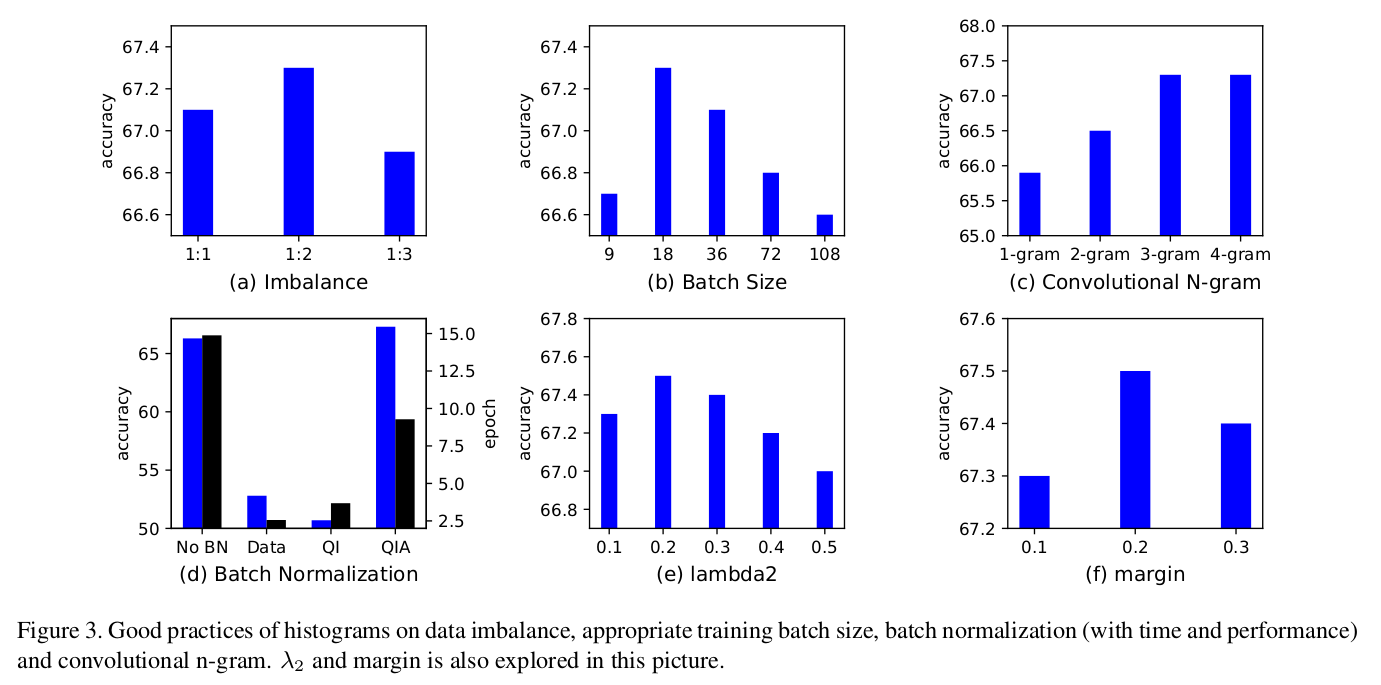

Gute Praxis :

Python Vergleiche_wacv.py

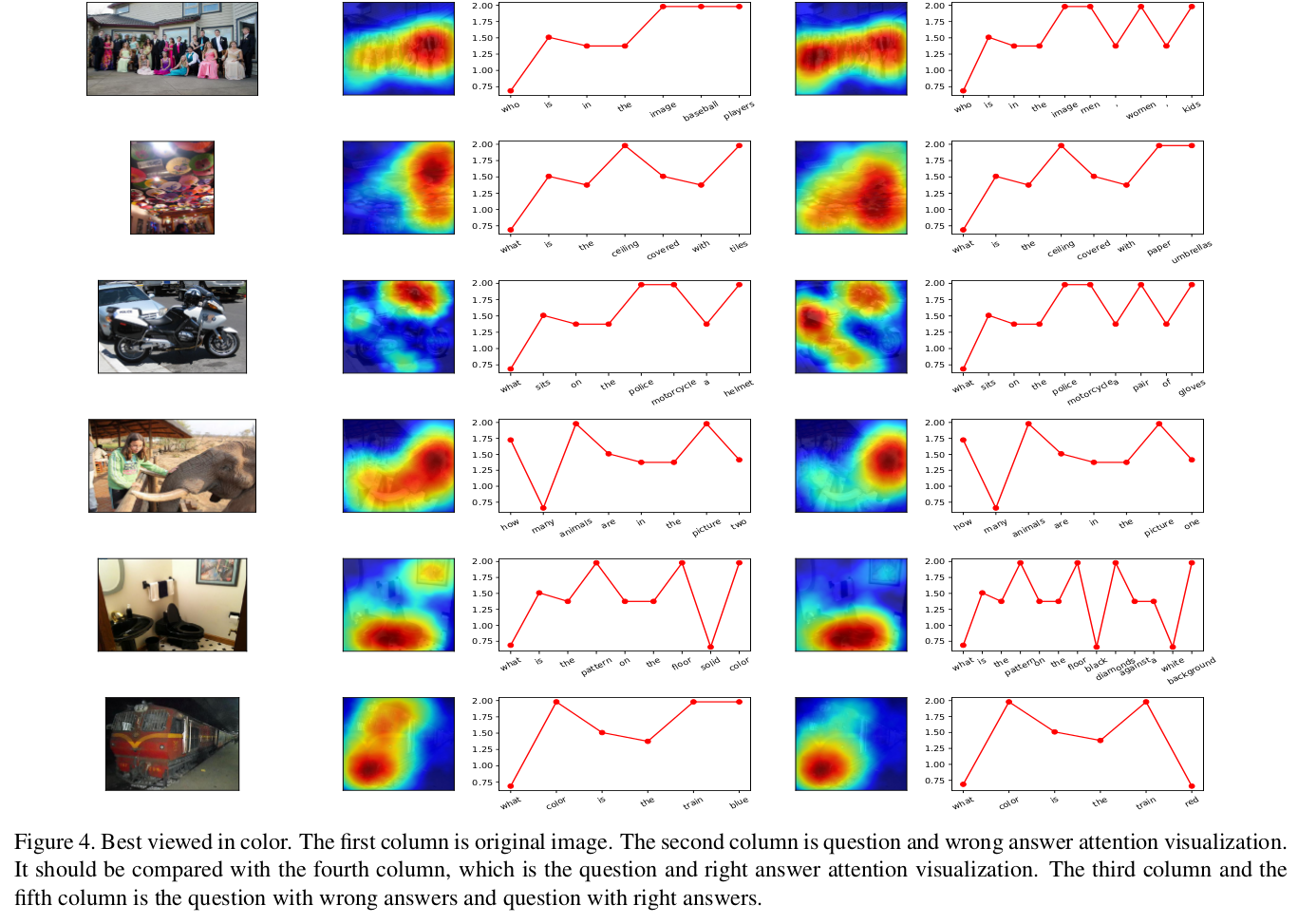

Gute Proben :

Gute Proben :

python draw_heat_new.py

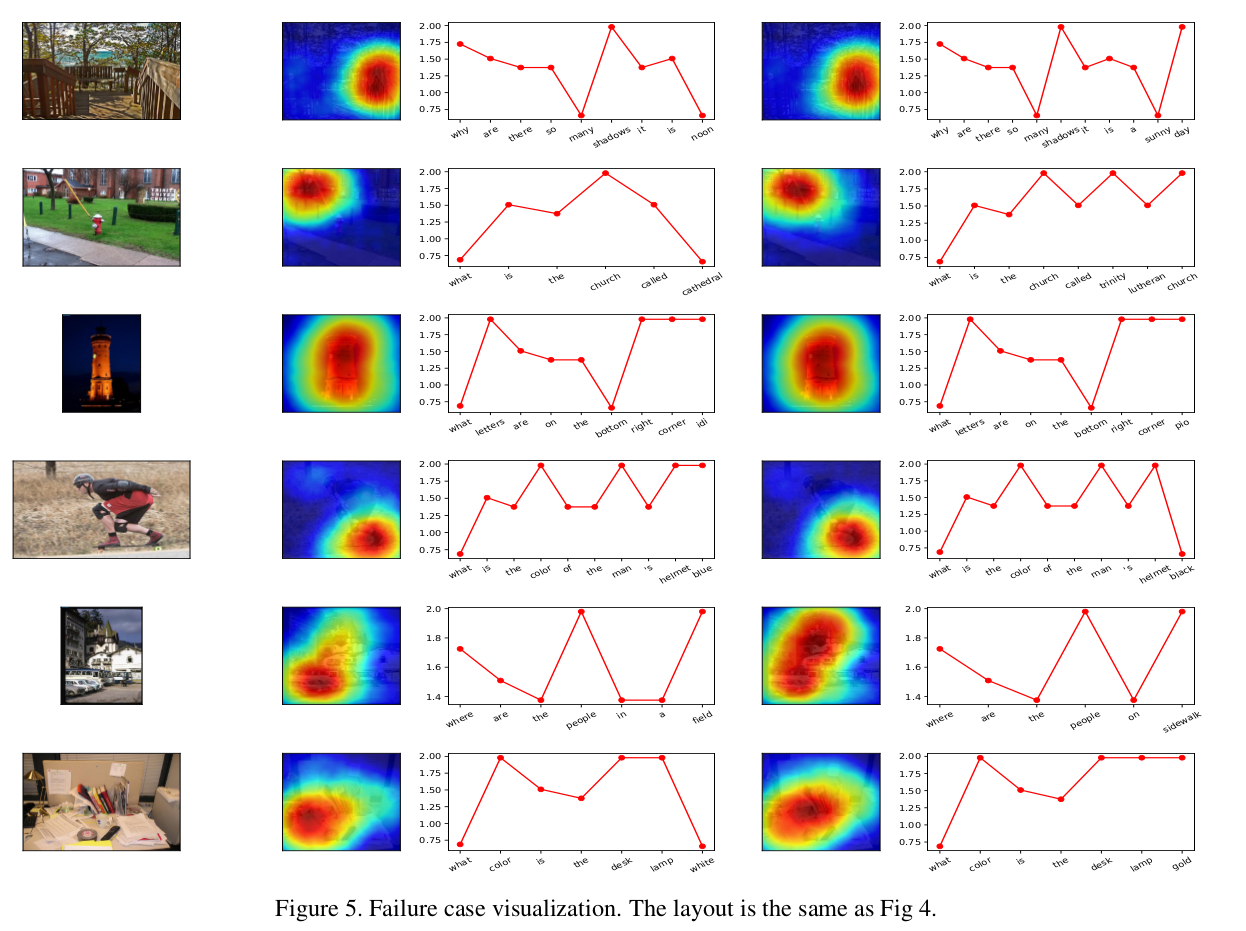

Schlechte Proben :

Schlechte Proben :

MIT