これは、「視覚的質問の回答のためのPOSタグのガイド付きの注意を払った構造化されたトリプレット学習、WACV 2018(Zhe Wang、Xiaoyi Liu、Liangjian Chen、Limin Wang、Yu Qiao、Xiaohui Xie、Charless Fowlkes)のコードです」 タスク。

コードが便利だと思う場合は、論文を引用してください。

コードのフィードバックがある場合は、お問い合わせください。

以下は、私たちの方法のステップバイステップの有効性の検証です。注意をスピードアップするために、14BY14機能の代わりに7BY7機能を使用します

| 方法 | V7W | VQA検証 |

|---|---|---|

| 私たちのベースライン | 65.6 | 58.3 |

| +POSタグガイド付き注意(POS-ATT) | 66.3 | 58.7 |

| +畳み込みn-gram(conv n-gram) | 66.2 | 59.3 |

| +pos-att +conv n-gram | 66.6 | 59.5 |

| +pos-att +conv n-gram +トリプレット注意-q | 66.8 | 60.1 |

| +pos-att +conv n-gram +トリプレット注意-a | 67.0 | 60.1 |

| +pos-att +conv n-gram +トリプレット注意-q +a | 67.3 | 60.2 |

| +pos-att +conv n-gram +トリプレット注意-q +a +構造化学習トリプレット | 67.5 | 60.3 |

私たちの完全なモデルパフォーマンス

| 方法 | v7wテーリング | VQAテスト標準 | VQAテスト開発者 | VQAテストDEV Y/N | VQAテストDEV NUM | VQAテスト開発その他 |

|---|---|---|---|---|---|---|

| 私たちのもの | 68.2 | 69.6 | 69.7 | 81.9 | 44.3 | 64.7 |

Tensorflow、Torch、Pandas、H5py、IPDB、CV2、PDB、Spacy、Sklearn、Matplotlib、PIL、NLTK

https://drive.google.com/open?id = 1hofquxw22j8soyje0vuzqxcnuvjd-e9vで共有されているV7Wの告知機能をダウンロードして、 "cuda_visible_devices = 0 python v7w.py" "

Visual7W:http://web.stanford.edu/~yukez/visual7w/ and glove:http://nlp.stanford.edu/data/wordvecs/glove.6b.zip https://github.com/stanfordnlp/glove Dowarlnlp/gloveダウンロード: https://d2j0dndfm35trm.cloudfront.net/resnet-200.t7

python data_preprocessing_7w.py - data_set telling

python prepro_7w.py

th prepro_img_residule.lua

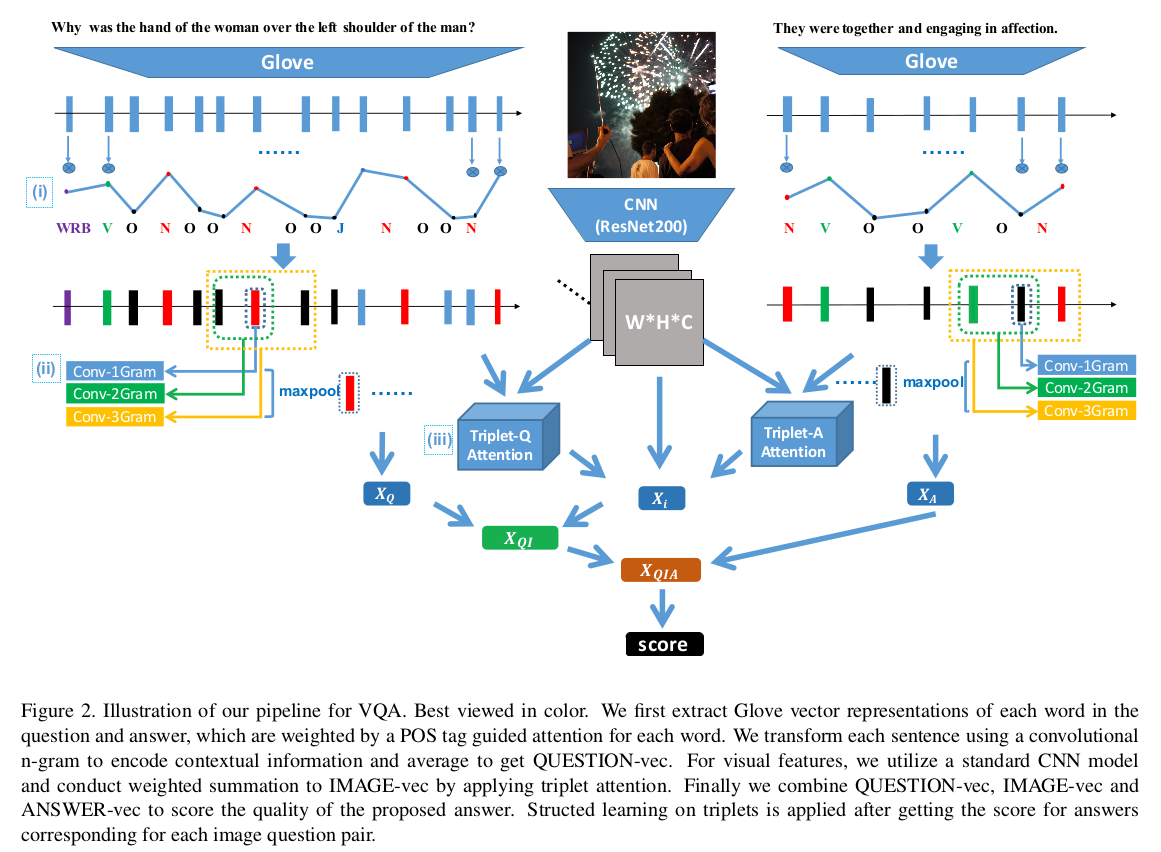

建築:

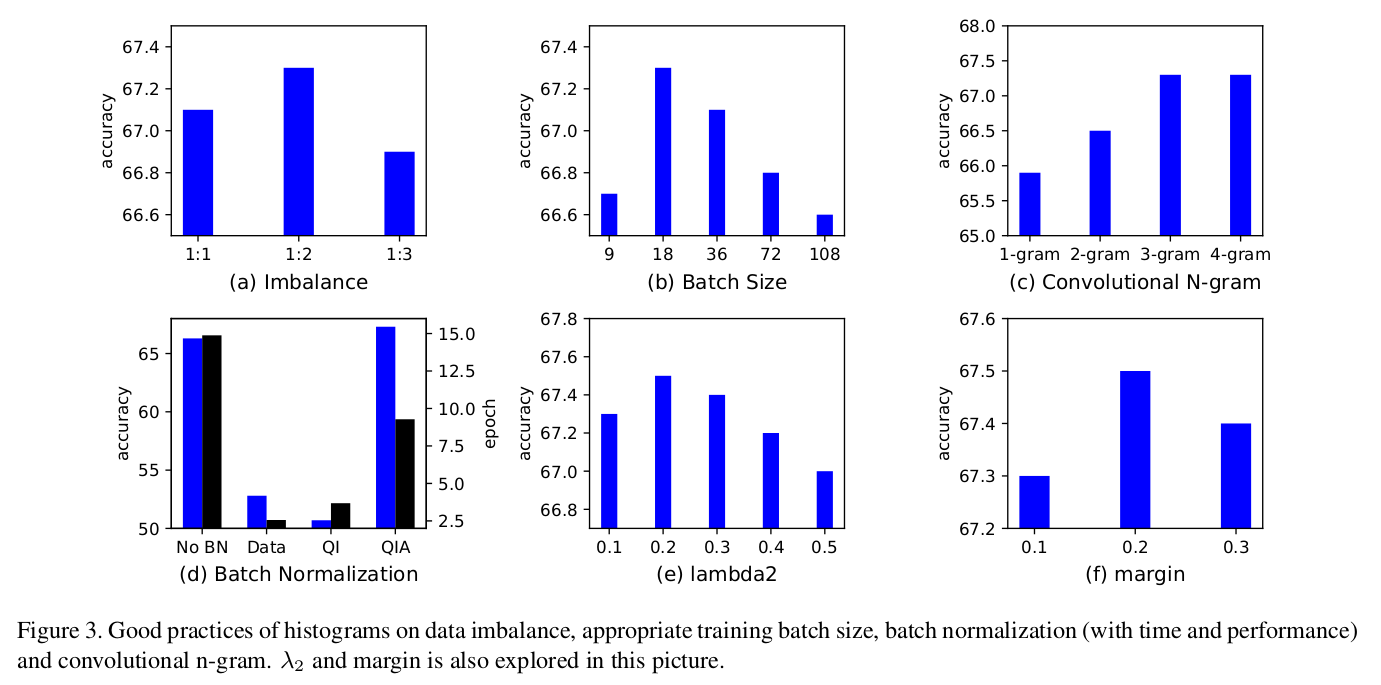

グッドプラクティス:

python比較_wacv.py

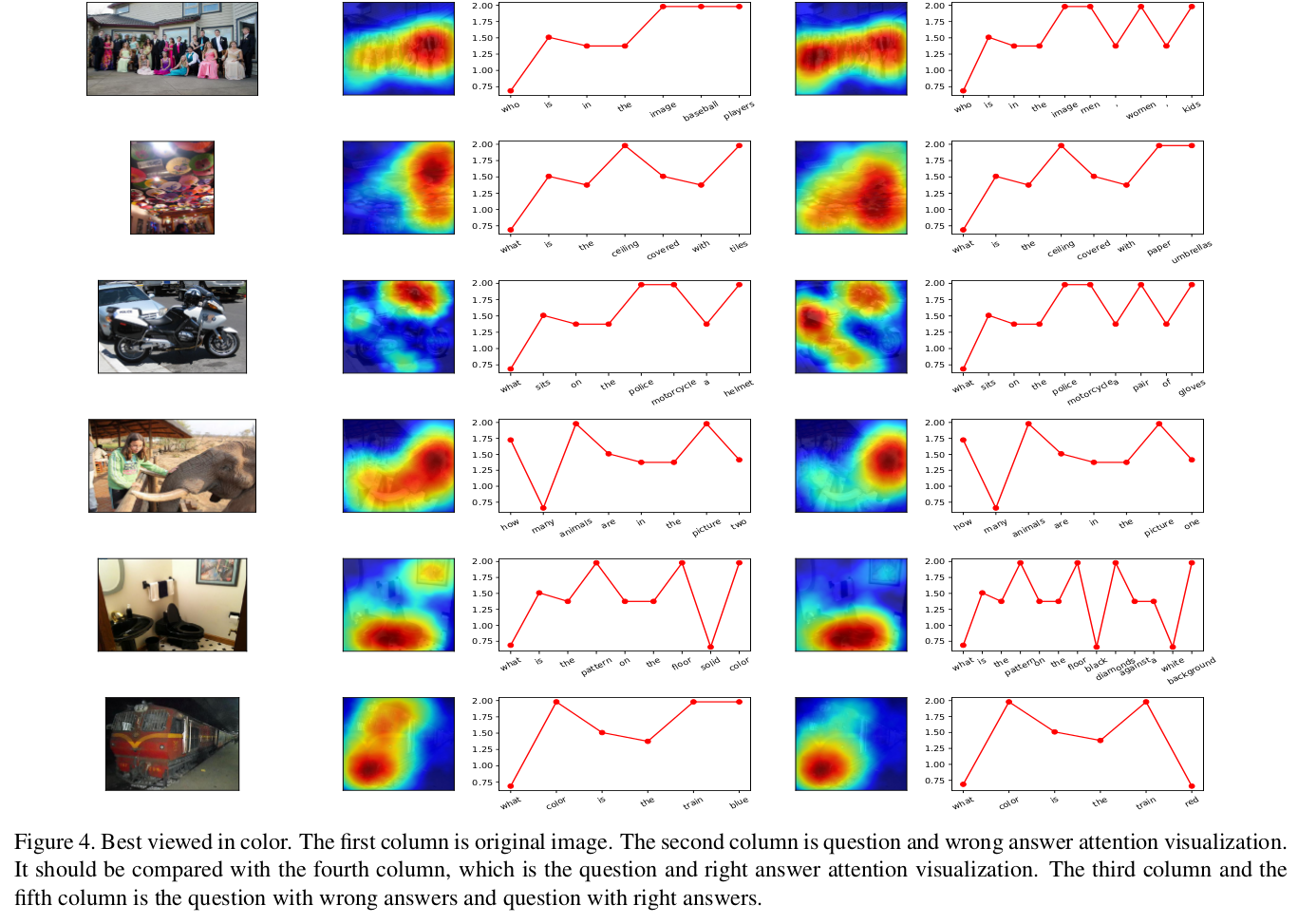

良いサンプル:

良いサンプル:

python draw_heat_new.py

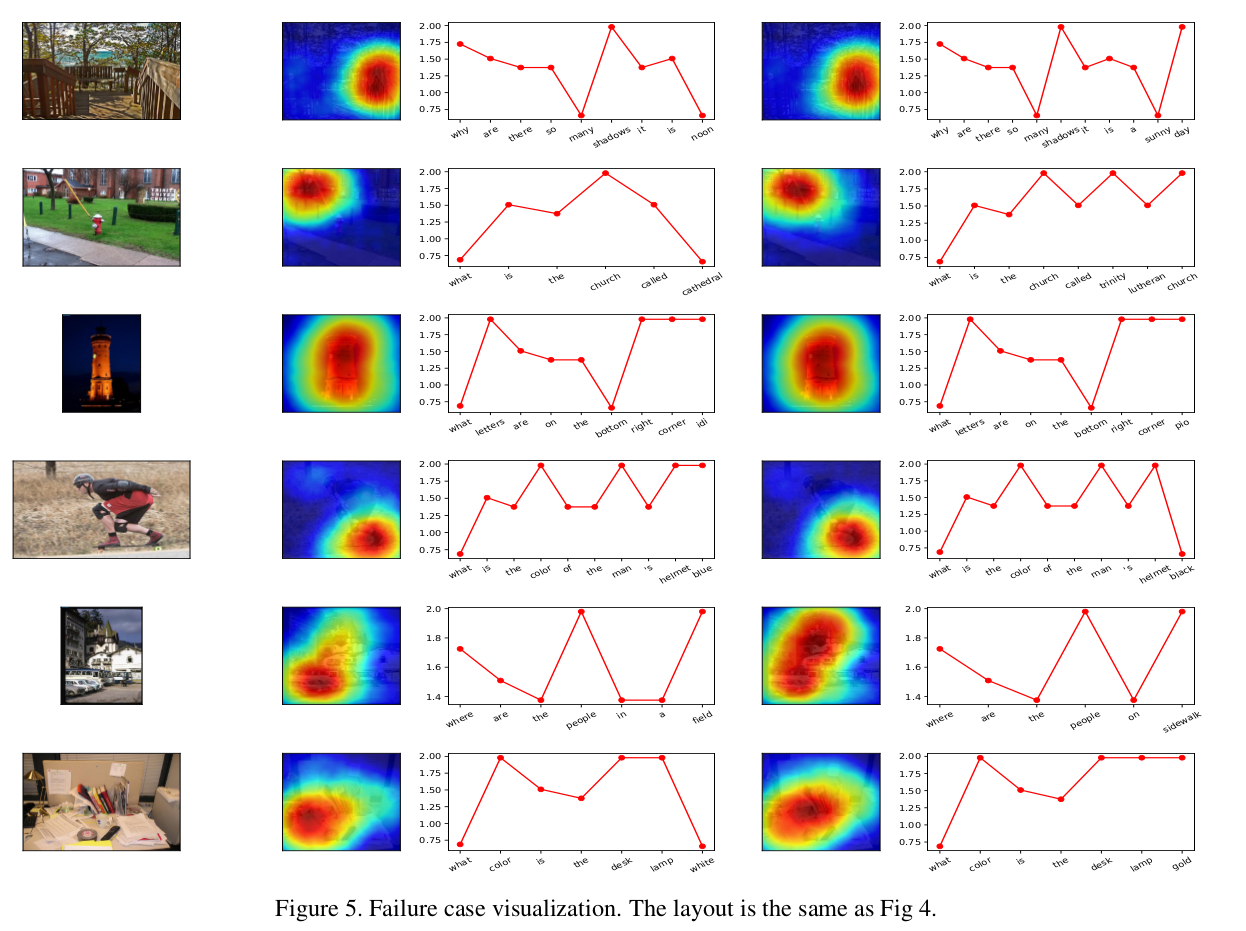

悪いサンプル:

悪いサンプル:

mit