다른 모델 API를 상자 밖에서 OpenAI API 형식으로 변환하십시오.

10MB+ 위젯은 다양한 모델 API를 상자 밖에서 OpenAI API 형식으로 변환 할 수 있습니다.

현재 지원되는 모델 :

GitHub 릴리스 페이지를 방문하여 운영 체제에 적합한 실행 파일을 다운로드하십시오.

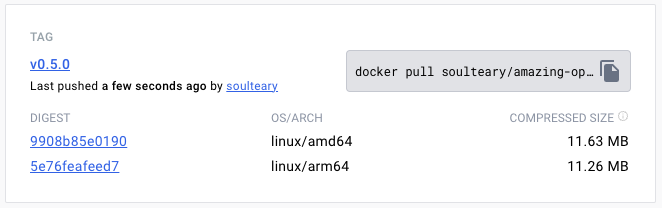

또는 Docker Pull을 사용하여 지정된 버전의 이미지 파일을 다운로드하십시오.

docker pull soulteary/amazing-openai-api:v0.7.0 AOA 구성 파일을 작성할 필요가 없으며 "작업 모델 선택", "모델 작동에 필요한 매개 변수 설정"및 "모델 호환성 별명 설정"을 포함하여 환경 변수를 지정하여 응용 프로그램 동작을 조정할 수 있습니다.

./aoa 으로이 프로그램은 작업 모델을 azure 로 설정합니다. 환경 변수 AZURE_ENDPOINT=https://你的部署名称.openai.azure.com/ 설정하면 서비스를 정상적으로 사용할 수 있습니다.

AZURE_ENDPOINT=https://你的部署名称.openai.azure.com/ ./aoaDocker를 선호하는 경우 다음 명령을 사용할 수 있습니다.

docker run --rm -it -e AZURE_ENDPOINT=https://你的部署名称.openai.azure.com/ -p 8080:8080 soulteary/amazing-openai-api:v0.7.0 서비스가 시작된 후 http://localhost:8080/v1 방문하여 OpenAI와 동일한 API 서비스에 액세스 할 수 있습니다.

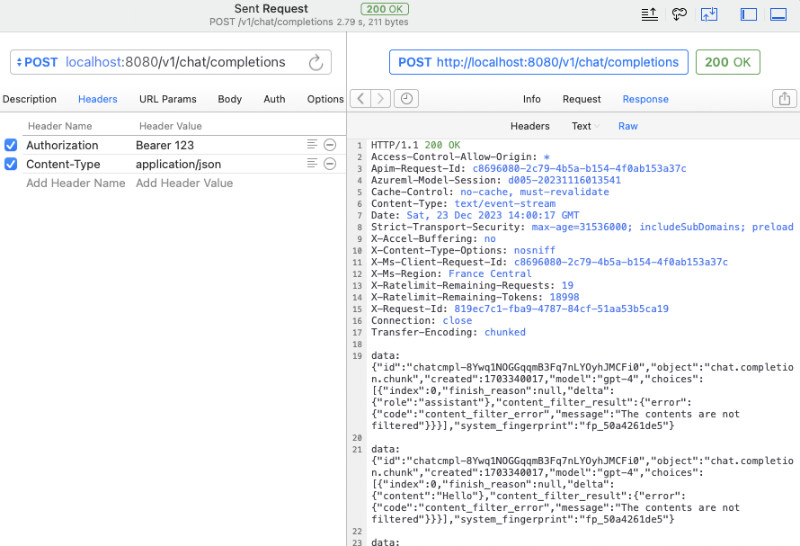

curl 사용하여 빠른 테스트를 수행 할 수 있습니다.

curl -v http://127.0.0.1:8080/v1/chat/completions

-H " Content-Type: application/json "

-H " Authorization: Bearer 123 "

-d ' {

"model": "gpt-4",

"messages": [

{

"role": "system",

"content": "You are a poetic assistant, skilled in explaining complex programming concepts with creative flair."

},

{

"role": "user",

"content": "Compose a poem that explains the concept of recursion in programming."

}

]

} '공식 OpenAI SDK를 통화에 사용하거나 OpenAi 호환 오픈 소스 소프트웨어를 사용할 수도 있습니다 (자세한 예제는 예를 참조하십시오).

from openai import OpenAI

client = OpenAI (

api_key = "your-key-or-input-something-as-you-like" ,

base_url = "http://127.0.0.1:8080/v1"

)

chat_completion = client . chat . completions . create (

messages = [

{

"role" : "user" ,

"content" : "Say this is a test" ,

}

],

model = "gpt-3.5-turbo" ,

)

print ( chat_completion ) API 키를 애플리케이션에 노출시키지 않거나 다양한 복잡한 오픈 소스 소프트웨어가 API 키 유출 위험이 있는지 여부에 대해 걱정하고 있다면 추가 AZURE_API_KEY=你的API Key 환경 변수를 구성 할 수 있으며 다양한 오픈 소스 소프트웨어가 요청시 API 키를 채울 필요가 없습니다 (또는 그냥 채우기 만하면).

물론, 일부 오픈 소스 소프트웨어에서 Azure의 일부 제한과 모델 호출 이름을 조정하기 때문에 원래 요청의 모델을 다음 방식으로 실제 요청에 매핑 할 수 있습니다. 예를 들어, GPT 3.5/4를 yi-34b-chat 로 바꾸십시오.

gpt-3.5-turbo:yi-34b-chat,gpt-4:yi-34b-chat yi-34b-chat 또는 gemini-pro 사용하려면 AOA_TYPE=yi 또는 AOA_TYPE=gemini 설정해야합니다.

이 프로젝트에는 현재 지원되는 세 가지 모델 인터페이스의 docker compose 샘플 파일이 example 되어 docker-compose.yml .

그런 다음 docker compose up 사용하여 서비스를 시작하면 빠르게 사용할 수 있습니다.

작업 모델 AOA_TYPE , 선택적 매개 변수, 기본값을 azure 로 조정하십시오.

# 选择一个服务, "azure", "yi", "gemini"

AOA_TYPE: " azure " 프로그램 서비스 주소, 선택적 매개 변수, 기본값으로 8080 및 0.0.0.0 :

# 服务端口,默认 `8080`

AOA_PORT: 8080

# 服务地址,默认 `0.0.0.0`

AOA_HOST: " 0.0.0.0 " Azure에 배포 된 OpenAI 서비스를 표준 OpenAI 통화로 변환하려면 다음 명령을 사용할 수 있습니다.

AZURE_ENDPOINT=https:// <你的 Endpoint 地址> .openai.azure.com/ AZURE_API_KEY= <你的 API KEY > AZURE_MODEL_ALIAS=gpt-3.5-turbo:gpt-35 ./amazing-openai-api 위의 명령에는 AZURE_ENDPOINT 와 AZURE_API_KEY Azure Deployment Gpt 3.5/GPT 4의 배포 이름이 포함되지 않기 때문에 AZURE_MODEL_ALIAS 사용하여 실제 Azure 배포 이름으로 요청한 모델 이름을 사용했습니다 . 이 기술은 다양한 오픈 소스 및 폐쇄 소스 소프트웨어에서 사용하는 모델을 자동으로 매핑하는 데 사용될 수도 있습니다.

# 比如不论是 3.5 还是 4 都映射为 `gpt-35`

AZURE_MODEL_ALIAS=gpt-3.5-turbo:gpt-35,gpt-4:gpt-35 AZURE_API_KEY 구성 했으므로 curl 을 추가 할 필요가 없습니다 Authorization: Bearer <你的API Key> (우연히 작성 가능)는 API 키를 엄격하게 재생하고 API 키의 보안을 향상시킵니다.

요청 헤더 매개 변수에 인증 내용을 추가하는 데 익숙한 경우 AZURE_API_KEY 포함되지 않은 다음 명령을 사용할 수 있으며 프로그램이 Azure 서비스에 대한 확인을 통과합니다.

AZURE_ENDPOINT=https:// <你的 Endpoint 地址> .openai.azure.com/ AZURE_MODEL_ALIAS=gpt-3.5-turbo:gpt-35 ./amazing-openai-api 특수 API 버전을 직접 지정하려면 API 버전의 유효성 검증을 강제로 AZURE_IGNORE_API_VERSION_CHECK=true 지정할 수 있습니다.

이미 Azure GPT Vision이있는 경우 SDK 통화를 사용하는 것 외에도이 문서를 참조하고 curl 사용하여 전화를 걸 수 있습니다. GPT Vision.

# (必选) Azure Deployment Endpoint URL

AZURE_ENDPOINT

# (必选) Azure API Key

AZURE_API_KEY

# (可选) 模型名称,默认 GPT-4

AZURE_MODEL

# (可选) API Version

AZURE_API_VER

# (可选) 是否是 Vision 实例

ENV_AZURE_VISION

# (可选) 模型映射别名

AZURE_MODEL_ALIAS

# (可选) Azure 网络代理

AZURE_HTTP_PROXY

AZURE_SOCKS_PROXY

# (可选) 忽略 Azure API Version 检查,默认 false,始终检查

AZURE_IGNORE_API_VERSION_CHECK공식 YI API를 표준 OpenAI 통화로 변환하려면 다음 명령을 사용할 수 있습니다.

AOA_TYPE=yi YI_API_KEY= <你的 API KEY > ./amazing-openai-api Azure Services 사용과 유사하게, 우리는 트릭을 사용하여 다양한 오픈 소스 폐쇄 소스 소프트웨어에서 사용하는 모델을 자동으로 매핑 할 수 있습니다.

# 比如不论是 3.5 还是 4 都映射为 `gpt-35`

YI_MODEL_ALIAS=gpt-3.5-turbo:yi-34b-chat,gpt-4:yi-34b-chat 서비스를 시작할 때 YI_API_KEY 구성하면 Authorization: Bearer <你的API Key> ( curl 작성할 수 있음)는 엄격한 API 키 격리를 제공하고 API 키의 보안을 향상시킵니다.

요청 헤더 매개 변수에 인증 내용을 추가하는 데 여전히 익숙한 경우 YI_API_KEY 포함되지 않은 다음 명령을 사용할 수 있으며 프로그램이 YI API 서비스로 확인됩니다.

./amazing-openai-api # (必选) YI API Key

YI_API_KEY

# (可选) 模型名称,默认 yi-34b-chat

YI_MODEL

# (可选) YI Deployment Endpoint URL

YI_ENDPOINT

# (可选) API Version,默认 v1beta,可选 v1

YI_API_VER

# (可选) 模型映射别名

YI_MODEL_ALIAS

# (可选) Azure 网络代理

YI_HTTP_PROXY

YI_SOCKS_PROXYGoogle의 공식 Gemini API를 표준 OpenAI 통화로 변환하려면 다음 명령을 사용할 수 있습니다.

AOA_TYPE=gemini GEMINI_API_KEY= <你的 API KEY > ./amazing-openai-api Azure Services 사용과 유사하게, 우리는 트릭을 사용하여 다양한 오픈 소스 폐쇄 소스 소프트웨어에서 사용하는 모델을 자동으로 매핑 할 수 있습니다.

# 比如不论是 3.5 还是 4 都映射为 `gpt-35`

GEMINI_MODEL_ALIAS=gpt-3.5-turbo:gemini-pro,gpt-4:gemini-pro 서비스를 시작할 때 GEMINI_API_KEY 구성하면 Authorization: Bearer <你的API Key> ( curl 작성할 수 있음)는 엄격한 API 키 격리를 제공하고 API 키의 보안을 향상시킵니다.

요청 헤더 매개 변수에 인증 내용을 추가하는 데 여전히 익숙한 경우 GEMINI_API_KEY 포함되지 않은 다음 명령을 사용할 수 있으며 프로그램은 Google AI 서비스로 확인됩니다.

./amazing-openai-api # (必选) Gemini API Key

GEMINI_API_KEY

# (可选) Gemini 安全设置,可选 `BLOCK_NONE` / `BLOCK_ONLY_HIGH` / `BLOCK_MEDIUM_AND_ABOVE` / `BLOCK_LOW_AND_ABOVE` / `HARM_BLOCK_THRESHOLD_UNSPECIFIED`

GEMINI_SAFETY

# (可选) Gemini 模型 版本,默认 `gemini-pro`

GEMINI_MODEL

# (可选) Gemini API 版本,默认 `v1beta`

GEMINI_API_VER

# (可选) Gemini API 接口地址

GEMINI_ENDPOINT

# (可选) 模型映射别名

GEMINI_MODEL_ALIAS

# (可选) Gemini 网络代理

GEMINI_HTTP_PROXY

GEMINI_SOCKS_PROXY