さまざまなモデルAPIを箱から出してOpenai API形式に変換します。

さまざまなモデルAPIをOpenAI API形式に変換することを可能にする10MB+ウィジェット。

現在のサポートされているモデル:

GitHubリリースページにアクセスして、オペレーティングシステムに合った実行ファイルをダウンロードしてください。

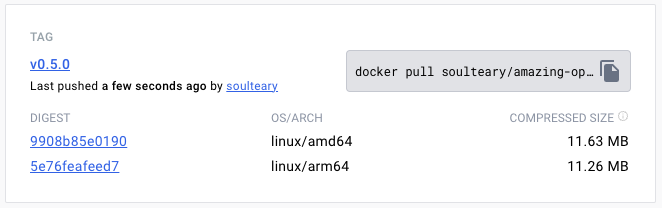

または、Docker Pullを使用して、指定されたバージョンの画像ファイルをダウンロードしてください。

docker pull soulteary/amazing-openai-api:v0.7.0AOA構成ファイルを記述する必要はなく、「作業モデルの選択」、「モデル操作に必要なパラメーターの設定」、「モデル互換性エイリアスの設定」など、環境変数を指定することにより、アプリケーションの動作を調整できます。

./aoaでAZURE_ENDPOINT=https://你的部署名称.openai.azure.com/ 、この時点で作業モデルをazureに設定します。

AZURE_ENDPOINT=https://你的部署名称.openai.azure.com/ ./aoaDockerを好む場合は、次のコマンドを使用できます。

docker run --rm -it -e AZURE_ENDPOINT=https://你的部署名称.openai.azure.com/ -p 8080:8080 soulteary/amazing-openai-api:v0.7.0サービスが開始された後、 http://localhost:8080/v1にアクセスして、Openaiと同じAPIサービスにアクセスできます。

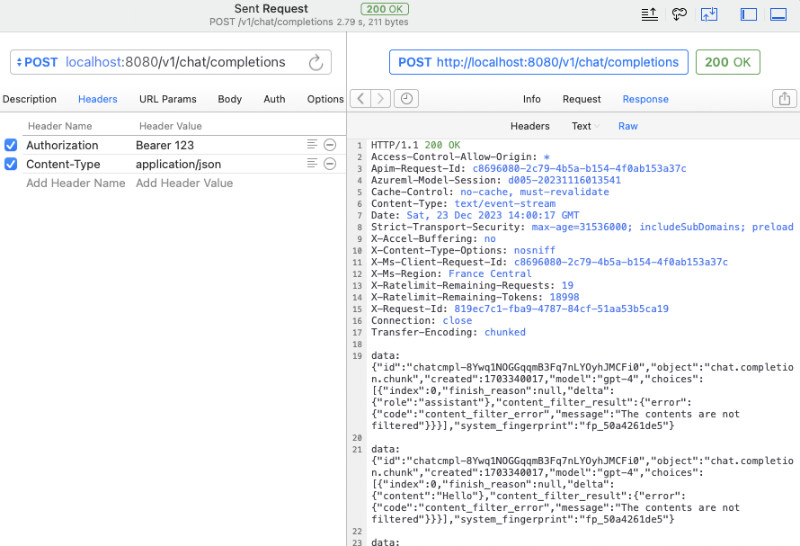

curlを使用して、クイックテストを実行できます。

curl -v http://127.0.0.1:8080/v1/chat/completions

-H " Content-Type: application/json "

-H " Authorization: Bearer 123 "

-d ' {

"model": "gpt-4",

"messages": [

{

"role": "system",

"content": "You are a poetic assistant, skilled in explaining complex programming concepts with creative flair."

},

{

"role": "user",

"content": "Compose a poem that explains the concept of recursion in programming."

}

]

} 'また、通話に公式Openai SDKを使用したり、OpenAI互換のオープンソースソフトウェアを使用したりすることもできます(例については、例を参照)。

from openai import OpenAI

client = OpenAI (

api_key = "your-key-or-input-something-as-you-like" ,

base_url = "http://127.0.0.1:8080/v1"

)

chat_completion = client . chat . completions . create (

messages = [

{

"role" : "user" ,

"content" : "Say this is a test" ,

}

],

model = "gpt-3.5-turbo" ,

)

print ( chat_completion ) APIキーをアプリケーションに公開したくない場合、またはさまざまな複雑なオープンソースソフトウェアがAPIキーリークのリスクがあるかどうかを心配している場合は、追加のAZURE_API_KEY=你的API Key環境変数を構成できます。

もちろん、Azureのいくつかの制限と、一部のオープンソースソフトウェアでモデルコール名の困難な調整があるため、元のリクエストのモデルを実際のモデル名にマップすることができます。たとえば、GPT 3.5/4をyi-34b-chatに置き換えます。

gpt-3.5-turbo:yi-34b-chat,gpt-4:yi-34b-chat yi-34b-chat 、またはgemini-proを使用する場合は、 AOA_TYPE=yiまたはAOA_TYPE=geminiを設定する必要があります。ただし、違いはありません。

このプロジェクトには、必要に応じて、 exampleディレクトリで現在サポートされている3つのモデルインターフェイスのdocker composeファイルdocker-compose.yml含まれています。

次に、 docker compose upを使用してサービスを開始すると、迅速に使用できます。

作業モデルAOA_TYPE 、オプションのパラメーターを調整し、デフォルトでazureになります。

# 选择一个服务, "azure", "yi", "gemini"

AOA_TYPE: " azure "プログラムサービスアドレス、オプションのパラメーター、デフォルトは8080および0.0.0.0になります。

# 服务端口,默认 `8080`

AOA_PORT: 8080

# 服务地址,默认 `0.0.0.0`

AOA_HOST: " 0.0.0.0 " Azureに展開されているOpenaiサービスを標準のOpenAIコールに変換する場合は、次のコマンドを使用できます。

AZURE_ENDPOINT=https:// <你的 Endpoint 地址> .openai.azure.com/ AZURE_API_KEY= <你的 API KEY > AZURE_MODEL_ALIAS=gpt-3.5-turbo:gpt-35 ./amazing-openai-api 上記のコマンドでは、Azure deployment GPT 3.5/GPT 4の展開名がAZURE_MODEL_ALIASを使用してモデル名を置き換えるため、Azure Openaiサービスにコア要素を含むAZURE_ENDPOINTとAZURE_API_KEYが含まれています.この手法は、さまざまなオープンソースおよびクローズドソースソフトウェアで使用されているモデルを自動的にマッピングして、次の手法を自動的にマッピングすることもできます。

# 比如不论是 3.5 还是 4 都映射为 `gpt-35`

AZURE_MODEL_ALIAS=gpt-3.5-turbo:gpt-35,gpt-4:gpt-35 AZURE_API_KEYを構成したため、 Authorization: Bearer <你的API Key> (さりげなくcurlこともできます)これが厳格なAPIキーイソレーションを再生し、APIキーのセキュリティを改善します。

要求ヘッダーパラメーターに認証コンテンツを追加することに慣れている場合は、 AZURE_API_KEYを含まない次のコマンドを使用できます。プログラムは、Azure Serviceに検証を通過します。

AZURE_ENDPOINT=https:// <你的 Endpoint 地址> .openai.azure.com/ AZURE_MODEL_ALIAS=gpt-3.5-turbo:gpt-35 ./amazing-openai-api 特別なAPIバージョンを自分で指定する場合は、 AZURE_IGNORE_API_VERSION_CHECK=trueを指定することができます。

既にAzure GPT Visionがある場合は、SDKコールの使用に加えて、このドキュメントを参照してcurlを使用してGPT Visionを呼び出すこともできます。

# (必选) Azure Deployment Endpoint URL

AZURE_ENDPOINT

# (必选) Azure API Key

AZURE_API_KEY

# (可选) 模型名称,默认 GPT-4

AZURE_MODEL

# (可选) API Version

AZURE_API_VER

# (可选) 是否是 Vision 实例

ENV_AZURE_VISION

# (可选) 模型映射别名

AZURE_MODEL_ALIAS

# (可选) Azure 网络代理

AZURE_HTTP_PROXY

AZURE_SOCKS_PROXY

# (可选) 忽略 Azure API Version 检查,默认 false,始终检查

AZURE_IGNORE_API_VERSION_CHECK公式YI APIを標準のOpenAIコールに変換する場合は、次のコマンドを使用できます。

AOA_TYPE=yi YI_API_KEY= <你的 API KEY > ./amazing-openai-api Azure Servicesの使用と同様に、トリックを使用して、さまざまなオープンソースのクローズドソースソフトウェアで使用されているモデルを自動的にマッピングして、次のモデルにマッピングできます。

# 比如不论是 3.5 还是 4 都映射为 `gpt-35`

YI_MODEL_ALIAS=gpt-3.5-turbo:yi-34b-chat,gpt-4:yi-34b-chatサービスを開始するときにYI_API_KEYを構成する場合、 Authorization: Bearer <你的API Key> ( curl書くこともできます)。

要求ヘッダーパラメーターに認証コンテンツを追加することに慣れている場合は、 YI_API_KEY含まない次のコマンドを使用でき、プログラムはYi APIサービスに検証を通過します。

./amazing-openai-api # (必选) YI API Key

YI_API_KEY

# (可选) 模型名称,默认 yi-34b-chat

YI_MODEL

# (可选) YI Deployment Endpoint URL

YI_ENDPOINT

# (可选) API Version,默认 v1beta,可选 v1

YI_API_VER

# (可选) 模型映射别名

YI_MODEL_ALIAS

# (可选) Azure 网络代理

YI_HTTP_PROXY

YI_SOCKS_PROXYGoogleの公式Gemini APIを標準のOpenAIコールに変換したい場合は、次のコマンドを使用できます。

AOA_TYPE=gemini GEMINI_API_KEY= <你的 API KEY > ./amazing-openai-api Azure Servicesの使用と同様に、トリックを使用して、さまざまなオープンソースのクローズドソースソフトウェアで使用されているモデルを自動的にマッピングして、次のモデルにマッピングできます。

# 比如不论是 3.5 还是 4 都映射为 `gpt-35`

GEMINI_MODEL_ALIAS=gpt-3.5-turbo:gemini-pro,gpt-4:gemini-proサービスを開始するときにGEMINI_API_KEYを構成する場合、 Authorization: Bearer <你的API Key> ( curl書くこともできます)。

要求ヘッダーパラメーターに認証コンテンツを追加することに慣れている場合は、 GEMINI_API_KEY含まない次のコマンドを使用できます。プログラムは、検証を検証を継続してGoogle AIサービスに渡すことができます。

./amazing-openai-api # (必选) Gemini API Key

GEMINI_API_KEY

# (可选) Gemini 安全设置,可选 `BLOCK_NONE` / `BLOCK_ONLY_HIGH` / `BLOCK_MEDIUM_AND_ABOVE` / `BLOCK_LOW_AND_ABOVE` / `HARM_BLOCK_THRESHOLD_UNSPECIFIED`

GEMINI_SAFETY

# (可选) Gemini 模型 版本,默认 `gemini-pro`

GEMINI_MODEL

# (可选) Gemini API 版本,默认 `v1beta`

GEMINI_API_VER

# (可选) Gemini API 接口地址

GEMINI_ENDPOINT

# (可选) 模型映射别名

GEMINI_MODEL_ALIAS

# (可选) Gemini 网络代理

GEMINI_HTTP_PROXY

GEMINI_SOCKS_PROXY