最近、GoogleはPaligemma2Mixと呼ばれる新しいVision-Languageモデル(VLM)をリリースしました。これは、画像とテキスト処理の分野で人工知能技術の主要なブレークスルーを示すイノベーションです。 paligemma2mixは、視覚情報とテキスト入力を同時に処理するだけでなく、要件に応じて対応する出力を生成し、マルチタスクの強力な技術サポートを提供することもできます。

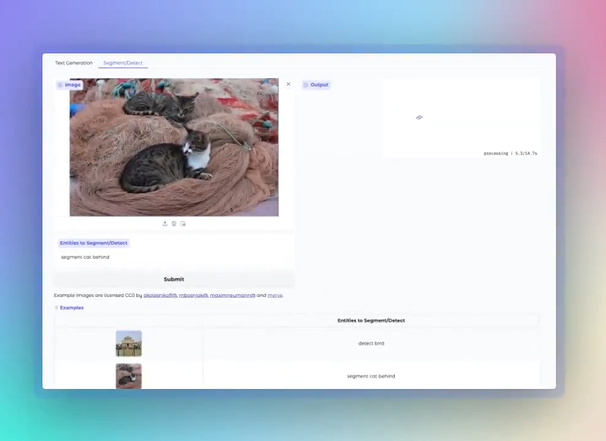

paligemma2mixには非常に包括的な機能があり、画像説明、光学文字認識(OCR)、画像の質問と回答、オブジェクト検出、画像セグメンテーションなどのさまざまな視覚言語タスクをカバーしています。開発者または研究者が、トレーニング前のチェックポイントを介してモデルを直接使用できるか、特定のニーズに応じて微調整して、さまざまなアプリケーションシナリオのニーズを満たすことができるかどうか。

Paligemma2の最適化バージョンとして、Paligemma2Mixは、開発者により便利な探索体験を提供することを目指して、ハイブリッドタスクに対して特別に調整されています。このモデルは、3B(30億パラメーター)、10b(100億パラメーター)、28b(280億パラメーター)を含む3つのパラメータースケールを提供し、224pxと448pxの2つの解像度をサポートします。

Paligemma2Mixのコア機能的ハイライトには、画像の説明、光学文字認識(OCR)、画像の質問と回答、オブジェクトの検出が含まれます。画像の説明に関しては、モデルは、ビーチに立っている牛の絵を識別したり、豊富な説明を提供するなど、詳細な短い説明または長い説明を生成することができます。 OCRに関しては、画像からテキストを抽出し、ロゴ、ラベル、ドキュメントコンテンツを識別し、情報抽出に大きな利便性を提供できます。さらに、ユーザーは写真をアップロードして質問することもできます。モデルは写真を分析し、正確な回答を提供し、動物、車両などの画像内の特定のオブジェクトを識別することもできます。

開発者は、KaggleおよびHugging Face Platformを介してPaligemma2mixの混合重量をダウンロードして、さらなる実験と開発を促進できることに言及する価値があります。このモデルに興味がある場合は、Faceのデモンストレーションプラットフォームを抱きしめて、その強力な機能とアプリケーションの可能性についての洞察を得ることができます。

Paligemma2Mixの発売により、Googleの視野モデルの分野での研究は、もう1つの重要な一歩を踏み出しました。このモデルは、人工知能技術の大きな可能性を実証するだけでなく、将来の実用的なアプリケーションの可能性も提供します。この技術がより多くの分野でその価値を示し、人工知能技術のさらなる開発を促進できることを楽しみにしています。

技術レポート:https://arxiv.org/abs/2412.03555