最新のニュースによると、iPhone15Proユーザーは主要なアップデートを案内します。Appleの視覚インテリジェンス機能は、2023年にリリースされたProシリーズのフラッグシップモデルで正式に発売されます。このニュースは、iPhone15ProユーザーがiPhone16シリーズにアップグレードするかどうかを確認するときに既存のデバイスを維持する別の理由を意味するため、多くのユーザーを励起します。

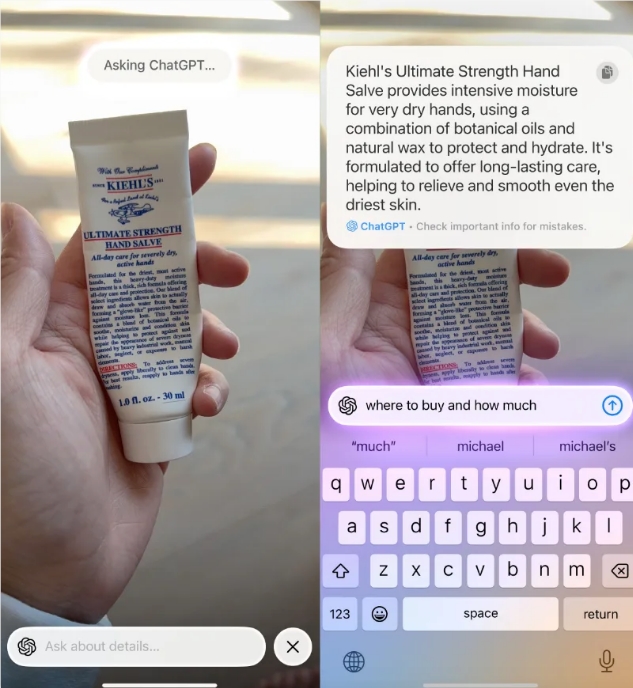

ビジュアルインテリジェンス機能は、GoogleのGoogleレンズに似ており、Apple Intelligence AI機能スイートの重要な部分です。この機能を使用すると、ユーザーはAIを使用して、オブジェクトにカメラをポイントするだけでリアルタイム分析を実行できます。いくつかのタスクを独立して完了することができますが、ChatGPTやGoogleイメージ検索などの画面ショートカットからより実用的な情報は、ユーザーエクスペリエンスをさらに向上させます。

iPhone16およびiPhone16Proユーザーの場合、視覚インテリジェンス関数は、専用の写真ボタンを長く押すことでトリガーできます。ただし、iPhone15Pro、Pro Max、および最近リリースされたiPhone16Eには物理カメラボタンがないため、これらの3つのデバイスは操作ボタンに、またはコントロールセンターのショートカットを介して機能を割り当てる必要があります。この機能は、今後のソフトウェアアップデートで利用できると報告されています。

中毒技術のcherlynnは、視覚知能の実用性の例を示しています。たとえば、ユーザーがクローゼットにユニークなパターンのタオルのセットを見つけ、購入する場所をより多く購入したいが、視覚インテリジェンス機能をアクティブにし、Google検索ショートカットを選択し、好きな製品が検索結果に表示されるかどうかを確認できます。さらに、ユーザーはCHATGPTを使用して、製品と注文チャネルに関する詳細情報を要求することもできます。これにより、日常生活が大幅に促進されます。

Visual Intelligence機能はGoogleやOpenaiの助けに完全に依存しておらず、独立して実行することもできます。ユーザーはテキストと直接対話して、翻訳、読み取り、および要約操作を実行できます。さらに、ユーザーはこの機能を使用して、営業時間、メニュー、サービス、さらには直接購入製品の視聴など、携帯電話が指摘したビジネス情報を理解し、アプリケーションシナリオの多様性をさらに改善することもできます。

現在、AppleはどのiOSバージョンがiPhone 15 ProシリーズにApple Intelligenceの視覚検索機能をもたらすかを明らかにしていません。しかし、大胆なファイアボールのジョン・グルーバーは、この機能がiOS 18.4に表示され、ベータベータに「いつでも」表示される可能性があると推測しています。これは、iPhone 15 ProとPro Maxのユーザーがこの便利な機能をすぐに体験することが期待されていることを意味し、ソフトウェアのベータ版を試してみる人にとっては、エクスペリエンスが早くなる可能性があります。

一般に、視覚インテリジェンス機能を追加すると、間違いなくiPhone15Proユーザーにより多くの利便性と可能性がもたらされます。日常生活のニーズであろうと、商人情報の迅速な獲得であろうと、この機能はユーザーの手の中で右側のアシスタントになります。 iOSの更新が近づくと、ユーザーはこの機能の公式発売を楽しみにしており、それがもたらすインテリジェントエクスペリエンスを楽しむことができます。