Laut den neuesten Nachrichten werden iPhone15Pro -Benutzer ein wichtiges Update einleiten: Die visuelle Intelligenzfunktion von Apple wird offiziell in den im Jahr 2023 veröffentlichten Pro -Serie -Flaggschiff -Modellen gestartet. Diese Nachricht wird zweifellos viele Benutzer anregt, da dies bedeutet, dass iPhone15PRO -Benutzer vorhandene Geräte beibehalten werden, wenn Sie überlegen, ob auf die iPhone16 -Serie aufgerüstet werden sollen.

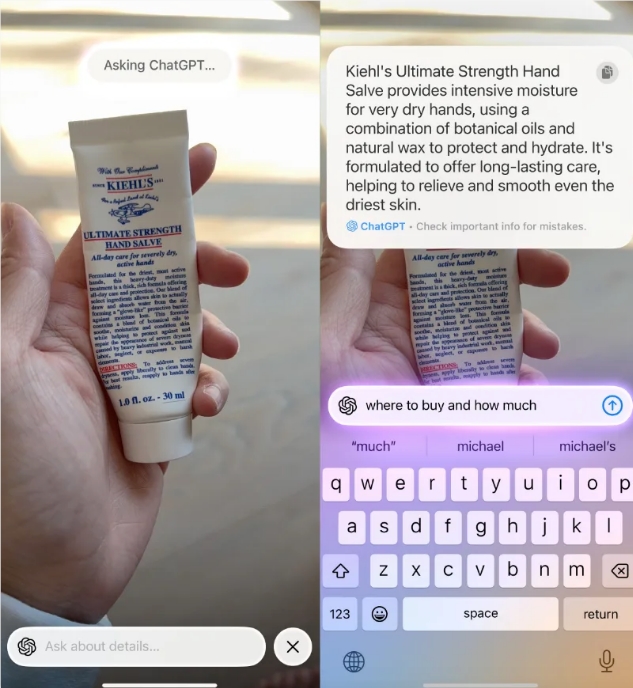

Visuelle Intelligenzfunktionen ähneln dem Google Lens von Google und sind ein wichtiger Bestandteil der Apple Intelligence AI Feature Suite. Mit dieser Funktion können Benutzer AI verwenden, um eine Echtzeitanalyse durchzuführen, indem sie einfach auf die Kamera auf das Objekt hinweisen. Während es einige Aufgaben unabhängig erledigen kann, stammen praktischere Informationen aus den Abkürzungen im Bildschirm, wie z.

Für die iPhone16- und iPhone16PRO -Benutzer kann die Funktion Visual Intelligence ausgelöst werden, indem das dedizierte Fotolaste lange gedrückt wird. Da jedoch das iPhone15pro, Pro Max und das kürzlich veröffentlichte iPhone16e keine physische Kamera -Taste haben, müssen diese drei Geräte die Funktion der Operationsschaltfläche oder über die Control Center -Verknüpfung zuweisen. Es wird berichtet, dass diese Funktion in einem bevorstehenden Software -Update verfügbar sein wird.

Cherlynn Low of Addiction Technology gibt ein Beispiel für die Praktikabilität der visuellen Intelligenz. Wenn ein Benutzer beispielsweise eine Reihe von Handtüchern mit einzigartigen Mustern in seinem Schrank findet, mehr kaufen möchte, aber den Ort zum Kauf vergisst, kann er die Funktion Visual Intelligence aktivieren, Google -Search -Verknüpfungen auswählen und prüfen, ob das Produkt, das Sie wie in den Suchergebnissen erscheint, erscheint. Darüber hinaus können Benutzer ChatGPT verwenden, um detaillierte Informationen über das Produkt und die Bestellkanäle zu bitten, die das tägliche Leben erheblich erleichtern.

Es ist erwähnenswert, dass die Funktion visueller Intelligenz nicht ausschließlich auf der Hilfe von Google oder OpenAI beruht, sondern auch unabhängig ausführen kann. Benutzer können direkt mit dem Text interagieren, um Operationen zu übersetzen, zu lesen und zusammenzufassen. Darüber hinaus können Benutzer diese Funktion auch nutzen, um die Geschäftsinformationen zu verstehen, auf die ihre Mobiltelefone wie die Anzeige der Geschäftszeiten, der Menüs, der Dienstleistungen und sogar des direkten Kaufprodukts angezeigt werden, wodurch die Vielfalt ihrer Anwendungsszenarien weiter verbessert wird.

Derzeit hat Apple nicht bekannt gegeben, welche iOS -Version die visuelle Suchfunktion von Apple Intelligence in die iPhone 15 Pro -Serie bringt. John Gruber von gewagter Feuerball spekuliert jedoch, dass das Feature in iOS 18.4 und jederzeit in Beta Beta erscheinen kann. Dies bedeutet, dass von Benutzern des iPhone 15 Pro und Pro Max diese bequeme Funktion in Kürze erleben wird. Für diejenigen, die bereit sind, die Beta -Version der Software auszuprobieren, kann die Erfahrung früher sein.

Im Allgemeinen bringt die Hinzufügung von visuellen Intelligenzfunktionen zweifellos mehr Bequemlichkeit und Möglichkeiten zu iPhone15Pro -Benutzern. Unabhängig davon, ob es sich um den Einkaufsbedarf im täglichen Leben oder um den schnellen Erwerb von Händlerinformationen handelt, wird diese Funktion in den Händen von Benutzern ein Rechtsassistent. Wenn sich iOS -Update nähert, können sich Benutzer auf den offiziellen Start dieser Funktion freuen und die intelligente Erfahrung genießen, die sie mit sich bringt.