マルチモーダル大手言語モデル(MLLM)の急速な発展により、超長ビデオの効率的な処理が現在の研究でホットなトピックになっています。既存のモデルは、コンテキストの長さと計算コストによって制限されることが多く、時間ごとのビデオを効果的に理解することが困難になります。この課題に対応して、Zhiyuan Research Instituteといくつかの大学は、効率的な時間レベルのビデオ理解のために特別に設計された非常に長い視覚言語モデルであるVideo-XLを立ち上げました。

現在、Multimodal Large Language Model(MLLM)はビデオ理解の分野で大きな進歩を遂げていますが、超長いビデオの処理は依然として課題です。 これは、MLLMが最大コンテキスト長を超え、マーク凝集によって引き起こされる情報減衰の影響を受ける数千の視覚マーカーを処理するのに苦労することが多いためです。 同時に、多数のビデオタグも高いコンピューティングコストをもたらします。

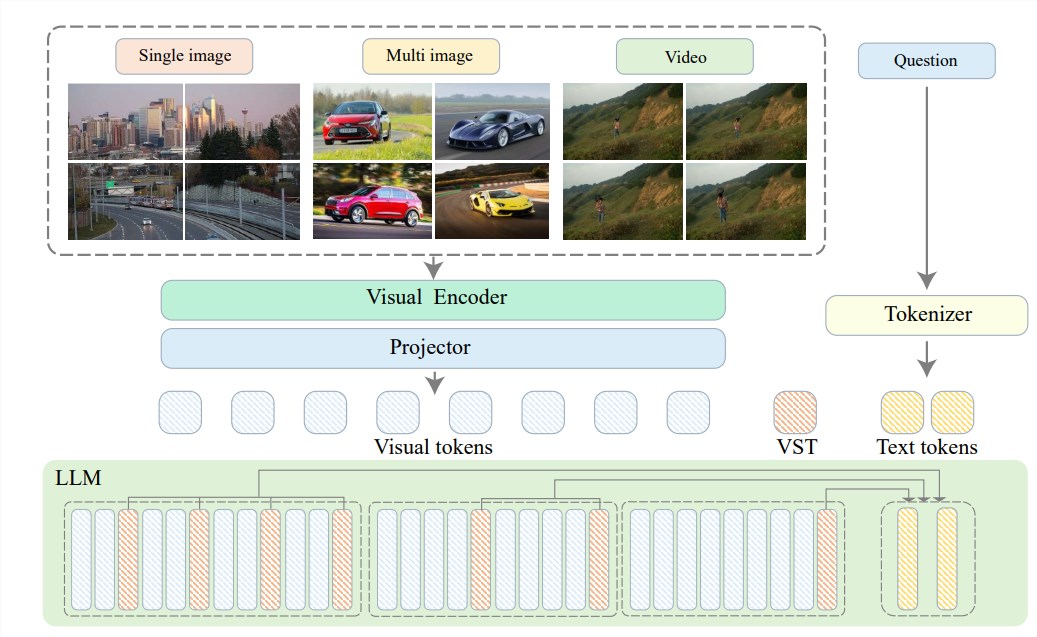

これらの問題を解決するために、Zhiyuan Research Instituteは、上海Jiaotong大学、中国のRenmin University of Posts and Telecommunicationsの北京大学と協力して、効率的な時間レベルのビデオ理解に専門化されていることを提案しています言語モデル。 Video-XLの中心には、LLMに固有のコンテキストモデリング機能を利用して、長い視覚表現をよりコンパクトなフォームに効果的に圧縮する「視覚的コンテキスト潜在的概要」テクノロジーにあります。

簡単に言えば、ビデオコンテンツをより合理的な形に圧縮することです。牛肉全体を牛肉のボウルに集中させるのと同じように、モデルが消化して吸収するのに便利です。

この圧縮技術は、効率を改善するだけでなく、ビデオの重要な情報を効果的に保持します。長い女性の足のバインディングのように、長い女性のように、長いビデオが多くの冗長な情報で満たされていることが多いことを知っておく必要があります。 Video-XLは、これらの役に立たない情報を正確に排除し、エッセンスのみを保持できます。これにより、長いビデオコンテンツを理解するときにモデルが方向を失わないようにします。

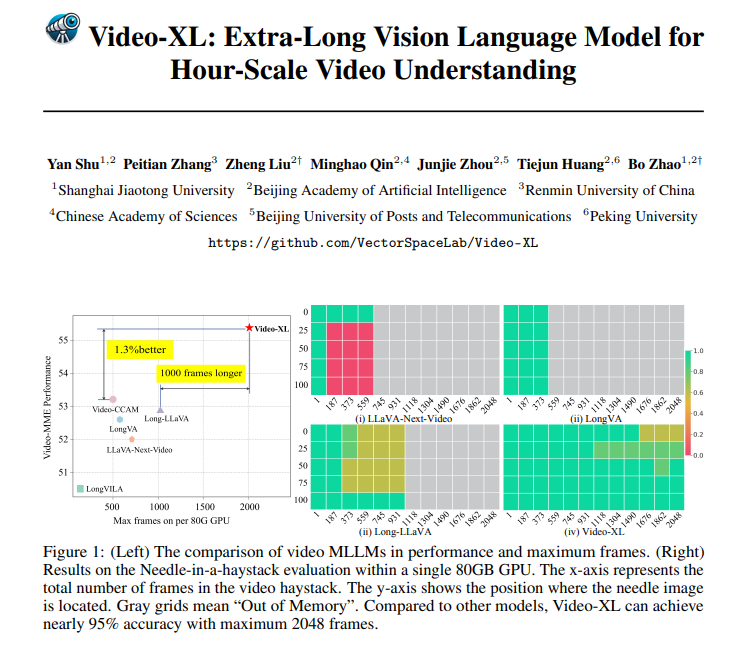

Video-XLは理論上非常に強力であるだけでなく、非常に強力な実用的な能力を持っています。 Video-XLは、特にVNBenchテストでは、最良の既存の方法よりも10%近く高い精度で、複数の長いビデオ理解ベンチマークで先導しています。

さらに印象的なのは、Video-XLが効率と有効性の驚くべきバランスをとっていることです。これは、単一の80GB GPUで2048フレームのビデオを処理しながら、「干し草の針を見つける」評価率の95%近くの精度を維持できることです。

Video-XLには非常に広範なアプリケーションの見通しがあります。一般的な長いビデオの理解に加えて、映画の概要、異常検出の監視、広告インプラントの認識など、特定のタスクにも能力がある可能性があります。

これは、将来映画を見るときに長いプロットに耐える必要がないことを意味します。マニュアルストーキングよりもはるかに効率的です。

プロジェクトアドレス:https://github.com/vectorspacelab/video-xl

論文:https://arxiv.org/pdf/2409.14485

要するに、Video-XLは、その効率と精度の分野で、将来のビデオ分析アプリケーションの強力な技術的サポートを提供しています。