Mit der schnellen Entwicklung des multimodalen Großsprachmodells (MLLM) ist die effiziente Verarbeitung von ultra langem Video zu einem heißen Thema in der aktuellen Forschung geworden. Bestehende Modelle werden häufig durch Kontextlänge und Rechenkosten eingeschränkt, wodurch es schwierig ist, Stundenvideos effektiv zu verstehen. Als Reaktion auf diese Herausforderung haben das Zhiyuan Research Institute und mehrere Universitäten Video-XL gestartet, ein ultra langes visuelles Sprachmodell, das speziell für ein effizientes Video verstehen.

Derzeit hat das multimodale Großsprachmodell (MLLM) im Bereich des Videoverständnisses erhebliche Fortschritte erzielt, aber der Umgang mit ultra-langen Videos bleibt eine Herausforderung. Dies liegt daran, dass MLLMs häufig Schwierigkeiten haben, Tausende von visuellen Markern zu bewältigen, die die maximale Kontextlänge überschreiten und durch die durch Markaggregation verursachte Informationsdämpfung beeinflusst werden. Gleichzeitig bringt eine große Anzahl von Video -Tags auch hohe Rechenkosten ein.

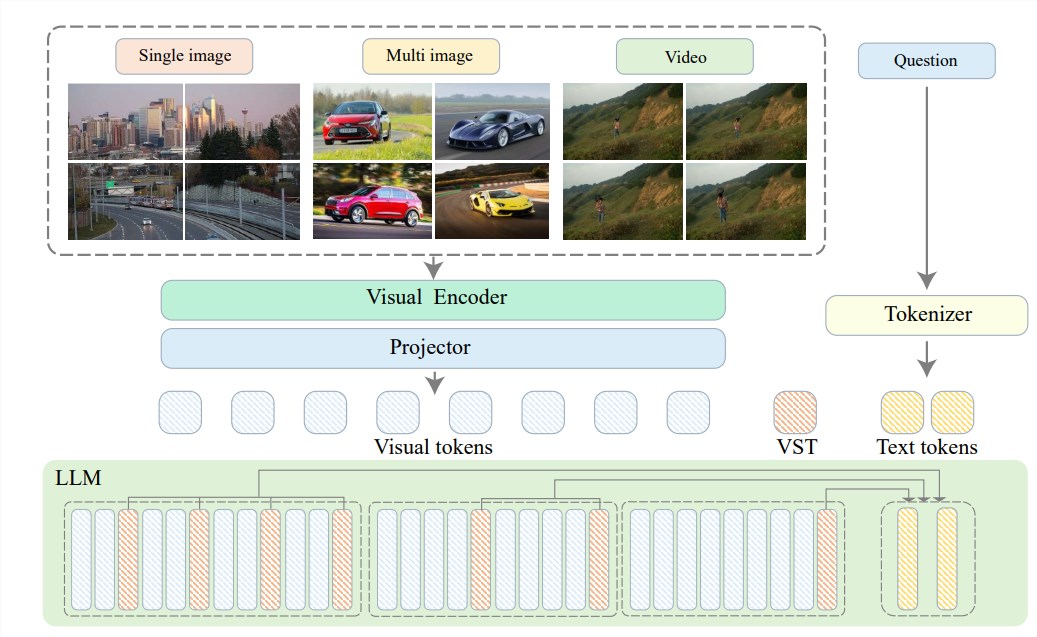

Um diese Probleme zu lösen, hat das Zhiyuan Research Institute Video-XL in Verbindung mit der Shanghai Jiaotong University, der Renmin University of China, der Peking University und der Peking University of Posts and Telecommunications vorgeschlagen Sprachmodell. Das Herzstück von Video-XL liegt in der Technologie „Visual Context Potential Summary“, in der die mit LLM inhärente Kontextmodellierungsfunktionen verwendet werden, um lange visuelle Darstellungen effektiv in kompaktere Formen zu komprimieren.

Einfach ausgedrückt, es soll den Videoinhalt in eine optimiertere Form komprimieren, genau wie das Konzentrieren eines ganzen Rindfleisches in eine Schüssel mit Rindfleischessenz, die für das Modell zum Verdauen und Absorpten bequem ist.

Diese Komprimierungstechnologie verbessert nicht nur die Effizienz, sondern behält auch die wichtigsten Informationen des Videos effektiv bei. Sie sollten wissen, dass lange Videos oft mit vielen redundanten Informationen gefüllt sind, genau wie die Fußbindung einer alten Dame, die lang und stinkend ist. Video-XL kann diese nutzlosen Informationen genau beseitigen und nur die Essenz beibehalten, was sicherstellt, dass das Modell beim Verständnis langer Videoinhalte nicht seine Richtung verliert.

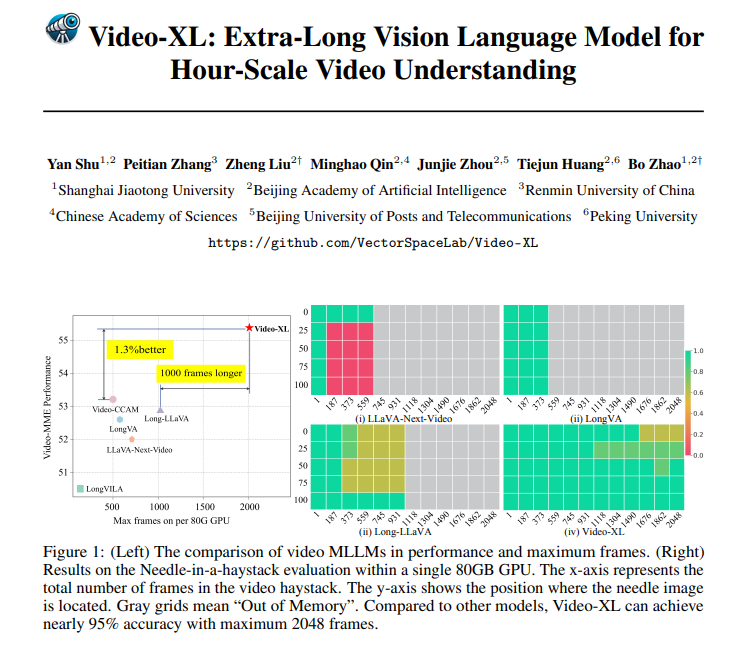

Video-XL ist theoretisch nicht nur sehr mächtig, sondern hat auch eine sehr starke praktische Fähigkeit. Video-XL war in mehreren langen Videoverständnissen, insbesondere im VNBench-Test, mit einer Genauigkeit von fast 10% höher als die besten vorhandenen Methoden.

Noch beeindruckender ist, dass Video-XL ein erstaunliches Gleichgewicht zwischen Effizienz und Effektivität trifft. Es kann 2048-Video-Frames für eine einzelne 80-GB-GPU verarbeiten und gleichzeitig eine Genauigkeit von fast 95% in der Bewertungsrate „Find a Nadel in a Haystack“ beibehalten.

Video-XL hat eine sehr breite Anwendungsaussicht. Neben dem Verständnis allgemeiner langer Videos kann es auch für bestimmte Aufgaben kompetent sein, wie z. B. Filmzusammenfassung, Überwachung der Anomalie -Erkennung und Erkennung von Werbeimplantaten.

Dies bedeutet, dass Sie die langwierige Handlung in Zukunft nicht ertragen müssen. Ereignisse, die viel effizienter als manuelles Stalking sind.

Projektadresse: https://github.com/vectorspacelab/video-xl

Papier: https://arxiv.org/pdf/2409.14485

Kurz gesagt, Video-XL hat den Durchbruch auf dem Gebiet des ultra-langen Videoverständnisses durcheinander gebracht.