Avec le développement rapide du modèle multimodal grand langage (MLLM), le traitement efficace de la vidéo ultra-longue est devenu un sujet brûlant dans la recherche actuelle. Les modèles existants sont souvent limités par la longueur du contexte et le coût de calcul, ce qui rend difficile la compréhension efficace des vidéos horaires. En réponse à ce défi, le Zhiyuan Research Institute et plusieurs universités ont lancé Video-XL, un modèle de langage visuel ultra-long conçu spécifiquement pour une compréhension efficace de la vidéo au niveau de l'heure.

Actuellement, le modèle de grande langue multimodal (MLLM) a fait des progrès significatifs dans le domaine de la compréhension vidéo, mais la gestion des vidéos ultra-longues reste un défi. En effet, les MLLM ont souvent du mal à gérer des milliers de marqueurs visuels qui dépassent la longueur du contexte maximum et sont affectés par l'atténuation de l'information causée par l'agrégation de marque. Dans le même temps, un grand nombre de balises vidéo entraîneront également des coûts informatiques élevés.

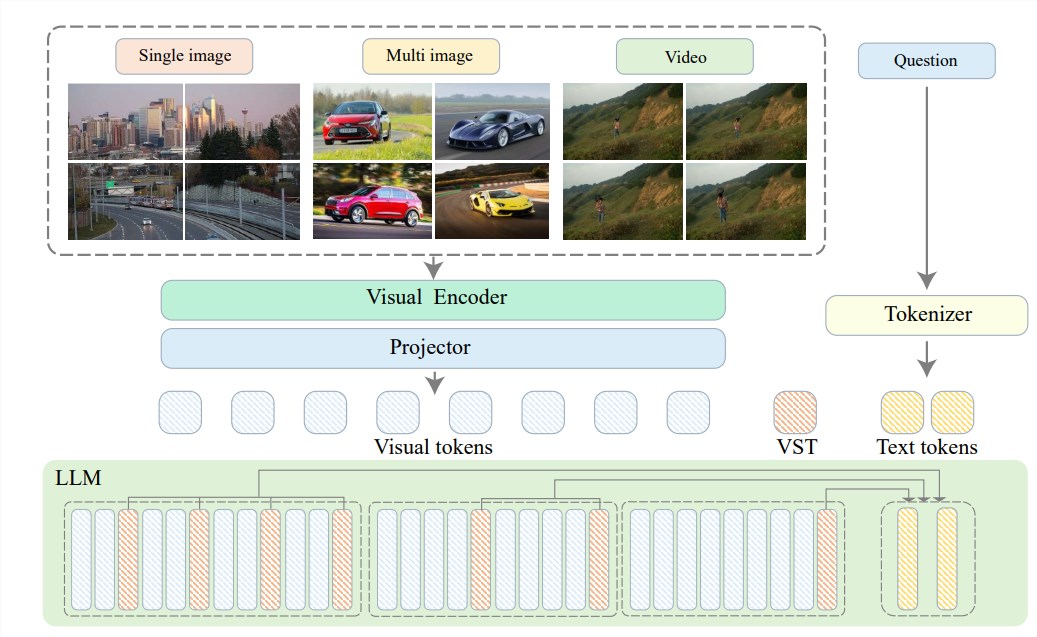

Pour résoudre ces problèmes, le Zhiyuan Research Institute a proposé la vidéo-XL en collaboration avec l'Université de Shanghai Jiaotong, l'Université Renmin de Chine, l'Université de Pékin et l'Université des publications et les télécommunications de Pékin, une compréhension de la vidéo visuelle de longue date. modèle de langue. Au cœur de la vidéo-XL réside dans la technologie du «Résumé du potentiel de contexte visuel», qui utilise les capacités de modélisation de contexte inhérentes à la LLM pour compresser efficacement les longues représentations visuelles en formes plus compactes.

Autrement dit, il s'agit de comprimer le contenu vidéo sous une forme plus rationalisée, tout comme la concentration d'un bœuf entier dans un bol d'essence de bœuf, ce qui est pratique pour le modèle pour digérer et absorber.

Cette technologie de compression améliore non seulement l'efficacité, mais conserve également efficacement les informations clés de la vidéo. Vous devez savoir que les longues vidéos sont souvent remplies de beaucoup d'informations redondantes, tout comme la liaison du pied d'une vieille dame, qui est longue et malodorante. Video-XL peut éliminer avec précision ces informations inutiles et conserver uniquement l'essence, ce qui garantit que le modèle ne perdra pas sa direction lors de la compréhension du contenu vidéo long.

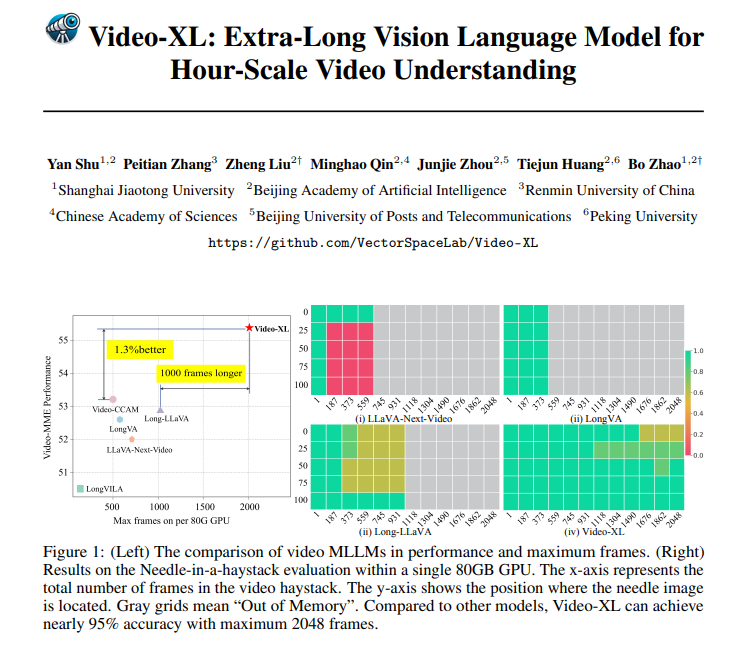

La vidéo-XL est non seulement très puissante en théorie, mais a également une capacité pratique très puissante. Video-XL a ouvert la voie dans plusieurs repères de compréhension vidéo longs, en particulier dans le test VNBench, avec une précision de près de 10% plus élevée que les meilleures méthodes existantes.

Ce qui est encore plus impressionnant, c'est que la vidéo-XL établit un équilibre étonnant entre l'efficacité et l'efficacité, il peut traiter 2048 images de vidéos sur un seul GPU de 80 Go tout en maintenant une précision de près de 95% dans le taux d'évaluation de "Trouver une aiguille dans une botte de foin".

VIDEO-XL a une perspective d'application très large. En plus de comprendre les vidéos longues générales, elle peut également être compétente pour certaines tâches, telles que le résumé des films, la surveillance de la détection des anomalies et de la reconnaissance des implants publicitaires.

Cela signifie que vous n'avez pas à supporter la longue intrigue lorsque vous regardez des films à l'avenir. Événements, qui est beaucoup plus efficace que le harcèlement manuel.

Adresse du projet: https://github.com/vectorspacelab/video-xl

Papier: https://arxiv.org/pdf/2409.14485

En bref, Video-XL a fait des progrès révolutionnaires dans le domaine de la compréhension vidéo ultra-longue.