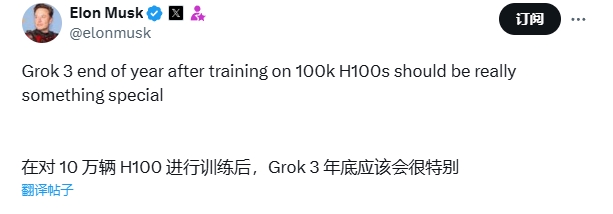

マスク氏の人工知能企業 xAI は、新しい大規模言語モデル Grok-2 を立ち上げようとしており、後継モデル Grok-3 のウォームアップを開始しています。 Grok-3 のトレーニングでは、驚異的な 100,000 個の NVIDIA H100 チップが使用されており、そのパフォーマンスが前例のない高みに達することが示されています。これは、xAI の強力な研究開発能力を証明するだけでなく、AI テクノロジーの将来の発展について人々の無限の想像力を刺激します。この記事では、Grok-3 のトレーニング規模、コスト、潜在的な技術的ブレークスルーについて詳細に説明し、xAI と Tesla の間でのリソース共有の可能性について説明しています。

マスク氏はAIの研究開発における高品質のデータセットの重要性を強調し、既存モデルのデータ処理の課題を指摘した。 Grok-3 プロジェクトは高価で、トレーニングに使用される 10 万個の Nvidia H100 チップは最大 30 億米ドルから 40 億米ドルの価値があり、これはテスラの今年の Nvidia チップの調達予算に匹敵するものであり、テスラ間のリソースの共有に関する憶測を引き起こしています。 2つの会社。 Grok-2 と Grok-3 の発売は、人工知能の分野で xAI が講じた大胆な一歩を示すものであり、AI テクノロジーの新たな変化の到来を告げるものでもあります。

NVIDIA H100 は、大規模言語モデル (LLM) データを処理するために設計された最先端のチップであり、単一チップの価格は最大 30,000 ~ 40,000 米ドル (約 219,000 ~ 292,000 元) で、xAI の投資額は 100,000 です。総額は30億~40億ドル(現在の為替レートで約218億6,800万~291億5,700万元)と見積もられ、空へと舞い上がった。

注目に値するのは、マスク氏が以前、今年のテスラのNVIDIAチップ購入予算もこの範囲内であることを明らかにしており、xAIがテスラのリソースに依存しているのではないかと人々が推測していることだ。

Grok-2 の今後のリリースと Grok-3 の集中的な準備により、マスク氏のリーダーシップの下、xAI は人工知能の分野における新たな変化を主導しています。

xAI への巨額の投資とデータ品質の重視は、将来、人工知能の分野でさらなる進歩が起こることを示しています。 Grok-2 と Grok-3 の発売は、それらが人工知能の分野で本当に新しい章を導くことができるかどうかを確認するのを待つ価値があります。 これはテクノロジー業界全体に重大な影響を与えるでしょう。