Songtao Liu、Di Huang、Yunhong Wang

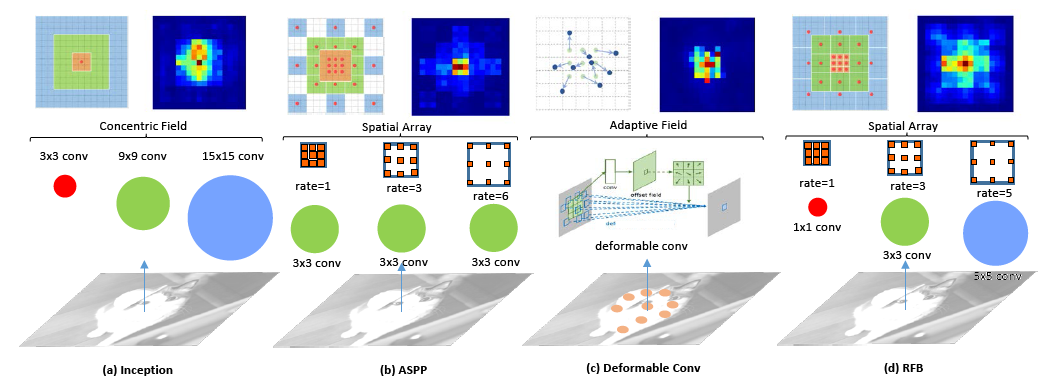

人間の視覚システムの受容フィールド(RFS)の構造に触発され、RFのサイズと偏心の関係を考慮して、機能の識別性と堅牢性を高める新しいRFブロック(RFB)モジュールを提案します。さらに、軽量CNNモデルでRFBモジュールをSSDの上部に組み立て、RFBネット検出器を構築します。コードを使用して、オブジェクト検出のためにRFBネットをトレーニング/評価できます。詳細については、ECCVペーパーを参照してください。

| システム | 地図 | FPS (タイタンXマックスウェル) |

|---|---|---|

| より速いR-CNN(VGG16) | 73.2 | 7 |

| yolov2(darknet-19) | 78.6 | 40 |

| r-fcn(resnet-101) | 80.5 | 9 |

| SSD300*(VGG16) | 77.2 | 46 |

| SSD512*(VGG16) | 79.8 | 19 |

| rfbnet300(vgg16) | 80.7 | 83 |

| rfbnet512(vgg16) | 82.2 | 38 |

| システム | Test-devマップ | 時間(タイタンxマックスウェル) |

|---|---|---|

| より速いR-CNN ++(ResNet-101) | 34.9 | 3.36s |

| yolov2(darknet-19) | 21.6 | 25ms |

| SSD300*(VGG16) | 25.1 | 22ms |

| SSD512*(VGG16) | 28.8 | 53ms |

| retinanet500(resnet-101-fpn) | 34.4 | 90ms |

| rfbnet300(vgg16) | 30.3 | 15ms |

| rfbnet512(vgg16) | 33.8 | 30ms |

| rfbnet512-e(vgg16) | 34.4 | 33ms |

| システム | ココミニバルマップ | #parameters |

|---|---|---|

| SSD MobileNet | 19.3 | 6.8m |

| RFB MobileNet | 20.7 | 7.4m |

それがあなたの研究に役立つなら、あなたの出版物で私たちの論文を引用してください:

@InProceedings{Liu_2018_ECCV,

author = {Liu, Songtao and Huang, Di and Wang, andYunhong},

title = {Receptive Field Block Net for Accurate and Fast Object Detection},

booktitle = {The European Conference on Computer Vision (ECCV)},

month = {September},

year = {2018}

}

./make.sh注:utils/build.py、行131のGPUアーキテクチャサポートを確認してください。デフォルトは次のとおりです。

'nvcc': ['-arch=sm_52',

conda install opencv注:トレーニングについては、現在VOCとCOCOをサポートしています。

物事を簡単にするために、 torch.utils.data.Datasetを継承するシンプルなVOCおよびCOCOデータセットローダーを提供し、 torchvision.datasets APIと完全に互換性があります。

# specify a directory for dataset to be downloaded into, else default is ~/data/

sh data/scripts/VOC2007.sh # <directory> # specify a directory for dataset to be downloaded into, else default is ~/data/

sh data/scripts/VOC2012.sh # <directory>MS cocoデータセットを/path/to/cocoで公式Webサイトからインストールします。デフォルトは〜/data/cocoです。 Minival2014およびValminusminival2014アノテーションを準備するための指示に従ってください。すべてのラベルファイル(.JSON)は、coco/ annotations/ folderの下にある必要があります。この基本構造が必要です

$COCO /

$COCO /cache/

$COCO /annotations/

$COCO /images/

$COCO /images/test2015/

$COCO /images/train2014/

$COCO /images/val2014/更新:現在のCOCOデータセットは、同じ画像セットの新しいスプリットである新しいTrain2017およびVAL2017セットをリリースしました。

最初にFC削減VGG-16 Pytorch Base Network Weightsをダウンロードしてください:https://s3.amazonaws.com/amdegroot-models/vgg16_educedfc.pthまたはbaiduyunドライバーから

MobileNet事前訓練を受けたBasenetは、紙で報告されている元のものよりもわずかに優れた精度率を達成するMobileNet-Caffeから移植されます。WeightFileはhttps://drive.google.com/open?id=13azsapybbbdjzfgidqn1inblpsdddxk14またはBaiduyunドライバーです。

デフォルトでは、 RFBNet/weights dirにファイルをダウンロードしたと想定しています。

mkdir weights

cd weights

wget https://s3.amazonaws.com/amdegroot-models/vgg16_reducedfc.pthtrain_RFB.pyにフラグとしてリストされているパラメーターを指定するか、手動で変更します。 python train_RFB.py -d VOC -v RFB_vgg -s 300 train_RFB.py参照)訓練されたネットワークを評価するには:

python test_RFB.py -d VOC -v RFB_vgg -s 300 --trained_model /path/to/model/weightsデフォルトでは、VOC2007テストまたはCoco Minival2014でマップ結果を直接出力します。 VOC2012テストおよびCOCO Test-DEVの結果の場合、 test_RFB.pyファイルのデータセットを手動で変更し、検出結果を保存してサーバーに送信できます。