AICONFIG-生産グレードのAIアプリケーションを構築するためのオープンソースフレームワーク

ドキュメント

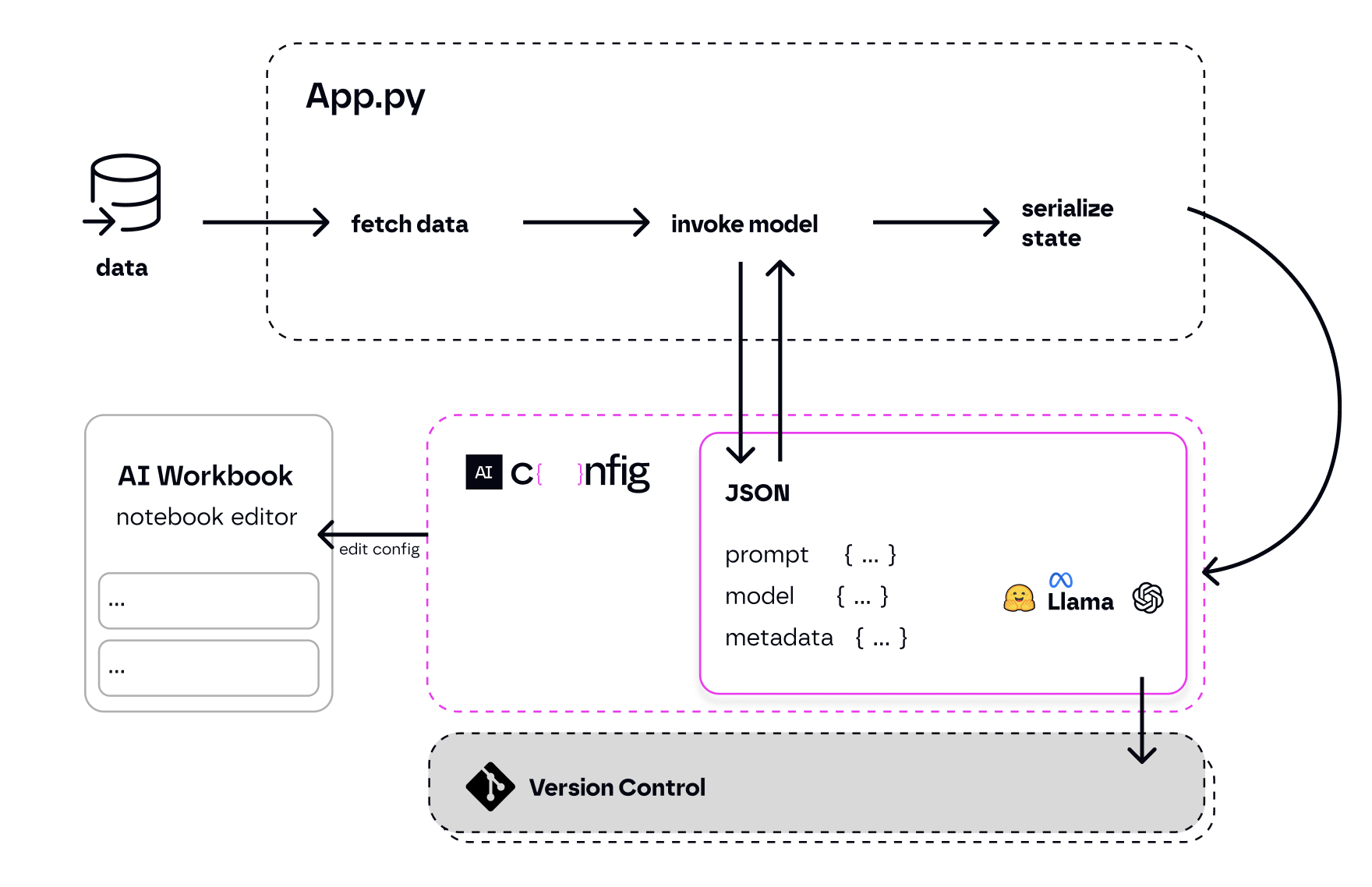

AICONFIGは、生産用の生成的AIアプリケーションを簡単に構築できるようにするフレームワークです。迅速なプロトタイプ化のためにローカルエディターでバージョン、評価、監視、および開くことができるJSON-Serializable構成として、生成AIプロンプト、モデル、およびモデルパラメーターを管理します。

これにより、アプリケーションコードとは別に生成AI動作を保存および反復し、合理化されたAI開発ワークフローを提供できます。

ここでより多くのコンテキスト。

対コードユーザーの場合:

VSコードを使用していない場合は、次の手順に従ってください。

pip3 install python-aiconfigexport OPENAI_API_KEY='your-key'aiconfig edit完全な開始チュートリアルをご覧ください。

# for python installation:

pip3 install python-aiconfig

# or using poetry: poetry add python-aiconfig

# for node.js installation:

npm install aiconfig

# or using yarn: yarn add aiconfig注: AICONFIGエディターを使用してPython AiconFigパッケージをインストールして、アプリケーションコードのAICONFIGと対話するためにノードSDKを使用する場合でも、プロンプトを作成および反復します。

OpenAI APIキーを指定する必要があります。端末を開いてこの行を追加し、「Your-Api-Key-Here」をAPIキーに置き換えます: export OPENAI_API_KEY='your-api-key-here' 。

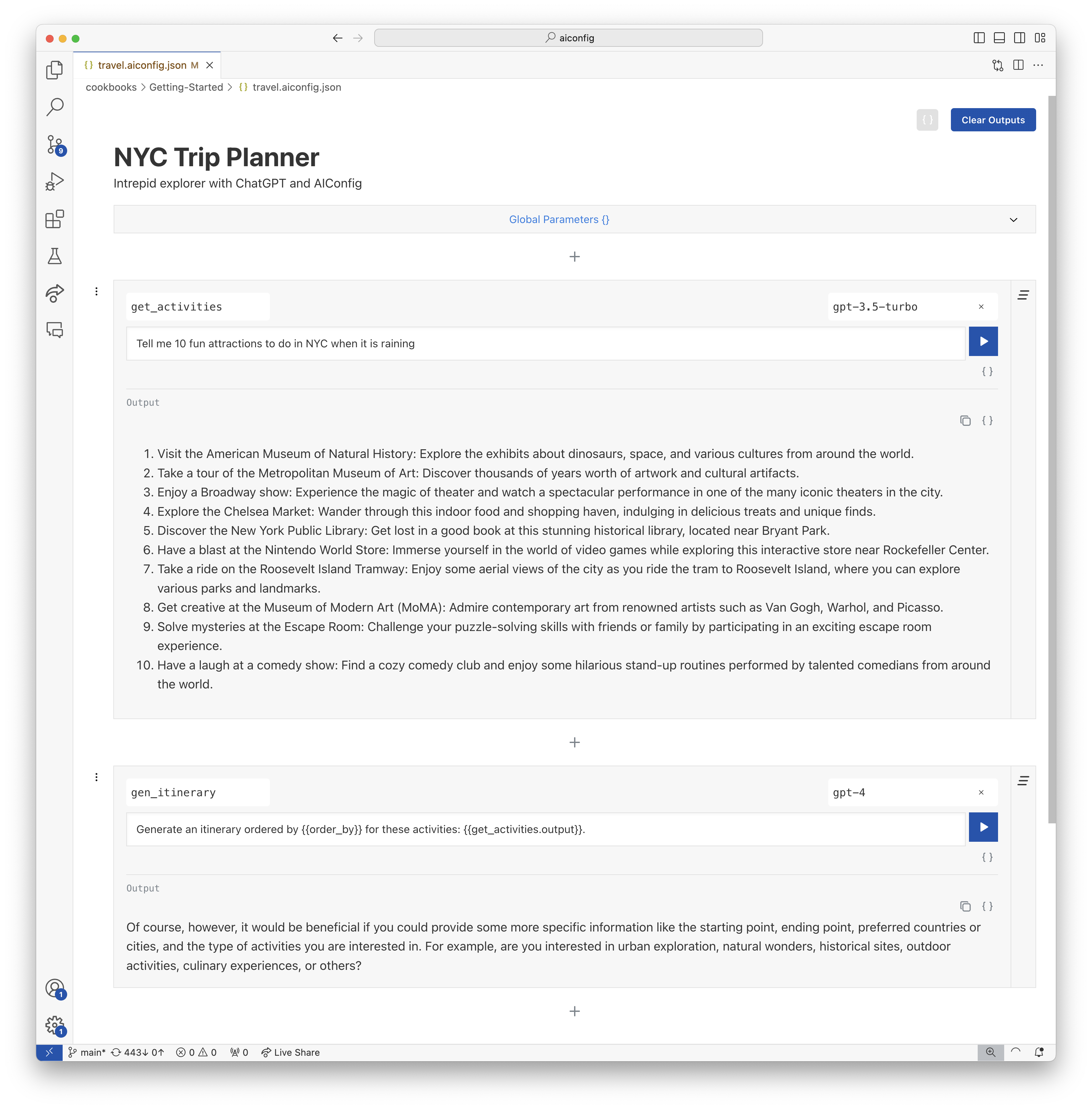

AICONFIGエディターは、AICONFIGSとして保存されているプロンプトとモデルのパラメーターを視覚的に作成および編集するのに役立ちます。

travel.aiconfig.jsonファイルを開きます。これにより、VSコードでAICONFIGエディターが自動的に開きます。AICONFIGエディターを使用すると、複雑なチェーンと変数を使用してプロンプトを作成および実行できます。編集者は15秒ごとに自動保存され、保存ボタンで手動で保存できます。更新は、AICONFIG JSONファイルに反映されます。エディターで作成されたプロンプトチェーンのこの例を参照してください。

対応するAICONFIG JSONファイル:

{

"name": "NYC Trip Planner",

"description": "Intrepid explorer with ChatGPT and AIConfig",

"schema_version": "latest",

"metadata": {

"models": {

"gpt-3.5-turbo": {

"model": "gpt-3.5-turbo",

"top_p": 1,

"temperature": 1

},

"gpt-4": {

"model": "gpt-4",

"max_tokens": 3000

}

},

"default_model": "gpt-3.5-turbo"

},

"prompts": [

{

"name": "get_activities",

"input": "Tell me 10 fun attractions to do in NYC."

},

{

"name": "gen_itinerary",

"input": "Generate an itinerary ordered by {{order_by}} for these activities: {{get_activities.output}}.",

"metadata": {

"model": "gpt-4",

"parameters": {

"order_by": "geographic location"

}

}

}

]

}

PythonまたはNode SDKのいずれかを使用して、アプリケーションコードでAICONFIGエディターから生成されたAICONFIGからプロンプトを実行できます。以下にPython SDKを示しました。

# load your AIConfig

from aiconfig import AIConfigRuntime , InferenceOptions

import asyncio

config = AIConfigRuntime . load ( "travel.aiconfig.json" )

# setup streaming

inference_options = InferenceOptions ( stream = True )

# run a prompt

async def gen_nyc_itinerary ():

gen_itinerary_response = await config . run ( "gen_itinerary" , params = { "order_by" : "location" }, options = inference_options , run_with_dependencies = True )

asyncio . run ( gen_nyc_itinerary ())

# save the aiconfig to disk and serialize outputs from the model run

config . save ( 'updated_travel.aiconfig.json' , include_outputs = True )aiconfigエディターを使用して、aiconfigをすばやく反復して編集できます。

aiconfig edit --aiconfig-path=travel.aiconfig.json AICONFIGエディターを搭載した新しいタブは、http:// localhost:8080/のデフォルトブラウザで開き、prompts、chainging logic、およびtravel.aiconfig.jsonからの設定を使用します。編集者は15秒ごとに自動保存され、保存ボタンで手動で保存できます。更新はAICONFIGファイルに反映されます。

今日、アプリケーションコードは、アプリケーションのGEN AI設定と密接に結びついています。プロンプト、パラメーター、およびモデル固有のロジックはすべて、アプリコードでごちゃごちゃになります。

AICONFIGは、アプリケーションからプロンプト、モデルパラメーター、モデル固有のロジックを分離することにより、複雑さを解き放つのに役立ちます。

config.run()を呼び出すだけですaiconfigを開いてすぐに反復しますaiconfig - アプリケーションのAIアーティファクトです。 aiconfig使用します。 AICONFIGは、モデルに依存してマルチモーダルになるように設計されているため、テキスト、画像、オーディオなど、あらゆる生成AIモデルで動作するように拡張できます。aiconfigアーティファクトを共有することで協力することができます。 AICONFIGにより、複雑なプロンプトチェーン、さまざまなモデル、高度な生成AIワークフローを簡単に操作できます。これらのレシピから始めて、もっとアクセス/cookbooks :

AICONFIGは、次のモデルを箱から出してサポートしています。例を参照してください:

箱から出して提供されていないモデルを使用する必要がある場合は、 ModelParser実装できます。 aiconfigで新しいモデルをサポートする方法の指示を参照してください。

AICONFIGは、ユースケース用にカスタマイズおよび拡張されるように設計されています。拡張性ガイドは、より詳細に説明します。

現在、AICONFIGを拡張するための3つのコアの方法があります。

aiconfigでカスタムフィールドを保存します私たちは急速にAICONFIGを発展させています!プロジェクトを改善する方法についてのPRの寄付とアイデアを歓迎します。

#aiconfigチャンネルで会話に参加してください現在、毎週pypiおよびnpmパッケージの新しいタグ付きバージョンをリリースしています。ホットフィックスが完了すると外出します。