Situs web resmi www.binance.com/zh-cn :Masukkan situs web resmi ☜☜

Aplikasi: ☞☞ Unduh Aplikasi Resmi☜☜

Dengan perkembangan cepat teknologi kecerdasan buatan, bagaimana mengevaluasi dan membandingkan kekuatan model AI generatif yang berbeda telah menjadi masalah yang sangat peduli. Metode pembandingan AI tradisional secara bertahap mengungkapkan keterbatasan mereka, dan untuk alasan ini, pengembang AI secara aktif mengeksplorasi metode evaluasi yang lebih inovatif.

Baru-baru ini, sebuah situs web yang disebut "Minecraft Benchmark" (MC-Bench) muncul. Keunikannya adalah bahwa ia menggunakan game microsoft yang dibangun oleh Sandbox "Minecraft" sebagai platform untuk memungkinkan pengguna mengevaluasi kinerja mereka dengan membandingkan model AI berdasarkan petunjuk. Yang mengejutkan adalah bahwa pencipta platform novel ini ternyata menjadi mahasiswa di kelas 12.

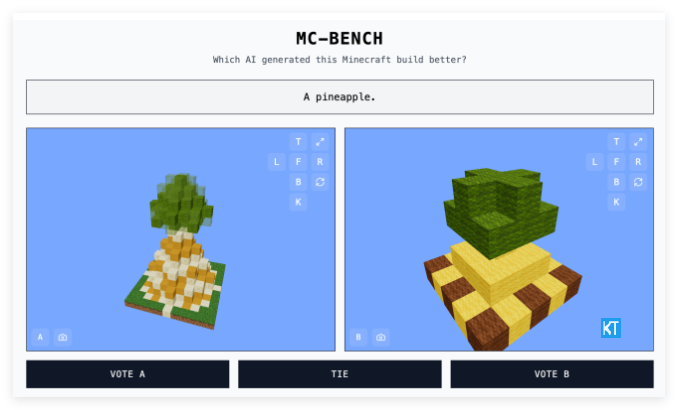

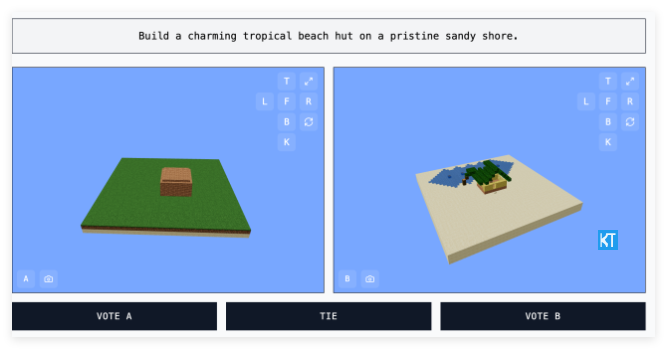

Situs web MC-Bench menyediakan cara yang intuitif dan menarik untuk mengevaluasi model AI. Pengembang memasukkan petunjuk berbeda ke dalam model AI yang berpartisipasi dalam pengujian, dan model akan menghasilkan bangunan Minecraft yang sesuai. Pengguna dapat memberikan suara pada bangunan -bangunan ini tanpa mengetahui pekerjaan mana yang dibuat oleh model AI mana untuk memilih yang menurut mereka lebih sesuai dengan petunjuk dan lebih baik. Hanya setelah pemungutan suara berakhir, pengguna akan melihat "pencipta" di balik setiap gedung. Mekanisme "seleksi buta" ini dirancang untuk secara lebih objektif mencerminkan kemampuan generasi sebenarnya dari model AI.

Adi Singh mengatakan Minecraft dipilih sebagai platform pembandingan bukan hanya karena popularitas permainan itu sendiri - ini adalah video game terlaris dalam sejarah. Lebih penting lagi, popularitas yang meluas dari permainan ini dan keakraban gaya visualnya membuatnya relatif mudah bagi orang -orang yang tidak pernah memainkan game ini untuk mengetahui nanas mana yang terbuat dari kotak terlihat lebih realistis. Dia percaya bahwa "Minecraft memudahkan orang untuk melihat kemajuan [pengembangan AI]", metode penilaian visual yang lebih meyakinkan daripada metrik tekstual belaka.

MC-Bench saat ini terutama melakukan tugas bangunan yang relatif sederhana, seperti meminta model AI untuk menulis kode untuk membuat struktur game yang sesuai berdasarkan tips seperti "King of Frost" atau "gubuk tropis berwarna-warni di pantai primitif". Ini pada dasarnya adalah tolok ukur pemrograman, tetapi kepintarannya adalah bahwa pengguna tidak perlu mempelajari kode yang kompleks dan dapat menilai kualitas pekerjaan berdasarkan efek visual intuitif, yang sangat meningkatkan partisipasi proyek dan potensi pengumpulan data.

Filosofi desain MC-Bench adalah untuk memungkinkan publik untuk secara lebih intuitif merasakan tingkat pengembangan teknologi AI. "Peringkat saat ini sangat konsisten dengan pengalaman pribadi saya dengan model -model ini, yang berbeda dari banyak tolok ukur teks biasa," kata Singh. Dia percaya bahwa MC-Bench dapat memberikan referensi yang berharga bagi perusahaan terkait untuk membantu mereka menilai apakah penelitian dan pengembangan AI mereka benar.

Meskipun MC-Bench diprakarsai oleh Adi Singh, itu juga mengumpulkan sekelompok kontributor sukarela di belakangnya. Perlu disebutkan bahwa beberapa perusahaan AI teratas, termasuk Anthropic, Google, Openai dan Alibaba, telah memberikan subsidi bagi proyek untuk menggunakan produk mereka untuk menjalankan tolok ukur. Namun, situs web MC-Bench menyatakan bahwa perusahaan-perusahaan ini tidak terkait dengan proyek.

Singh juga penuh dengan prospek masa depan MC-Bench. Dia mengatakan konstruksi sederhana saat ini sedang berlangsung hanyalah titik awal dan dapat diperluas ke perencanaan jangka panjang dan tugas yang berorientasi pada tujuan di masa depan. Dia percaya bahwa bermain game dapat menjadi media yang aman dan dapat dikendalikan untuk menguji kemampuan "penalaran agen" AI, yang sulit dicapai dalam kehidupan nyata, sehingga memiliki keuntungan dalam pengujian.

Selain MC-Bench, game lain seperti Street Fighter dan Anda menggambar dan saya kira juga telah digunakan sebagai tolok ukur eksperimental untuk AI, yang mencerminkan bahwa tolok ukur AI adalah area yang sangat terampil dalam diri mereka sendiri. Evaluasi standar tradisional sering kali memiliki "keuntungan bidang rumah" karena model AI telah dioptimalkan untuk jenis masalah tertentu selama pelatihan, terutama pada masalah yang membutuhkan memori hafalan atau inferensi dasar. Sebagai contoh, GPT-4 Openai mencapai 88% hasil yang sangat baik dalam ujian LSAT, tetapi tidak bisa mengetahui berapa banyak "r" ada dalam kata "stroberi".

Antropik Claude 3.7Sonnet mencapai akurasi 62,3% dalam tolok ukur rekayasa perangkat lunak standar, tetapi tidak sebagus kebanyakan anak berusia lima tahun ketika datang untuk bermain Pokémon.

Munculnya MC-Bench memberikan perspektif baru dan lebih mudah dipahami untuk mengevaluasi kemampuan model AI generatif. Dengan memanfaatkan platform game yang terkenal, ia mengubah kemampuan teknologi AI yang kompleks menjadi perbandingan visual yang intuitif, yang memungkinkan lebih banyak orang untuk berpartisipasi dalam evaluasi AI dan proses kognitif. Meskipun nilai aktual dari metode evaluasi ini masih sedang dibahas, itu tidak diragukan lagi memberi kita jendela baru untuk mengamati pengembangan AI.

Pintu masuk proyek: https://top.aibase.com/tool/mc-bench