Mit der raschen Entwicklung der Technologie für künstliche Intelligenz ist es zu einem sehr besorgten Problem geworden, die Stärke verschiedener generativer KI -Modelle effektiv zu bewerten und zu vergleichen. Traditionelle KI -Benchmarking -Methoden enthüllen allmählich ihre Einschränkungen, und aus diesem Grund untersuchen KI -Entwickler aktiv innovativere Bewertungsmethoden.

Vor kurzem entstand eine Website namens "Minecraft Benchmark" (MC-Bench). Seine Einzigartigkeit ist, dass es Microsofts Sandbox-gebautes Spiel "Minecraft" als Plattform verwendet, um den Benutzern ihre Leistung zu bewerten, indem sie KI-Modelle basierend auf Eingabeaufforderungen vergleichen. Überraschend ist, dass sich der Schöpfer dieser neuartigen Plattform als Schüler in der 12. Klasse herausstellte.

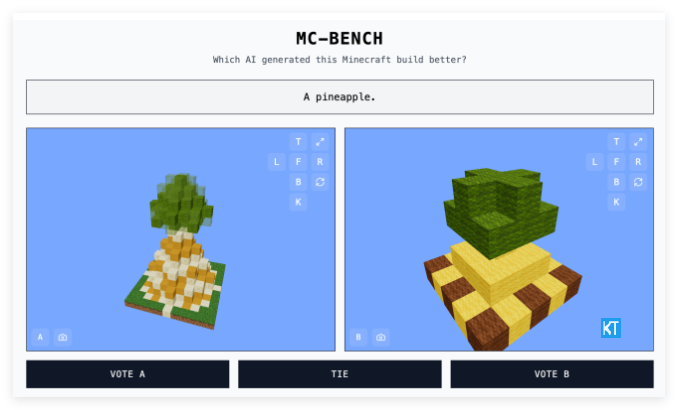

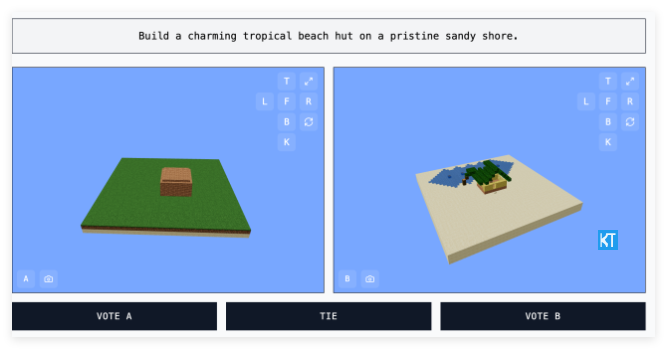

Die MC-Bench-Website bietet eine intuitive und interessante Möglichkeit, KI-Modelle zu bewerten. Entwickler geben verschiedene Eingabeaufforderungen in das KI -Modell ein, das am Test teilnimmt, und das Modell generiert das entsprechende Minecraft -Gebäude. Benutzer können über diese Gebäude abstimmen, ohne zu wissen, welche Arbeiten erstellt wurden, mit welchem KI -Modell sie ausgewählt werden können, die ihrer Meinung nach eher den Eingabeaufforderungen und besser entspricht. Erst wenn die Abstimmung beendet ist, sehen Benutzer den „Schöpfer“ hinter jedem Gebäude. Dieser Mechanismus "Blind Selection" ist so konzipiert, dass er die tatsächliche Erzeugungsfähigkeit von KI -Modellen objektiv widerspiegelt.

Adi Singh sagte, Minecraft sei als Benchmarking -Plattform ausgewählt worden, nicht nur wegen der Popularität des Spiels selbst - es ist das meistverkaufte Videospiel in der Geschichte. Noch wichtiger ist, dass die weit verbreitete Popularität dieses Spiels und die Vertrautheit seines visuellen Stils es für Menschen, die dieses Spiel noch nie gespielt haben, relativ einfach machen, zu erkennen, welche Ananas aus Quadraten realistischer aussieht. Er glaubt, dass "Minecraft es den Menschen leichter erleichtert, den Fortschritt von [AI -Entwicklung] zu sehen", einer visuellen Bewertungsmethode, die überzeugender als eine bloße Textmetrik ist.

MC-Bench führt derzeit hauptsächlich relativ einfache Bauaufgaben aus, z. B. AI-Modelle, um Code zu schreiben, um entsprechende Spielstrukturen basierend auf Tipps wie "King of Frost" oder "farbenfrohen tropischen Hütten an primitiven Stränden" zu erstellen. Dies ist im Wesentlichen ein Programmier -Benchmark, aber die Klugheit besteht darin, dass Benutzer nicht in komplexen Code eintauchen und die Qualität der Arbeit anhand intuitiver visueller Effekte beurteilen können, was die Teilnahme und die Datenerfassungspotential des Projekts erheblich verbessert.

Die Designphilosophie von MC-Bench besteht darin, dass die Öffentlichkeit das Entwicklungsniveau der AI-Technologie intuitiv spüren. "Die aktuellen Ranglisten stimmen sehr überein mit meinen persönlichen Erfahrungen mit diesen Modellen, was sich von vielen einfachen Text -Benchmarks unterscheidet", sagte Singh. Er glaubt, dass MC-Bench für verwandte Unternehmen eine wertvolle Referenz liefern könnte, um ihnen zu beurteilen, ob ihre KI-Forschung und -entwicklung korrekt sind.

Obwohl MC-Bench von Adi Singh initiiert wurde, sammelte es auch eine Gruppe freiwilliger Mitwirkender. Es ist erwähnenswert, dass mehrere Top -KI -Unternehmen, darunter Anthropic, Google, Openai und Alibaba, Subventionen für das Projekt zur Verfügung gestellt haben, um mit ihren Produkten Benchmarks auszuführen. Die Website von MC-Bench besagt jedoch, dass diese Unternehmen nicht mit dem Projekt verbunden sind.

Singh ist auch voller Aussichten für die Zukunft von MC-Bench. Er sagte, dass der derzeit laufende einfache Konstruktion nur ein Ausgangspunkt sei und in Zukunft auf längerfristige Planung und zielgerichtete Aufgaben ausgeweitet werden kann. Er glaubt, dass das Spielen zu einem sicheren und kontrollierbaren Medium zum Testen von KIs "Agenten -Argumentation" -Funktionen werden kann, was im wirklichen Leben schwer zu erreichen ist, sodass es einen Vorteil beim Testen hat.

Zusätzlich zu MC-Bench wurden andere Spiele wie Street Fighter und Sie zeichnen und ich denke, ich wurde auch als experimentelle Benchmarks für KI verwendet, was widerspiegelt, dass KI-Benchmarks ein sehr geschickter Bereich für sich sind. Traditionelle standardisierte Bewertungen haben häufig einen "Heimspielvorteil", da KI-Modelle während des Trainings für bestimmte Arten von Problemen optimiert wurden, insbesondere bei Problemen, die einen roten Speicher oder grundlegende Inferenz erfordern. Zum Beispiel erzielte OpenAIs GPT-4 in der LSAT-Prüfung 88% ausgezeichnete Ergebnisse, konnten jedoch nicht sagen, wie viele "R" in dem Wort "Strawberry" enthalten sind.

Das Claude 3.7Sonnet von Anthropic erreichte eine Genauigkeit von 62,3% in standardisierten Software-Engineering-Benchmarks, war jedoch nicht so gut wie die meisten Fünfjährigen, wenn es darum geht, Pokémon zu spielen.

Die Entstehung von MC-Bench bietet eine neuartige und leichter verständliche Perspektive für die Bewertung der Fähigkeit generativer KI-Modelle. Durch die Nutzung der bekannten Gaming-Plattform verwandelt sie komplexe KI-Technologiefunktionen in intuitive visuelle Vergleiche und ermöglicht es mehr Menschen, an der KI-Bewertung und dem kognitiven Prozess teilzunehmen. Obwohl der tatsächliche Wert dieser Bewertungsmethode noch diskutiert wird, bietet sie uns zweifellos ein neues Fenster, um die Entwicklung von KI zu beobachten.

Projekteingang: https://top.aibase.com/tool/mcbench